API en tiempo real de GPT-4o: Un punto final de transmisión multimodal de baja latencia que permite a los desarrolladores enviar y recibir datos sincronizados de texto, audio y visión a través de WebRTC o WebSocket (modelo=gpt-4o-realtime-preview-<date>, stream=true) para aplicaciones interactivas en tiempo real.

Información básica y características

OpenAI's GPT-4o en tiempo real (ID del modelo: gpt-4o-vista previa en tiempo real-2025-06-03) es el primer modelo de base disponible públicamente diseñado para Conversión de voz a voz de extremo a extremo (S2S) interacción con latencia de subsegundosDerivada de la familia “omni” GPT-4o, la variante Realtime fusiona reconocimiento de voz, razonamiento en lenguaje natural y texto a voz neuronal en una sola red, lo que permite a los desarrolladores crear agentes de voz que conversan con la misma fluidez que los humanos. El modelo se expone a través de la interfaz diseñada específicamente. API en tiempo real y está estrechamente integrado con el nuevo Agente en tiempo real abstracción dentro de la SDK de agentes (TypeScript y Python).

Conjunto de funciones principales — S2S de extremo a extremo • Manejo de interrupciones • Llamada a herramientas

• Voz a voz nativa: La entrada de audio se ingiere como flujo continuo, se tokeniza internamente, se razona y se devuelve como voz sintetizada. No se necesitan búferes STT/TTS externos, lo que elimina el retardo de varios segundos en la canalización.

• Latencia a escala de milisegundos: La poda arquitectónica, la destilación de modelos y una pila de servicio optimizada para GPU permiten Latencias del primer token de ~300 a 500 ms En implementaciones típicas de nube, acercándose a las normas de turnos de conversación humanos.

• Seguimiento sólido de instrucciones: Optimizado en scripts de conversación y rastros de llamadas de función, GPT-4o Realtime demuestra una >25 % de reducción en errores de ejecución de tareas en comparación con la línea base GPT-2024o de mayo de 4.

• Llamada de herramientas determinista: El modelo produce JSON estructurado conforme a OpenAI. esquema de llamada de funciónPermite la invocación determinista de APIs de back-end (sistemas de reserva, bases de datos, IoT). Incorpora reintentos con detección de errores y validación de argumentos.

• Interrupciones elegantes: Un detector de actividad de voz en tiempo real combinado con decodificación incremental permite al agente pausar el discurso a mitad de la oración, ingerir una interrupción del usuario y reanudar o volver a planificar la respuesta sin problemas.

• Velocidad de voz configurable: Una nueva encuesta velocidad El parámetro (0.25–4× tiempo real) permite a los desarrolladores adaptar el ritmo de salida para accesibilidad o aplicaciones de ejecución rápida.

Arquitectura técnica — Transformador multimodal unificado

Codificador-decodificador unificado: GPT-4o Realtime comparte la arquitectura omni transformador de una sola pila En el que los tokens de audio, texto y visión (futura) coexisten en un espacio latente. La computación adaptativa por capas ata los fotogramas de audio directamente a bloques de atención posteriores, ahorrando entre 20 y 40 ms por pasada.

Tokenización jerárquica de audio: El PCM de 16 kHz sin procesar se divide en parches log-mel → se cuantifica en tokens acústicos de grano grueso → se comprime en tokens semánticos, optimizando la token por segundo presupuesto sin sacrificar la prosodia.

Núcleos de inferencia de bits bajos: Los pesos desplegados se ejecutan a Cuantización NF4 de 4 bits a través de kernels Triton/TensorRT-LLM, duplicando el rendimiento frente a fp16 mientras se mantiene una pérdida de calidad MOS de <1 dB.

Atención al streaming: Las incrustaciones rotatorias de ventanas deslizantes y el almacenamiento en caché de valores clave permiten que el modelo preste atención a los últimos 15 segundos de audio con memoria O(L), crucial para diálogos con duración de llamadas telefónicas.

Detalles técnicos

- Versión API:

2025-06-03-preview - Protocolos de Transporte:

- WebRTC:Latencia ultrabaja (<80 ms) para transmisiones de audio y video del lado del cliente

- WebSocketTransmisión de servidor a servidor con una latencia inferior a 100 ms

- Codificación de datos:

- Opus códec dentro RTP paquetes de audio

- H.264 / H.265 Envoltorios de fotogramas para vídeo

- Streaming: Apoya

stream: truepara entregar incrementales respuestas parciales a medida que se generan tokens - Nueva paleta de voces:Presenta ocho nuevas voces—aleación, ceniza, balada, coral, echo, salvia, brillar e verso—para más información expresivo, parecido a un humano interacciones ..

Evolución de GPT-4o en tiempo real

- Mayo de 2024: GPT-4o Omni debuta con soporte multimodal para texto, audio y visión.

- Octubre de 2024: API en tiempo real entra en beta privada (

2024-10-01-preview), optimizado para audio de baja latencia. - Diciembre del 2024:Disponibilidad global ampliada de

gpt-4o-realtime-preview-2024-12-17, Añadiendo almacenamiento en caché rápido y más voces. - 3 de Junio de 2025: Última actualización (

2025-06-03-preview) lanza un refinado paleta de voces y optimizaciones de rendimiento.

Rendimiento de referencia

- MMLU: 88.7, superando el 4 de GPT-86.5 en Comprensión masiva del lenguaje multitarea .

- Reconocimiento de voz: Logra líderes en la industria tasas de error de palabras en entornos ruidosos, superando Susurro líneas de base.

- Pruebas de latencia:

- De extremo a extremo (discurso entrante → texto saliente): 50 - 80 ms a través de WebRTC

- Audio de ida y vuelta (discurso entrante → discurso saliente): <100 ms .

Indicadores técnicos

- Throughput:Sostiene 15 tokens/seg para flujos de texto; kbps 24 Opus para audio.

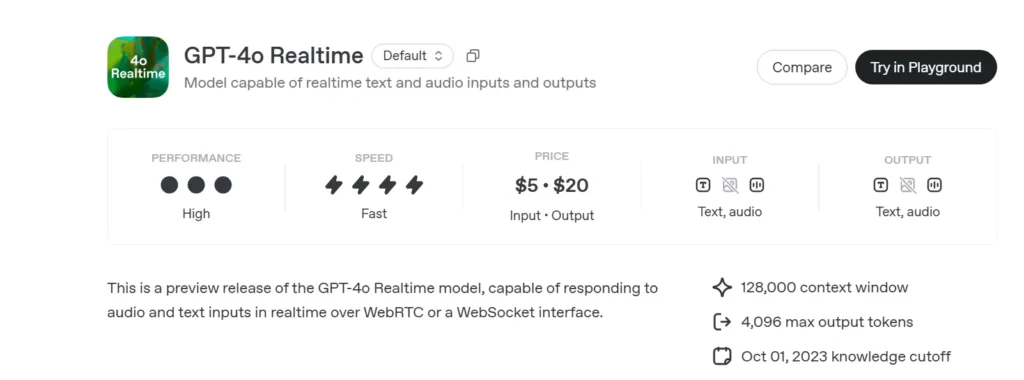

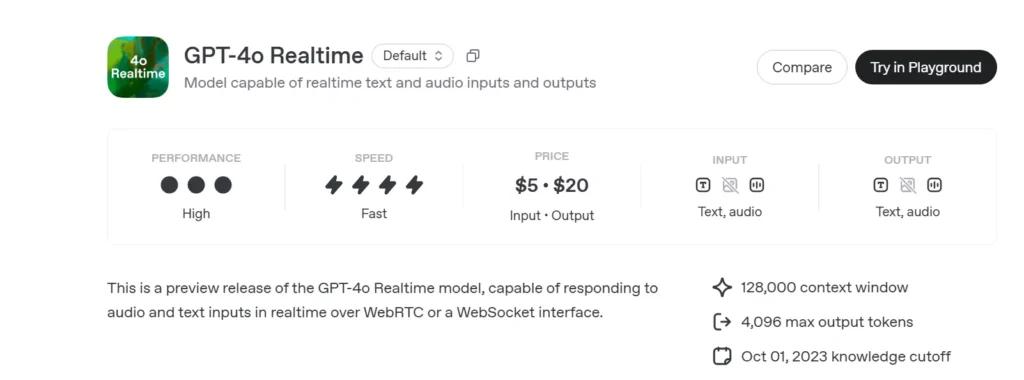

- Precios:

- Texto:$5 por 1 millón de tokens de entrada; $20 por 1 millón de tokens de salida

- Audio:$100 por 1 millón de tokens de entrada; $200 por 1 millón de tokens de salida.

- Disponibilidad:Implementado globalmente en todas las regiones compatibles con la API en tiempo real.

Cómo llamar a la API en tiempo real GPT-4o desde CometAPI

GPT-4o Realtime Precios de la API en CometAPI:

- Tokens de entrada: $2/M tokens

- Tokens de salida: $8/M tokens

Pasos requeridos

- Inicia sesión en cometapi.comSi aún no eres nuestro usuario, por favor regístrate primero.

- Obtenga la clave API de credenciales de acceso de la interfaz. Haga clic en "Agregar token" en el token API del centro personal, obtenga la clave del token: sk-xxxxx y envíe.

- Obtenga la URL de este sitio: https://api.cometapi.com/

Métodos de uso

- Seleccione la opción "**

gpt-4o-realtime-preview-2025-06-03**Punto final para enviar la solicitud y configurar su cuerpo. El método y el cuerpo de la solicitud se obtienen de la documentación de la API de nuestro sitio web. Nuestro sitio web también ofrece la prueba de Apifox para su comodidad. - Reemplazar con su clave CometAPI real de su cuenta.

- Inserte su pregunta o solicitud en el campo de contenido: esto es lo que responderá el modelo.

- . Procesa la respuesta de la API para obtener la respuesta generada.

Para obtener información sobre el acceso a modelos en la API de Comet, consulte Documento API.

Para obtener información sobre el precio del modelo en Comet API, consulte https://api.cometapi.com/pricing.

Código de muestra e integración de API

import openai

openai.api_key = "YOUR_API_KEY"

# Establish a Realtime WebRTC connection

connection = openai.Realtime.connect(

model="gpt-4o-realtime-preview-2025-06-03",

version="2025-06-03-preview",

transport="webrtc"

)

# Stream audio frames and receive incremental text

with open("user_audio.raw", "rb") as audio_stream:

for chunk in iter(lambda: audio_stream.read(2048), b""):

result = connection.send_audio(chunk)

print("Assistant:", result)

- Parámetros clave:

model: “gpt-4o-realtime-preview-2025-06-03”version: Vista previa del 2025/06/03transport: “webrtc” para preguntas de latencia mínimastream:truepara preguntas de incrementales <font style="vertical-align: inherit;" class="">actualizaciones sobre los portfolios ilustrativos de Small Caps y de todos los activos</font>

Combinando el estado de la técnica razonamiento multimodal, una robusto nueva paleta de voces, y ultra bajo transmisión de latencia, GPT-4o en tiempo real (2025-06-03) permite a los desarrolladores construir realmente interactivo, conversacional Aplicaciones de IA.

Vea también API de o3-Pro

Seguridad y cumplimiento

OpenAI entrega GPT-4o Realtime con:

• Barandillas a nivel de sistema: Política adaptada para rechazar solicitudes no permitidas (extremismo, comportamiento ilícito).

• Filtrado de contenido en tiempo real: Los clasificadores de menos de 100 ms analizan tanto la entrada del usuario como la salida del modelo antes de la emisión.

• Rutas de aprobación humana: Se activa en invocaciones de herramientas de alto riesgo (pagos, asesoramiento legal), aprovechando las nuevas primitivas de aprobación del SDK de agentes.