La serie GLM-4.5, desarrollada por Zhipu AI (Z.ai), representa un avance significativo en los modelos de lenguaje grande (LLM) de código abierto. Diseñada para unificar las capacidades de razonamiento, codificación y agencia, GLM-4.5 ofrece un rendimiento robusto en diversas aplicaciones. Tanto si eres desarrollador, investigador o aficionado, esta guía proporciona información detallada sobre cómo acceder y utilizar la serie GLM-4.5 eficazmente.

¿Qué es la serie GLM-4.5 y por qué es importante?

GLM-4.5 es un modelo de razonamiento híbrido que combina dos modos distintos: un modo de pensamiento para razonamiento complejo y uso de herramientas, y un modo de no pensamiento para respuestas inmediatas. Este enfoque dual permite al modelo gestionar una amplia gama de tareas de forma eficiente. La serie incluye dos variantes principales:

- GLM-4.5Con 355 mil millones de parámetros totales y 32 mil millones de parámetros activos, este modelo está diseñado para una implementación a gran escala en tareas de razonamiento, generación y múltiples agentes.

- GLM-4.5-Aire:Una versión liviana con 106 mil millones de parámetros totales y 12 mil millones de parámetros activos, optimizada para la inferencia en el dispositivo y en la nube a menor escala sin sacrificar las capacidades principales.

Ambos modelos admiten modos de razonamiento híbridos, ofreciendo modos de “pensamiento” y “no pensamiento” para equilibrar tareas de razonamiento complejas y respuestas rápidas, son de código abierto y se publican bajo la licencia MIT, lo que los hace accesibles para uso comercial y desarrollo secundario.

Principios de arquitectura y diseño

En esencia, GLM-4.5 aprovecha MoE para enrutar dinámicamente tokens a través de subredes expertas especializadas, lo que permite una eficiencia de parámetros superior y un comportamiento de escalado (). Este enfoque implica que se requieren menos parámetros por cada pasada de avance, lo que reduce los costos operativos y mantiene un rendimiento de vanguardia en las tareas de razonamiento y codificación ().

Capacidades Clave

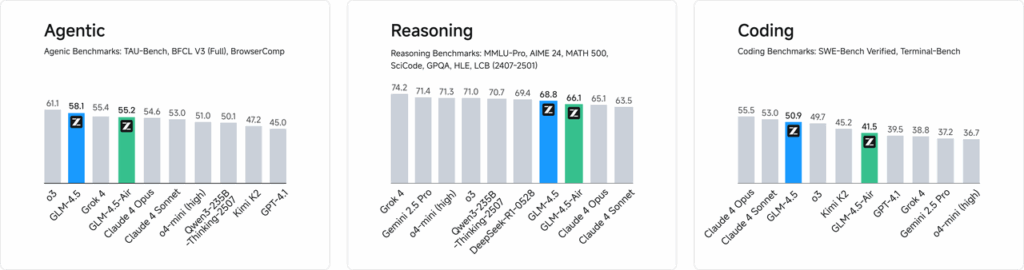

- Razonamiento y codificación híbridos:GLM-4.5 demuestra el rendimiento de SOTA tanto en los puntos de referencia de comprensión del lenguaje natural como en las pruebas de generación de código, rivalizando a menudo con los modelos propietarios en precisión y fluidez.

- Integración de agentesLas interfaces de llamada de herramientas integradas permiten que GLM-4.5 organice flujos de trabajo de varios pasos (como consultas de bases de datos, orquestación de API y generación de front-end interactivo) dentro de una sola sesión.

- Artefactos multimodalesDesde miniaplicaciones HTML/CSS hasta simulaciones basadas en Python y SVG interactivos, GLM-4.5 puede generar artefactos totalmente funcionales, mejorando la participación del usuario y la productividad del desarrollador.

¿Por qué GLM-4.5 supone un cambio radical?

GLM-4.5 ha sido elogiado no solo por su desempeño bruto sino también por redefinir la propuesta de valor de los LLM de código abierto en entornos empresariales y de investigación.

Puntos de referencia de rendimiento

En evaluaciones independientes de 52 tareas de programación, que abarcan desarrollo web, análisis de datos y automatización, GLM-4.5 superó consistentemente a otros modelos líderes de código abierto en fiabilidad de llamadas a herramientas y finalización general de tareas. En pruebas comparativas con Claude Code, Kimi-K2 y Qwen3-Coder, GLM-4.5 obtuvo las mejores puntuaciones en benchmarks como la clasificación "SWE-bench Verified".

Reducción de costes

Más allá de la precisión, el diseño MoE de GLM-4.5 reduce drásticamente los costos de inferencia. El precio público de las llamadas a la API comienza desde tan solo 0.8 RMB por millón de tokens de entrada y 2 RMB por millón de tokens de salida, aproximadamente un tercio del costo de ofertas propietarias comparables. Junto con velocidades máximas de generación de 100 tokens/s, el modelo admite implementaciones de alto rendimiento y baja latencia sin gastos prohibitivos.

¿Cómo puedo acceder a GLM-4.5?

1. Acceso directo a través de la plataforma Z.ai

El método más sencillo para interactuar con GLM-4.5 es a través de la plataforma Z.ai. Visitando chat.z.aiLos usuarios pueden seleccionar el modelo GLM-4.5 y comenzar a interactuar mediante una interfaz intuitiva. Esta plataforma permite realizar pruebas y prototipos de inmediato sin necesidad de integraciones complejas. Los usuarios pueden seleccionar el modelo GLM-4.5 o GLM-4.5-Air en la esquina superior izquierda y comenzar a chatear al instante. Esta interfaz es intuitiva y no requiere configuración, lo que la hace ideal para interacciones y demostraciones rápidas.

2. Acceso a la API para desarrolladores

Para los desarrolladores que buscan integrar GLM-4.5 en sus aplicaciones, la plataforma API Z.ai ofrece soporte completo. La API ofrece interfaces compatibles con OpenAI para los modelos GLM-4.5 y GLM-4.5-Air, lo que facilita una integración fluida en los flujos de trabajo existentes. La documentación detallada y las directrices de integración están disponibles en Documentación de la API de Z.ai .

3. Implementación de código abierto

Para quienes estén interesados en la implementación local, los modelos GLM-4.5 están disponibles en plataformas como Hugging Face y ModelScope. Estos modelos se publican bajo la licencia de código abierto del MIT, lo que permite su uso comercial y desarrollo secundario. Pueden integrarse con marcos de inferencia convencionales como vLLM y SGLang.

4. Integración con CometAPI

CometAPI ofrece acceso optimizado a los modelos GLM-4.5 a través de su plataforma API unificada en TableroEsta integración simplifica la autenticación, la limitación de velocidad y la gestión de errores, lo que la convierte en una excelente opción para desarrolladores que buscan una configuración sencilla. Además, el formato de API estandarizado de CometAPI facilita la conmutación de modelos y las pruebas A/B entre GLM-4.5 y otros modelos disponibles.

¿Cómo pueden los desarrolladores acceder a la serie GLM-4.5?

Existen múltiples canales para obtener e implementar GLM-4.5, desde descargas directas de modelos hasta API administradas.

A través de Hugging Face y ModelScope

Tanto Hugging Face como ModelScope alojan la serie completa GLM-4.5 bajo el espacio de nombres zai-org. Tras aceptar la licencia MIT, los desarrolladores pueden:

- Clonar el repositorio:

git clone https://huggingface.co/zai-org/GLM-4.5

- Instalar dependencias:

pip install transformers accelerate

- Cargar el modelo:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

A través de CometAPI

CometAPI proporciona una API sin servidor para GLM‑4.5 y API de aire GLM-4.5 A tarifas de pago por token, accesible a través de, mediante la configuración de puntos finales compatibles con OpenAI, puede llamar a GLM-4.5 a través del cliente Python de OpenAI con ajustes mínimos a las bases de código existentes. CometAPI no solo proporciona GLM4.5 y GLM-4.5-air, sino también todos los modelos oficiales:

| Nombre del modelo | introducir | Precio |

glm-4.5 | Nuestro modelo de razonamiento más poderoso, con 355 mil millones de parámetros | Tokens de entrada $0.48 Tokens de salida $1.92 |

glm-4.5-air | Rentable, ligero, de alto rendimiento | Tokens de entrada $0.16 Tokens de salida $1.07 |

glm-4.5-x | Alto rendimiento, razonamiento fuerte, respuesta ultrarrápida | Tokens de entrada $1.60 Tokens de salida $6.40 |

glm-4.5-airx | Ligero, fuerte rendimiento, respuesta ultrarrápida | Tokens de entrada $0.02 Tokens de salida $0.06 |

glm-4.5-flash | Alto rendimiento, excelente para razonamiento, codificación y agentes | Tokens de entrada $3.20 Tokens de salida $12.80 |

Integración de Python y API REST

Para implementaciones a medida, las organizaciones pueden alojar GLM-4.5 en clústeres de GPU dedicados mediante Docker o Kubernetes. Una configuración RESTful típica implica:

Lanzamiento del servidor de inferencia:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

Envío de solicitudes:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

¿Cuáles son las mejores prácticas para integrar GLM-4.5 en las aplicaciones?

Para maximizar el ROI y garantizar un rendimiento sólido, los equipos deben considerar lo siguiente:

Optimización de API y límites de velocidad

- Solicitudes de agrupamiento:Agrupe indicaciones similares para reducir la sobrecarga y aprovechar el rendimiento de la GPU.

- Almacenamiento en caché de consultas comunes:Almacene finalizaciones frecuentes localmente para evitar llamadas de inferencia redundantes.

- Muestreo adaptativo:Ajustar dinámicamente

temperatureytop_pbasado en la complejidad de la consulta para equilibrar la creatividad y el determinismo.

Seguridad y cumplimiento

- Sanitización de datos:Preprocesar las entradas para eliminar la información confidencial antes de enviarla al modelo.

- Control de Acceso:Implemente claves API, listas de direcciones IP permitidas y limitación de velocidad para evitar el uso indebido y el abuso.

- Registro de auditoría:Registre indicaciones, finalizaciones y metadatos para cumplir con los requisitos corporativos y reglamentarios, especialmente en contextos financieros o de atención médica.

Primeros Pasos

CometAPI es una plataforma API unificada que integra más de 500 modelos de IA de proveedores líderes, como la serie GPT de OpenAI, Gemini de Google, Claude de Anthropic, Midjourney, Suno y más, en una única interfaz intuitiva para desarrolladores. Al ofrecer autenticación, formato de solicitudes y gestión de respuestas consistentes, CometAPI simplifica drásticamente la integración de las capacidades de IA en sus aplicaciones. Ya sea que esté desarrollando chatbots, generadores de imágenes, compositores musicales o canales de análisis basados en datos, CometAPI le permite iterar más rápido, controlar costos y mantenerse independiente del proveedor, todo mientras aprovecha los últimos avances del ecosistema de IA.

Para los desarrolladores que buscan integrar GLM-4.5 en sus aplicaciones, la plataforma CometAPI ofrece una solución robusta. La API proporciona interfaces compatibles con OpenAI, lo que permite una integración fluida en los flujos de trabajo existentes. La documentación detallada y las instrucciones de uso están disponibles en Página de la API de Comet.

Los desarrolladores pueden acceder GLM‑4.5 y API de aire GLM-4.5 atravesar CometAPILas últimas versiones de los modelos mencionados corresponden a la fecha de publicación del artículo. Para comenzar, explore las capacidades del modelo en... Playground y consultar el Guía de API Para obtener instrucciones detalladas, consulte la sección "Antes de acceder, asegúrese de haber iniciado sesión en CometAPI y de haber obtenido la clave API". CometAPI Ofrecemos un precio muy inferior al oficial para ayudarte a integrarte.

Conclusión

GLM-4.5 representa un avance significativo en el campo de los modelos de lenguaje de gran tamaño, ofreciendo una solución versátil para una amplia gama de aplicaciones. Su arquitectura de razonamiento híbrido, sus capacidades de agencia y su naturaleza de código abierto lo convierten en una opción atractiva para desarrolladores y organizaciones que buscan aprovechar las tecnologías avanzadas de IA. Al explorar los diversos métodos de acceso descritos en esta guía, los usuarios pueden integrar eficazmente GLM-4.5 en sus proyectos y contribuir a su desarrollo continuo.