A OpenAI anunciou recentemente diversas atualizações, incluindo o lançamento do modelo GPT-5-Codex-Mini, melhorias no limite de taxa para hierarquias multiusuário e otimizações na eficiência do processamento do modelo.

OpenAI's GPT-5-Codex-Mini é uma variante recém-anunciada do GPT-5-Codex, voltada para desenvolvedores: um modelo menor, otimizado em custo e desempenho, que visa fornecer a maior parte da assistência de codificação do GPT-5-Codex, mas a um custo muito menor e com maior volume utilizável. A variante "Mini" se posiciona como uma escolha pragmática para longas sessões de codificação, automação em segundo plano e fluxos de trabalho de desenvolvedores de alta frequência, onde a capacidade máxima bruta é menos importante do que obter mais tokens/requisições pelo mesmo plano.

O que é o GPT-5-Codex-Mini e quais são suas funcionalidades?

O GPT-5-Codex-Mini é uma variante compacta e econômica da família GPT-5-Codex da OpenAI, especificamente desenvolvida para as plataformas Codex (integração com CLI e IDE). Ele se posiciona como um modelo "menor e mais econômico" que sacrifica um pouco da capacidade máxima em troca de um consumo de recursos significativamente menor e uma cota utilizável maior para fluxos de trabalho interativos de desenvolvimento. O modelo mini permite que os desenvolvedores executem muito mais ciclos de codificação (a OpenAI descreve aproximadamente 4 vezes mais utilização (para o mesmo nível de assinatura do ChatGPT), mantendo a latência e os custos baixos para tarefas de engenharia comuns e bem definidas.

Em termos de funcionalidades, o GPT-5-Codex-Mini herda os principais recursos da linha de produtos Codex: um profundo conhecimento da base de código e a execução de tarefas complexas de forma automatizada. Com base nos recursos da CLI do Codex, os desenvolvedores podem enviar comandos em linguagem natural, trechos de código, capturas de tela ou diagramas de design de interface para o Codex em um terminal interativo. O modelo primeiro elabora um plano e, em seguida, navega automaticamente pelos arquivos, edita o código, executa comandos e realiza testes após obter a aprovação do usuário.

Do ponto de vista modal, os produtos Codex permitem anexar imagens (como capturas de tela da interface do usuário, esboços de design ou capturas de tela de mensagens de erro) à sessão no terminal ou IDE. O modelo consegue entender tanto conteúdo de texto quanto de imagem, mas a saída ainda é principalmente código textual e explicações. Portanto, o GPT-5-Codex-Mini pode ser considerado um modelo proxy de código que é principalmente "entrada de texto + imagem, saída de texto" e não realiza tarefas como geração de imagens, geração de áudio ou geração de vídeo.

Como o GPT-5-Codex-Mini se compara ao GPT-5-Codex?

O que há de novo no Codex?

Além do lançamento do GPT-5-Codex-Mini, a OpenAI aumentou uniformemente o limite de requisições do Codex em 50% para os planos ChatGPT Plus, Business e Edu, elevando significativamente o limite de requisições disponíveis. Ao mesmo tempo, os usuários do ChatGPT Pro receberão permissões de processamento prioritário para melhorar a velocidade de resposta e a experiência de execução de tarefas.

Além disso, a OpenAI realizou uma pequena atualização no modelo GPT-5-Codex, otimizando seu desempenho em cenários colaborativos. O modelo atualizado apresenta melhorias de vários pontos percentuais em métricas de avaliação importantes, um aumento de aproximadamente 3% na eficiência do uso de tokens e maior robustez no tratamento de casos extremos, reduzindo assim a necessidade de orientação do usuário.

| nível de usuário | GPT-5-Codex | GPT-5-Codex-Mini |

|---|---|---|

| Mais/Negócios/Educação | aumenta o volume de mensagens em 1.5 vezes, respectivamente. | aumenta o volume de mensagens em 6 vezes, respectivamente. |

GPT-5-Codex-Mini vs GPT-5-Codex: diferenças nos benchmarks

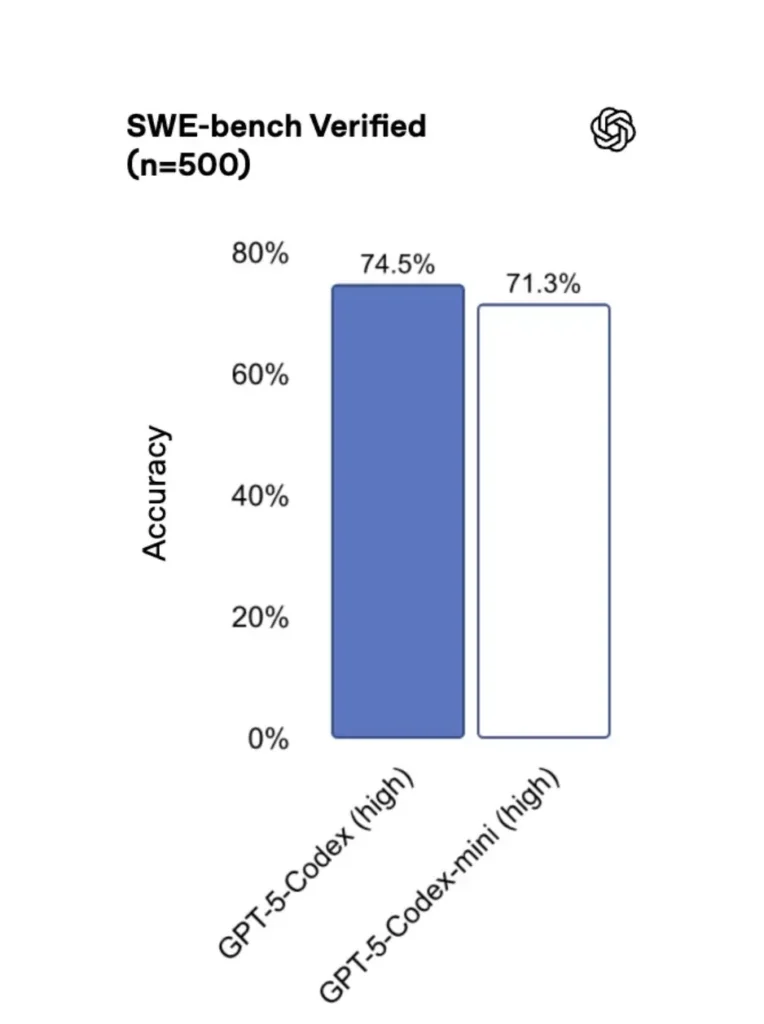

Comparado à versão original, o GPT-5-Codex-Mini apresenta um desempenho ligeiramente inferior, mas os desenvolvedores recebem aproximadamente quatro vezes mais créditos de utilização. No teste SWE-bench Verified, o GPT-5 High obteve 72.8%, o GPT-5-Codex 74.5% e o GPT-5-Codex-Mini 71.3%.

O Codex (e sua variante mini) usa drasticamente menos tokens para interações leves — os materiais da OpenAI afirmam reduções na ordem de dezenas de pontos percentuais para prompts simples (por exemplo, um valor citado de ≈93.7% menos tokens em interações leves para a família Codex versus GPT-5 em alguns cenários).

GPT-5-Codex-Mini vs GPT-5-Codex: diferenças de recursos

- Tamanho e custo: O Mini é explicitamente menor e mais econômico; a OpenAI o descreve como permitindo cerca de 4 vezes mais uso sob as mesmas restrições de assinatura. Trata-se de uma otimização de cota/eficiência para tarefas rotineiras de desenvolvedores.

- Envoltório de capacidade: O GPT-5-Codex continua sendo a opção de maior capacidade para tarefas complexas e de longa duração (grandes refatorações, revisões de código detalhadas, ciclos de teste extensos). O Mini foi otimizado para ser mais ágil e menos intensivo em recursos para interações curtas e frequentes.

- Limites de latência e taxa: O Mini geralmente oferece menor latência e permite limites de taxa mais altos por plano, tornando-o adequado para fluxos de trabalho densos e interativos.

- Superfícies padrão: O Mini está disponível como um modelo selecionável no Codex CLI e na extensão IDE; o GPT-5-Codex é o padrão para tarefas na nuvem e fluxos de revisão de código aprofundados no Codex.

Quando usar o Codex Mini ou o Codex Completo

- Uso Mini Para: estruturação, geração repetitiva de código, pequenas refatorações, sugestões interativas durante a edição e quando se trabalha com cotas ou restrições de custo.

- Uso GPT-5-Codex Indicado para: revisões de código abrangentes, tarefas autônomas de várias horas, refatorações complexas e tarefas que exigem o raciocínio mais robusto do modelo e execução orientada a testes.

Como posso acessar o GPT-5-Codex-Mini (CLI, IDE, API)?

Codex CLI (terminal-primeiro)

OpenAI introduzido gpt-5-codex-mini como uma opção de modelo dentro da CLI do Codex. Os padrões de uso típicos seguem o fluxo de trabalho da CLI do Codex: iniciar uma sessão interativa, especificar o modelo, anexar arquivos ou capturas de tela, executar "tarefas na Nuvem do Codex" e muito mais. A CLI também oferece suporte a comandos rápidos. /model alternando entre completo gpt-5-codex e gpt-5-codex-miniNa primeira execução, você precisará se autenticar usando sua conta ChatGPT/Pro/Enterprise (ou fornecer uma chave de API). A CLI oferece vários comandos que permitem ao Codex analisar bases de código, executar testes, abrir REPLs ou aplicar recomendações de patches.

Exemplo (sessão interativa da CLI do Codex):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

Esse fluxo espelha as novas configurações padrão da CLI do Codex, onde a ferramenta sugerirá o uso do Mini próximo aos limites de uso.

Extensão para VS Code/IDE

Sim — a extensão Codex IDE (VS Code) já inclui gpt-5-codex-mini Como opção, instale a extensão Codex no Visual Studio Code para obter preenchimento automático de código embutido, sugestões de refatoração e correções rápidas baseadas em IA. A extensão também oferece ações rápidas (gerar código, explicar o código selecionado, refatorar) e pode executar tarefas do Codex Cloud diretamente do editor.

- Instale a extensão OpenAI Codex / ChatGPT para VS Code.

- Faça login com sua conta ChatGPT (Plus/Pro/Business).

- Abra a paleta de comandos:

Cmd/Ctrl+Shift+P → Codex: Set Model→ escolhagpt-5-codex-mini. - Utilize comandos embutidos (selecione o código → clique com o botão direito → “Explicar com o Codex” ou pressione a tecla de atalho configurada).

Exemplo: comando embutido do VS Code (pseudo passos)

- Selecione uma função em

user_service.py. - Imprensa

Cmd/Ctrl+Shift+P → Codex: Explain Selectionou use o botão direito do mouse → “Explicar com o Codex”. - A extensão abre um painel lateral com a explicação do Mini, testes sugeridos e um botão "Criar PR" que, com um único clique, usa as tarefas do Codex Cloud para enviar uma branch para revisão.

E quanto à API — posso chamá-la do meu aplicativo?

Os anúncios da OpenAI indicam O suporte à API estará disponível em breve. Para GPT-5-Codex-Mini; no momento da redação deste documento, o modelo está disponível primeiro no conjunto de ferramentas Codex (CLI/IDE). Isso significa que os clientes da API de produção devem se preparar para o nome do modelo. gpt-5-codex-mini na API de Requisições/Respostas assim que for publicada. Enquanto isso, você pode criar protótipos com os fluxos da CLI e do IDE do Codex.

Quando o acesso à API está habilitado, uma chamada típica (no estilo de respostas) pode ser semelhante a:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Quais são as melhores práticas para engenharia rápida com o Codex Mini?

A seguir, apresentamos as melhores práticas e padrões concretos e testados em campo para obter o máximo valor do Codex Mini em fluxos de trabalho de engenharia de produção.

1) Estratégia de seleção de modelos — combinação de modelos.

Use o Mini para tarefas frequentes e de baixa complexidade (formatação, pequenas refatorações, testes automatizados) e recorra ao Codex completo para projetos complexos, depuração profunda ou grandes transformações em todo o repositório. Automatize a transição: a CLI do Codex já sugere o uso do Mini em 90% dos casos, e você pode criar scripts para isso. /model Alterar suas ferramentas para escolher um modelo com base na complexidade da tarefa.

2) Modelos de engenharia de resposta rápida

Crie modelos de prompts pequenos e determinísticos para tarefas repetíveis: geração de testes, rascunhos de changelog, geração de mensagens de commit e descrições de pull requests. Armazene-os como trechos reutilizáveis em seu repositório ou como predefinições de prompts do Codex.

Exemplo de modelo de prompt para testes unitários:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) Automatizar mecanismos de segurança — aprovações e controle de qualidade.

Nunca permita que um modelo envie código diretamente sem aprovação humana. Use os modos de aprovação do Codex e as tarefas do Codex Cloud para criar diffs e exigir aprovação humana na CI. A CLI do Codex oferece suporte a "modos de aprovação", portanto, as edições devem ser aprovadas antes de serem aplicadas.

4) Armazenar em cache e remover chamadas de modelo duplicadas

Para solicitações repetitivas (por exemplo, explicar uma função), armazene em cache a resposta indexada pela solicitação + hash do arquivo. Isso reduz chamadas redundantes e mantém o perfil de custo previsível.

5) Use streaming + diferenças incrementais

Sempre que possível, solicite saídas em fluxo contínuo e diferenças incrementais em vez de reescritas de arquivos inteiros. Isso reduz o uso de tokens e ajuda os revisores a visualizarem as alterações direcionadas.

6) Teste unitário - primeiro fluxo do gerador

Gere testes e execute-os localmente em um ambiente efêmero. Se os testes falharem, itere com o modelo, fornecendo correções para os testes com falha. Estruture cada iteração como um prompt discreto com as saídas dos testes incluídas.

Exemplo de trecho de código para automação da CLI do Codex (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

Conclusão

O GPT-5-Codex-Mini é uma iniciativa pragmática: reconhece que os fluxos de trabalho de desenvolvedores são frequentemente dominados por muitas interações curtas, onde latência, custo e fluxo ininterrupto são cruciais. Ao fornecer um nível "mini" voltado para o uso em IDEs e CLIs, a OpenAI permite que as equipes escalem a assistência de codificação diária sem precisar recorrer imediatamente ao modelo de maior custo para cada interação.

Os desenvolvedores podem acessar API GPT-5-Codex ,API GPT-5 Pro Através do CometAPI, os modelos mais recentes listados são os da data de publicação do artigo. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave da API.CometAPI oferecem um preço muito mais baixo que o preço oficial para ajudar você a se integrar.

Pronto para ir?→ Inscreva-se no CometAPI hoje mesmo !

Se você quiser saber mais dicas, guias e novidades sobre IA, siga-nos em VK, X e Discord!