Las noticias sobre Gemini 3.0 han sido el tema más comentado entre los desarrolladores desde agosto, con constantes informes que anunciaban con confianza su fecha de lanzamiento, solo para descubrir que nunca llegó. Las esperanzas se han visto frustradas una y otra vez, pero la expectación sigue siendo alta, ya que el rendimiento del Gemini 2.5 Pro ya se ha quedado atrás respecto a sus competidores, Chatgpt y Claude. Ahora les traigo las últimas noticias de primera mano, y me complace anunciar que ya está disponible en CometAPI.

La próxima generación de Gemini 3 de Google ha generado más rumores y filtraciones que la mayoría de los lanzamientos de productos: puntos de control de la comunidad que aparecen en sitios web públicos de evaluación comparativa, nombres de modelos que aparecen en las propias herramientas de Google y una vía activa para que los desarrolladores prueben los modelos a través de la CLI de Gemini y la API de Comet.

¿Qué es Gemini 3.0 y por qué genera tanta expectación?

En términos generales, Gemini 3.0 es el próxima iteración importante de la familia Gemini de grandes modelos de IA multimodales desarrollados por Google DeepMind (y su empresa matriz Google LLC). La serie Gemini se posiciona como la línea insignia de modelos de IA de Google, diseñada no solo para la comprensión y generación de texto, sino también para tareas multimodales (texto + imagen + código + audio/video), razonamiento, uso de herramientas y, en última instancia, un comportamiento más proactivo.

La razón por la que la gente está tan entusiasmada con Gemini 3.0 es que parece representar un gran salto adelante —no se trata de una simple actualización— sino de una mejora significativa en la capacidad del modelo, la amplitud del contexto, el razonamiento y su utilidad práctica. Filtraciones de la comunidad, referencias de código, análisis comparativos y artículos sugieren que Gemini 3.0 se adentrará en un nuevo territorio de «modelos pensantes», ventanas de contexto más amplias, una integración multimodal más profunda y la orquestación de herramientas con agentes.

A continuación, explicaré con detalle el proceso. por qué Eso importa, lo que sabemos hasta ahora e lo que aún es especulativo.

¿Qué son “lithiumflow” y “orionmist”, y por qué aparecieron en LMArena?

¿Qué descubrieron LM Arena y la comunidad?

Entre el 19 y el 23 de octubre, los investigadores de la comunidad encontraron dos nuevos puntos de control de LM Arena llamados lithiumflow y orionmist. Estos nombres parecen coincidir con las convenciones de nomenclatura internas de Google (el nombre de la familia "orion" se ha utilizado en nombres en clave anteriores de Gemini), y los analistas de la comunidad los interpretan como identificadores o puntos de control iniciales para variantes de Gemini 3.x, coloquialmente conocidas como puntos de control de Gemini 3 Pro/Flash.

¿Por qué importa esto?

Si Lithiumflow y Orionmist son verdaderos hitos de Gemini 3, esta división sugiere que Google podría estar preparando varias subfamilias (Flash y Pro): por ejemplo, una variante de Lithiumflow optimizada para el rendimiento y la eficiencia, y una variante de Orionmist adaptada para la recuperación de datos actualizada o capacidades multimodales. Lithiumflow parece ser (según las especulaciones de la comunidad) el modelo de generación base, optimizado para el razonamiento y la generación (sin base de búsqueda). Orionmist parece ser una variante con integración a datos externos y búsqueda en tiempo real, posiblemente más potente en la generación con recuperación de datos o en tareas en tiempo real.

Mi prueba

El programa de registro del LM Arena muy fuerte Resultados de Lithiumflow en tareas de lenguaje clásico (razonamiento, código y algunas tareas de SVG/diseño). Varios analistas de la comunidad también publicaron comparaciones directas que afirman que Lithiumflow supera a la versión pública actual de Gemini 2.x y a otras alternativas similares en microbenchmarks específicos.

El uso de Lithiumflow para la escritura resulta en una mayor creatividad y calidad literaria que Gemini 2.5, pero el límite de palabras sigue siendo una debilidad, apenas entre dos y tres mil. Combinado con OrionMist, puede competir con Claude 4.5 en rendimiento y precisión de codificación, pero la diferencia no es significativa.

Así es como se comparan estos modelos en las pruebas de referencia realizadas hasta el momento:

| Gemini 3.0 (litio) | Géminis 3.0 (orionmist) | Géminis 2.5 Pro | Claude Opus 4.1 | Soneto de Claudio 3.7 | |

|---|---|---|---|---|---|

| Banco simple | 80-100% | 80-100% | 62.4% | 60.0% | 46.4% |

Ambos modelos aún presentaban ilusiones e inestabilidades en ciertas tareas de conocimiento, algo comprensible en una fase inicial de desarrollo. Este patrón (excelente desempeño en tareas creativas y generación de código/estructura de alta calidad, pero con errores de hecho ocasionales) es común cuando los modelos se combinan con nuevas capacidades multimodales o de generación de código.

Las pruebas de estos dos modelos han concluido en LM Arena, lo que confirma aún más que se trata efectivamente de Gemini 3.0.

Participación de Apple y especificaciones filtradas

Diferencias de modelo

A mediados de 2025, Verde Según los informes, se filtraron fragmentos de código en una versión beta de iOS que mostraban identificadores como com.google.gemini_3_pro y gemini_3_ultra.

Los analistas dedujeron que Google y Apple se estaban preparando. Integraciones de “Apple Intelligence” con tecnología Gemini, probablemente para Siri y el resumen en el dispositivo:

- Gemini 3 Pro (capa de razonamiento basada en la nube)

- Gemini 3 Nano (variante integrada en el dispositivo)

- inferencia multimodal en tiempo real

Esto coincide con el impulso de Google por un Tejido de IA Conectando dispositivos móviles, API en la nube y el ecosistema web.

Fuga de especificaciones

Apple y Google negocian una mayor integración de Gemini para Apple Intelligence/Siri. Según una primicia, Apple planea usar una variante personalizada de Gemini en su plataforma de IA. Apple y Google mencionaron el parámetro de 1.2 TB en su plan de colaboración para modelos de inteligencia artificial, que podría corresponder a la especificación de Gemini 3.0.

Cómo empezar con la vista previa del Gemini 3 Pro

Según la información disponible y las pruebas realizadas, proporcionaré tres métodos: Vertex, Gemini CLI y API. Los desarrolladores pueden elegir el método que mejor se adapte a sus necesidades y entorno. El nombre del modelo Gemini 3.0 Pro es gemini-3-pro-preview-11-2025 y gemini-3-pro-preview-11-2025-thinking.

Vértice de acceso

Gemini 3.0 pro (gemini-3-pro-preview-11-2025) Se ha añadido a la lista de modelos de Vertex, y algunos usuarios de la comunidad afirman que pueden probarlo directamente, siempre que tengan una cuenta de pago de Vertex y puedan acceder a ella utilizando sus credenciales de cuenta. De hecho, se pueden encontrar rastros en los registros de red de Vertex:

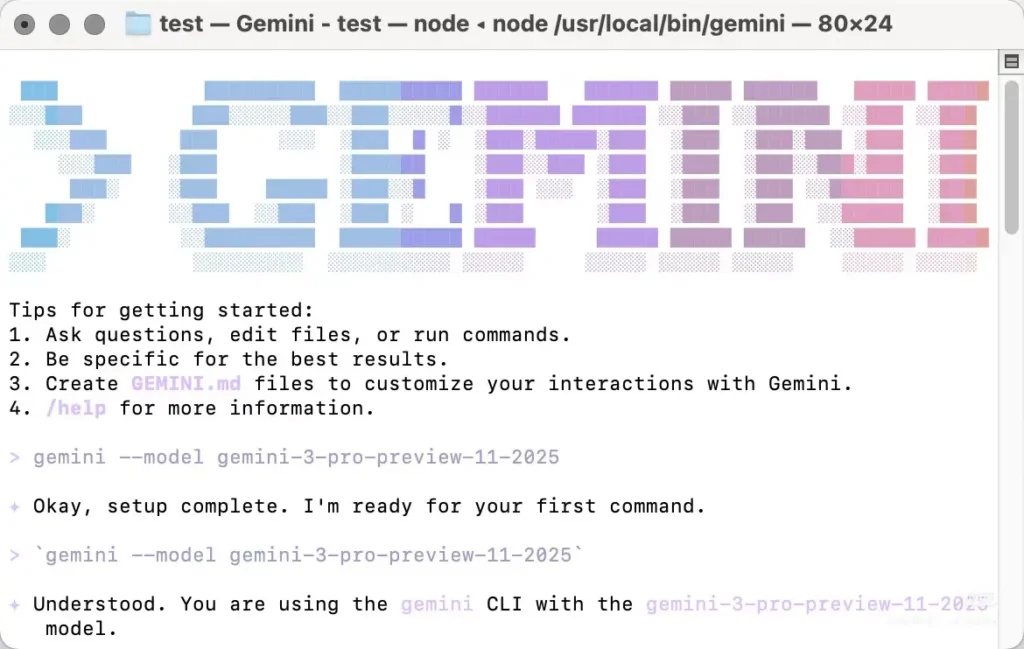

Acceso Gemini cli

También se puede invocar Gemini 3.0 Pro desde la CLI de Gemini, pero es necesario especificar el modelo manualmente. La mayoría de las reseñas más recientes de Gemini 3.0 Pro se basan en el uso de la CLI. Sin embargo, presenta algunos inconvenientes: solo funciona con algunos nodos de Norteamérica, requiere cambiar manualmente la dirección IP local para probarlo y puede que sea necesario intentarlo varias veces. No es muy estable y devuelve un error 404 si falla.

Tu necesitas instalar la CLI de Gemini localmenteA continuación, autentíquese con una cuenta que tenga permisos de acceso (cuenta de Google/cuenta de CometAPI) y especifique manualmente el nombre del modelo “gemini-3-pro-preview-11-2025Para usar Gemini 3.0 pro-preview, por ejemplo: instalar y ejecutar (shell).

```bash

# instant run (no install)

npx https://github.com/google-gemini/gemini-cli

or install globally:

npm install -g @google/gemini-cli

# or on macOS/Linux using Homebrew

brew install gemini-cli

La CLI acepta identificadores de modelo de la misma forma que la API. En la práctica: configure su identificador de modelo (por ejemplo, `model: "gemini-3-pro-preview-11-2025"`) en una solicitud o configuración de CLI e invocarla; si su cuenta tiene acceso, la solicitud tendrá éxito.

### Acceda a la API de CometAPI

[CometAPI](https://www.cometapi.com/es/) Es una plataforma API unificada que reúne más de 500 modelos de IA de proveedores líderes —como la serie GPT de OpenAI, Gemini de Google, Claude de Anthropic, Midjourney, Suno y otros— en una única interfaz intuitiva para desarrolladores. Ofrece autenticación, formato de solicitudes y gestión de respuestas consistentes.

CometAPI ha integrado la [API de vista previa de Gemini 3 Pro](https://www.cometapi.com/es/gemini-3-pro-api/) , y el nombre de la llamada a la API interna es `gemini-3-pro-preview`Al realizar la llamada, solo necesita cambiar la dirección de solicitud a `https://api.cometapi.com/v1/chat/completions`.

Puedes llamar a la versión preliminar de Gemini 3.0 Pro de la misma forma que llamas a la API de OpenAI. En mis pruebas, la llamada a través de CometAPI es más estable que usar la CLI de Gemini.

## ¿Cuáles son las características previstas de Gemini 3.0?

A continuación se presentan las capacidades más comentadas (indicando explícitamente qué elementos están confirmados frente a las expectativas de la comunidad/analistas).

### Diseño y arquitectura del núcleo (confirmado vs. esperado)

- **Fundación multimodal:** Gemini se ha diseñado como una plataforma multimodal (texto, imágenes, código, audio/vídeo), y Google ya ha publicado modelos y herramientas multimodales en la API de Gemini. Esto está confirmado y seguirá siendo fundamental.

- **Razonamiento avanzado / planificación:** Se prevé una mayor integración de las técnicas de planificación y aprendizaje por refuerzo, basadas en la investigación de DeepMind, lo que probablemente marcará una diferencia en el enfoque de diseño con respecto a algunos competidores. Esta expectativa se fundamenta en la trayectoria de DeepMind, más que en una especificación pública.

### Ventana de contexto y memoria

Ventanas de contexto más amplias: Gemini 3.0 aumentará la capacidad efectiva de contexto (se especula que podría alcanzar millones de tokens), basándose en trabajos previos sobre contextos amplios. Esto es una predicción; Google aún no ha publicado los límites oficiales de tokens para Gemini 3.0.

### Rendimiento, latencia y variantes del modelo

- **Alta precisión en el razonamiento y la codificación:** Las publicaciones de la comunidad LM Arena sobre “lithiumflow” (y “orionmist”) sugieren un buen rendimiento en tareas de razonamiento y codificación. Si bien se trata de pruebas de rendimiento de la comunidad no verificadas, son el principal motivo de entusiasmo. Considérenlas como indicios iniciales, no como prueba definitiva.

- **Múltiples variantes:** Los rumores y las filtraciones apuntan a distintas versiones: una versión básica/«Pro» (a menudo asociada en publicaciones con la etiqueta lithiumflow) y una versión con conexión a tierra/con capacidad de búsqueda (orionmist). Cabe mencionar que estas son deducciones de la comunidad basadas en los identificadores de los modelos y su comportamiento en las pruebas.

### Multimodalidad y nuevas capacidades

- **Integración de vídeo e imagen:** Recientemente, Google ha incorporado modelos de vídeo (p. ej., Veo 3) y funcionalidades de imagen a la API de Gemini; se espera que Gemini 3.0 aproveche y unifique estas funcionalidades para crear flujos de trabajo multimodales más completos. Esto se ve respaldado por versiones anteriores de Google en el ecosistema de Gemini.

- **Funciones en el dispositivo y de privacidad (objetivo):**Se prevén opciones más eficientes, ya sea en el dispositivo o en la nube privada, para el almacenamiento de datos confidenciales, dado que Google y sus socios priorizan la privacidad y una menor latencia. Esta predicción se basa en las tendencias del ecosistema; aún no se han publicado los detalles de Gemini 3.0.

## En pocas palabras

Se espera que la versión preliminar de Gemini 3.0 Pro suponga un cambio radical para los modelos multimodales de Google centrados en el razonamiento, ofreciendo potencialmente un contexto más amplio, una planificación más sólida y capacidades multimodales más completas. El entusiasmo actual se debe a una mezcla de **Herramientas para desarrolladores confirmadas y señales de productos de Google** (API Gemini, CLI, modelos Veo/de vídeo) y **señales comunitarias no oficiales pero ruidosas** (Entradas de LM Arena para lithiumflow/orionmist, filtraciones y cronologías de rumores de analistas). Considera los indicadores de referencia de la comunidad como indicadores tempranos y prepárate aprendiendo a usar las herramientas para desarrolladores de Gemini para que puedas evaluar el modelo objetivamente cuando Google lance el acceso oficial.

Creo que la fecha de lanzamiento oficial más probable es el 18 de noviembre, que coincide con el plan de migración de modelos de Google para ese mismo día. ¡Esperemos con interés más información sobre la vista previa del Gemini 3 Pro!

### Primeros Pasos

CometAPI es una plataforma API unificada que integra más de 500 modelos de IA de proveedores líderes, como la serie GPT de OpenAI, Gemini de Google, Claude de Anthropic, Midjourney, Suno y más, en una única interfaz intuitiva para desarrolladores. Al ofrecer autenticación, formato de solicitudes y gestión de respuestas consistentes, CometAPI simplifica drásticamente la integración de las capacidades de IA en sus aplicaciones. Ya sea que esté desarrollando chatbots, generadores de imágenes, compositores musicales o canales de análisis basados en datos, CometAPI le permite iterar más rápido, controlar costos y mantenerse independiente del proveedor, todo mientras aprovecha los últimos avances del ecosistema de IA.

Los desarrolladores pueden acceder a la versión preliminar de Gemini 3.0 pro a través de CometAPI. [la última versión del modelo](https://api.cometapi.com/pricing) Se actualiza constantemente con el sitio web oficial. Para empezar, explora las capacidades del modelo en el [Playground](https://www.cometapi.com/console/playground) y consultar el [Guía de API](https://api.cometapi.com/doc) Para obtener instrucciones detalladas, consulte la sección "Antes de acceder, asegúrese de haber iniciado sesión en CometAPI y de haber obtenido la clave API". [CometAPI](https://www.cometapi.com/es/) Ofrecemos un precio muy inferior al oficial para ayudarte a integrarte.

¿Listo para ir?→ [Regístrate en CometAPI hoy](https://api.cometapi.com/login) !

Si quieres conocer más consejos, guías y novedades sobre IA síguenos en [VK](https://vk.com/id1078176061), [X](https://x.com/cometapi2025) y [Discord](https://discord.com/invite/HMpuV6FCrG)!