Entre 2025 y 2026, el panorama de las herramientas de IA continuó consolidándose: las API de puerta de enlace (como CometAPI) se expandieron para proporcionar acceso al estilo de OpenAI a cientos de modelos, mientras que las aplicaciones LLM para usuarios finales (como AnythingLLM) siguieron mejorando su proveedor "OpenAI genérico" para permitir que las aplicaciones de escritorio y las aplicaciones locales accedieran a cualquier punto de conexión compatible con OpenAI. Esto facilita hoy en día enrutar el tráfico de AnythingLLM a través de CometAPI y obtener las ventajas de la selección de modelos, el enrutamiento de costes y la facturación unificada, sin dejar de utilizar la interfaz de usuario local y las funciones RAG/de agente de AnythingLLM.

¿Qué es AnythingLLM y por qué querrías conectarlo a CometAPI?

¿Qué es AnythingLLM?

AnythingLLM es una aplicación de IA integral de código abierto y un cliente local/en la nube para crear asistentes de chat, flujos de trabajo de generación aumentada por recuperación (RAG) y agentes basados en LLM. Ofrece una interfaz de usuario elegante, una API para desarrolladores, funciones de espacio de trabajo/agente y compatibilidad con LLM locales y en la nube; está diseñada para ser privada por defecto y extensible mediante plugins. AnythingLLM expone una OpenAI genérico proveedor que le permite comunicarse con las API de LLM compatibles con OpenAI.

¿Qué es CometAPI?

CometAPI es una plataforma comercial de agregación de API que expone Más de 500 modelos de IA a través de una interfaz REST al estilo de OpenAI y una facturación unificada. En la práctica, permite llamar a modelos de múltiples proveedores (OpenAI, Anthropic, variantes de Google/Gemini, modelos de imagen/audio, etc.) mediante la misma interfaz. https://api.cometapi.com/v1 puntos de conexión y una única clave API (formato sk-xxxxxCometAPI admite puntos de conexión estándar al estilo de OpenAI, como por ejemplo: /v1/chat/completions, /v1/embeddings, etc., lo que facilita la adaptación de herramientas que ya admiten API compatibles con OpenAI.

¿Por qué integrar AnythingLLM con CometAPI?

Tres razones prácticas:

- Elección de modelo y flexibilidad del proveedor: AnythingLLM puede usar cualquier LLM compatible con OpenAI mediante su wrapper genérico de OpenAI. Al conectar dicho wrapper a CometAPI, se obtiene acceso inmediato a cientos de modelos sin modificar la interfaz de usuario ni los flujos de trabajo de AnythingLLM.

- Optimización de costes y operaciones: El uso de CometAPI le permite cambiar de modelo (o pasar a modelos más económicos) de forma centralizada para el control de costes y mantener una facturación unificada en lugar de gestionar múltiples claves de proveedor.

- Experimentación más rápida: Puedes realizar comparaciones A/B entre diferentes modelos (por ejemplo,

gpt-4o,gpt-4.5, variantes de Claude o modelos multimodales de código abierto) a través de la misma interfaz de usuario de AnythingLLM, útil para agentes, respuestas RAG, resumen y tareas multimodales.

El entorno y las condiciones deben prepararse antes de la integración.

Requisitos del sistema y del software (nivel general)

- Ordenador de escritorio o servidor con AnythingLLM (Windows, macOS, Linux): instalación de escritorio o instancia autohospedada. Confirme que está utilizando una compilación reciente que expone la Preferencias de LLM / Proveedores de IA configuración.

- una cuenta CometAPI y una clave API (la

sk-xxxxx(Secreto de estilo). Usarás este secreto en el proveedor OpenAI genérico de AnythingLLM. - Conectividad de red desde su máquina a

https://api.cometapi.com(sin firewall que bloquee el HTTPS saliente). - Opcional pero recomendado: un entorno moderno de Python o Node para realizar pruebas (Python 3.10+ o Node 18+), curl y un cliente HTTP (Postman / HTTPie) para comprobar que CometAPI funciona correctamente antes de integrarlo en AnythingLLM.

Condiciones específicas de AnythingLLM

El elemento OpenAI genérico El proveedor LLM es la opción recomendada para los endpoints que imitan la interfaz de la API de OpenAI. La documentación de AnythingLLM advierte que este proveedor está orientado a desarrolladores y que es importante comprender los parámetros que se proporcionan. Si se utiliza streaming o el endpoint no lo admite, AnythingLLM incluye una opción para deshabilitar el streaming para OpenAI genérico.

Lista de verificación de seguridad y operativa

- Trata la clave CometAPI como cualquier otro secreto: no la subas a repositorios; guárdala en llaveros del sistema operativo o en variables de entorno siempre que sea posible.

- Si planea utilizar documentos confidenciales en RAG, asegúrese de que las garantías de privacidad de los puntos de conexión cumplan con sus necesidades de cumplimiento (consulte la documentación/términos de CometAPI).

- Decide los límites máximos de tokens y de la ventana de contexto para evitar facturas descontroladas.

¿Cómo se configura AnythingLLM para usar CometAPI (paso a paso)?

A continuación se muestra una secuencia de pasos concreta, seguida de ejemplos de variables de entorno y fragmentos de código para probar la conexión antes de guardar la configuración en la interfaz de usuario de AnythingLLM.

Paso 1 — Obtén tu clave CometAPI

- Regístrate o inicia sesión en CometAPI.

- Navegue hasta “Claves API” y genere una clave; obtendrá una cadena similar a la siguiente:

sk-xxxxxManténlo en secreto.

Paso 2 — Verificar que CometAPI funciona con una solicitud rápida

Utilice curl o Python para llamar a un punto final de finalización de chat simple para confirmar la conectividad.

Ejemplo de curl

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

Si esto devuelve un código 200 y una respuesta JSON con un choices Si el array, la clave y la red funcionan correctamente, consulte la documentación de CometAPI, que muestra la interfaz y los endpoints al estilo de OpenAI.

Ejemplo de Python (peticiones)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

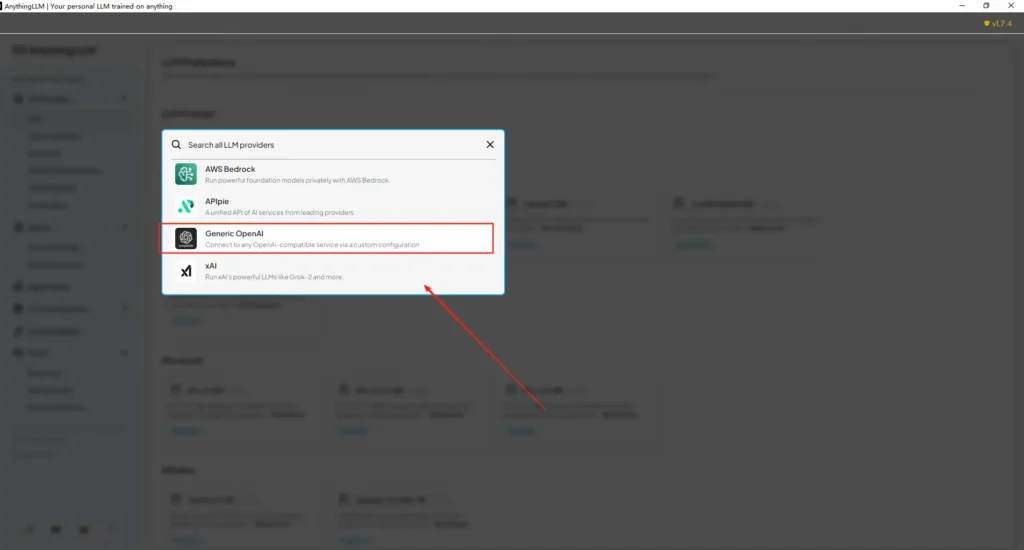

Paso 3 — Configurar AnythingLLM (Interfaz de usuario)

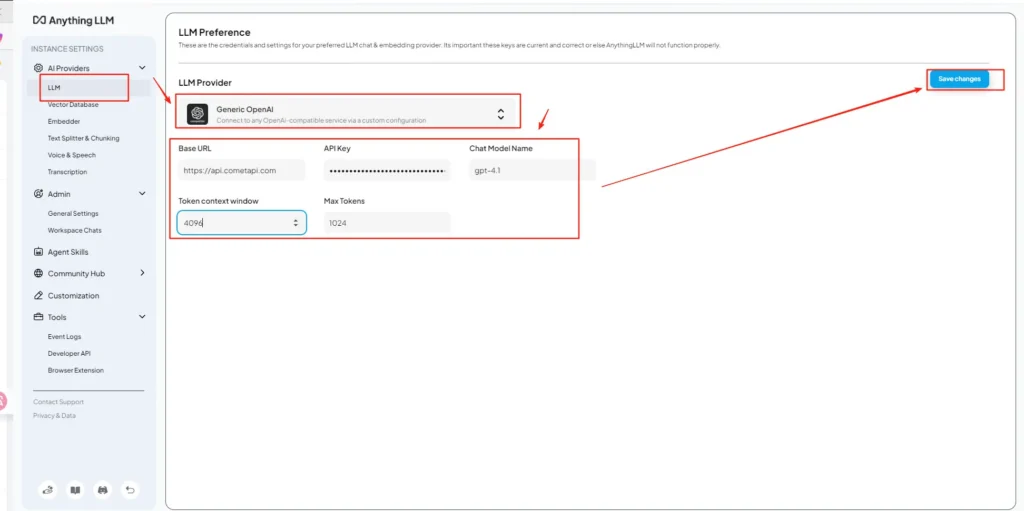

Abre AnythingLLM → Configuración → Proveedores de IA → Preferencias de LLM (o ruta similar en su versión). Utilice el OpenAI genérico proveedor y complete los campos de la siguiente manera:

Configuración de la API (ejemplo)

• Ingrese al menú de configuración de AnythingLLM y ubique Preferencias de LLM en Proveedores de IA.

• Seleccione OpenAI genérico como proveedor de modelos e ingresehttps://api.cometapi.com/v1en el campo URL.

• Pegue elsk-xxxxxde CometAPI en el cuadro de entrada de clave API. Complete la ventana de contexto de token y el número máximo de tokens según el modelo real. También puede personalizar los nombres de los modelos en esta página, como agregar elgpt-4omodelo.

Esto se alinea con la guía “OpenAI genérico” de AnythingLLM (envoltorio para desarrolladores) y el enfoque de URL base compatible con OpenAI de CometAPI.

Paso 4 — Establecer nombres de modelos y límites de tokens

En la misma pantalla de configuración, agregue o personalice los nombres de los modelos exactamente como los publica CometAPI (por ejemplo, gpt-4o, minimax-m2, kimi-k2-thinkingDe esta forma, la interfaz de usuario de AnythingLLM puede presentar esos modelos a los usuarios. CometAPI publica cadenas de modelos para cada proveedor.

Paso 5 — Prueba en AnythingLLM

Inicia un nuevo chat o usa un espacio de trabajo existente, selecciona el proveedor OpenAI genérico (si tienes varios proveedores), elige uno de los nombres de modelo de CometAPI que agregaste y ejecuta una solicitud sencilla. Si obtienes autocompletados coherentes, la integración se ha completado correctamente.

Cómo utiliza AnythingLLM esos ajustes internamente

El envoltorio genérico de OpenAI de AnythingLLM construye solicitudes al estilo de OpenAI (/v1/chat/completions, /v1/embeddings), así que una vez que configures la URL base y proporciones la clave CometAPI, AnythingLLM enrutará los chats, las llamadas de los agentes y las solicitudes de integración a través de CometAPI de forma transparente. Si utilizas agentes de AnythingLLM (el @agent flujos), heredarán el mismo proveedor.

¿Cuáles son las mejores prácticas y los posibles escollos?

Mejores prácticas

- Utilice la configuración de contexto adecuada para el modelo: Asegúrese de que la ventana de contexto de tokens y el número máximo de tokens de AnythingLLM coincidan con el modelo seleccionado en CometAPI. Una discrepancia puede provocar truncamientos inesperados o fallos en las llamadas.

- Proteja sus claves API: Almacena las claves de CometAPI en variables de entorno o en Kubernetes/secret manager; nunca las incluyas en Git. AnythingLLM almacenará las claves en su configuración local si las introduces en la interfaz de usuario; trata el almacenamiento del host como información confidencial.

- Comience con modelos más económicos/pequeños para los flujos experimentales: Utilice CometAPI para probar modelos de menor coste durante el desarrollo y reserve los modelos premium para producción. CometAPI ofrece explícitamente la posibilidad de cambiar de modelo según sus costes y una facturación unificada.

- Supervisar el uso y configurar alertas: CometAPI proporciona paneles de control de uso: configure presupuestos/alertas para evitar facturas sorpresa.

- Agentes y herramientas de prueba de forma aislada: Los agentes de AnythingLLM pueden desencadenar acciones; pruébelos primero con avisos seguros y en instancias de prueba.

Errores comunes

- Interfaz de usuario vs

.envconflictos: Al alojar la configuración en un servidor propio, la configuración de la interfaz de usuario puede sobrescribirla..envcambios (y viceversa). Comprueba el resultado generado./app/server/.envSi el problema persiste tras reiniciar, consulte el informe de problemas de la comunidad.LLM_PROVIDERse reinicia. - Errores en los nombres de los modelos: Usar un nombre de modelo no disponible en CometAPI provocará un error 400/404 del gateway. Siempre verifique los modelos disponibles en la lista de modelos de CometAPI.

- Límites de tokens y transmisión: Si necesitas respuestas en tiempo real, verifica que el modelo CometAPI admita la transmisión de datos (y que la versión de la interfaz de usuario de AnythingLLM también la admita). Algunos proveedores difieren en la semántica de la transmisión de datos.

¿Qué casos de uso reales permite esta integración?

Recuperación-Generación Aumentada (RAG)

Utilice los cargadores de documentos y la base de datos vectorial de AnythingLLM con los LLM de CometAPI para generar respuestas contextuales. Puede experimentar con modelos de incrustación económicos y modelos de chat complejos, o bien, mantener todo en CometAPI para una facturación unificada. Los flujos RAG de AnythingLLM son una función integrada principal.

Automatización de agentes

AnythingLLM lo admite @agent Flujos de trabajo (navegar páginas, llamar a herramientas, ejecutar automatizaciones). El enrutamiento de las llamadas LLM de los agentes a través de CometAPI le permite elegir entre varios modelos para los pasos de control/interpretación sin modificar el código del agente.

Pruebas A/B multimodelo y optimización de costes

Cambiar de modelo por espacio de trabajo o función (por ejemplo, gpt-4o para respuestas de producción, gpt-4o-mini (para desarrolladores). CometAPI simplifica los intercambios de modelos y centraliza los costos.

tuberías multimodales

CometAPI proporciona modelos de imagen, audio y especializados. La compatibilidad multimodal de AnythingLLM (a través de proveedores) junto con los modelos de CometAPI permite que la generación de subtítulos para imágenes, resúmenes multimodales o transcripciones de audio se realicen a través de la misma interfaz.

Conclusión

CometAPI continúa posicionándose como una plataforma multimodelo (más de 500 modelos, API estilo OpenAI), lo que la convierte en un socio ideal para aplicaciones como AnythingLLM, que ya son compatibles con un proveedor OpenAI genérico. Del mismo modo, el proveedor genérico de AnythingLLM y sus recientes opciones de configuración facilitan la conexión con dichas plataformas. Esta convergencia simplifica la experimentación y la migración a producción a finales de 2025.

Cómo empezar a utilizar la API de Comet

CometAPI es una plataforma API unificada que integra más de 500 modelos de IA de proveedores líderes, como la serie GPT de OpenAI, Gemini de Google, Claude de Anthropic, Midjourney, Suno y más, en una única interfaz intuitiva para desarrolladores. Al ofrecer autenticación, formato de solicitudes y gestión de respuestas consistentes, CometAPI simplifica drásticamente la integración de las capacidades de IA en sus aplicaciones. Ya sea que esté desarrollando chatbots, generadores de imágenes, compositores musicales o canales de análisis basados en datos, CometAPI le permite iterar más rápido, controlar costos y mantenerse independiente del proveedor, todo mientras aprovecha los últimos avances del ecosistema de IA.

Para empezar, explore las capacidades del modelo deCometAPI en el cuadro Playground Consulte la guía de la API para obtener instrucciones detalladas. Antes de acceder, asegúrese de haber iniciado sesión en CometAPI y de haber obtenido la clave de API. ComoeAPI Ofrecemos un precio muy inferior al oficial para ayudarte a integrarte.

¿Listo para ir?→ Regístrate en CometAPI hoy !

Si quieres conocer más consejos, guías y novedades sobre IA síguenos en VK, X y Discord!