La IA avanza rápidamente: los nuevos modelos multimodales y las API mejoradas en tiempo real facilitan la integración de una IA potente en las plataformas de automatización, mientras que los debates paralelos sobre seguridad y observabilidad están transformando la forma en que los equipos gestionan los sistemas de producción. Para quienes crean automatizaciones locales, está surgiendo un patrón práctico: utilizar una puerta de enlace de modelos unificada (como CometAPI) para acceder a muchos modelos y unir esas llamadas de modelo en un ejecutor de automatización autohospedado (como n8n) para que mantengas el control de los datos, la latencia y los costos. Esta guía te muestra, paso a paso, cómo empezar con CometAPI + n8n (local), qué tener en cuenta y cómo solucionar problemas cuando las cosas salen mal.

¿Qué es n8n y por qué es importante para la automatización de la IA?

n8n es una herramienta de código abierto para la automatización de flujos de trabajo con un editor visual y un amplio ecosistema de nodos (conectores). Está diseñada para permitirte encadenar activadores, transformaciones y llamadas a API externas en flujos de trabajo repetibles (webhooks, trabajos programados, procesamiento de archivos, chatbots, etc.). El alojamiento local de n8n te brinda control total sobre la residencia y la ejecución de los datos, lo cual es especialmente valioso al llamar a modelos de IA de terceros que manejan entradas sensibles.

¿Cómo funciona n8n en la práctica?

- Lienzo visual con activadores (Webhook, Cron) y nodos de acción (Solicitud HTTP, nodos de base de datos, correo electrónico).

- Los nodos comunitarios amplían la capacidad: puedes instalar paquetes comunitarios y tratarlos como nodos nativos.

El autohospedaje de n8n le ofrece:

- Control total de datos — Los flujos de trabajo y los datos de ejecución permanecen en la infraestructura que usted administra.

- Personalización — agregue nodos privados o integraciones locales sin esperar las funciones de la nube.

- Previsibilidad de costos — Sin sorpresas en la facturación por tarea en la nube para una automatización interna pesada.

- Seguridad y cumplimiento — es más fácil satisfacer las necesidades normativas y políticas internas.

¿Qué es CometAPI y por qué usarlo como puerta de enlace de modelos?

CometAPI Es una puerta de enlace API unificada que expone cientos de modelos de IA de terceros (texto, incrustaciones, generación de imágenes, etc.) tras una única interfaz y modelo de facturación compatibles con OpenAI. Esto significa que, en lugar de añadir integraciones personalizadas para cada LLM o motor de imágenes que desee probar, solo tiene que llamar a una API y seleccionar el modelo deseado en la solicitud. Esto simplifica la experimentación, el control de costes y la integración operativa.

beneficios:

- Elección del modelo: Pruebe muchos proveedores/modelos con la misma ruta de código.

- Agrupación de tokens / cuotas gratuitas: Muchas pasarelas unificadas ofrecen créditos/niveles para experimentar.

- Más simple infra: Un sistema de autenticación y una URL base para gestionar.

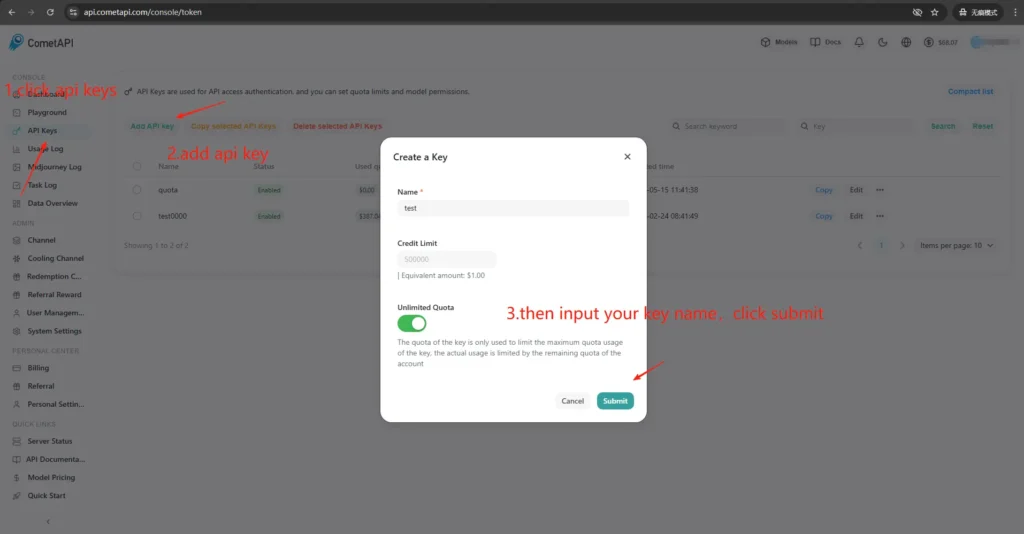

¿Cómo obtengo acceso y claves de CometAPI?

- Regístrate En el sitio de CometAPI (o en el panel del proveedor). La mayoría de las pasarelas ofrecen una versión gratuita para probar.

- Obtén una clave API Desde su panel de CometAPI: una cadena secreta larga. Tenga en cuenta dónde la documentación le indica que la coloque (CometAPI usa la autorización de portador contra...)

https://api.cometapi.com/v1). - Lea la documentación de la API Para el punto final que planea usar (finalizaciones de chat, imágenes, incrustaciones). CometAPI documenta puntos finales como

/v1/chat/completionsy/v1/images/generations.

¿Por qué es importante la unión (integración) entre n8n y CometAPI?

"Enlace" se refiere a una ruta de integración fiable y segura entre el ejecutor de automatización (n8n) y la puerta de enlace del modelo. Un enlace adecuado es importante porque:

- Conserva contexto en todas las llamadas (historial de conversaciones, incrustaciones).

- Se centraliza Cartas credenciales y secretos en un solo lugar para una rotación más segura.

- Reduce la latencia y la superficie de error mediante el uso de puntos finales predecibles y formatos de solicitud estándar.

- Permite observabilidad y resolución de problemas: saber qué modelo, mensaje y respuesta condujeron a un resultado.

En resumen: una buena unión reduce el riesgo operativo y acelera la iteración.

¿Cómo implementar n8n localmente (guía práctica rápida)?

Puede ejecutar n8n localmente con npm o con Docker; Docker Compose es el enfoque recomendado para la mayoría de los escenarios autoalojados (es reproducible y aísla las dependencias). A continuación, se muestra un ejemplo mínimo de Docker Compose y notas esenciales.

¿Cómo puedo alojar por mi cuenta n8n con Docker?

Docker (y Docker Compose) es la forma más robusta y repetible de ejecutar n8n en producción. Aísla la aplicación, simplifica las actualizaciones y se integra bien con proxies inversos y orquestadores (Docker Swarm, Kubernetes). La documentación oficial de n8n incluye una referencia de Docker Compose que seguiré y adaptaré aquí.

Para producción, normalmente se ejecutará una pila que consta de:

- Servicio n8n (imagen oficial:

docker.n8n.io/n8nio/n8norn8nio/n8n(dependiendo de la etiqueta). - PostgreSQL (u otra base de datos compatible).

- Redis (si planea utilizar el modo de cola).

- Un proxy inverso (Traefik, Caddy o nginx) para TLS, enrutamiento de host y reglas de límite de velocidad.

Esta arquitectura separa claramente las preocupaciones (persistencia de la base de datos, colas, proxy web) y simplifica el escalado y las copias de seguridad. La documentación oficial de n8n proporciona patrones de Docker Compose y referencias a variables de entorno.

Esta es una guía paso a paso:

- Crea una carpeta y una

docker-compose.ymlCon el servicio canónico n8n. A continuación, se muestra un ejemplo práctico de Docker-Compose que cubre las necesidades típicas de producción: Postgres externo, Redis (para el modo de cola/ejecución), volúmenes persistentes y un proxy inverso Nginx que gestiona TLS.

```yaml

version: "3.8"

services:

n8n:

image: n8nio/n8n:latest

restart: unless-stopped

environment:

- DB_TYPE=postgresdb

- DB_POSTGRESDB_HOST=postgres

- DB_POSTGRESDB_PORT=5432

- DB_POSTGRESDB_DATABASE=n8n

- DB_POSTGRESDB_USER=n8n

- DB_POSTGRESDB_PASSWORD=supersecretpassword

- N8N_BASIC_AUTH_ACTIVE=true

- N8N_BASIC_AUTH_USER=admin

- N8N_BASIC_AUTH_PASSWORD=anothersecret

- WEBHOOK_TUNNEL_URL=https://n8n.example.com

- EXECUTIONS_MODE=queue

- QUEUE_BULL_REDIS_HOST=redis

ports:

- "5678:5678"

volumes:

- n8n_data:/home/node/.n8n

depends_on:

- postgres

- redis

postgres:

image: postgres:15

environment:

POSTGRES_DB: n8n

POSTGRES_USER: n8n

POSTGRES_PASSWORD: supersecretpassword

volumes:

- pgdata:/var/lib/postgresql/data

redis:

image: redis:7

volumes:

- redisdata:/data

volumes:

n8n_data:

pgdata:

redisdata:

2. Comienza:

docker compose up -d

3. Visite `http://localhost:5678` Y crea tu usuario administrador. Para producción, necesitarás Postgres, SSL y las variables de entorno adecuadas (consulta la documentación oficial de Docker Compose).

**Notas y endurecimiento:**

- Do **no** almacenar secretos en texto plano en `docker-compose.yml`; utilice archivos de entorno, secretos de Docker o administradores de secretos externos en producción.

- Reemplace `WEBHOOK_URL` con su URL pública real y configure el proxy inverso para enrutar `n8n.example.com` al contenedor n8n.

- Use `EXECUTIONS_MODE=queue` Para un procesamiento en segundo plano robusto, requiere trabajadores de cola y Redis.

## ¿Cómo puedo autoalojar n8n con npm/Node.js?

La instalación mediante npm (o pnpm) ejecuta n8n directamente en el host. Esto es más ligero (sin capa de contenedor) y puede ser útil para instalaciones monousuario de baja complejidad o para equipos de desarrollo. Sin embargo, implica una mayor responsabilidad del administrador en la gestión de dependencias, el aislamiento y la supervisión de servicios. La documentación oficial de n8n incluye una guía de instalación de npm y advertencias.

### Los paquetes de sistema operativo necesarios y la versión del nodo:

- Utilice un Node.js LTS estable (Node 18 o Node 20+, que coincida con los requisitos de la versión n8n).

- Instalar `build-essential`, `git`y un administrador de procesos (se recomienda systemd).

- Para la producción, siga utilizando PostgreSQL y Redis como servicios externos (el mismo razonamiento que Docker).

### ¿Cómo instalo y ejecuto n8n a través de npm (paso a paso)?

1. Instalar Node.js (recomendado: nvm)

Install nvm

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash

Reload your shell (adjust to your shell startup file if needed)

source ~/.bashrc # or ~/.zshrc

Install and use the latest LTS (usually 18 or 20)

nvm install --lts

nvm use --lts

Verify

node -v

npm -v

Si más tarde ve “n8n: comando no encontrado”, reinicie la terminal o asegúrese de que la ruta bin global npm administrada por nvm esté en su PATH.

---

2. Instalar e iniciar n8n (local)

npm install -g n8n

n8n -v # verify version

3. Empezar en primer plano:

n8n start

URL predeterminada: <http://localhost:5678/> Si el puerto está en uso:

export N8N_PORT=5679

n8n start

Opcional: manténgalo ejecutándose en segundo plano (aún local):

npm install -g pm2

pm2 start "n8n" --name n8n

pm2 save

pm2 status

4.Primer acceso e inicio de sesión:

- Abra http://localhost:5678/ en su navegador.

- En la primera ejecución, siga el asistente para crear la cuenta de propietario (correo electrónico + contraseña) e iniciar sesión.

## ¿Cómo instalo o configuro un nodo comunitario CometAPI en n8n?

n8n admite tanto nodos comunitarios verificados (instalación GUI) como la instalación manual desde npm cuando se aloja el sistema por cuenta propia. Hay dos maneras de integrar CometAPI en n8n:

### Opción A: utilizar el nodo de la comunidad CometAPI (si está disponible en el panel Nodos)

1. En n8n abra el panel de nodos (presione `+` or `Tab`).

2. CometAPI es un nodo comunitario verificado. Aparece en "Más de la comunidad". Haz clic e instálalo.

3. Después de la instalación, reinicie n8n si se le solicita. Cree un nuevo **Credencial** en Configuración → Credenciales (elija el tipo de credencial CometAPI si el nodo lo proporciona) y pegue su token CometAPI.

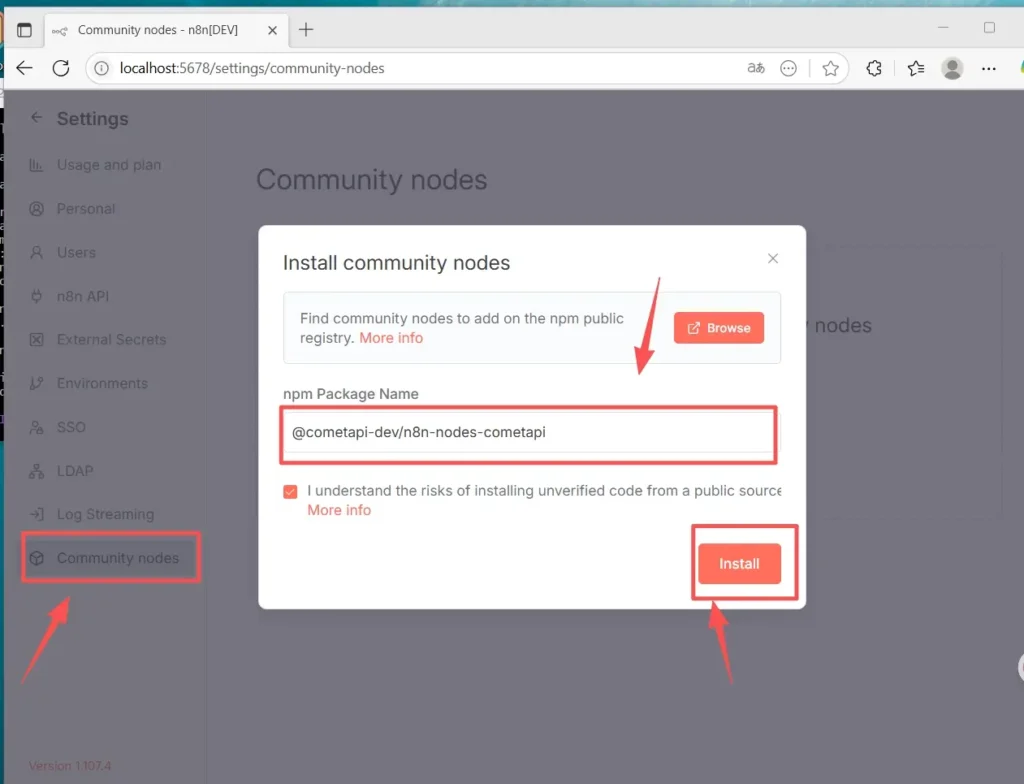

### Opción B: Instalación manual (cuando la instalación GUI no está disponible)

1. Inicie sesión en su host/contenedor n8n.

2. Instale el paquete en el n8n global `node_modules` o su carpeta personalizada:

- Vaya a Configuración (abajo a la izquierda) > Nodos de la comunidad. Haga clic en “

- Instalar un nodo comunitario”

- En “Nombre del paquete npm”, ingrese: `@cometapi-dev/n8n-nodes-cometapi`Marque la casilla de reconocimiento de riesgos. Haga clic en “

- Instalar”Después de la instalación, puede buscar “CometAPI” en el panel de nodos.

3. Reinicie n8n. Si su instancia se ejecuta en modo de cola, debe seguir la ruta de instalación manual descrita en la documentación.

### Cómo comprobar que el nodo está instalado

- Tras reiniciar, abra el panel de nodos y busque "CometAPI" o "Comet". El nodo se marcará como paquete comunitario.

- Si no puede ver el nodo: verifique que se use la cuenta del propietario de la instancia (solo los propietarios de instancias pueden instalar) o que el paquete del nodo se haya instalado sin errores en los registros del contenedor/imagen.

## Cómo crear un flujo de trabajo y configurar la API

### 1. Crear un nuevo flujo de trabajo

- Inicie sesión en su instancia n8n (autohospedada).

- Haga clic en **“Agregar flujo de trabajo”** para iniciar un nuevo lienzo de automatización.

### 2.Añadir nodo

- Agregue un nodo activador: busque “Activador manual” o “Al hacer clic en 'Ejecutar flujo de trabajo'”.

- Haga clic en el “+” en el lado derecho del lienzo y busque “CometAPI” para agregar el nodo.

- También puede buscar “CometAPI” en la lista de nodos de la izquierda y arrastrarlo al lienzo.

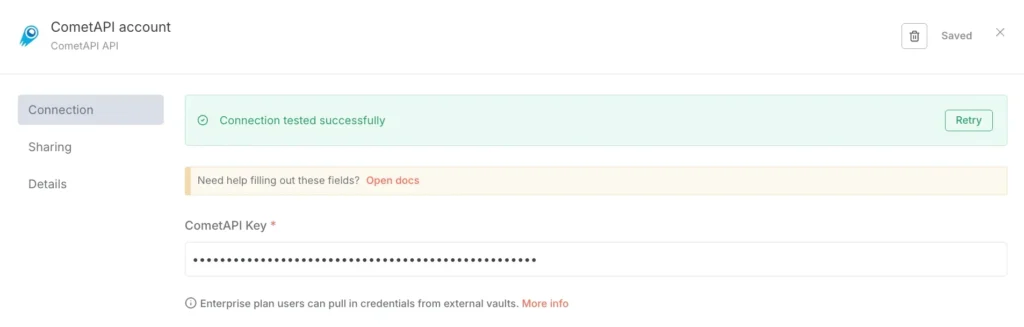

### 3. Configurar credenciales (solo la primera vez):

- En el nodo CometAPI, en “Credenciales para conectarse”, seleccione “Crear nuevo”.

- Pegue el token que creó en la consola CometAPI en “CometAPI Key”.

- Guardar. La URL base predeterminada es https://www.cometapi.com/console/ y, por lo general, no requiere cambios.

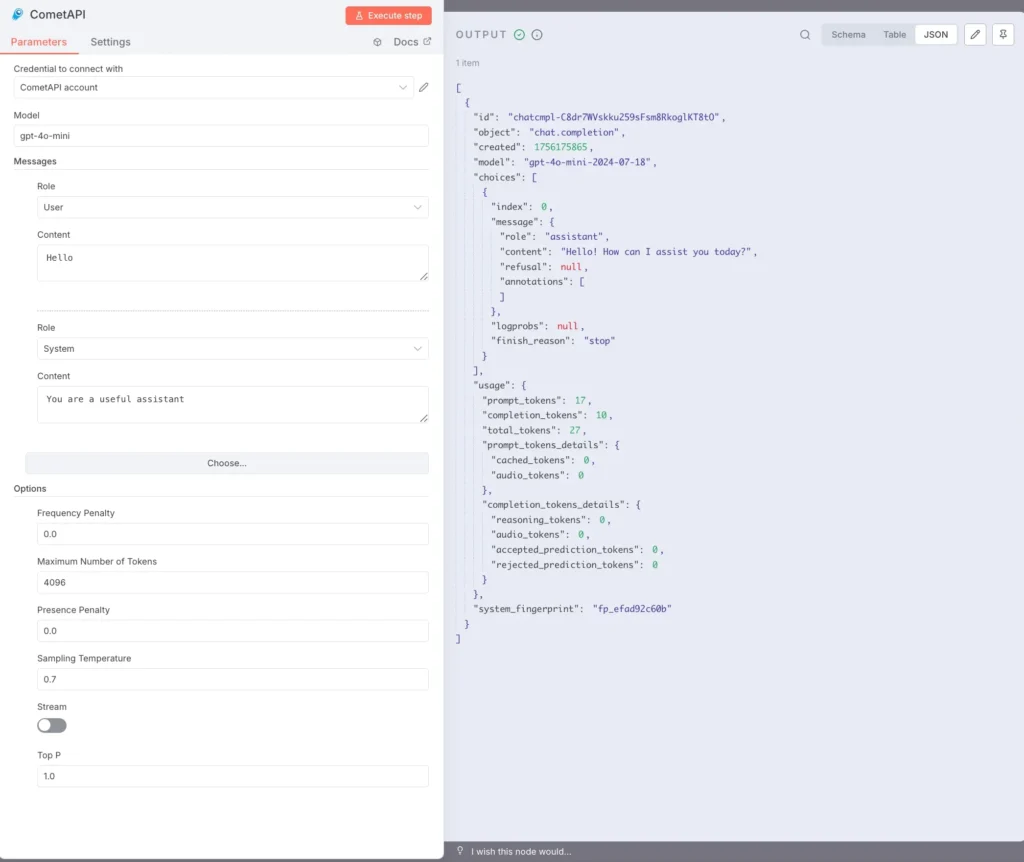

### 4. Configurar el modelo y los mensajes:

Modelo: ingrese un modelo compatible, p. ej., `gpt-4o` or `gpt-4o-mini`.

Mensajes: Debe completar el rol y el contexto, y puede elegir usuario o sistema para el rol.

Los parámetros opcionales (según sea necesario) incluyen: Número máximo de tokens (p. ej., 4096); Temperatura de muestreo (p. ej., 0.7); PenaltyStream (habilitar/deshabilitar la transmisión). Para obtener documentación y explicaciones específicas de los parámetros, consulte [Documentación de CometAPI](https://api.cometapi.com/doc).

### 5. Ejecución de texto:

Seleccione el nodo CometAPI y haga clic en “Ejecutar paso”, o haga clic en “Ejecutar flujo de trabajo” en la parte inferior.

El panel SALIDA a la derecha debe mostrar una respuesta JSON (incluyendo opciones, uso, etc.).

Ahora ha instalado n8n(Recommend) localmente en Linux a través de npm, ha instalado y configurado el nodo de la comunidad CometAPI y puede ejecutar flujos de trabajo que llaman a modelos como gpt-4o para recibir respuestas.

## ¿Cuáles son los problemas comunes y cómo puedo solucionarlos?

### 1) “401 No autorizado” o “Clave API no válida”

- Confirme la cadena de token exacta en su panel de CometAPI (puede haber tokens con nombres similares). Copie y pegue en la credencial n8n y reinicie el nodo si es necesario.

- Asegúrese de que el formato del encabezado de autorización sea `Bearer sk-xxxxx`.

### 2) El nodo comunitario no se instala / “modo cola”

- Si su n8n corre en **modo cola**La instalación GUI se puede deshabilitar; siga la documentación de instalación manual para instalar los nodos comunitarios mediante npm o cree una imagen personalizada que incluya el nodo. Reinicie n8n después de la instalación.

### 3) Nodo no encontrado en la paleta después de la instalación

- Reiniciar n8n.

- Asegúrese de haber instalado el paquete en el contexto correcto (dentro de la imagen del contenedor o en el `.n8n/custom` ruta si se utiliza ese patrón).

- Verifique los registros del contenedor para detectar errores de resolución del módulo.

### 4) Límites de tarifas o problemas de cuotas

- Consulte el panel de CometAPI para conocer el uso y la cuota.

- Implemente un retroceso exponencial y un retroceso a modelos más económicos cuando detecte advertencias de límite o HTTP 429.

## ¿Existen alternativas si el nodo comunitario no está disponible o desea más flexibilidad?

Sí, siempre puedes usar el **Solicitud HTTP** nodo directamente (control total) o un [Nodo OpenAI con URL base](https://apidoc.cometapi.com/n8n-965890m0) Redirección (atajo práctico). El uso de HTTP sin formato también facilita la adopción de nuevos puntos finales de CometAPI a medida que se lanzan (por ejemplo, puntos finales de imagen/vídeo). Consulte [Guía](https://apidoc.cometapi.com/n8n-965890m0).

**Vea también** [Cómo usar n8n con CometAPI](https://www.cometapi.com/es/how-to-use-n8n-with-cometapi/?utm_source=chatgpt.com)

## Conclusión:

CometAPI le ofrece la posibilidad de elegir modelos y simplicidad operativa; n8n le ofrece orquestación visual y extensibilidad. Utilice el truco de las credenciales de OpenAI para una rápida integración de chat/finalización, y nodos comunitarios donde existan y sean de confianza. Instrumente cada flujo de trabajo para optimizar costos, latencia y seguridad; prefiera respaldo humano para las decisiones importantes; y mantenga la selección de modelos dinámica para adaptarse a los rápidos cambios en el panorama de proveedores de IA. La combinación de n8n y CometAPI es potente, pero como todas las herramientas potentes, necesita medidas de seguridad: observar, probar e iterar.