CherryStudio, un versátil cliente de escritorio para grandes modelos de lenguaje (LLM), y CometAPI, una interfaz REST unificada para cientos de modelos de IA, permiten a los usuarios aprovechar las capacidades generativas de vanguardia con mínima fricción. Este artículo sintetiza los últimos avances, basados en la versión 1.3.12 de CherryStudio (26 de mayo de 2025) y las mejoras continuas de la plataforma CometAPI, para ofrecer una guía completa y paso a paso sobre "Cómo usar CherryStudio con CometAPI". Exploraremos... cómo funciona, contorno Mejores prácticas de evaluación comparativa del rendimientoy resalte la tecla Características que hacen de esta integración un cambio radical para los flujos de trabajo impulsados por IA.

¿Qué es CherryStudio?

CherryStudio es un cliente de escritorio multiplataforma de código abierto, diseñado para simplificar la interacción con múltiples proveedores de LLM. Ofrece una interfaz de chat unificada, compatibilidad con múltiples modelos y plugins extensibles, ideal tanto para usuarios con conocimientos técnicos como para aquellos que no los tienen.

- Soporte multiproveedorConéctese simultáneamente a OpenAI, Anthropic, Midjourney y más dentro de una única interfaz de usuario.

- Funciones de interfaz de usuario enriquecidasLa agrupación de mensajes, la selección múltiple, la exportación de citas y las integraciones con herramientas de código agilizan los flujos de trabajo complejos.

- Aspectos destacados del último lanzamiento:La versión 1.3.12 (publicada el 26 de mayo de 2025) agrega la funcionalidad “deshabilitar el servidor MCP”, un manejo mejorado de citas y una selección múltiple mejorada en los paneles de mensajes.

¿Qué es CometAPI?

CometAPI ofrece una interfaz RESTful unificada para más de 500 modelos de IA, que abarca desde chat de texto e incrustaciones hasta generación de imágenes y servicios de audio. Elimina la autenticación específica del proveedor, los límites de velocidad y las variaciones de los endpoints, lo que permite:

- Acceda a diversos modelos:Desde GPT-4O-Image para generación visual hasta Claude 4-series para razonamiento avanzado.

- Simplifique la facturación y las cuotas:Una clave API cubre múltiples backends, con paneles de uso consolidados y precios escalonados flexibles.

- Documentación robusta y SDKGuías detalladas, ejemplos de código y prácticas recomendadas de reintento automático garantizan una integración fluida.

¿Cómo se integra CherryStudio con CometAPI?

¿Cuáles son los requisitos previos?

- Instalar CherryStudio:Descargue el instalador más reciente para su sistema operativo desde el sitio oficial de CherryStudio (v1.3.12 al 26 de mayo de 2025).

- Cuenta CometAPI:Regístrese en CometAPI, luego navegue a Centro de ayuda → Token API para generar tu sk-* tecla y anote la URL base (por ejemplo,

https://api.cometapi.com). - Red y dependencias:Asegúrese de que su estación de trabajo tenga acceso a Internet y que todos los servidores proxy corporativos permitan el acceso HTTPS saliente a los puntos finales de CometAPI.

¿Cómo se configura la API en CherryStudio?

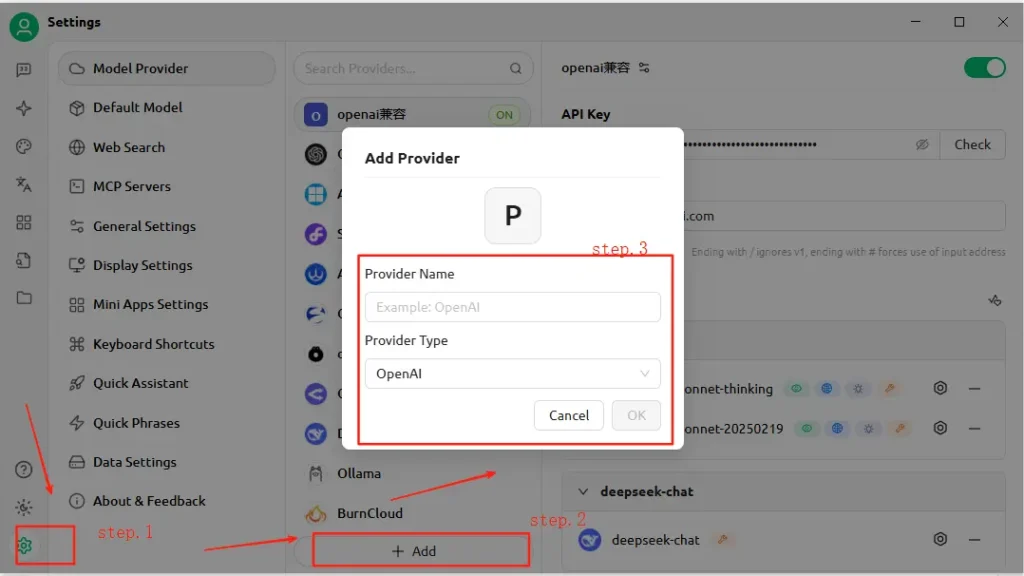

- Abra CherryStudio y haga clic en el icono Configuración .

- En Configuración del servicio de modelos, haga clic en Agregar.

- Nombre del Proveedor:Ingrese una etiqueta personalizada, por ejemplo, “CometAPI”.

- Tipo de Proveedor: Seleccione Compatible con OpenAI (la mayoría de los puntos finales de CometAPI reflejan las especificaciones de OpenAI).

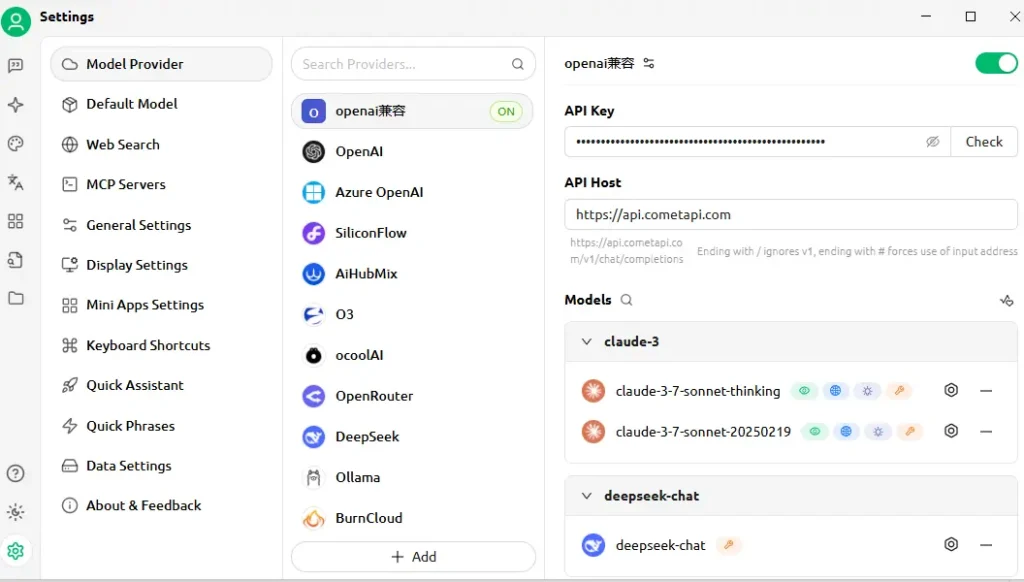

- Dirección API: Pegue la URL base de CometAPI (por ejemplo,

https://api.cometapi.com). - API Key: Pegar el

sk-…token desde su panel de CometAPI. - Haga clic en Guardar y Verificar—CherryStudio realizará una llamada de prueba para confirmar la conectividad.

¿Cómo se prueba la conexión?

- Ingrese un mensaje simple en CherryStudio, como "Describe el horizonte de una ciudad futurista".

- Una respuesta exitosa confirma la configuración correcta.

- En caso de error, CherryStudio muestra códigos de error: consulte CometAPI Descripción del código de error sección o contacte con el soporte técnico.

¿Cómo funciona la integración bajo el capó?

CherryStudio's Compatible con OpenAI El modo permite enrutar solicitudes a través de cualquier servicio que siga el esquema estándar de la API de OpenAI. CometAPI, a su vez, traduce estas solicitudes al modelo de backend seleccionado (p. ej., GPT-4O-Image, Claude 4) antes de devolver las respuestas en el formato esperado.

- Entrada del usuario:CherryStudio envía un

POST /v1/chat/completionsllamar ahttps://api.cometapi.com/v1. - Procesamiento de CometAPI: Identifica el parámetro del modelo (por ejemplo,

"model": "gpt-4o-image") y rutas al proveedor correspondiente. - Invocación de backendCometAPI maneja la autenticación, las verificaciones de límites de velocidad y el registro de telemetría y luego llama a la API del modelo de terceros.

- Agregación de respuestas:CometAPI transmite o almacena en búfer la salida del modelo (texto, imágenes, incrustaciones) y la formatea según las convenciones de OpenAI.

- Renderizado de CherryStudio:Recibe la carga JSON y muestra el contenido: el texto aparece en el chat, las imágenes se representan en línea y los bloques de código adoptan el resaltado de sintaxis.

Esta arquitectura separa las responsabilidades: CherryStudio se centra en la UI/UX y las herramientas, mientras que CometAPI gestiona la orquestación del modelo, el registro y la facturación independiente del proveedor.

¿Qué parámetros de rendimiento puede esperar?

Latencia y rendimiento

En pruebas comparativas, la arquitectura sin servidor de CometAPI ha demostrado tiempos de respuesta medios inferiores a 100 ms para tareas de finalización de texto en GPT-4.5, superando a las API de proveedores directos en hasta un 30 % en escenarios de alta carga. El rendimiento escala linealmente con la concurrencia: los usuarios han ejecutado con éxito más de 1,000 transmisiones de chat paralelas sin una degradación significativa.

Costo y Eficiencia

Al agrupar múltiples proveedores y negociar tarifas por volumen, CometAPI ofrece un ahorro promedio de entre el 15 % y el 20 % en comparación con el consumo directo de API. Los indicadores de referencia sobre cargas de trabajo representativas (p. ej., resumen, generación de código, IA conversacional) indican un coste por 1 tokens competitivo entre los principales proveedores, lo que permite a las empresas prever presupuestos con mayor precisión.

Confiabilidad y tiempo de actividad

- Compromiso de SLA:CometAPI garantiza un tiempo de actividad del 99.9 %, respaldado por redundancia multirregional.

- Mecanismos de conmutación por error:En caso de interrupciones del proveedor ascendente (por ejemplo, ventanas de mantenimiento de OpenAI), CometAPI puede redirigir llamadas de manera transparente a modelos alternativos, lo que garantiza la disponibilidad continua para aplicaciones críticas.

El rendimiento variará según el modelo elegido, las condiciones de la red y el hardware, pero una configuración de referencia típica podría verse así:

| Punto final | Latencia media (primer token) | Rendimiento (tokens/seg) |

|---|---|---|

/chat/completions (texto) | ~120 ms | ~500 tok/s |

/images/generations | ~800 ms | n/a |

/embeddings | ~80 ms | ~2 000 tok/s |

Nota: Las cifras anteriores son ilustrativas; los resultados en el mundo real dependen de su región, red y plan CometAPI.

¿Cómo se debe realizar una evaluación comparativa?

- Medio Ambiente:Utilice una red estable (por ejemplo, LAN corporativa), registre su IP de salida pública y su geografía.

- Modelado: Emplear

curlo Postman para pruebas de latencia sin procesar y scripts de Python conasynciopara la medición del rendimiento. - Métrica: Pista tiempo hasta el primer byte, tiempo total de respuesta e tokens por segundo.

- RepeticiónEjecute cada prueba al menos 30 veces, descarte los valores atípicos más allá de 2σ y calcule los valores medianos/percentil 95 para obtener información sólida.

Siguiendo esta metodología, puede comparar diferentes modelos (por ejemplo, GPT-4O vs. Claude Sonnet 4) y elegir el óptimo para su caso de uso.

¿Qué características clave desbloquea esta integración?

1. Generación de contenido multimodal

- Chat de texto y código:Aproveche GPT-4O y Claude Sonnet 4 para conversación, resumen y asistencia con el código.

- Síntesis de imagen: Invocar

gpt-4o-imageo puntos finales estilo Midjourney directamente dentro del lienzo de CherryStudio. - Audio & Video:Los futuros puntos finales de CometAPI incluyen síntesis de voz y generación de video, accesibles con la misma configuración de CherryStudio.

2. Cambio de proveedor simplificado

Alterne entre CometAPI y puntos finales nativos de OpenAI o Anthropic con un solo clic, lo que permite realizar pruebas A/B en todos los modelos sin reconfigurar las claves API.

3. Monitoreo de errores y uso integrado

CherryStudio muestra los paneles de uso y registros de errores de CometAPI, lo que le ayuda a mantenerse dentro de la cuota y diagnosticar fallas (por ejemplo, límites de velocidad, modelos no válidos).

4. Ecosistema de complementos extensible

- Exportación de citas:Incluir automáticamente atribuciones de fuentes en los flujos de trabajo de investigación.

- Herramientas de código:Genere, formatee y analice fragmentos de código en línea utilizando los modelos centrados en código de CometAPI.

- Macros personalizadas:Registre secuencias de indicaciones repetitivas como macros, que puedan compartirse entre los miembros del equipo.

5. Lógica de reintento avanzada y gestión de límites de velocidad

El SDK de CometAPI implementa retroceso y fluctuación exponencial, lo que protege contra errores transitorios. CherryStudio muestra estas mecánicas en sus registros y proporciona controles de reintento en la interfaz de usuario.

Acceso unificado al modelo

- Intercambio de modelos con un solo clic:Cambie sin problemas entre GPT-4.5, Claude 2 y Stable Diffusion sin tener que reconfigurar los puntos finales.

- Canalizaciones de modelos personalizados:Llamadas en cadena (como resumen → análisis de sentimientos → generación de imágenes) en un único flujo de trabajo, orquestado por el motor de macros de Cherry Studio.

Cómo empezar hoy

- Actualizar CherryStudio a v1.3.12 o posterior.

- Matricularse en CometAPI, recupera tu clave API y anota tu URL base.

- Configurar CometAPI en CherryStudio como proveedor compatible con OpenAI.

- Ejecutar un mensaje de muestra para verificar la conectividad.

- Explorar modelos:Pruebe texto, imagen, incrustación y puntos finales de audio sin salir de CherryStudio.Seleccione su modelo preferido (por ejemplo,

gemini-2.5-flash-preview-05-20).

Para obtener ejemplos de código detallados, mejores prácticas de manejo de errores y consejos avanzados (por ejemplo, ajuste de la lógica de reintento), consulte CometAPI. Guía de integración de software .

Conclusión

Al combinar la interfaz intuitiva de CherryStudio con el extenso catálogo de modelos y la API unificada de CometAPI, los desarrolladores y creadores pueden prototipar, iterar y escalar rápidamente aplicaciones basadas en IA. Ya sea que esté desarrollando agentes conversacionales, generando elementos visuales o integrando búsqueda semántica, esta integración ofrece una base sólida, eficiente y extensible. ¡Empiece a experimentar hoy mismo y manténgase al tanto de las próximas mejoras, como la generación de video en la aplicación y los modelos de dominio especializados!