Google anunció Gemini 3 Flash el 17–18 de diciembre de 2025 como un miembro de baja latencia y costo eficiente de la familia Gemini 3. Lleva razonamiento de nivel Pro a un perfil de clase Flash, admite entradas multimodales extensas (texto, imagen, audio, vídeo), introduce controles de thinking_level y media resolution, y está disponible a través de Google AI Studio, la API de Gemini (REST / SDKs), Vertex AI, Gemini CLI, y como el modelo predeterminado en Búsqueda de Google / la app Gemini.

¿Qué es Gemini 3 Flash y por qué es importante?

Gemini 3 Flash forma parte de los modelos de la serie 3 de Google. Fue diseñado para empujar la frontera de Pareto entre calidad, costo y latencia: ofrecer gran parte de la capacidad de razonamiento de Gemini 3 Pro siendo significativamente más rápido y más barato de ejecutar. Esa combinación lo hace muy adecuado para escenarios interactivos de alta frecuencia (chatbots, asistentes en IDE, flujos agénticos en tiempo real), generación de contenido en lote donde la latencia importa, y aplicaciones que necesitan razonamiento multimodal (imágenes + texto + audio) con bajo overhead.

Puntos clave de alto nivel:

- Está explícitamente optimizado para velocidad + bajo costo manteniendo un sólido razonamiento y fidelidad multimodal (Tres veces más rápido que el antiguo Gemini 2.5 Pro; Conserva las capacidades de inferencia de primer nivel de Gemini 3.).

- Se posiciona como el “punto óptimo” para bucles agénticos y flujos iterativos de desarrolladores (p. ej., asistencia de código, agentes multi-turno).

- Flexible: Puede "ajustar su tiempo de pensamiento" según la complejidad del problema: responde preguntas simples al instante y considera más pasos para tareas complejas.

Rendimiento técnico y resultados de benchmarks

Gemini 3 Flash logra un triple avance en velocidad, inteligencia y costo:

1) Bucles agénticos y comprensión multimodal

Gemini 3 Flash hereda mejoras arquitectónicas y de entrenamiento de la familia Gemini 3 en general, logrando una fuerte competencia multimodal (entradas de texto, imagen, vídeo, audio) y un razonamiento mejorado en comparación con modelos Flash anteriores. Google posiciona a Flash como capaz de manejar tareas como análisis de documentos (OCR + razonamiento), resumen de vídeo, preguntas y respuestas imagen + texto, y tareas de programación multimodal. Esta capacidad multimodal, combinada con baja latencia, es uno de los argumentos técnicos definitorios del modelo.

Google publicó afirmaciones de benchmarks internos que destacan un fuerte desempeño agéntico en codificación (SWE-bench Verified ~78% para flujos de trabajo de codificación agéntica) y que Flash se acerca al razonamiento de nivel Pro en muchas tareas mientras sigue siendo lo suficientemente rápido para bucles agénticos y flujos casi en tiempo real.

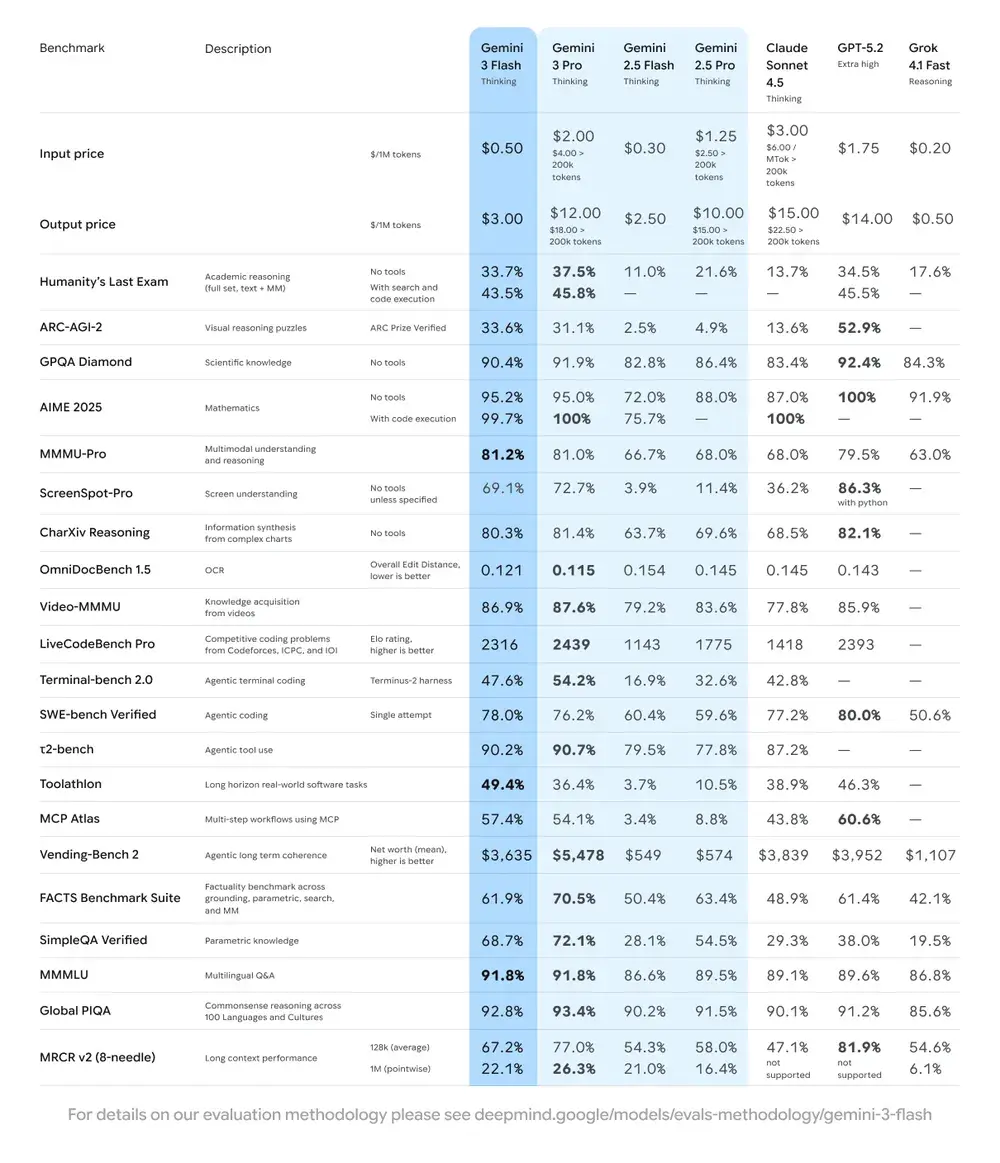

| Benchmark | Puntuación de Gemini 3 Flash | Modelo de comparación | Mejora |

|---|---|---|---|

| GPQA Diamond (razonamiento a nivel de doctorado) | 90.4% | Supera a Gemini 2.5 Pro | Significativa |

| Humanity’s Last Exam (prueba de conocimientos generales) | 33.7% (sin herramientas) | Cercano a Gemini 3 Pro | Razonamiento avanzado |

| MMMU Pro (comprensión multimodal) | 81.2% | A la par de Gemini 3 Pro | — |

| SWE-bench Verified (benchmark de capacidad de programación) | 78% | Superior a Gemini 3 Pro y la serie 2.5 | Excelente |

2) Coste y eficiencia

La filosofía de desarrollo de Gemini 3 Flash es la "Frontera de Pareto": es decir, encontrar el equilibrio óptimo entre velocidad, calidad y costo. Gemini 3 Flash está explícitamente optimizado para la relación precio-rendimiento. Google lista los precios de Flash significativamente por debajo de Pro para tareas comparables, y lo posiciona para procesar grandes volúmenes de solicitudes a menor costo operativo. Para muchas cargas de trabajo, la variante Flash pretende ser el valor por defecto más eficiente en costo — por ejemplo, el precio de la vista previa de Flash es de aproximadamente $0.50 por 1M tokens de entrada y $3.00 por 1M tokens de salida para el nivel de vista previa de Flash. En la práctica, esto lo hace viable para tareas de alta frecuencia donde el mayor costo por token de Pro sería prohibitivo.

Indicadores de eficiencia

- Velocidad: 3x más rápido que Gemini 2.5 Pro (según pruebas de Artificial Analysis).

- Eficiencia de tokens: usa en promedio un 30% menos de tokens para completar la misma tarea. En otras palabras, obtienes resultados más rápidos y mejores por el mismo dinero.

- Gemini 3 Flash incorpora un "Modo de pensamiento dinámico": adapta la profundidad de razonamiento a la complejidad de la tarea, "pensando un poco más" cuando es necesario y respondiendo rápido en tareas simples.

Implicaciones prácticas: Un menor costo por token o por llamada significa que puedes ejecutar más consultas, contextos más largos o mayores tasas de muestreo con el mismo presupuesto. Las ganancias de eficiencia también pueden reducir la complejidad de la infraestructura (se necesitan menos instancias calientes) y mejorar las garantías de tiempo de respuesta.

3) Benchmark de rendimiento

Gemini 3 Flash alcanza un rendimiento “de vanguardia” en varios benchmarks académicos y de aplicación mientras ofrece mejor latencia y costo que modelos Pro anteriores. Google presenta cifras como altas puntuaciones en benchmarks de razonamiento y conocimiento complejos (p. ej., variantes de GPQA) para ilustrar su competencia.

¿Cómo uso la API de Gemini 3 Flash?

¿Qué método de acceso debo usar?

- Recomendado (simple + robusto): Usa el patrón de integración de SDK que muestra Comet — simplemente apunta un SDK GenAI existente a la URL base de Comet y suministra tu clave de API de Comet. Esto evita que tengas que replicar tú mismo el análisis de solicitudes/stream.

- Alternativo (HTTP crudo / curl / stacks personalizadas): Puedes hacer POST directamente a los endpoints de CometAPI (Comet acepta formatos estilo OpenAI o específicos del proveedor). Usa

Authorization: Bearer <sk-...>(los ejemplos de Comet usan un encabezado Bearer) y la cadena de modelogemini-3-flashen el cuerpo. Confirma la ruta exacta y los parámetros de consulta en la documentación de la API de Comet para el modelo que quieras.

Resumen rápido — lo que harás

- Regístrate en CometAPI y crea un token de API.

- Elige un método de acceso (recomendado: patrón de wrapper de SDK mostrado abajo; alternativa: HTTP/cURL crudo).

- Llama al modelo

gemini-3-flasha través de la URL base de CometAPI (Comet enruta tu solicitud al backend Gemini de Google). - Gestiona streaming / function-calls / entradas multimodales según los requisitos del modelo (detalles abajo).

A continuación hay un ejemplo compacto (basado en los patrones de muestra de CometAPI) que muestra cómo llamar a gemini-3-flash vía CometAPI; sustituye <YOUR_COMETAPI_KEY> por tu clave real. El ID de modelo y los endpoints a continuación coinciden con la documentación de CometAPI.

from google import genaiimport os# Get your CometAPI key from https://api.cometapi.com/console/token, and paste it hereCOMETAPI_KEY = os.environ.get("COMETAPI_KEY") or "<YOUR_COMETAPI_KEY>"BASE_URL = "https://api.cometapi.com"client = genai.Client( http_options={"api_version": "v1beta", "base_url": BASE_URL}, api_key=COMETAPI_KEY,)response = client.models.generate_content( model="gemini-3-flash", contents="Explain how AI works in a few words",)print(response.text)

Parámetros clave de la solicitud a considerar

thinking_level— controla la profundidad de razonamiento interna:MINIMAL,LOW,MEDIUM,HIGH. UsaMINIMALpara la menor latencia y costo cuando no necesitas razonamiento profundo de varios pasos.media_resolution— para entradas de visión/vídeo:low,medium,high,ultra_high. Una resolución menor reduce la equivalencia de tokens y la latencia.streamGenerateContentvsgenerateContent— usa streaming para una mejor latencia percibida cuando quieras respuestas parciales a medida que llegan.- Llamadas a funciones / Modo JSON — usa respuestas estructuradas cuando necesites salidas analizables por máquina.

Envío de entradas multimodales (consejos prácticos)

- Imágenes/PDF: prefiere URIs de Cloud Storage (gs://) para medios grandes; muchas APIs aceptan base64 para imágenes pequeñas. Vigila la contabilidad de tokens por modalidad — los PDFs pueden contarse bajo cuotas de imagen/documento según el endpoint.

- Vídeo/audio: para clips cortos puedes pasar URIs; para medios largos usa flujos de procesamiento por lotes o transmite en fragmentos. Revisa los tamaños máximos de entrada y las restricciones de codificación en la documentación de la API.

- Llamadas a funciones / herramientas: usa esquemas de funciones estructurados para obtener salidas JSON y habilitar invocación segura de herramientas. Gemini 3 Flash admite llamadas a funciones en streaming para mejorar la UX.

¿Dónde puedo acceder a Gemini 3 Flash?

Gemini 3 Flash está disponible en las superficies de consumidor y desarrollador de Google:

- Búsqueda de Google y la app Gemini — Flash se ha implementado como el modelo predeterminado para el Modo IA en Search y está integrado en la experiencia de la app Gemini para usuarios finales.

- Google AI Studio — lugar inmediato para que los desarrolladores experimenten y generen claves de API para pruebas.

- Gemini API (Generative Language / AI Developer API) — disponible como

gemini-3-flash-preview(ID de modelo usado en la documentación/notas de lanzamiento) y a través de los endpoints estándar generateContent / streamGenerateContent. - Vertex AI (Google Cloud) — acceso de grado torsión de producción a través de las APIs de modelos de IA generativa de Vertex AI y precios/cuotas adecuados para cargas de trabajo empresariales.

- Gemini CLI — para desarrollo en terminal y flujos de scripting.

Pasarela de terceros CometAPI

CometAPI ya ha añadido gemini-3-flash a su catálogo, y su página del modelo explica cómo llamarlo a sopena a través del endpoint unificado de CometAPI. El API del modelo proporcionado tiene un precio del 20% del precio oficial.

¿Cuáles son las mejores prácticas al usar Gemini 3 Flash?

1) Elige thinking_level por tarea y ajústalo

- Establece

MINIMAL/LOWpara preguntas y respuestas simples y tareas interactivas de alta frecuencia. - Usa

MEDIUM/HIGHde forma selectiva para tareas que requieren cadenas de pensamiento más profundas o planificación de varios pasos. - Evalúa costo vs. calidad cuando cambies

thinking_level. La documentación de Google advierte quethinking_levelcambia las firmas de pensamiento internas y la latencia.

2) Usa media_resolution para controlar el cómputo de visión

Si pasas imágenes o vídeo, elige la media_resolution más baja aceptable para la tarea; por ejemplo, usa low para miniaturas y extracción masiva, high para crítica de diseño visual. Esto reduce la equivalencia de tokens para imágenes y disminuye la latencia.

3) Prefiere salidas estructuradas para automatización

Usa Modo JSON / llamadas a funciones cuando tu aplicación necesite salidas analizables por máquina (p. ej., extracción de entidades, invocación de herramientas). Esto simplifica drásticamente el procesamiento posterior. Impón esquemas JSON estrictos donde sea posible y valida en el cliente.

4) Usa ampliamente el streaming para respuestas largas

streamGenerateContent reduce la latencia percibida y permite renderizado progresivo de la UI. Para tareas multimodales largas, transmite salidas parciales para que los usuarios vean progreso inmediato.

5) Controla los costes con caché y gestión de contexto

- Usa caché de contexto para referencias repetidas (precios y tokens difieren entre modelos).

- Evita enviar contexto largo innecesario si no es requerido — prefiere prompts concisos y usa recuperación + grounding para grandes bases de conocimiento.

Escenarios típicos de uso de Gemini 3 Flash

Agentes conversacionales de alto volumen

Flash enc pipeline natural para chatbots y asistentes de soporte al cliente que necesitan baja latencia y bajo costo por inferencia. Con soporte de streaming y alta tasa de tokens/seg, Flash reduce los tiempos de espera percibidos y los costos operativos.

Asistentes multimodales y pipelines de documentos

Dado que Flash maneja bien imágenes, PDFs y vídeos cortos, aplicaciones comunes incluyen extracción de facturas, preguntas y respuestas multimodales sobre manuales, soporte al cliente con imágenes e ingestión de PDF para bases de conocimiento.

Análisis y moderación de vídeo en tiempo real

La alta velocidad de salida reportada (≈218 t/s en pruebas previas al lanzamiento) permite análisis y resumen casi en tiempo real de vídeos cortos, detección de momentos destacados y pipelines de moderación de contenido en vivo cuando se diseñan correctamente.

Herramientas agénticas para desarrolladores y asistencia de código

Las puntuaciones en SWE-bench y el rendimiento de codificación reportado hacen de Flash una buena opción para asistentes de código rápidos, ayudantes de CLI y otros flujos de trabajo de desarrolladores que priorizan baja latencia.

Conclusión — ¿deberías adoptar Gemini 3 Flash ahora?

Gemini 3 Flash es una oferta estratégica para equipos que necesitan razonamiento sólido e inteligencia multimodal sin la latencia y el costo de los modelos Pro de gama alta. El modelo es especialmente adecuado para asistentes agénticos de codificación, agentes multimodales interactivos, pipelines de procesamiento de documentos y cualquier sistema donde la baja latencia y la escala sean preocupaciones primarias. Los primeros benchmarks (tanto de Google como de análisis independientes) indican que Flash es competitivo en calidad al tiempo que ofrece ventajas sustanciales de rendimiento y costo.

Para empezar, explora las capacidades de Gemini 3 Flash en el Playground y consulta la Guía de la API para instrucciones detalladas. Antes de acceder, asegúrate de haber iniciado sesión en CometAPI y haber obtenido la clave de API. CometAPI ofrece un precio muy inferior al oficial para ayudarte a integrar.

¿Listo para empezar?→ Prueba gratuita de Gemini 3 Flash !