La API de video de MidJourney permite a los desarrolladores generar, manipular y recuperar programáticamente contenido de video generado por IA utilizando los modelos y las indicaciones de MidJourney.

Descripción general

Midjourney Video es el primer modelo de generación de video (Video Model V1) lanzado por Midjourney el 18 de junio de 2025. Introduce un flujo de trabajo de "Imagen a Video" que transforma imágenes estáticas generadas por IA o subidas por el usuario en clips animados cortos. Esto marca la expansión de Midjourney de la creación de imágenes fijas a contenido dinámico, lo que la posiciona junto a otras herramientas de video con IA de Google, OpenAI y Meta.

Cómo funciona MidJourney Video

- Flujo de trabajo de imagen a vídeo: Se proporciona una imagen generada por Midjourney o una imagen externa, además de una indicación de movimiento opcional. El modelo de Midjourney interpreta quién se mueve, cómo se mueve y qué sucede después para animar la escena durante unos 5 segundos por defecto.

- Animación automática vs. manualEn el modo automático, el sistema infiere los parámetros de movimiento y las trayectorias de la cámara. El modo manual permite ajustar con precisión aspectos como el ángulo de la cámara, la trayectoria del sujeto y la velocidad, lo que proporciona un mayor control creativo.

Arquitectura técnica

Midjourney Video se basa en un arquitectura del transformador mejorado para manejar consistencia temporal Entre marcos. El flujo de trabajo funciona de la siguiente manera:

- Extracción de características:La imagen de entrada se procesa a través de capas convolucionales y transformadoras profundas para capturar características espaciales.

- Generación de fotogramas clave:Se sintetiza un pequeño conjunto de cuadros representativos.

- Interpolación de cuadros:Los submodelos especializados generan cuadros intermedios, lo que garantiza una fluidez síntesis de movimiento entre fotogramas clave.

- Acondicionamiento del movimiento: Dependiendo de Alta or Movimiento bajo Configuración (y cualquier indicación manual), el modelo ajusta las trayectorias de los objetos y de la cámara.

Versiones del modelo y hoja de ruta

Modelo de vídeo V1 (junio de 2025):Lanzamiento debut centrado en la conversión de imagen a vídeo.

Rendimiento de referencia

Las primeras evaluaciones posicionan al modelo V1 competitivamente:

- Calidad del marco (puntuación FID):Logra una distancia de inicio de Fréchet de 22.4, superando a los modelos de video de código abierto comparables en aproximadamente un 15 % en los puntos de referencia de video estándar.

- Suavidad temporal (métrica TS):Registra una puntuación de suavidad temporal de 0.88 en el conjunto de datos DAVIS, lo que indica una alta continuidad visual entre fotogramas.

- Estado latente:Tiempo medio de generación de 12 segundos por clip en una sola GPU NVIDIA A100, equilibrando el rendimiento con las expectativas del usuario.

- Métricas de calidad:Logra un SSIM (Índice de similitud estructural) arriba 0.85 en conjuntos de datos de movimiento sintético en comparación con clips de verdad fundamental, lo que indica alta fidelidad a patrones de movimiento naturales.

Nota: :Estas cifras reflejan las pruebas internas de Midjourney; el rendimiento externo puede variar según la carga y el nivel de suscripción.

Características principales de V1

- Longitud del clipLos clips base duran aproximadamente 5 segundos; se pueden ampliar en incrementos de 4 segundos hasta un total de 21 segundos.

- Coherencia de estilo:Las animaciones conservan el estilo artístico de la imagen original: las pinceladas, las paletas de colores y el estado de ánimo se mantienen a través del movimiento.

- Rendimiento y velocidad:Un video típico de 4 segmentos (aproximadamente 17 segundos) se procesa en menos de 70 segundos, lo que equilibra la calidad con una iteración rápida.

- Resolución:Actualmente limitado a 480p, lo cual es adecuado para clips estilo redes sociales, pero no está destinado a proyectos comerciales de pantalla grande o de alto nivel.

Cómo llamar a la API de video de MidJourney desde CometAPI

MidJourney Video Precios de la API en CometAPI, inferiores al precio oficial:

| Nombre de Modelo | Calcular precio |

mj_fast_video | 0.6 |

Pasos requeridos

- Inicia sesión en cometapi.comSi aún no eres nuestro usuario, por favor regístrate primero.

- Obtenga la clave API de credenciales de acceso de la interfaz. Haga clic en "Agregar token" en el token API del centro personal, obtenga la clave del token: sk-xxxxx y envíe.

- Obtenga la URL de este sitio: https://api.cometapi.com/

Uso de API

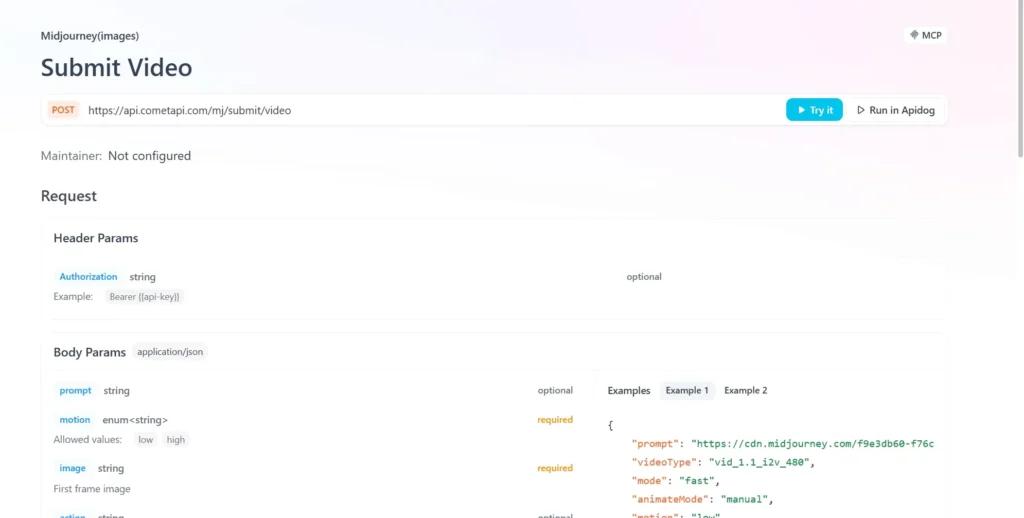

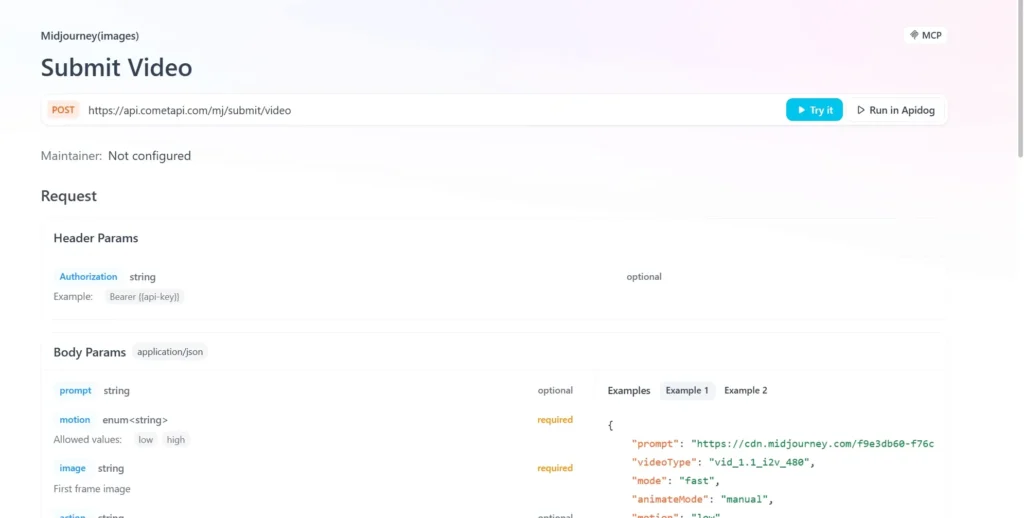

- Envíe la solicitud de API y configure el cuerpo de la solicitud. El método y el cuerpo de la solicitud se obtienen de la documentación de la API de nuestro sitio web. Nuestro sitio web también ofrece la prueba de Apifox para su comodidad.

- Reemplazar con su clave CometAPI real de su cuenta.

- Inserte su pregunta o solicitud en el campo de contenido: esto es lo que responderá el modelo.

- . Procesa la respuesta de la API para obtener la respuesta generada.

Integración API de CometAPI

Actualmente, V1 está accesible solo web a través de Midjourney Bot de discordia, es Envoltorios no oficiales (por ejemplo, CometAPI) proporcionan puntos finales que los desarrolladores pueden integrar mediante:

Los desarrolladores pueden integrar la generación de vídeo mediante la API RESTful. Estructura de solicitud típica (ejemplo):

curl --

location

--request POST 'https://api.cometapi.com/mj/submit/video' \

--header 'Authorization: Bearer {{api-key}}' \

--header 'Content-Type: application/json' \

--data-raw '{ "prompt": "https://cdn.midjourney.com/f9e3db60-f76c-48ca-a4e1-ce6545d9355d/0_0.png add a dog", "videoType": "vid_1.1_i2v_480", "mode": "fast", "animateMode": "manual" }'

Vea también ¿Cómo utilizar el modelo de vídeo V1 de Midjourney?