Gemini 3 Pro (Preview) es el modelo insignia multimodal de razonamiento más reciente de Google/DeepMind en la familia Gemini 3. Se presenta como su “modelo más inteligente hasta ahora”, diseñado para razonamiento profundo, flujos con agentes, programación avanzada y comprensión multimodal de contexto largo (texto, imágenes, audio, video, código e integraciones de herramientas).

Características clave

- Modalidades: Texto, imagen, video, audio, PDFs (y salidas estructuradas de herramientas).

- Agéntico/herramientas: Llamadas a funciones integradas, búsqueda como herramienta, ejecución de código, contexto de URL y soporte para orquestar agentes de múltiples pasos. El mecanismo de firma de pensamiento preserva el razonamiento multipaso entre llamadas.

- Programación y “vibe coding”: Optimizado para generación de front-end, generación de IU interactiva y programación con agentes (encabeza los rankings relevantes reportados por Google). Se promociona como su modelo de “vibe coding” más sólido hasta la fecha.

- Nuevos controles para desarrolladores:

thinking_level(low|high) para equilibrar costo/latencia frente a profundidad de razonamiento, ymedia_resolutioncontrola la fidelidad multimodal por imagen o fotograma de video. Esto ayuda a equilibrar rendimiento, latencia y costo.

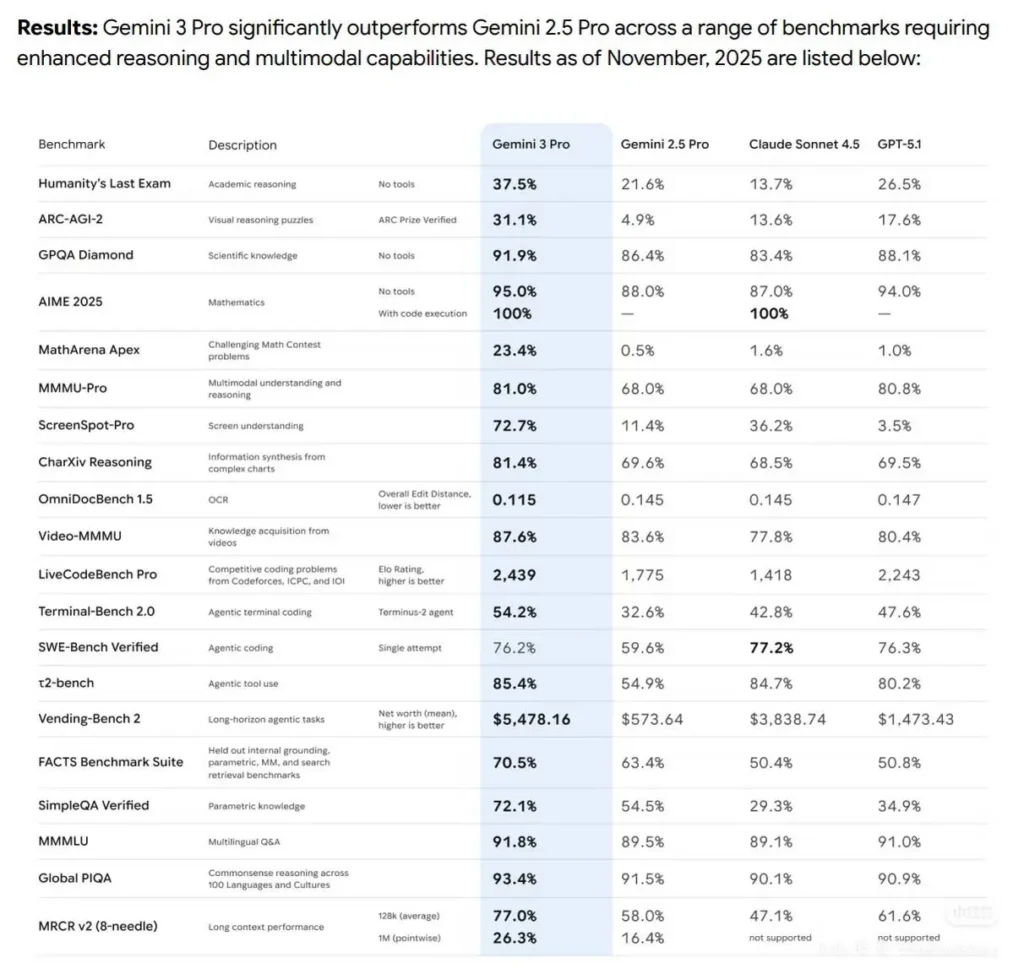

Rendimiento en benchmarks

- El Gemini3Pro logró el primer lugar en LMARE con una puntuación de 1501, superando los 1484 puntos de Grok-4.1-thinking y también liderando a Claude Sonnet 4.5 y Opus 4.1.

- También consiguió el primer puesto en el área de programación WebDevArena con una puntuación de 1487.

- En Humanity’s Last Exam de razonamiento académico, alcanzó 37.5% (sin herramientas); en GPQA Diamond de ciencia, 91.9%; y en la competencia de matemáticas MathArena Apex, 23.4%, estableciendo un nuevo récord.

- En capacidades multimodales, el MMMU-Pro logró 81%; y en Video-MMMU de comprensión de video, 87.6%.

Detalles técnicos y arquitectura

- Parámetro “thinking level”: Gemini 3 expone un control

thinking_levelque permite a los desarrolladores equilibrar la profundidad del razonamiento interno frente a la latencia/costo. El modelo tratathinking_levelcomo una concesión relativa para el razonamiento multipaso interno en lugar de una garantía estricta de tokens. El valor predeterminado suele serhighpara Pro. Este es un nuevo control explícito para que los desarrolladores ajusten la planificación multipaso y la profundidad de la cadena de pensamiento. - Salidas estructuradas y herramientas: El modelo admite salidas JSON estructuradas y puede combinarse con herramientas integradas (fundamentación con Google Search, contexto de URL, ejecución de código, etc.). Algunas funciones de salidas estructuradas + herramientas están solo en vista previa para

gemini-3-pro-preview. - Integraciones multimodales y con agentes: Gemini 3 Pro está construido explícitamente para flujos con agentes (herramientas + múltiples agentes sobre código/terminales/navegador).

Limitaciones y advertencias conocidas

- Factualidad no perfecta: siguen siendo posibles alucinaciones. A pesar de las mejoras de factualidad que Google afirma, la verificación fundamentada y la revisión humana siguen siendo necesarias en entornos de alto riesgo (legal, médico, financiero).

- Rendimiento en contexto largo variable según la tarea. La compatibilidad con una ventana de entrada de 1M es una capacidad firme, pero la efectividad empírica puede disminuir en algunos benchmarks a longitudes extremas (se observan descensos puntuales a 1M en algunas pruebas de contexto largo).

- Compromisos de costo y latencia. Contextos grandes y configuraciones de

thinking_levelmás altas aumentan el cómputo, la latencia y el costo; se aplican niveles de precios según volúmenes de tokens. Usethinking_levely estrategias de fragmentación para gestionar costos. - Seguridad y filtros de contenido. Google continúa aplicando políticas de seguridad y capas de moderación; ciertos contenidos y acciones siguen restringidos o activarán modos de rechazo.

Cómo Gemini 3 Pro Preview se compara con otros modelos líderes

Comparación de alto nivel (preview → cualitativa):

Frente a Gemini 2.5 Pro: Mejoras significativas en razonamiento, uso agéntico de herramientas e integración multimodal; manejo de contextos mucho más grandes y mejor comprensión de textos largos. DeepMind muestra avances consistentes en razonamiento académico, programación y tareas multimodales.

Frente a GPT-5.1 y Claude Sonnet 4.5 (según lo reportado): En el conjunto de referencias de Google/DeepMind, Gemini 3 Pro se presenta como líder en varias métricas agénticas, multimodales y de contexto largo (ver Terminal-Bench, MMMU-Pro, AIME). Los resultados comparativos varían según la tarea.

Casos de uso típicos y de alto valor

- Resumen y Q&A de documentos/libros extensos: el soporte de contexto largo lo hace atractivo para equipos legales, de investigación y cumplimiento.

- Comprensión y generación de código a escala de repositorio: la integración con cadenas de herramientas de programación y el razonamiento mejorado ayuda en refactorizaciones de grandes bases de código y flujos de revisión de código automatizados.

- Asistentes de producto multimodales: flujos de imagen + texto + audio (soporte al cliente que ingiere capturas de pantalla, fragmentos de llamadas y documentos).

- Generación y edición de medios (foto → video): las funciones anteriores de la familia Gemini ahora incluyen capacidades de foto→video estilo Veo / Flow-style; la vista previa sugiere una generación multimedia más profunda para prototipos y flujos de trabajo de medios.