Qué es la API de GPT-5.2

La API de GPT-5.2 es la misma que GPT-5.2 Thinking en ChatGPT. GPT-5.2 Thinking es la variante de nivel medio de la familia GPT-5.2 de OpenAI diseñada para trabajo más profundo: razonamiento de múltiples pasos, resumen de documentos largos, generación de código de calidad y trabajo profesional de conocimiento donde la precisión y la estructura utilizable importan más que el rendimiento bruto. En la API se expone como el modelo gpt-5.2 (Responses API / Chat Completions), y se sitúa entre la variante de baja latencia Instant y la variante Pro de mayor calidad pero más costosa.

Características principales

- Contexto muy largo y compactación: ventana efectiva de 400K y herramientas de compactación para gestionar la relevancia en conversaciones y documentos extensos.

- Esfuerzo de razonamiento configurable:

none | medium | high | xhigh(xhigh habilita el máximo cómputo interno para razonamientos difíciles).xhighestá disponible en las variantes Thinking/Pro. - Soporte más sólido de herramientas y funciones: llamadas a herramientas de primera clase, gramáticas (CFG/Lark) para restringir salidas estructuradas, y comportamientos de agente mejorados que simplifican automatizaciones complejas de múltiples pasos.

- Comprensión multimodal: comprensión más rica de imagen + texto e integración en tareas de múltiples pasos.

- Seguridad mejorada / manejo de contenido sensible: intervenciones específicas para reducir respuestas indeseables en áreas como autolesiones y otros contextos sensibles.

Capacidades técnicas & especificaciones (vista para desarrolladores)

- Puntos finales de API e IDs de modelo:

gpt-5.2para Thinking (Responses API),gpt-5.2-chat-latestpara flujos de chat/instant, ygpt-5.2-propara el nivel Pro; disponibles vía Responses API y Chat Completions donde se indique. - Tokens de razonamiento y gestión del esfuerzo: la API admite parámetros explícitos para asignar cómputo (esfuerzo de razonamiento) por solicitud; mayor esfuerzo incrementa la latencia y el costo pero mejora la calidad de salida en tareas complejas.

- Herramientas de salida estructurada: compatibilidad con gramáticas (Lark / CFG) para restringir la salida del modelo a un DSL o sintaxis exacta (útil para SQL, JSON, generación de DSL).

- Llamadas de herramientas en paralelo y coordinación de agentes: mayor paralelismo y orquestación de herramientas más limpia reducen la necesidad de prompts de sistema elaborados y andamiaje multiagente.

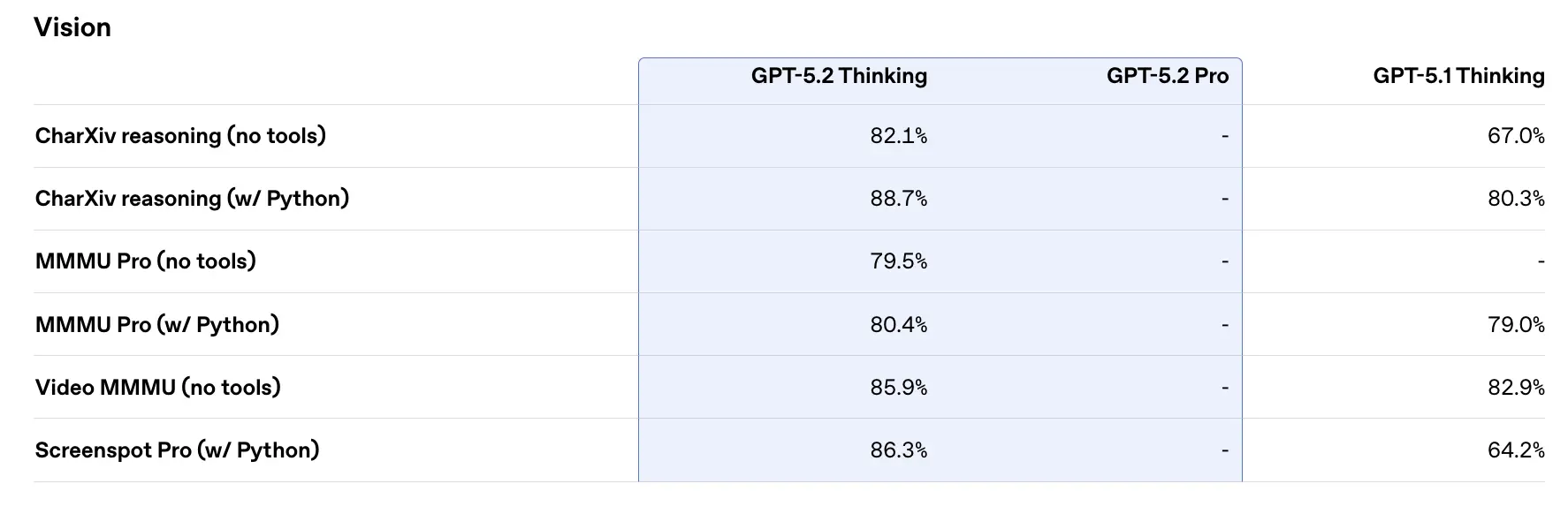

Rendimiento en benchmarks y datos de respaldo

OpenAI publicó una variedad de resultados de benchmarks internos y externos para GPT-5.2. Aspectos destacados seleccionados (cifras reportadas por OpenAI):

- GDPval (44 ocupaciones, trabajo de conocimiento) — GPT-5.2 Thinking “supera o iguala a los mejores profesionales de la industria en el 70,9% de las comparaciones”; OpenAI informa que las salidas se produjeron a >11× la velocidad y a <1% del costo de profesionales expertos en sus tareas de GDPval (las estimaciones de velocidad y costo se basan en datos históricos). Estas tareas incluyen modelos de hojas de cálculo, presentaciones y videos cortos.

- SWE-Bench Pro (coding) — GPT-5.2 Thinking alcanza ≈55.6% en SWE-Bench Pro y ~80% en SWE-Bench Verified (solo Python) según OpenAI, estableciendo un nuevo estado del arte para evaluación de generación de código/ingeniería en sus pruebas. Esto se traduce en depuración más confiable y correcciones de extremo a extremo en la práctica, según los ejemplos de OpenAI.

- GPQA Diamond (preguntas y respuestas a nivel de posgrado en ciencia) — GPT-5.2 Pro: 93.2%, GPT-5.2 Thinking: 92.4% en GPQA Diamond (sin herramientas, razonamiento máximo).

- Serie ARC-AGI — En ARC-AGI-2 (un benchmark más difícil de razonamiento fluido), GPT-5.2 Thinking obtuvo 52.9% y GPT-5.2 Pro 54.2% (OpenAI afirma que son nuevas marcas de estado del arte para modelos de estilo cadena de pensamiento).

- Contexto largo (OpenAI MRCRv2) — GPT-5.2 Thinking muestra precisión cercana al 100% en la variante MRCR de 4 agujas hasta 256k tokens y puntuaciones sustancialmente mejoradas frente a GPT-5.1 en escenarios de contexto largo. (OpenAI publicó gráficos y tablas de MRCRv2.)

Comparación con contemporáneos

- vs Google Gemini 3 (Gemini 3 Pro / Deep Think): Gemini 3 Pro ha sido publicitado con una ventana de contexto de tokens de ~1,048,576 (≈1M) y entradas multimodales amplias (texto, imagen, audio, video, PDFs) y sólidas integraciones de agente vía Vertex AI / AI Studio. En teoría, la ventana de contexto mayor de Gemini 3 es un diferenciador para cargas extremadamente grandes de una sola sesión; las compensaciones incluyen la superficie de herramientas y el encaje en el ecosistema.

- vs Anthropic Claude Opus 4.5: Opus 4.5 de Anthropic enfatiza flujos de trabajo de codificación/agent empresariales y reporta resultados sólidos en SWE-bench y robustez para sesiones agentivas largas; Anthropic posiciona Opus para automatización y generación de código con una ventana de contexto de 200k y integraciones especializadas de agente/Excel. Opus 4.5 es un competidor fuerte en tareas de automatización y código a nivel empresarial.

Conclusión práctica: GPT-5.2 apunta a un conjunto equilibrado de mejoras (contexto de 400k, salidas de tokens altas, razonamiento/codificación mejorados). Gemini 3 apunta a los contextos de una sola sesión absolutamente más grandes (≈1M), mientras que Claude Opus se centra en la ingeniería empresarial y la robustez agentiva. Elige en función del tamaño de contexto, necesidades de modalidad, ajuste de características/herramientas y compensaciones de costo/latencia.

Cómo acceder y usar la API de GPT-5.2

Paso 1: Regístrate para obtener la clave de API

Inicia sesión en cometapi.com. Si aún no eres nuestro usuario, regístrate primero. Inicia sesión en tu consola de CometAPI. Obtén la clave de API de credenciales de acceso de la interfaz. Haz clic en “Add Token” en el token de API en el centro personal, obtén la clave del token: sk-xxxxx y envíala.

Paso 2: Envía solicitudes a la API de GPT-5.2

Selecciona el “gpt-5.2” endpoint para enviar la solicitud de API y establece el cuerpo de la solicitud. El método de la solicitud y el cuerpo de la solicitud se obtienen de la documentación de la API en nuestro sitio web. Nuestro sitio web también proporciona Apifox test para tu comodidad. Reemplaza <YOUR_API_KEY> con tu clave real de CometAPI de tu cuenta. Los desarrolladores llaman a estos vía la Responses API / Chat endpoints.

Inserta tu pregunta o solicitud en el campo de contenido—esto es a lo que el modelo responderá . Procesa la respuesta de la API para obtener la respuesta generada.

Paso 3: Recupera y verifica los resultados

Procesa la respuesta de la API para obtener la respuesta generada. Después del procesamiento, la API responde con el estado de la tarea y los datos de salida.

Consulta también Gemini 3 Pro Preview API