OpenAI, Anthropic y Google siguen ampliando los límites de los modelos de lenguaje de gran tamaño con sus últimas ofertas estrella: o3 de OpenAI (y su versión mejorada o3-pro), Claude Opus 4 de Anthropic y Gemini 2.5 Pro de Google. Cada uno de estos modelos ofrece innovaciones arquitectónicas únicas, ventajas de rendimiento e integraciones con ecosistemas que se adaptan a diferentes casos de uso, desde asistencia para la codificación empresarial hasta mejoras en la búsqueda para el consumidor. Esta comparación exhaustiva examina su historial de lanzamientos, capacidades técnicas, rendimiento de referencia y aplicaciones recomendadas para ayudar a las organizaciones a elegir el modelo más adecuado a sus necesidades.

¿Qué es o3 de OpenAI y cómo ha evolucionado?

OpenAI introdujo o3 por primera vez el 16 de abril de 2025, posicionándolo como "nuestro modelo más inteligente", diseñado para contexto extendido y respuestas altamente confiables. Poco después, el 10 de junio de 2025, OpenAI lanzó o3-pro, una variante optimizada para el rendimiento disponible para usuarios Pro en ChatGPT y a través de la API, que ofrece una inferencia más rápida y un mayor rendimiento con cargas pesadas.

Ventana de contexto y rendimiento

OpenAI o3 ofrece una 200 tokens Ventana contextual para entrada y salida, lo que permite gestionar documentos extensos, bases de código o conversaciones de varios turnos sin truncamientos frecuentes. Su rendimiento se mide en torno a... 37.6 tokens/seg, que, si bien no lidera el grupo, proporciona una capacidad de respuesta constante para cargas de trabajo sostenidas.

Razonamiento deliberativo avanzado

- “Cadena privada de pensamiento”:o3 fue entrenado con aprendizaje de refuerzo para planificar y razonar a través de pasos intermedios antes de producir su resultado final, mejorando notablemente su capacidad de deducción lógica y descomposición de problemas.

- Alineación deliberativa:Incorpora técnicas de seguridad que guían al modelo para adherirse de manera más confiable a las pautas a través de un razonamiento paso a paso, reduciendo errores importantes en tareas complejas del mundo real.

Precios e integración empresarial

El precio de OpenAI para o3 es de aproximadamente $2 por millón de tokens de entrada y $8 por millón de tokens de salidaEsto lo posiciona en el rango medio: más asequible que modelos premium como Claude Opus 4 para cargas de trabajo pesadas, pero más costoso que alternativas económicas como Gemini 2.5 Pro. Fundamentalmente, las empresas se benefician de una integración fluida con el ecosistema más amplio de API de OpenAI, que abarca integraciones, ajustes y endpoints especializados, lo que minimiza la sobrecarga de integración.

¿Cómo se diferencia Claude Opus 4 en el mercado?

Anthropic anunció Claude Opus 4 el 22 de mayo de 2025, promocionándolo como "el mejor modelo de codificación del mundo" con un rendimiento sostenido en tareas complejas y de larga duración, así como en flujos de trabajo de agentes. Se lanzó simultáneamente en la API de Anthropic y a través de Amazon Bedrock, lo que lo hizo accesible a los clientes de AWS mediante las funciones LLM y la API REST de Bedrock...

Capacidades de “pensamiento” ampliadas

Una característica distintiva de Opus 4 es su “pensamiento extendido” Modo beta, que asigna dinámicamente el cómputo entre el razonamiento del modelo y las invocaciones de herramientas (p. ej., búsqueda, recuperación, API externas). Junto con los "resúmenes de razonamiento", los usuarios obtienen visibilidad de la cadena de razonamiento interna del modelo, crucial para aplicaciones con requisitos de cumplimiento normativo en los sectores financiero y sanitario.

Compensaciones entre precios y contexto

At $15 por millón de tokens de entrada y $75 por millón de tokens de salidaClaude Opus 4 se sitúa en lo más alto del espectro de precios. Su 200 tokens ventana de entrada (con una 32 tokens El límite de salida es menor que la ventana de 2.5 millón de tokens de Gemini 1 Pro, pero es suficiente para la mayoría de las tareas de revisión de código y razonamiento de formato largo. Anthropic justifica la prima al enfatizar la intensidad de cómputo interno y la fidelidad sostenida de la cadena de pensamiento, con un ahorro de hasta el 90 % mediante el almacenamiento en caché de indicaciones y del 50 % mediante el procesamiento por lotes. Los presupuestos de pensamiento extendido están incluidos en los niveles de pago; los usuarios gratuitos solo pueden acceder a la variante Sonnet.

¿Qué características y rendimiento únicos aporta Gemini 2.5 Pro?

Lanzado como el nivel “Pro” de próxima generación de Google, Géminis 2.5 Pro Está dirigido a organizaciones que necesitan contexto masivo, información multimodal y escalabilidad rentable. Cabe destacar que admite hasta Tokens 1,048,576 en un solo mensaje (entrante) y Tokens 65,535 saliente, lo que permite flujos de trabajo de documentos de extremo a extremo que abarcan cientos de miles de páginas.

Contexto superior y multimodalidad

Gemini 2.5 Pro brilla con su 1 millón de tokens ventana de contexto, lo que facilita casos de uso como el análisis de contratos legales, la minería de patentes y la refactorización integral de la base de código. El modelo acepta de forma nativa texto, código, imágenes, audio, archivos PDF y fotogramas de vídeo, agilizando los ductos multimodales sin pasos de preprocesamiento separados.

¿Cómo mejora Gemini la búsqueda multimodal y conversacional?

Gemini 2.5 Pro destaca por su metodología de "distribución de consultas": descompone consultas complejas en subpreguntas, ejecuta búsquedas paralelas y sintetiza respuestas completas y conversacionales sobre la marcha. Con compatibilidad con texto, voz e imagen, el Modo IA aprovecha las capacidades multimodales de Gemini para adaptarse a diversas interacciones del usuario, aunque aún se encuentra en una etapa inicial y, en ocasiones, puede malinterpretar las consultas.

Precios competitivos

Con una tasa de entrada de $1.25–$2.50 por millón de tokens y $10–$15 Por cada millón de tokens de salida, Gemini 2.5 Pro ofrece lo mejor precio por token Relación entre los tres. Esto lo hace especialmente atractivo para aplicaciones con gran volumen de documentos, donde los contextos largos impulsan el consumo de tokens más que las métricas de rendimiento sin procesar. Los planes premium permiten presupuestos de análisis profundo y un mayor rendimiento. Las suscripciones a Google AI Pro y Ultra incluyen acceso a Gemini 2.5 Pro junto con otras herramientas como la generación de video Veo y NotebookLM.

Arquitecturas y capacidades subyacentes

OpenAI o3: Razonamiento reflexivo a escala

o3 de OpenAI es un transformador generativo reflexivo preentrenado, diseñado para dedicar tiempo adicional de deliberación a tareas de razonamiento lógico paso a paso. Arquitectónicamente, se basa en la estructura del transformador GPT-4, pero incorpora un mecanismo de "presupuesto de pensamiento": el modelo asigna dinámicamente más ciclos de cómputo a problemas complejos, creando cadenas internas de pensamiento antes de generar resultados. Esto resulta en un rendimiento notablemente mejorado en dominios que requieren razonamiento de varios pasos, como matemáticas avanzadas, investigación científica y síntesis de código.

Claude Opus 4: Razonamiento híbrido para flujos de trabajo extendidos

Claude Opus 4 de Anthropic es su modelo más potente hasta la fecha, optimizado para codificación y flujos de trabajo de agentes sostenidos. Al igual que o3, utiliza un núcleo transformador, pero introduce modos de razonamiento híbridos (respuestas casi instantáneas ("pensamiento rápido") frente a deliberación prolongada ("pensamiento profundo")), lo que le permite mantener el contexto a lo largo de miles de pasos y horas de computación. Este enfoque híbrido hace que Opus 4 sea especialmente adecuado para procesos de ingeniería de software de larga duración, tareas de investigación multietapa y orquestación autónoma de agentes.

Gemini 2.5 Pro: Pensamiento multimodal con presupuestos adaptativos

Gemini 2.5 Pro de Google DeepMind amplía las capacidades nativas de multimodalidad y razonamiento de Gemini. Introduce "Deep Think", un mecanismo adaptativo de pensamiento paralelo que distribuye subtareas entre módulos internos, sintetizando los resultados en respuestas coherentes. Gemini 2.5 Pro también cuenta con una ventana de contexto excepcionalmente amplia, lo que le permite procesar bases de código completas, grandes conjuntos de datos (texto, audio, vídeo) y documentos de diseño en una sola pasada, a la vez que proporciona controles precisos sobre los presupuestos de pensamiento para equilibrar el rendimiento y el coste.

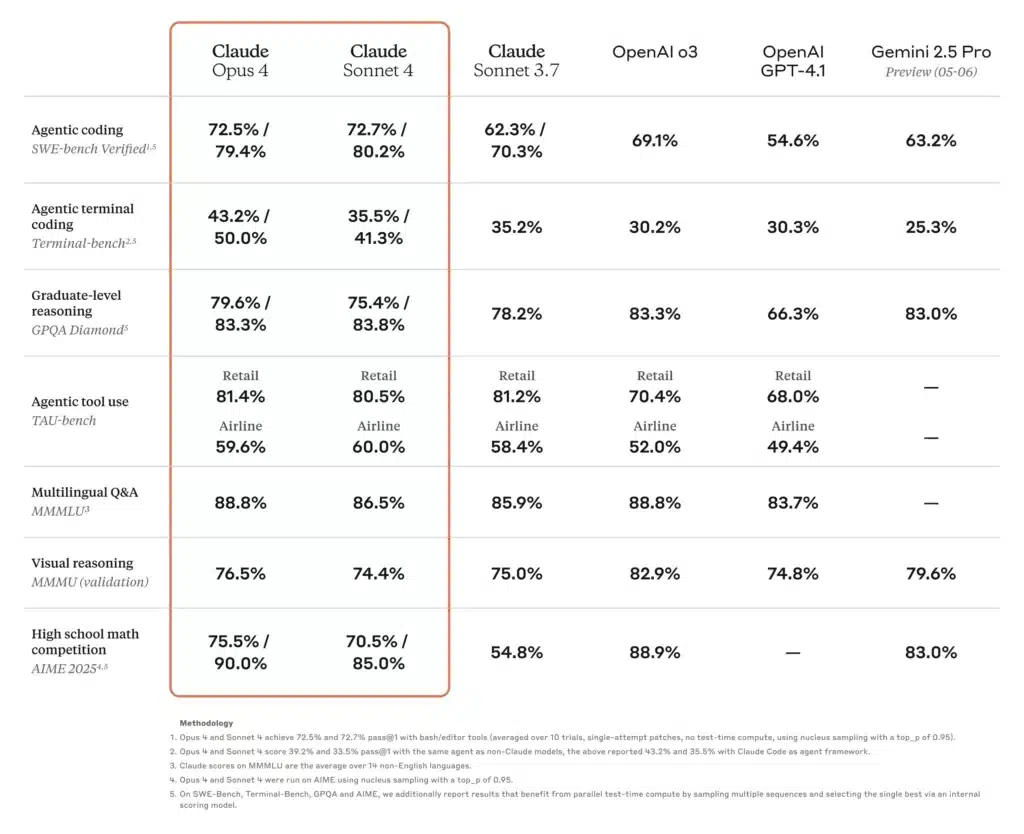

¿Cómo se comparan los puntos de referencia de rendimiento entre estos modelos?

Razonamiento académico y científico

En una clasificación reciente de SciArena, o3 superó a sus pares en preguntas de razonamiento técnico evaluadas por investigadores, lo que refleja la sólida confianza de la comunidad en su precisión científica. Por otro lado, Claude Opus 4 demostró un rendimiento superior en pruebas de rendimiento basadas en agentes que requieren resolución sostenida de problemas durante varias horas, superando a los modelos Sonnet hasta en un 30 % en pruebas de TAU y razonamiento predictivo. Gemini 2.5 Pro también lidera muchas pruebas académicas, alcanzando el primer puesto en LMArena en medidas de preferencia humana y mostrando importantes ventajas en pruebas de matemáticas y ciencias.

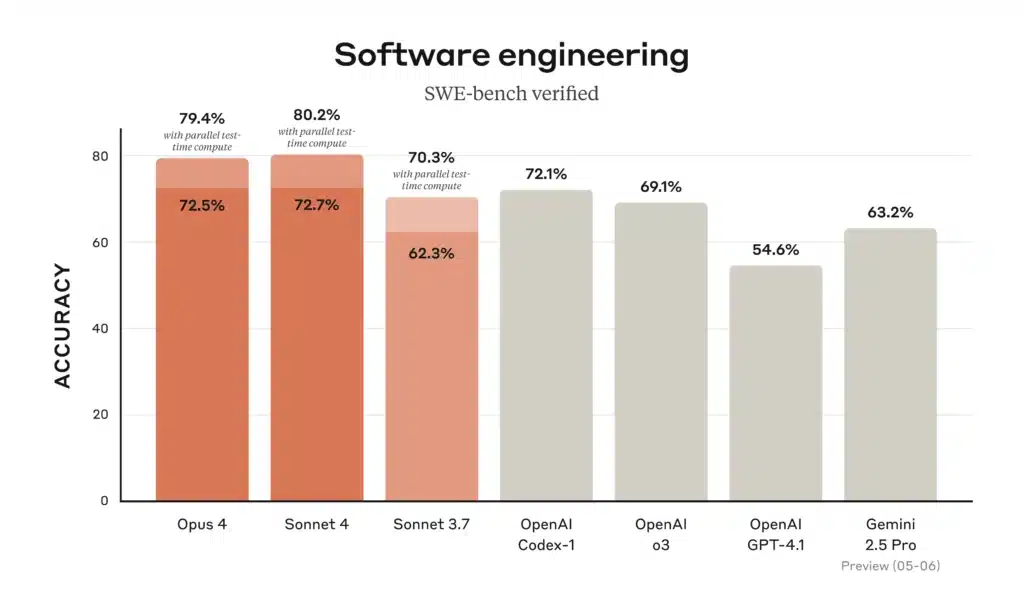

Codificación e ingeniería de software

En las clasificaciones de programación, Gemini 2.5 Pro lidera el popular WebDev Arena y las pruebas de referencia de programación comunes gracias a su capacidad para cargar y razonar repositorios completos. Claude Opus 4 ostenta el título de "mejor modelo de programación del mundo", con un 72.5 % en SWE-bench y un 43.2 % en Terminal-bench, pruebas centradas en tareas de software complejas y de larga duración. o3 también destaca en la síntesis y depuración de código, pero se queda ligeramente por detrás de Opus 4 y Gemini en escenarios de ingeniería de varios pasos a gran escala. No obstante, su intuitiva cadena de pensamiento lo hace altamente fiable para tareas de programación individuales.

Uso de herramientas e integración multimodal

El diseño multimodal de Gemini 2.5 Pro (que procesa texto, imágenes, audio y video) le otorga una ventaja en flujos de trabajo creativos como simulaciones interactivas, análisis visual de datos y guiones gráficos de video. El uso de herramientas de Claude Opus 4, que incluye la CLI de Claude Code y las operaciones integradas del sistema de archivos, destaca en la creación de canales autónomos entre API y bases de datos. o3 admite navegación web, análisis de archivos, ejecución en Python y razonamiento de imágenes, lo que lo convierte en una herramienta versátil para tareas de formato mixto, aunque con límites de contexto más reducidos que Gemini 2.5 Pro.

¿Cómo se comparan estos modelos en escenarios de codificación del mundo real?

En lo que respecta a la asistencia en la codificación, los benchmarks solo cuentan una parte de la historia. Los desarrolladores buscan una generación de código precisa, destreza en la refactorización y la capacidad de comprender el contexto del proyecto distribuido en múltiples archivos.

Tasas de precisión y alucinaciones

- Claude Opus 4 Es líder en la prevención de alucinaciones, con menos casos de referencias de API inexistentes o firmas de biblioteca incorrectas, clave para bases de código críticas. Su tasa de alucinaciones se reporta en ~ 12% sobre auditorías de código exhaustivas versus ~ 18% para Géminis y ~ 20% para o3.

- Géminis 2.5 Pro Se destaca en transformaciones masivas (por ejemplo, migrar patrones de código a lo largo de decenas de miles de líneas), gracias a su amplia ventana de contexto, pero ocasionalmente tiene problemas con errores lógicos sutiles en grandes bloques de código.

- AbiertoAI o3 sigue siendo la opción preferida para fragmentos rápidos, generación de código repetitivo y depuración interactiva debido a su latencia estable y alta disponibilidad, pero los desarrolladores a menudo realizan una validación cruzada con otro modelo para detectar errores en casos extremos.

Ecosistema de herramientas y API

- Ambos o3 y Gemini Aproveche herramientas extensas (la API de llamada de funciones de OpenAI y el marco de acciones integrado de Google respectivamente), lo que permite una orquestación fluida de la recuperación de datos, las consultas de bases de datos y las llamadas a API externas.

- Claude Opus 4 Se está integrando en marcos de trabajo de agentes como Claude Code (herramienta CLI de Anthropic) y Amazon Bedrock, ofreciendo abstracciones de alto nivel para crear flujos de trabajo autónomos sin orquestación manual.

¿Qué modelo ofrece la mejor relación precio-rendimiento?

Al equilibrar las capacidades brutas, la duración del contexto y el costo se obtienen diferentes conclusiones sobre el “mejor valor” según las características de la carga de trabajo.

Casos de uso de gran volumen centrados en documentos

Si se procesan grandes corpus (como repositorios legales, literatura científica o archivos empresariales),Géminis 2.5 Pro A menudo surge como el ganador. Su 1 millón de tokens ventana y punto de precio de $ 1.25-$ 2.50 (entrada) y $ 10-$ 15 Los tokens (de salida) proporcionan una estructura de costos inmejorable para tareas de contexto largo.

Razonamiento profundo y flujos de trabajo de varios pasos

Cuando la precisión, la fidelidad en la cadena de pensamiento y las capacidades de los agentes a largo plazo son importantes (como en el modelado financiero, las verificaciones de cumplimiento legal o los procesos de I+D),Claude Opus 4, a pesar de su precio más elevado, puede reducir la sobrecarga de manejo de errores y mejorar el rendimiento de extremo a extremo al minimizar las repeticiones y los ciclos de revisión humana.

Adopción empresarial equilibrada

Para equipos que buscan un rendimiento confiable de propósito general sin escala extrema, AbiertoAI o3 Ofrece un punto intermedio. Con un amplio soporte de API, precios moderados y sólidos resultados de benchmarking, sigue siendo una opción atractiva para plataformas de ciencia de datos, automatización de la atención al cliente e integraciones de productos en etapas iniciales.

¿Qué modelo de IA debería elegir para sus necesidades específicas?

En última instancia, su modelo ideal depende de tres factores principales:

- Escala de contextoPara cargas de trabajo que requieren ventanas de entrada masivas, Gemini 2.5 Pro domina.

- Profundidad del razonamiento:Si sus tareas implican lógica de varios pasos y baja tolerancia a errores, Claude Opus 4 ofrece una consistencia superior.

- Sensibilidad a los costos y adecuación al ecosistemaPara tareas de propósito general dentro de la pila OpenAI, especialmente donde es importante la integración con canales de datos existentes, o3 presenta una opción equilibrada y rentable.

Al evaluar el perfil de token de su aplicación (entrada vs. salida), la tolerancia a las alucinaciones y los requisitos de herramientas, puede seleccionar el modelo que se alinee óptimamente con las necesidades técnicas y las limitaciones presupuestarias.

A continuación, se muestra un cuadro comparativo que resume las especificaciones clave, las métricas de rendimiento, los precios y los casos de uso ideales de OpenAI o3, Anthropic Claude Opus 4 y Google Gemini 2.5 Pro:

| Característica/Métrica | AbiertoAI o3 | Claude Opus 4 | Géminis 2.5 Pro |

|---|---|---|---|

| Ventana de contexto (entrante/saliente) | 200 K tokens / 200 K tokens | 200 K tokens / 32 K tokens | 1 048 576 fichas / 65 535 fichas |

| Rendimiento (tokens/seg) | ~ 37.6 | ~ 42.1 | ~ 83.7 |

| Latencia media | ~ 2.8 segundos | ~ 3.5 segundos | ~ 2.52 segundos |

| Punto de referencia de codificación (SWE-bench) | 69.1% | 72.5% | 63.2% |

| Punto de referencia de matemáticas (AIME-2025) | 78.4%¹ | 81.7%¹ | 83.0% |

| Tasa de alucinaciones (auditorías de código) | ~ 20% | ~ 12% | ~ 18% |

| Entradas multimodales | Texto y código | Texto y código | Texto, código, imágenes, audio, PDF, vídeo |

| Apoyo de “cadena de pensamiento” | Estándar | Pensamiento extendido con resúmenes | Estándar |

| API de llamada a funciones/herramientas | Sí (Funciones de OpenAI) | Sí (a través de agentes antrópicos y Bedrock) | Sí (Acciones de Google) |

| Precios (tokens de entrada) | $2.00 / M tokens | $15.00 / M tokens | $1.25–$2.50 / M tokens |

| Precios (tokens de salida) | $8.00 / M tokens | $75.00 / M tokens | $10–$15 / M tokens |

| Casos de uso ideales | Chatbots de propósito general, atención al cliente, fragmentos de código rápidos | Razonamiento profundo, bases de código complejas, agentes autónomos | Análisis de documentos a gran escala, flujos de trabajo multimodales |

Los puntajes de matemáticas AIME-2025 para o3 y Opus 4 son valores aproximados de rango medio basados en puntos de referencia informados.

Primeros Pasos

CometAPI es una plataforma API unificada que integra más de 500 modelos de IA de proveedores líderes, como la serie GPT de OpenAI, Gemini de Google, Claude de Anthropic, Midjourney, Suno y más, en una única interfaz intuitiva para desarrolladores. Al ofrecer autenticación, formato de solicitudes y gestión de respuestas consistentes, CometAPI simplifica drásticamente la integración de las capacidades de IA en sus aplicaciones. Ya sea que esté desarrollando chatbots, generadores de imágenes, compositores musicales o canales de análisis basados en datos, CometAPI le permite iterar más rápido, controlar costos y mantenerse independiente del proveedor, todo mientras aprovecha los últimos avances del ecosistema de IA.

Los desarrolladores pueden acceder Géminis 2.5 Pro,Claude Opus 4 y API de O3 atravesar CometAPILas últimas versiones de los modelos mencionados corresponden a la fecha de publicación del artículo. Para comenzar, explore las capacidades del modelo en... Playground y consultar el Guía de API Para obtener instrucciones detalladas, consulte la sección "Antes de acceder, asegúrese de haber iniciado sesión en CometAPI y de haber obtenido la clave API". CometAPI Ofrecemos un precio muy inferior al oficial para ayudarte a integrarte.

En definitiva, la elección entre la serie o3 de OpenAI, Claude Opus 4 de Anthropic y Gemini 2.5 Pro de Google depende de prioridades organizativas específicas, ya sea un rendimiento técnico de primer nivel, una integración empresarial segura o experiencias de consumidor multimodales fluidas. Al alinear sus casos de uso con las fortalezas y el ecosistema de cada modelo, puede aprovechar la vanguardia de la IA para impulsar la innovación en investigación, desarrollo, educación y más allá.

Nota del autor: A partir del 31 de julio de 2025, cada uno de estos modelos seguirá evolucionando, con pequeñas actualizaciones y mejoras frecuentes en el ecosistema. Consulte siempre la documentación de la API de CometAPI y las pruebas de rendimiento más recientes antes de tomar una decisión definitiva.