DeepSeek ha lanzado Búsqueda profunda V3.2 como sucesor de su línea V3.x y un acompañante DeepSeek-V3.2-Especial Variante que la compañía posiciona como una edición de alto rendimiento, centrada en el razonamiento, para uso de agentes y herramientas. La V3.2 se basa en trabajos experimentales (V3.2-Exp) e introduce una mayor capacidad de razonamiento, una edición Speciale optimizada para un rendimiento de alto nivel en matemáticas y programación competitiva, y lo que DeepSeek describe como un sistema dual de "pensamiento + herramienta", pionero en su tipo, que integra estrechamente el razonamiento interno paso a paso con la invocación de herramientas externas y los flujos de trabajo de agentes.

¿Qué es DeepSeek V3.2 y en qué se diferencia de V3.2-Speciale?

DeepSeek-V3.2 es el sucesor oficial de la rama experimental V3.2-Exp de DeepSeek. DeepSeek lo describe como... Familia de modelos de “razonamiento primero” creada para agentes, es decir, modelos ajustados no solo para la calidad conversacional natural sino específicamente para la inferencia de múltiples pasos, la invocación de herramientas y el razonamiento confiable en cadena de pensamiento cuando se opera en entornos que incluyen herramientas externas (API, ejecución de código, conectores de datos).

¿Qué es DeepSeek-V3.2 (base)?

- Posicionado como el sucesor de producción principal de la línea experimental V3.2-Exp; destinado a una amplia disponibilidad a través de la aplicación/web/API de DeepSeek.

- Mantiene un equilibrio entre la eficiencia computacional y el razonamiento sólido para tareas de agente.

¿Qué es DeepSeek-V3.2-Speciale?

DeepSeek-V3.2-Especial Es una variante que DeepSeek comercializa como una "Edición Especial" de mayor capacidad, optimizada para razonamiento a nivel de concurso, matemáticas avanzadas y rendimiento de agentes. Se comercializa como una variante de mayor capacidad que "traspasa los límites de las capacidades de razonamiento". DeepSeek actualmente expone Speciale como un modelo solo para API con enrutamiento de acceso temporal; las primeras pruebas de rendimiento sugieren que está posicionado para competir con modelos cerrados de alto nivel en pruebas de rendimiento de razonamiento y codificación.

¿Qué linaje y decisiones de ingeniería llevaron a la V3.2?

La versión 3.2 hereda una línea de ingeniería iterativa que DeepSeek difundió a lo largo de 2025: V3 → V3.1 (Terminus) → V3.2-Exp (un paso experimental) → V3.2 → V3.2-Speciale. Se introdujo la versión experimental V3.2-Exp. Atención dispersa de DeepSeek (DSA) — un mecanismo de atención dispersa de grano fino destinado a reducir los costos de memoria y computación para contextos muy largos, preservando al mismo tiempo la calidad de salida. Esta investigación de DSA y el trabajo de reducción de costos sirvieron como un trampolín técnico para la familia oficial V3.2.

¿Qué novedades hay en la versión oficial DeepSeek 3.2?

1) Capacidad de razonamiento mejorada: ¿cómo se mejora el razonamiento?

DeepSeek comercializa la versión 3.2 como “razonamiento primero.” Esto significa que la arquitectura y el ajuste se centran en realizar de manera confiable inferencias de múltiples pasos, mantener cadenas de pensamiento internas y respaldar los tipos de deliberación estructurada que los agentes necesitan para usar las herramientas externas correctamente.

Concretamente, las mejoras incluyen:

- Entrenamiento y RLHF (o procedimientos de alineación similares) ajustados para fomentar la resolución explícita de problemas paso a paso y estados intermedios estables (útiles para razonamiento matemático, generación de código de múltiples pasos y tareas lógicas).

- Opciones arquitectónicas y de función de pérdida que preservan ventanas de contexto más largas y permiten que el modelo haga referencia a pasos de razonamiento anteriores con fidelidad.

- Modos prácticos (ver “modo dual” a continuación) que permiten que el mismo modelo funcione en un modo de “conversación” más rápido o en un modo de “pensamiento” deliberativo donde trabaja intencionalmente a través de pasos intermedios antes de actuar.

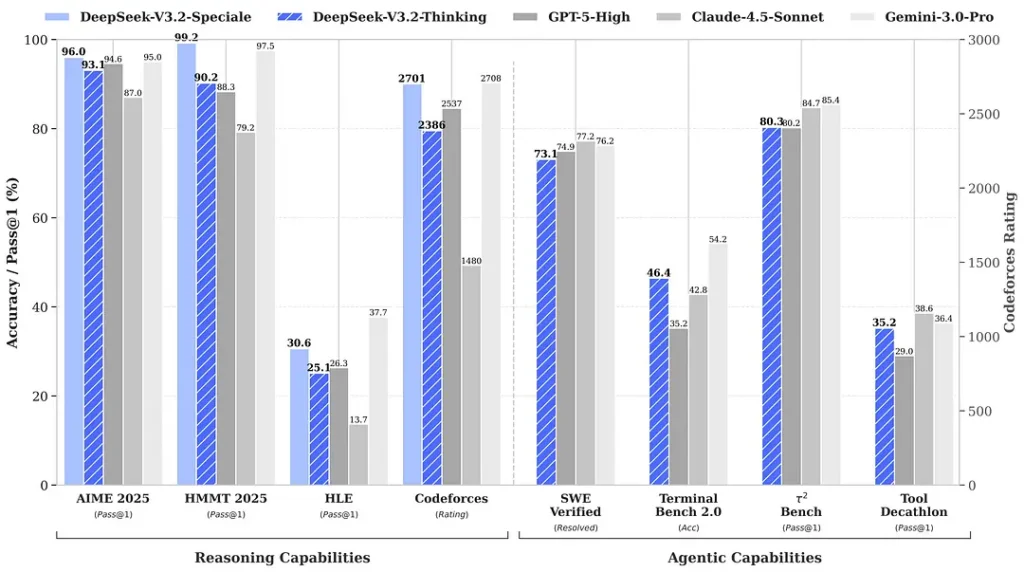

Los puntos de referencia citados en torno al lanzamiento afirman avances notables en conjuntos de matemáticas y razonamiento; los primeros puntos de referencia comunitarios independientes también informan puntajes impresionantes en conjuntos de evaluación competitivos:

2) Rendimiento innovador en la Edición Especial: ¿cuánto mejor?

DeepSeek-V3.2-Especial Se afirma que ofrece una mejora en la precisión del razonamiento y la orquestación de agentes en comparación con la versión estándar V3.2. El proveedor define Speciale como un nivel de rendimiento orientado a cargas de razonamiento intensas y tareas exigentes para los agentes. Actualmente, es solo API y se ofrece como un punto final temporal de mayor capacidad (DeepSeek indicó que la disponibilidad de Speciale será limitada inicialmente). La versión de Speciale integra el modelo matemático anterior DeepSeek-Math-V2; puede demostrar teoremas matemáticos y verificar el razonamiento lógico por sí misma; ha obtenido resultados notables en múltiples competiciones de clase mundial.

- 🥇 Medalla de Oro de la OMI (Olimpiada Internacional de Matemáticas)

- 🥇 Medalla de Oro de la Olimpiada Matemática China (CMO)

- 🥈 ICPC (Concurso Internacional de Programación de Computadoras) Segundo Lugar (Concurso Humano)

- 🥉 IOI (Olimpiada Internacional de Informática) Décimo Lugar (Concurso Humano)

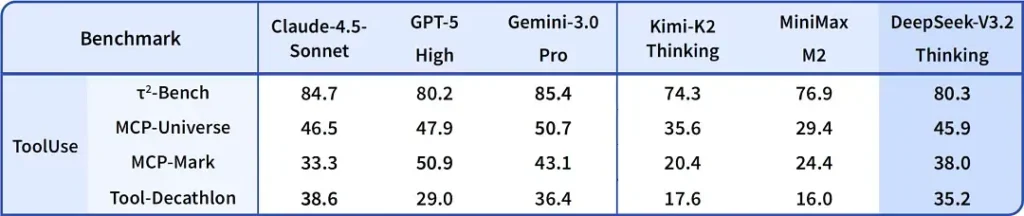

| GPT-5 Alto | Géminis-3.0 Pro | Pensamiento Kimi-K2 | Pensamiento de DeepSeek-V3.2 | DeepSeek-V3.2 Especial | |

|---|---|---|---|---|---|

| AIME 2025 | 94.6 (13k) | 95.0 (15k) | 94.5 (24k) | 93.1 (16k) | 96.0 (23k) |

| HMMT 2025 de febrero | 88.3 (16k) | 97.5 (16k) | 89.4 (31k) | 92.5 (19k) | 99.2 (27k) |

| HMMT noviembre de 2025 | 89.2 (20k) | 93.3 (15k) | 89.2 (29k) | 90.2 (18k) | 94.4 (25k) |

| Banco de respuestas de la OMI | 76.0 (31k) | 83.3 (18k) | 78.6 (37k) | 78.3 (27k) | 84.5 (45k) |

| Banco de código en vivo | 84.5 (13k) | 90.7 (13k) | 82.6 (29k) | 83.3 (16k) | 88.7 (27k) |

| CodeForces | 2537 (29k) | 2708 (22k) | - | 2386 (42k) | 2701 (77k) |

| Diamante GPQA | 85.7 (8k) | 91.9 (8k) | 84.5 (12k) | 82.4 (7k) | 85.7 (16k) |

| HLE | 26.3 (15k) | 37.7 (15k) | 23.9 (24k) | 25.1 (21k) | 30.6 (35k) |

3) Primera implementación de un sistema de modo dual “pensamiento + herramienta”

Una de las afirmaciones más interesantes desde el punto de vista práctico de la V3.2 es una flujo de trabajo de modo dual que separa (y le permite elegir entre) una operación conversacional rápida y un modo de “pensamiento” deliberativo más lento que se integra estrechamente con el uso de herramientas.

- Modo “Chat/rápido”: Diseñado para un chat de baja latencia orientado al usuario con respuestas concisas y menos rastros de razonamiento interno: ideal para ayuda informal, preguntas y respuestas breves y aplicaciones sensibles a la velocidad.

- Modo “pensador/razonador”: Optimizado para una rigurosa cadena de pensamiento, planificación gradual y orquestación de herramientas externas (API, consultas a bases de datos, ejecución de código). Al operar en modo de pensamiento, el modelo genera pasos intermedios más explícitos, que pueden inspeccionarse o utilizarse para impulsar llamadas de herramientas seguras y correctas en sistemas agénticos.

Este patrón (un diseño de dos modos) ya estaba presente en ramas experimentales anteriores, y DeepSeek lo ha integrado con mayor profundidad en la versión 3.2 y Speciale. Speciale actualmente admite exclusivamente el modo de pensamiento (de ahí su control de API). La capacidad de alternar entre velocidad y deliberación es valiosa para la ingeniería, ya que permite a los desarrolladores encontrar el equilibrio adecuado entre latencia y fiabilidad al crear agentes que deben interactuar con sistemas del mundo real.

Por qué es notable: Muchos sistemas modernos ofrecen un sólido modelo de cadena de pensamiento (para explicar el razonamiento) o una capa independiente de orquestación de agentes y herramientas. El enfoque de DeepSeek sugiere un acoplamiento más estrecho: el modelo puede "pensar" y luego invocar herramientas de forma determinista, utilizando las respuestas de estas para fundamentar el pensamiento posterior, lo que resulta más fluido para los desarrolladores que crean agentes autónomos.

Dónde conseguir Búsqueda profunda v3.2

Respuesta corta: puedes obtener DeepSeek v3.2 de varias maneras según lo que necesites:

- Web/aplicación oficial (uso en línea) — Pruebe la interfaz web o la aplicación móvil de DeepSeek para utilizar la versión 3.2 de forma interactiva.

- Acceso API — DeepSeek expone la versión 3.2 a través de su API (la documentación incluye nombres de modelos, URL base y precios). Regístrese para obtener una clave API y llame al punto de conexión de la versión 3.2.

- Pesas descargables/abiertas (Cara abrazada) El modelo (variantes V3.2 / V3.2-Exp) está publicado en Hugging Face y se puede descargar (peso abierto). Usar

huggingface-hubortransformerspara extraer los archivos. - CometAPI — Una plataforma de agregación de API de IA que ofrece puntos finales alojados (versión 3.2-Exp). El precio es inferior al oficial.

Un par de notas prácticas:

- Si desea pesos para ejecutar localmente, vaya a la página del modelo Hugging Face (acepte cualquier licencia / condiciones de acceso allí) y use

huggingface-cliortransformerspara descargar; el repositorio de GitHub generalmente muestra los comandos exactos. - Si desea uso de producción a través de API, siga las instrucciones que desee en la plataforma, como los documentos de la API de cometapi, para conocer los nombres de los puntos finales y la información correcta.

base_urlpara la variante V3.2.

DeepSeek-V3.2-Especial:

- Abierto solo para uso de investigación, admite el diálogo “Modo de pensamiento”, pero no admite llamadas de herramientas.

- La salida máxima puede alcanzar 128K tokens (Think Chain ultra larga).

- Actualmente disponible para probar de forma gratuita hasta el 15 de diciembre de 2025.

Reflexiones finales

DeepSeek-V3.2 representa un paso significativo en la maduración de los modelos centrados en el razonamiento. Su combinación de razonamiento multipaso mejorado, ediciones especializadas de alto rendimiento (Speciale) y una integración de producción de "pensamiento + herramientas" es destacable para quienes desarrollan agentes avanzados, asistentes de programación o flujos de trabajo de investigación que deben intercalar la deliberación con acciones externas.

Los desarrolladores pueden acceder a DeepSeek V3.2 a través de CometAPI. Para comenzar, explore las capacidades del modelo de CometAPI en Playground y consultar el Guía de API Para obtener instrucciones detalladas, consulte la sección "Antes de acceder, asegúrese de haber iniciado sesión en CometAPI y de haber obtenido la clave API". ComoeAPI Ofrecemos un precio muy inferior al oficial para ayudarte a integrarte.

¿Listo para ir?→ Regístrate en CometAPI hoy !

Si quieres conocer más consejos, guías y novedades sobre IA síguenos en VK, X y Discord!