En el acelerado mundo de la inteligencia artificial, el lanzamiento de cada nuevo modelo de lenguaje grande (LLM) representa más que un simple aumento en la versión numérica: indica un progreso en el razonamiento, la capacidad de codificación y la colaboración entre humanos y máquinas. A finales de septiembre de 2025, Zhipu AI (Z.ai) dio a conocer GLM-4.6, el miembro más reciente de la familia de Modelos Generales de Lenguaje. Basándose en la robusta arquitectura y la sólida base de razonamiento de GLM-4.5, esta actualización perfecciona las capacidades del modelo en razonamiento agente, inteligencia de codificación y comprensión de contextos largos, permaneciendo abierto y accesible tanto para desarrolladores como para empresas.

¿Qué es GLM-4.6?

GLM-4.6 es una versión importante de la serie GLM (Modelo de Lenguaje General), diseñada para equilibrar el razonamiento de alta capacidad con flujos de trabajo prácticos para desarrolladores. A grandes rasgos, esta versión se centra en tres casos de uso estrechamente relacionados: (1) generación avanzada de código y razonamiento sobre el código, (2) tareas de contexto extendido que requieren la comprensión del modelo a través de entradas muy extensas, y (3) flujos de trabajo de agencia donde el modelo debe planificar, invocar herramientas y orquestar procesos de varios pasos. El modelo se ofrece en variantes diseñadas para API en la nube y centros de modelos comunitarios, lo que permite implementar patrones de implementación alojados y autoalojados.

En la práctica, GLM-4.6 se posiciona como un producto estrella que prioriza al desarrollador: sus mejoras no se limitan a las cifras de referencia, sino a las capacidades que transforman sustancialmente la forma en que los desarrolladores crean asistentes, copilotos de código y agentes basados en documentos o conocimiento. Se espera una versión que priorice el ajuste de instrucciones para el uso de herramientas, mejoras detalladas en la calidad y la depuración del código, y opciones de infraestructura que permitan contextos muy largos sin una degeneración lineal del rendimiento.

¿Qué pretende resolver el GLM-4.6?

- Reduzca la fricción de trabajar con bases de código extensas y documentos grandes al admitir ventanas de contexto efectivas más largas.

- Mejorar la confiabilidad de la generación y depuración de código, produciendo resultados más idiomáticos y comprobables.

- Aumente la solidez de los comportamientos agenticos (planificación, uso de herramientas y ejecución de tareas de varios pasos) mediante instrucciones específicas y un ajuste del estilo de refuerzo.

¿Qué cambió en la práctica desde GLM-4.5 a GLM-4.6?

- Contexto escalar:128K saltar a 200 mil fichas Es el mayor cambio de experiencia de usuario y arquitectura para los usuarios: documentos extensos, bases de código completas o transcripciones extendidas de agentes ahora se pueden procesar como una única ventana de contexto. Esto reduce la necesidad de fragmentación ad hoc o costosos bucles de recuperación para muchos flujos de trabajo.

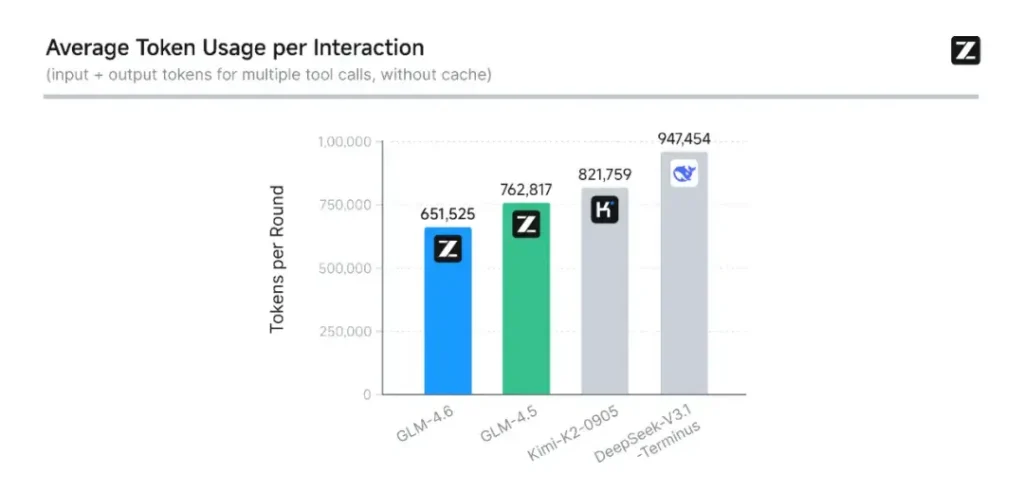

- Codificación y evaluación en el mundo real: Z.ai amplió CC-Bench (su punto de referencia de codificación y finalización) con trayectorias de tareas reales más difíciles e informa que GLM-4.6 finaliza las tareas con ~15% menos tokens que GLM-4.5, a la vez que mejora las tasas de éxito en tareas complejas de ingeniería multi-turno. Esto indica una mayor eficiencia de tokens, así como mejoras en la capacidad bruta en escenarios de codificación aplicada. Z.ai

- Integración de agentes y herramientas: GLM-4.6 incluye mejores patrones de soporte para llamadas de herramientas y agentes de búsqueda, lo cual es importante para los productos que dependen del modelo para orquestar la búsqueda web, la ejecución de código u otros microservicios.

¿Cuáles son las características principales de GLM-4.6?

1. Ventana de contexto ampliada a 200 000 tokens

Una de las características más llamativas de GLM-4.6 es su ventana de contexto extendida masivamente. Ampliación de 128K en la generación anterior a 200 mil fichasGLM-4.6 puede procesar libros completos, conjuntos de datos complejos con múltiples documentos o incluso horas de diálogo en una sola sesión. Esta expansión no solo mejora la comprensión, sino que también permite... razonamiento consistente sobre entradas largas — un gran salto para el resumen de documentos, el análisis legal y los flujos de trabajo de ingeniería de software.

2. Inteligencia de codificación mejorada

Interno de Zhipu AI Banco CC El punto de referencia, un conjunto de tareas de programación del mundo real, muestra que GLM-4.6 logra mejoras notables en la precisión y eficiencia de la codificaciónEl modelo puede producir código sintácticamente correcto y lógicamente sólido mientras utiliza aproximadamente un 15% menos de tokens que GLM-4.5 para tareas equivalentes. Esta eficiencia se traduce en finalizaciones más rápidas y económicas sin sacrificar la calidad, un factor vital para la implementación empresarial.

3. Razonamiento avanzado e integración de herramientas

Más allá de la generación de texto sin procesar, GLM-4.6 brilla en razonamiento aumentado con herramientasHa sido entrenado y alineado para la planificación multipaso y la orquestación de sistemas externos, desde bases de datos hasta herramientas de búsqueda y entornos de ejecución. En la práctica, esto significa que GLM-4.6 puede actuar como el "cerebro" de un agente de IA autónomo, decidir cuándo llamar a las API externas, cómo interpretar los resultados y cómo mantener la continuidad de la tarea entre sesiones.

4. Alineación mejorada del lenguaje natural

A través del aprendizaje de refuerzo continuo y la optimización de preferencias, GLM-4.6 ofrece Flujo de conversación más fluido, mejor correspondencia de estilos y mayor alineación de seguridadEl modelo adapta su tono y estructura para ajustarse al contexto (ya sea documentación formal, tutoría educativa o escritura creativa), mejorando la confianza y la legibilidad del usuario.

¿Qué arquitectura impulsa GLM-4.6?

¿Es GLM-4.6 un modelo de mezcla de expertos?

Continuidad del método de inferencia: El equipo de GLM indica que GLM-4.5 y GLM-4.6 comparten el mismo flujo de inferencia fundamental, lo que permite actualizar las configuraciones de implementación existentes con mínima fricción. Esto reduce el riesgo operativo para los equipos que ya utilizan GLM-4.x: parámetros de escalado y opciones de diseño de modelos que priorizan la especialización para el razonamiento agéntico, la codificación y la inferencia eficiente. El informe de GLM-4.5 ofrece la descripción pública más clara de la estrategia de MoE y el régimen de entrenamiento de la familia (preentrenamiento multietapa, iteración del modelo experto, aprendizaje de refuerzo para la alineación); GLM-4.6 aplica estas lecciones al tiempo que optimiza la longitud del contexto y las capacidades específicas de cada tarea.

Notas prácticas de arquitectura para ingenieros

- Huella de parámetros vs. cómputo activado: Los totales de parámetros grandes (cientos de miles de millones) no se traducen directamente en un costo de activación equivalente en cada solicitud: MoE significa que solo un subconjunto de expertos se activa por secuencia de tokens, lo que brinda una relación costo/rendimiento más favorable para muchas cargas de trabajo.

- Precisión y formatos de tokens: Los pesos públicos se distribuyen en formatos BF16 y F32, y las cuantificaciones comunitarias (GGUF, 4-/8-/bits) están apareciendo rápidamente; esto permite a los equipos ejecutar GLM-4.6 en perfiles de hardware variados.

- Compatibilidad de la pila de inferencia: Z.ai documenta vLLM y otros tiempos de ejecución LLM modernos como backends de inferencia compatibles, lo que hace que GLM-4.6 sea viable tanto para implementaciones en la nube como locales.

Rendimiento de referencia: ¿cómo funciona GLM-4.6?

¿Qué puntos de referencia se informaron?

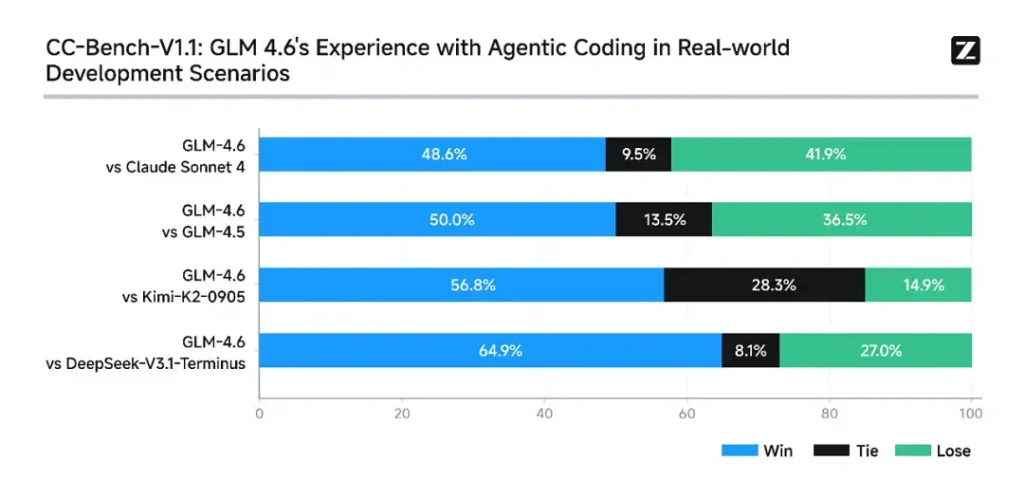

Z.ai evaluó GLM-4.6 en un conjunto de ocho puntos de referencia públicos Abarcando tareas de agencia, razonamiento y codificación. También ampliaron CC-Bench (un benchmark de codificación de tareas reales, evaluado por humanos y ejecutado en entornos aislados de Docker) para simular mejor las tareas de ingeniería de producción (desarrollo front-end, pruebas y resolución de problemas algorítmicos). En estas tareas, GLM-4.6 mostró mejoras consistentes con respecto a GLM-4.5.

Rendimiento de codificación

- Victorias en tareas reales: En las evaluaciones humanas de CC-Bench, GLM-4.6 alcanzó casi paridad con Claude Sonnet 4 de Anthropic en tareas de varios turnos cara a cara: Z.ai informa 48.6% tasa de ganancias En sus evaluaciones aisladas de Docker y evaluadas por humanos (interpretación: casi 50/50 con Claude Sonnet 4 en su conjunto seleccionado). Al mismo tiempo, GLM-4.6 superó a varios modelos nacionales abiertos (por ejemplo, variantes de DeepSeek) en sus tareas.

- Eficiencia del token: Informes de Z.ai ~15% menos tokens utilizado para finalizar tareas en comparación con GLM-4.5 en trayectorias CC-Bench (esto es importante tanto para la latencia como para el costo).

razonamiento y matematicas

GLM-4.6 afirma una capacidad de razonamiento mejorada y un rendimiento más sólido en el uso de herramientas en comparación con GLM-4.5. Mientras que GLM-4.5 priorizaba los modos híbridos de pensamiento y respuesta directa, GLM-4.6 aumenta la robustez del razonamiento multipaso, especialmente al integrarse con herramientas de búsqueda o ejecución.

Las posiciones de mensajes públicos de Z.ai posicionan a GLM-4.6 como Competitivo con los principales modelos nacionales e internacionales En sus benchmarks elegidos, específicamente, compitiendo con Claude Sonnet 4 y superando a ciertas alternativas nacionales, como las variantes de DeepSeek, en tareas de código/agente. Sin embargo, en algunos subbenchmarks específicos de codificación**, GLM-4.6 aún está por detrás de Claude Sonnet 4.5 (una versión más reciente de Anthropic), lo que convierte el panorama en una competencia reñida en lugar de un dominio absoluto.

Cómo acceder a GLM-4.6

- 1. A través de la Plataforma Z.ai: Los desarrolladores pueden acceder a GLM-4.6 directamente a través de API de Z.ai or **interfaz de chat (chat.z.ai)**Estos servicios alojados permiten una rápida experimentación e integración sin necesidad de implementación local. La API admite tanto el autocompletado de texto estándar como los modos de llamada a herramientas estructuradas, esenciales para los flujos de trabajo de agentes.

- 2. Pesas abiertas en Hugging Face y ModelScope: Para aquellos que prefieren el control local, Zhipu AI ha publicado archivos del modelo GLM-4.6 en Abrazando la cara y Alcance del modelo, incluidas las versiones con safetensors en BF16 y F32 Precisión. Los desarrolladores de la comunidad ya han producido versiones cuantificadas de GGUF, lo que permite la inferencia en GPU de consumo.

- 3. Marcos de integración: GLM-4.6 se integra sin problemas con los principales motores de inferencia como vllm, SGLang e LMDeploy, lo que lo hace adaptable a las modernas plataformas de servicio. Esta versatilidad permite a las empresas elegir entre cloud, Edge e implementación local dependiendo de los requisitos de cumplimiento o latencia.

CometAPI es una plataforma API unificada que integra más de 500 modelos de IA de proveedores líderes, como la serie GPT de OpenAI, Gemini de Google, Claude de Anthropic, Midjourney, Suno y más, en una única interfaz intuitiva para desarrolladores. Al ofrecer autenticación, formato de solicitudes y gestión de respuestas consistentes, CometAPI simplifica drásticamente la integración de las capacidades de IA en sus aplicaciones. Ya sea que esté desarrollando chatbots, generadores de imágenes, compositores musicales o canales de análisis basados en datos, CometAPI le permite iterar más rápido, controlar costos y mantenerse independiente del proveedor, todo mientras aprovecha los últimos avances del ecosistema de IA.

La última integración GLM-4.6 aparecerá pronto en CometAPI, ¡así que permanezca atento! Mientras finalizamos la carga del modelo GLM 4.6, explore nuestros otros modelos en la página de Modelos o pruébelos en AI Playground.

Los desarrolladores pueden acceder API GLM‑4.5 a través de CometAPI, la última versión del modelo Se actualiza constantemente con el sitio web oficial. Para empezar, explora las capacidades del modelo en el Playground y consultar el Guía de API Para obtener instrucciones detalladas, consulte la sección "Antes de acceder, asegúrese de haber iniciado sesión en CometAPI y de haber obtenido la clave API". CometAPI Ofrecemos un precio muy inferior al oficial para ayudarte a integrarte.

¿Listo para ir?→ Regístrate en CometAPI hoy !

Conclusión: ¿Por qué GLM-4.6 es importante ahora?

GLM-4.6 es un hito importante en la línea GLM, ya que combina mejoras prácticas para desarrolladores (ventanas de contexto más amplias, codificación específica y optimizaciones de agentes, y mejoras tangibles en los benchmarks) con la apertura y la flexibilidad del ecosistema que muchas organizaciones buscan. Para equipos que desarrollan asistentes de código, agentes de documentos extensos o automatizaciones basadas en herramientas, GLM-4.6 es una excelente opción.