GPT-5-Codex es la nueva variante de GPT-5 de OpenAI, centrada en la ingeniería, optimizada específicamente para la ingeniería de software con agentes dentro de la familia de productos Codex. Está diseñada para abordar grandes flujos de trabajo de ingeniería del mundo real: creación de proyectos completos desde cero, adición de características y pruebas, depuración, refactorización y revisión de código, todo ello mientras se interactúa con herramientas y conjuntos de pruebas externos. Esta versión representa un refinamiento específico del producto, más que un nuevo modelo fundacional: OpenAI ha integrado GPT-5-Codex en la CLI de Codex, la extensión IDE de Codex, Codex Cloud, los flujos de trabajo de GitHub y las experiencias móviles de ChatGPT. La disponibilidad de la API está prevista, pero no es inmediata.

¿Qué es GPT-5-Codex y por qué existe?

GPT-5-Codex es GPT-5 "especializado para codificación". En lugar de ser un asistente conversacional general, está optimizado y entrenado con aprendizaje de refuerzo y conjuntos de datos específicos de ingeniería para un mejor soporte de tareas de codificación iterativas asistidas por herramientas (por ejemplo, ejecutar pruebas, iterar sobre fallos, refactorizar módulos y seguir las convenciones de relaciones públicas). OpenAI lo presenta como el sucesor de las iniciativas anteriores de Codex, pero se basa en la estructura principal de GPT-5 para mejorar la profundidad de razonamiento sobre grandes bases de código y realizar tareas de ingeniería de varios pasos con mayor fiabilidad.

La motivación es práctica: los flujos de trabajo de los desarrolladores dependen cada vez más de agentes capaces de hacer más que sugerencias de fragmentos individuales. Al alinear un modelo específicamente con el ciclo de "generar → ejecutar pruebas → corregir → repetir" y con las normas de relaciones públicas de la organización, OpenAI busca crear una IA que se sienta como un compañero de equipo, en lugar de una fuente de finalizaciones puntuales. Ese cambio de "generar una función" a "entregar una característica" es el valor único del modelo.

¿Cómo está diseñado y entrenado GPT-5-Codex?

Arquitectura de alto nivel

GPT-5-Codex es una variante de la arquitectura GPT-5 (el linaje GPT-5 más amplio), en lugar de una arquitectura completamente nueva. Esto significa que hereda el diseño principal de GPT-5 basado en transformadores, las propiedades de escalado y las mejoras de razonamiento, pero añade entrenamiento específico de Codex y ajustes precisos basados en aprendizaje por refuerzo (RL) dirigidos a tareas de ingeniería de software. El apéndice de OpenAI describe que GPT-5-Codex se entrena en tareas de ingeniería complejas del mundo real y enfatiza el aprendizaje por refuerzo en entornos donde se ejecuta y valida el código.

¿Cómo fue entrenado y optimizado para el código?

El régimen de entrenamiento del GPT-5-Codex enfatiza tareas de ingeniería del mundo realUtiliza un ajuste fino de estilo aprendizaje por refuerzo en conjuntos de datos y entornos construidos a partir de flujos de trabajo tangibles de desarrollo de software: refactorizaciones multiarchivo, comparaciones de PR, ejecución de conjuntos de pruebas, sesiones de depuración y señales de revisión. El objetivo del entrenamiento es maximizar la precisión en las ediciones de código, aprobar las pruebas y generar comentarios de revisión con alta precisión y relevancia. Este enfoque diferencia a Codex del ajuste fino general basado en chat: las funciones de pérdida, los arneses de evaluación y las señales de recompensa se alinean con los resultados de ingeniería (pruebas aprobadas, comparaciones correctas, menos comentarios falsos).

Cómo es el entrenamiento “agentético”

- Ajuste fino impulsado por la ejecuciónEl modelo se entrena en contextos donde el código generado se ejecuta, prueba y evalúa. Los bucles de retroalimentación provienen de los resultados de las pruebas y las señales de preferencia humana, lo que motiva al modelo a iterar hasta que un conjunto de pruebas supera la prueba.

- Aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF):Similar en espíritu al trabajo anterior de RLHF, pero aplicado a tareas de codificación de múltiples pasos (crear PR, ejecutar pruebas, corregir fallas), por lo que el modelo aprende la asignación de crédito temporal en una secuencia de acciones.

- Contexto a escala de repositorioEl entrenamiento y la evaluación incluyen grandes repositorios y refactorizaciones, lo que ayuda al modelo a aprender razonamiento entre archivos, convenciones de nomenclatura e impactos a nivel de base de código. ()

¿Cómo gestiona GPT-5-Codex el uso de herramientas y las interacciones con el entorno?

Una característica arquitectónica clave es la capacidad mejorada del modelo para llamar y coordinar herramientas. Históricamente, Codex combinaba las salidas del modelo con un pequeño sistema de tiempo de ejecución/agente capaz de ejecutar pruebas, abrir archivos o llamar a búsquedas. GPT-5-Codex amplía esta función al aprender cuándo llamar a las herramientas e integrar mejor la retroalimentación de las pruebas en la generación posterior de código, cerrando así el ciclo entre la síntesis y la verificación. Esto se logra mediante el entrenamiento en trayectorias donde el modelo emite acciones (como "ejecutar prueba X") y condiciona las generaciones posteriores a las salidas de las pruebas y las comparaciones.

¿Qué puede hacer realmente GPT-5-Codex? ¿Cuáles son sus características?

Una de las innovaciones de producto que definen es duración del pensamiento adaptativoGPT-5-Codex ajusta la cantidad de razonamiento oculto que realiza: las solicitudes triviales se ejecutan de forma rápida y económica, mientras que las refactorizaciones complejas o las tareas de larga duración permiten al modelo "pensar" durante mucho más tiempo. Al mismo tiempo, para turnos pequeños e interactivos, el modelo consume muchos menos tokens que una instancia GPT-5 de propósito general, ahorrando un 93.7 % de tokens (incluyendo inferencia y salida) en comparación con GPT-5. Esta estrategia de razonamiento variable está diseñada para producir respuestas ágiles cuando es necesario y una ejecución profunda y exhaustiva cuando se justifica.

Capacidades principales

- Generación y arranque de proyectos: Cree esqueletos de proyectos completos con CI, pruebas y documentación básica a partir de indicaciones de alto nivel.

- Pruebas y iteraciones de Agentic: Genere código, ejecute pruebas, analice fallas, aplique parches al código y vuelva a ejecutarlo hasta que las pruebas pasen, automatizando de manera efectiva partes del ciclo de edición → prueba → reparación de un desarrollador.

- Refactorización a gran escala: Realice refactorizaciones sistemáticas en varios archivos, manteniendo el comportamiento y las pruebas. Este es un área de optimización establecida para GPT-5-Codex frente a GPT-5 genérico.

- Revisión de código y generación de PR: Producir descripciones de relaciones públicas, cambios sugeridos con diferencias y comentarios de revisión que se alineen con las convenciones del proyecto y las expectativas de revisión humana.

- Razonamiento de código de contexto amplio: Mejor para navegar y razonar sobre bases de código de múltiples archivos, gráficos de dependencia y límites de API en comparación con los modelos de chat genéricos.

- Entradas y salidas visuales: Al trabajar en la nube, GPT-5-Codex puede aceptar imágenes/capturas de pantalla, inspeccionar visualmente el progreso y adjuntar artefactos visuales (capturas de pantalla de la IU creada) a las tareas: una ventaja práctica para la depuración del frontend y los flujos de trabajo de control de calidad visual.

Integraciones de editores y flujos de trabajo

Codex está profundamente integrado en los flujos de trabajo de los desarrolladores:

- Codex CLI — Interacción con el terminal como prioridad, compatible con capturas de pantalla, seguimiento de tareas pendientes y aprobaciones de agentes. La CLI es de código abierto y está optimizada para flujos de trabajo de codificación con agentes.

- Extensión IDE de Codex — integra el agente en VS Code (y bifurcaciones) para que pueda obtener una vista previa de las diferencias locales, crear tareas en la nube y mover trabajo entre la nube y los contextos locales con el estado preservado.

- Nube de Codex / GitHub — Las tareas en la nube se pueden configurar para revisar automáticamente las solicitudes de relaciones públicas, generar contenedores temporales para pruebas y adjuntar registros de tareas y capturas de pantalla a los hilos de solicitudes de relaciones públicas.

Limitaciones y desventajas notables

- Optimización estrecha:Algunas evaluaciones de producción no codificantes son levemente inferiores para GPT-5-Codex que para la variante general de GPT-5, lo que constituye un recordatorio de que la especialización puede comprometer la generalidad.

- Confianza en las pruebasEl comportamiento de la agencia depende de las pruebas automatizadas disponibles. Las bases de código con poca cobertura de pruebas expondrán limitaciones en la verificación automática y podrían requerir supervisión humana.

¿En qué tipos de tareas es especialmente bueno o malo el GPT-5-Codex?

Bueno en: refactorizaciones complejas, creación de andamiajes para proyectos grandes, redacción y corrección de pruebas, seguimiento de las expectativas de relaciones públicas y diagnóstico de problemas de ejecución de múltiples archivos.

Menos bueno en: Tareas que requieren conocimiento interno actualizado o exclusivo que no se proporciona en el espacio de trabajo, o aquellas que exigen una corrección de alta seguridad sin revisión humana (los sistemas críticos para la seguridad aún requieren expertos). Las revisiones independientes también indican un panorama heterogéneo sobre la calidad del código bruto en comparación con otros modelos de codificación especializados: las fortalezas de los flujos de trabajo de agencia no se traducen uniformemente en una corrección excepcional en todos los parámetros.

¿Qué revelan los puntos de referencia sobre el rendimiento de GPT-5-Codex?

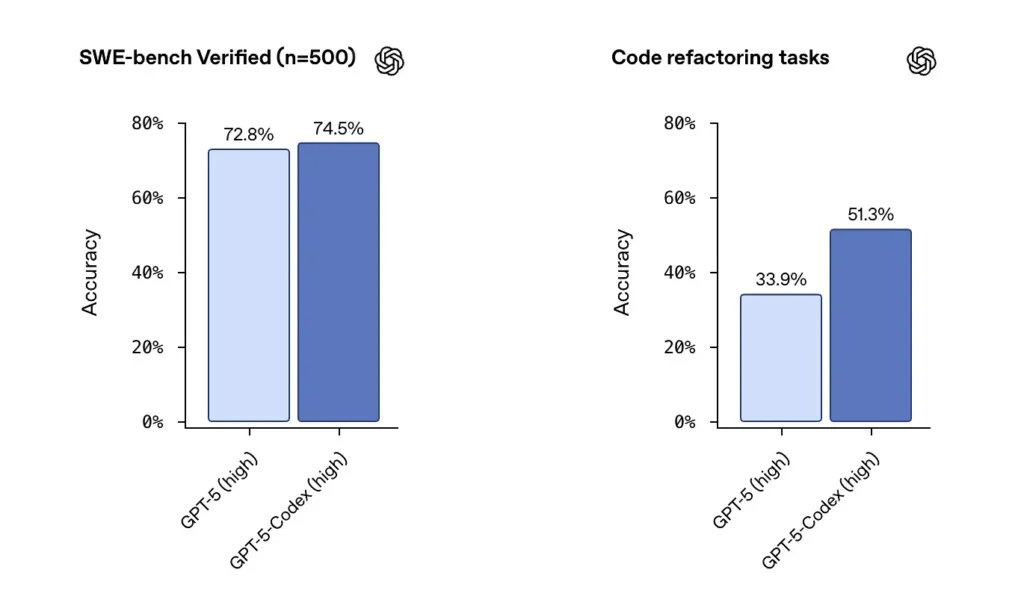

Banco SWE / Banco SWE verificadoOpenAI afirma que GPT-5-Codex supera a GPT-5 en pruebas de referencia de codificación de agentes, como SWE-bench Verified, y muestra mejoras en tareas de refactorización de código extraídas de grandes repositorios. En el conjunto de datos de SWE-bench Verified, que contiene 500 tareas de ingeniería de software reales, GPT-5-Codex alcanzó una tasa de éxito del 74.5 %. Esto supera el 5 % de GPT-72.8 en la misma prueba de referencia, lo que destaca las capacidades mejoradas del agente. 500 tareas de programación de proyectos reales de código abierto. Anteriormente, solo se podían probar 477 tareas, pero ahora se pueden probar las 500 tareas → resultados más completos.

Desde las configuraciones anteriores de GPT-5 hasta GPT-5-Codex, las puntuaciones de evaluación de la refactorización de código aumentaron considerablemente: cifras como el cambio de ~34 % a ~51 % en una métrica de refactorización específica de alta verbosidad se destacaron en los primeros análisis). Estas mejoras son significativas porque reflejan una mejora en refactorizaciones grandes y realistas en lugar de ejemplos de juguetes, pero aún quedan salvedades sobre la reproducibilidad y el arnés de prueba exacto.

¿Cómo pueden los desarrolladores y equipos acceder a GPT-5-Codex?

OpenAI ha integrado GPT-5-Codex en las interfaces de producto de Codex: está disponible dondequiera que Codex se ejecute actualmente (por ejemplo, la CLI de Codex y las experiencias integradas de Codex). Para los desarrolladores que utilizan Codex mediante la CLI y el inicio de sesión en ChatGPT, la experiencia actualizada de Codex mostrará el modelo GPT-5-Codex. OpenAI ha anunciado que el modelo estará disponible en la API más amplia "próximamente" para quienes utilicen claves de API, pero, en el lanzamiento inicial, la principal vía de acceso es a través de las herramientas de Codex, en lugar de un punto final de API público.

Codex CLI

Permite que Codex revise los borradores de solicitudes de aprobación en un repositorio aislado para que puedas evaluar la calidad de los comentarios sin riesgo. Usa los modos de aprobación con moderación.

- Rediseñado en torno a un flujo de trabajo de codificación agente.

- La compatibilidad para adjuntar imágenes (como wireframes, diseños y capturas de pantalla de errores de UI) proporciona contexto para los modelos.

- Se agregó una función de lista de tareas para realizar un seguimiento del progreso de tareas complejas.

- Se proporcionó soporte para herramientas externas (búsqueda web, conexión MCP).

- La nueva interfaz de terminal mejora la invocación de herramientas y el formato de diferencias, y el modo de permiso se ha simplificado a tres niveles (solo lectura, automático y acceso completo).

Extensión IDE

Integrar en flujos de trabajo IDE: Agregue la extensión Codex IDE para desarrolladores que desean vistas previas en línea y una iteración más rápida. Mover tareas entre la nube y el entorno local con contexto preservado puede reducir la fricción en funciones complejas.

- Admite VS Code, Cursor y más.

- Invoque Codex directamente desde el editor para aprovechar el contexto del archivo y el código actualmente abiertos para obtener resultados más precisos.

- Cambie tareas sin problemas entre entornos locales y en la nube, manteniendo la continuidad contextual.

- Vea y trabaje con los resultados de las tareas en la nube directamente en el editor, sin cambiar de plataforma.

Integración de GitHub y Cloud Functions

- Revisión automatizada de relaciones públicas: activa automáticamente el progreso desde el borrador hasta la versión lista.

- Permite a los desarrolladores solicitar revisiones específicas directamente en la sección @codex de una PR.

- Infraestructura en la nube significativamente más rápida: reduzca los tiempos de respuesta de las tareas en un 90 % mediante el almacenamiento en caché de contenedores.

- Configuración automatizada del entorno: ejecuta scripts de configuración e instala dependencias (por ejemplo, pip install).

- Ejecuta automáticamente un navegador, verifica las implementaciones del frontend y adjunta capturas de pantalla a las tareas o solicitudes de incorporación de cambios.

¿Cuáles son las consideraciones de seguridad, protección y limitación?

OpenAI enfatiza múltiples capas de mitigación para los agentes del Codex:

- Entrenamiento a nivel de modelo: Entrenamiento de seguridad específico para resistir inyecciones inmediatas y limitar conductas dañinas o de alto riesgo.

- Controles a nivel de producto: Comportamiento predeterminado en un entorno aislado, acceso a la red configurable, modos de aprobación para ejecutar comandos, registros de terminales y citaciones para la trazabilidad, y la capacidad de requerir aprobaciones humanas para acciones sensibles. OpenAI también ha publicado un anexo de tarjeta de sistema que describe estas mitigaciones y sus evaluaciones de riesgos, especialmente para las capacidades de los dominios biológico y químico.

Estos controles reflejan el hecho de que un agente capaz de ejecutar comandos e instalar dependencias tiene una superficie de ataque y un riesgo en el mundo real: el enfoque de OpenAI es combinar el entrenamiento del modelo con las restricciones del producto para limitar el uso indebido.

¿Cuáles son las limitaciones conocidas?

- No es un sustituto de los revisores humanos: OpenAI recomienda explícitamente Codex como una adicional Revisor, no un sustituto. La supervisión humana sigue siendo crucial, especialmente para las decisiones de seguridad, licencias y arquitectura.

- Los puntos de referencia y las afirmaciones requieren una lectura atenta: Los revisores han señalado diferencias en los subconjuntos de evaluación, la configuración de verbosidad y las compensaciones de costos al comparar modelos. Las primeras pruebas independientes sugieren resultados mixtos: Codex muestra un sólido comportamiento de agencia y mejoras en la refactorización, pero la precisión relativa en comparación con otros proveedores varía según el punto de referencia y la configuración.

- Alucinaciones y comportamiento inestable: Como todos los LLM, Codex puede alucinar (inventar URL, tergiversar gráficos de dependencia), y sus ejecuciones de agente de varias horas aún pueden presentar vulnerabilidades en casos extremos. Se espera validar sus resultados con pruebas y revisión humana.

¿Cuáles son las implicaciones más amplias para la ingeniería de software?

GPT-5-Codex demuestra un cambio de maduración en el diseño de LLM: en lugar de solo mejorar las capacidades básicas del lenguaje, los proveedores están optimizando comportamiento Para tareas largas y con agentes (ejecución de varias horas, desarrollo basado en pruebas, canales de revisión integrados). Esto cambia la unidad de productividad de un único fragmento generado a la terminación de la tarea — la capacidad del modelo para tomar un ticket, ejecutar un conjunto de pruebas y producir iterativamente una implementación validada. Si estos agentes se vuelven robustos y bien gobernados, transformarán los flujos de trabajo (menos refactorizaciones manuales, ciclos de relaciones públicas más rápidos, tiempo de desarrollo enfocado en el diseño y la estrategia). Sin embargo, la transición requiere un diseño de procesos cuidadoso, supervisión humana y gobernanza de la seguridad.

Conclusión: ¿Qué debemos recordar?

GPT-5-Codex es un paso enfocado hacia grado de ingeniero LLM: una variante de GPT-5 entrenada, optimizada y desarrollada para actuar como un agente de codificación competente dentro del ecosistema Codex. Aporta nuevos comportamientos tangibles (tiempo de razonamiento adaptativo, largas ejecuciones autónomas, ejecución integrada en un entorno aislado y mejoras específicas en la revisión de código), manteniendo las limitaciones habituales de los modelos de lenguaje (la necesidad de supervisión humana, los matices de la evaluación y las alucinaciones ocasionales). Para los equipos, la vía prudente es la experimentación mesurada: realizar pruebas piloto en repositorios seguros, supervisar las métricas de resultados e integrar el agente en los flujos de trabajo de los revisores de forma gradual. A medida que OpenAI amplía el acceso a las API y proliferan los benchmarks de terceros, cabe esperar comparaciones más claras y directrices más concretas sobre costes, precisión y gobernanza de las mejores prácticas.

Primeros Pasos

CometAPI es una plataforma de API unificada que integra más de 500 modelos de IA de proveedores líderes, como la serie GPT de OpenAI, Google Gemini, Claude de Anthropic, Midjourney, Suno y más, en una única interfaz intuitiva para desarrolladores. Al ofrecer autenticación, formato de solicitudes y gestión de respuestas consistentes, CometAPI simplifica drásticamente la integración de las capacidades de IA en sus aplicaciones. Ya sea que esté desarrollando chatbots, generadores de imágenes, compositores musicales o canales de análisis basados en datos, CometAPI le permite iterar más rápido, controlar costos y mantenerse independiente del proveedor, todo mientras aprovecha los últimos avances del ecosistema de IA.

Los desarrolladores pueden acceder API del códice GPT-5 A través de CometAPI, los modelos más recientes de cometAPI se listan a la fecha de publicación del artículo. Antes de acceder, asegúrese de haber iniciado sesión en CometAPI y obtenido la clave API.