Kimi K2 representa un avance significativo en los modelos de lenguaje de código abierto de gran tamaño, combinando una arquitectura de vanguardia de expertos mixtos con capacitación especializada para tareas de agencia. A continuación, exploramos sus orígenes, diseño, rendimiento y consideraciones prácticas para su acceso y uso.

¿Qué es Kimi K2?

Kimi K2 es un modelo de lenguaje de mezcla de expertos (MoE) con un billón de parámetros, desarrollado por Moonshot AI. Cuenta con 32 mil millones de parámetros "activados" (aquellos que se utilizan por token) y un recuento total de parámetros expertos de 1 billón, lo que permite una capacidad masiva sin costos de inferencia lineal. Desarrollado con el optimizador Muon, Kimi K2 se entrenó con más de 15.5 billones de tokens, logrando estabilidad a escalas que antes se consideraban imprácticas. El modelo se ofrece en dos variantes principales:

Kimi‑K2‑Instrucciones: Preajustado para aplicaciones conversacionales y de agencia, listo para implementación inmediata en sistemas de diálogo y flujos de trabajo habilitados por herramientas.

Kimi‑K2‑Base: Un modelo de base adecuado para la investigación, el ajuste personalizado y la experimentación de bajo nivel.

¿Cómo funciona su arquitectura?

- Mezcla de expertos (MoE): En cada capa, un mecanismo de control selecciona un pequeño subconjunto de expertos (8 de 384) para procesar cada token, lo que reduce drásticamente el procesamiento para inferencia y al mismo tiempo mantiene una enorme base de conocimiento.

- Capas especializadas: Incorpora una única capa densa junto con 61 capas en total, con 64 cabezales de atención y dimensiones ocultas diseñadas para la eficiencia de MoE.

- Contexto y vocabulario: Admite hasta 128 K tokens en longitud de contexto y un vocabulario de 160 K tokens, lo que permite la comprensión y generación de formatos largos.

¿Por qué es importante Kimi K2?

Kimi K2 expande las fronteras de la IA de código abierto al ofrecer un rendimiento equivalente al de los modelos propietarios líderes, particularmente en evaluaciones comparativas de codificación y razonamiento.

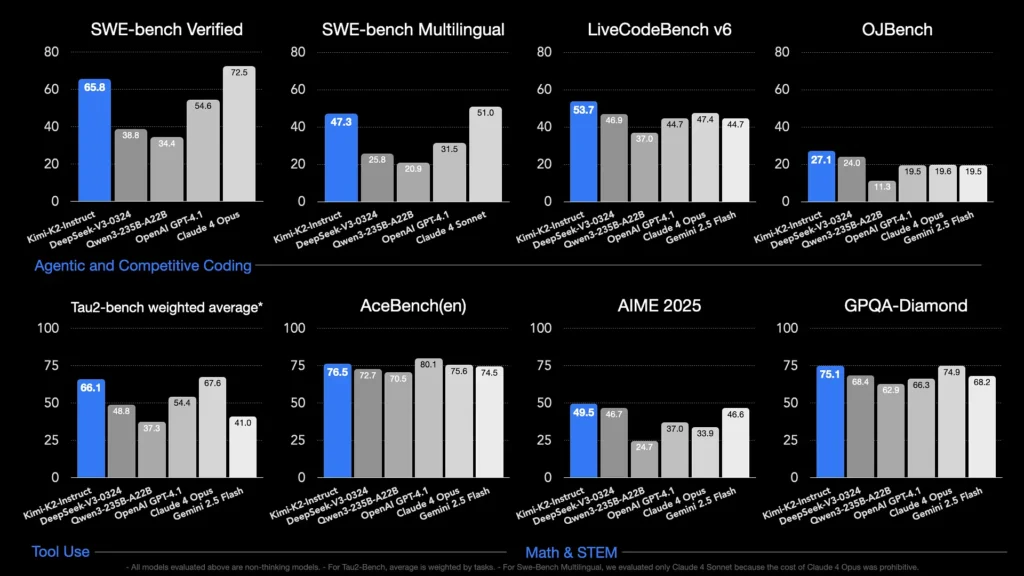

¿Qué puntos de referencia muestran sus capacidades?

- LiveCodeBench v6: Logra una tasa de aprobación del 1%, liderando los modelos de código abierto y rivalizando con sistemas cerrados como GPT-53.7 (4.1%).

- Verificado por SWE-bench: Obtiene un puntaje de 65.8%, superando el 4.1% de GPT‑54.6 y quedando solo detrás de Claude Sonnet 4 en pruebas de comparación disponibles públicamente.

- MultiPL‑E y OJBench: Demuestra una sólida capacidad de codificación multilingüe (85.7 % en MultiPL-E) y un rendimiento confiable en los desafíos de programación del mundo real.

- Matemáticas-500:Alcanza el 97.4%, superando el 4.1% de GPT-92.4, lo que demuestra su destreza en el razonamiento matemático formal.

¿Cómo se optimiza para tareas de agencia?

Más allá de la generación de datos sin procesar, Kimi K2 se entrenó con escenarios sintéticos de uso de herramientas (datos del Protocolo de Contexto de Modelo ) para llamar a herramientas externas, analizar procesos de varios pasos y resolver problemas de forma autónoma. Esto lo hace especialmente apto en entornos como Cline, donde puede orquestar la ejecución de código, la interacción con API y la automatización del flujo de trabajo sin problemas.

¿Cómo puedo acceder a Kimi K2?

Las opciones de acceso abarcan plataformas oficiales, distribuciones de código abierto e integraciones de terceros, satisfaciendo las necesidades de investigación, desarrollo y empresariales.

Plataforma oficial de inteligencia artificial de Moonshot

Moonshot AI ofrece inferencia alojada a través de su plataforma, lo que proporciona acceso API de baja latencia a las variantes Kimi-K2-Base y Kimi-K2-Instruct. El precio se basa en el consumo de cómputo, y los planes empresariales incluyen soporte prioritario e implementaciones locales. Los usuarios pueden registrarse en el sitio web de Moonshot AI y obtener sus claves API para una integración inmediata.

CometAPI

CometAPI ya ha integrado K2 en su oferta. Combina la inferencia de K2 con infraestructura de GPU administrada, garantías de SLA y niveles de precios escalables, lo que permite a las organizaciones elegir entre el pago por uso de la API o la reserva de capacidad con descuentos por volumen.

CometAPI es una plataforma API unificada que integra más de 500 modelos de IA de proveedores líderes, como la serie GPT de OpenAI, Gemini de Google, Claude de Anthropic, Midjourney, Suno y más, en una única interfaz intuitiva para desarrolladores. Al ofrecer autenticación, formato de solicitudes y gestión de respuestas consistentes, CometAPI simplifica drásticamente la integración de las capacidades de IA en sus aplicaciones.

Los desarrolladores pueden acceder API de Kimi K2(kimi-k2-0711-preview)a través de CometAPIPara comenzar, explore las capacidades del modelo en el Playground y consultar el Guía de APIPara obtener instrucciones detalladas, consulte la sección "Antes de acceder, asegúrese de haber iniciado sesión en CometAPI y de haber obtenido la clave API".

Integraciones de herramientas de terceros

- Clina: Un IDE popular centrado en código que admite de forma nativa Kimi K2 a través de

cline:moonshotai/kimi-k2proveedor, que ofrece a los desarrolladores acceso con un solo clic al chat, la generación de código y los flujos de trabajo de agentes dentro de su editor. - Espacios para abrazar la cara: Las demostraciones alojadas por la comunidad y las interfaces de usuario minimalistas permiten a los usuarios interactuar con los modelos de K2-Instruct directamente en el navegador. Se requiere una cuenta de Hugging Face y el rendimiento puede variar según los recursos compartidos del backend.

¿Cómo utilizar Kimi K2?

Una vez que haya elegido un método de acceso, puede emplear K2 para una variedad de tareas, desde chat hasta ejecución de código y agentes autónomos.

A través de API o SDK de la plataforma

- Authenticate: Recupere su clave API de Moonshot AI o CometAPI.

- Inicializar cliente: Utilice el SDK oficial (Python/JavaScript) o solicitudes HTTP estándar.

- Elija la variante del modelo:

- Kimi-K2-Base para puesta a punto e investigación.

- Kimi-K2-Instruct para chat y agentes plug-and-play.

- Modelo de CometAPI:

kimi-k2-0711-preview

- Enviar indicaciones: Formatee las entradas según la plantilla de chat (sistema, usuario, roles de asistente) para aprovechar un comportamiento optimizado de seguimiento de instrucciones.

Ejecutándose localmente con llama.cpp

Para configuraciones fuera de línea o autoalojadas, utilice los pesos GGUF cuantificados por Unsloth (245 GB para cuantificación dinámica de 1.8 bits).

- Descargar pesos: Del repositorio GitHub o Hugging Face de Moonshot AI.

- Instalar llama.cpp: Asegúrese de tener suficiente disco (≥ 250 GB) y RAM+VRAM combinadas (≥ 250 GB) para un rendimiento de ~5 tokens/s.

- Modelo de lanzamiento:

./main --model kimi-k2-gguf.q8_0 --prompt "Your prompt here" - Ajuste la configuración: Utilice los parámetros recomendados (

rope_freq_base,context_len) documentado en la guía de Unsloth para un rendimiento estable.

Integraciones con herramientas de desarrollo

- Complementos IDE: Varios complementos de la comunidad habilitan K2 en los IDE de VS Code, Neovim y JetBrains. La configuración suele implicar especificar el punto final de la API y el ID del modelo en la configuración.

- Marcos de automatización: Aproveche el núcleo agente de K2 con marcos como LangChain o Haystack para encadenar indicaciones, llamadas API y pasos de ejecución de código en automatizaciones complejas.

¿Cuáles son los casos de uso típicos de Kimi K2?

La combinación de escala, capacitación agente y acceso abierto de K2 lo hace versátil en todos los dominios.

Asistencia de codificación

Desde la generación de código repetitivo y la refactorización hasta la corrección de errores y la creación de perfiles de rendimiento, los puntos de referencia de codificación SOTA de K2 se traducen en ganancias de productividad en el mundo real, que a menudo superan a las alternativas en legibilidad y simplicidad.

Conocimiento y razonamiento

Con una longitud de contexto de 128 K, K2 gestiona documentos extensos, preguntas y respuestas multidocumento y razonamiento en cadena. Su arquitectura MoE garantiza la retención de conocimiento diverso sin olvidos catastróficos.

Flujos de trabajo de agentes

K2 se destaca en la orquestación de tareas de varios pasos (obtener datos, invocar API, actualizar bases de código y resumir resultados), lo que lo hace ideal para asistentes autónomos en atención al cliente, análisis de datos y DevOps.

¿Cómo se compara Kimi K2 con otros modelos de código abierto?

Si bien los recientes lanzamientos abiertos de V3 y Meta de DeepSeek dominaron los titulares a principios de 2025, Kimi K2 se diferencia por:

Inteligencia Agente

Kimi K2 se diseñó específicamente para flujos de trabajo "agenticos": automatiza tareas mediante llamadas a herramientas, comandos de shell, automatización web e integraciones de API. Su conjunto de datos de entrenamiento, con autoejecución y aumento de rendimiento, incluye diversos ejemplos de llamadas a herramientas, lo que permite una integración fluida con sistemas del mundo real.

Reducción de costes

Con un costo de inferencia por token aproximadamente entre un 80 % y un 90 % menor en comparación con modelos como Claude Sonnet 4, Kimi K2 ofrece un rendimiento de nivel empresarial sin precios exorbitantes, lo que cataliza una rápida adopción entre los desarrolladores sensibles a los precios.

Licencias y accesibilidad

A diferencia de ciertas versiones de código abierto sujetas a licencias restrictivas, Kimi K2 está disponible bajo una licencia permisiva que permite el uso comercial, trabajos derivados e implementaciones locales, alineándose con el espíritu de código abierto de Moonshot AI.

- Al combinar un diseño de vanguardia de MoE, un riguroso entrenamiento de agentes y la disponibilidad de código abierto, Kimi K2 permite a desarrolladores e investigadores crear aplicaciones inteligentes y autónomas sin costos prohibitivos ni ecosistemas cerrados. Ya sea que esté escribiendo código, creando flujos de trabajo complejos de varios pasos o experimentando con razonamiento a gran escala, K2 ofrece una base versátil y de alto rendimiento.