¿Qué es Llama 4?

Meta Platforms ha presentado su última suite de modelos de lenguaje de gran tamaño (LLM) bajo la serie Llama 4, lo que marca un avance significativo en la tecnología de inteligencia artificial. La colección Llama 4 presenta dos modelos principales en abril de 2025: Llama 4 Scout y Llama 4 Maverick. Estos modelos están diseñados para procesar y traducir diversos formatos de datos, incluyendo texto, video, imágenes y audio, demostrando sus capacidades multimodales. Además, Meta ha presentado una vista previa de Llama 4 Behemoth, un próximo modelo considerado uno de los LLM más potentes hasta la fecha, diseñado para facilitar el entrenamiento de futuros modelos.

¿En qué se diferencia Llama 4 de los modelos anteriores?

Capacidades multimodales mejoradas

A diferencia de sus predecesores, Llama 4 está diseñado para gestionar múltiples modalidades de datos sin problemas. Esto significa que puede analizar y generar respuestas basadas en texto, imágenes, vídeos y audio, lo que lo hace altamente adaptable a diversas aplicaciones.

Introducción de modelos especializados

Meta ha introducido dos versiones especializadas dentro de la serie Llama 4:

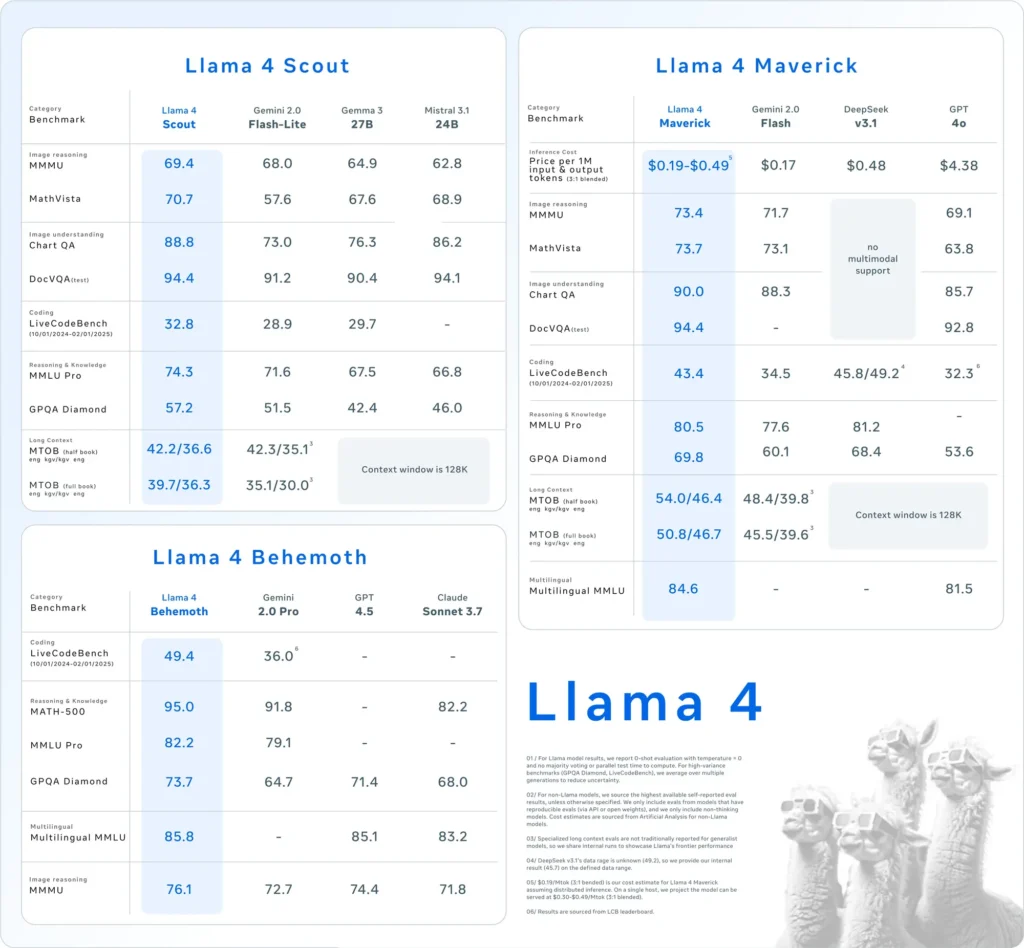

- Llama 4 ScoutUn modelo compacto optimizado para funcionar eficientemente con una sola GPU Nvidia H100. Cuenta con una ventana de contexto de 10 millones de tokens y ha demostrado un rendimiento superior al de competidores como Gemma 3 y Mistral 3.1 de Google en diversas pruebas de rendimiento.

- Llama 4 Maverick:Un modelo más grande comparable en rendimiento a GPT-4o y DeepSeek-V3 de OpenAI, que se destaca particularmente en tareas de codificación y razonamiento al utilizar menos parámetros activos.

Además, Meta está desarrollando Llama 4 Behemoth, un modelo con 288 mil millones de parámetros activos y un total de 2 billones, que apunta a superar modelos como GPT-4.5 y Claude Sonnet 3.7 en los puntos de referencia STEM.

Adopción de la arquitectura de mezcla de expertos (MoE)

Llama 4 emplea una arquitectura de "mezcla de expertos" (MoE), que divide el modelo en unidades especializadas para optimizar el uso de recursos y mejorar el rendimiento. Este enfoque permite un procesamiento más eficiente al activar únicamente subconjuntos relevantes del modelo para tareas específicas.

¿Cómo se compara Llama 4 con otros modelos de IA?

Llama 4 se posiciona competitivamente entre los modelos líderes de IA:

- Puntos de referencia de rendimiento:El rendimiento de Llama 4 Maverick está a la par con GPT-4o y DeepSeek-V3 de OpenAI en tareas de codificación y razonamiento, mientras que Llama 4 Scout supera a modelos como Gemma 3 y Mistral 3.1 de Google en varios puntos de referencia.

- Enfoque de código abiertoMeta continúa ofreciendo modelos de Llama en código abierto, lo que promueve una mayor colaboración e integración entre plataformas. Sin embargo, la licencia de Llama 4 impone restricciones a las entidades comerciales con más de 700 millones de usuarios, lo que genera debates sobre la verdadera apertura del modelo.

| Categoría: | Llama 4 Maverick | GPT-4o | Géminis 2.0 Flash | Búsqueda profunda v3.1 | |

|---|---|---|---|---|---|

| Razonamiento de imágenes | MMMU | 73.4 | 69.1 | 71.7 | Sin soporte multimodal |

| MatemáticasVista | 73.7 | 63.8 | 73.1 | Sin soporte multimodal | |

| Comprensión de la imagen | Gráfico de control de calidad | 90.0 | 85.7 | 88.3 | Sin soporte multimodal |

| DocVQA (prueba) | 94.4 | 92.8 | – | Sin soporte multimodal | |

| Codificación | Banco de código en vivo | 43.4 | 32.3 | 34.5 | 45.8/49.2 |

| Razonamiento y conocimiento | MMLU Pro | 80.5 | – | 77.6 | 81.2 |

| Diamante GPQA | 69.8 | 53.6 | 60.1 | 68.4 | |

| Multilingüe | MMLU multilingüe | 84.6 | 81.5 | – | – |

| Contexto largo | MTOB (medio libro) eng→kgv/kgv→eng | 54.0/46.4 | Contexto limitado a 128K | 48.4/39.8 | Contexto limitado a 128K |

| MTOB (libro completo) eng→kgv/kgv→eng | 50.8/46.7 | Contexto limitado a 128K | 45.5/39.6 | Contexto limitado a 128K |

¿Cómo se desempeña Llama 4 en las pruebas comparativas?

Las evaluaciones comparativas brindan información sobre el rendimiento de los modelos Llama 4:

- Llama 4 ScoutEste modelo supera a varios competidores, como Gemma 3 y Mistral 3.1 de Google, en diversas pruebas de rendimiento. Su capacidad para operar con una ventana de contexto de 10 millones de tokens en una sola GPU destaca su eficiencia y eficacia al gestionar tareas complejas.

- Llama 4 MaverickCon un rendimiento comparable al de GPT-4o y DeepSeek-V3 de OpenAI, Llama 4 Maverick destaca en tareas de codificación y razonamiento, utilizando menos parámetros activos. Esta eficiencia no se reduce a la capacidad, lo que lo convierte en un sólido competidor en el ámbito de LLM.

- Llama 4 BehemothCon 288 mil millones de parámetros activos y un total de 2 billones, Llama 4 Behemoth supera a modelos como GPT-4.5 y Claude Sonnet 3.7 en las pruebas STEM. Su amplio recuento de parámetros y rendimiento indican su potencial como modelo fundamental para futuros desarrollos de IA.

Estos resultados de referencia subrayan la dedicación de Meta para avanzar en las capacidades de IA y posicionar la serie Llama 4 como un jugador formidable en el campo.

¿Cómo pueden los usuarios acceder a Llama 4?

Meta ha integrado los modelos Llama 4 en su asistente de IA, haciéndolos accesibles en plataformas como WhatsApp, Messenger, Instagram y la web. Esta integración permite a los usuarios experimentar las funciones mejoradas de Llama 4 en aplicaciones conocidas.

Para desarrolladores e investigadores interesados en aprovechar Llama 4 para aplicaciones personalizadas, Meta proporciona acceso a los pesos del modelo a través de plataformas como Hugging Face y sus propios canales de distribución. Este enfoque de código abierto permite a la comunidad de IA innovar y desarrollar las capacidades de Llama 4.

Es importante tener en cuenta que, si bien Llama 4 se comercializa como código abierto, la licencia impone restricciones a las entidades comerciales con más de 700 millones de usuarios. Las organizaciones deben revisar los términos de la licencia para garantizar el cumplimiento de las directrices de Meta.

Construye rápido con Llama 4 en CometAPI

CometAPI proporciona acceso a más de 500 modelos de IA, incluyendo modelos multimodales especializados y de código abierto para chat, imágenes, código y más. Su principal ventaja reside en simplificar el proceso, tradicionalmente complejo, de integración de IA. Al centralizar la agregación de API en una sola plataforma, ahorra a los usuarios tiempo y recursos valiosos que, de otro modo, se dedicarían a gestionar plataformas y proveedores independientes. Con CometAPI, se puede acceder a herramientas de IA líderes como Claude, OpenAI, Deepseek y Gemini mediante una única suscripción unificada. Puedes usar la API de CometAPI para crear música y material gráfico, generar vídeos y crear tus propios flujos de trabajo.

CometAPI Ofrecemos un precio mucho más bajo que el precio oficial para ayudarte a integrarte API de Llama 4¡Recibirás $1 en tu cuenta después de registrarte e iniciar sesión! Bienvenido a registrarte y a experimentar CometAPI. CometAPI paga por uso.API de Llama 4 En CometAPI los precios se estructuran de la siguiente manera:

| Categoría: | llama-4-disidente | llama-4-explorador |

| Precios de API | Tokens de entrada: $0.48/M tokens | Tokens de entrada: $0.216 / M tokens |

| Tokens de salida: $1.44/M tokens | Tokens de salida: $1.152/M tokens |

- Por favor, consulte API de Llama 4 Para detalles de integración.

- Para obtener información sobre el modelo publicado en Comet API, consulte https://api.cometapi.com/new-model.

- Para obtener información sobre el precio del modelo en Comet API, consulte https://api.cometapi.com/pricing

Empieza a construir CometAPI hoy: regístrate Aquí para acceder gratis o escalar sin límites de velocidad actualizándose a una Plan de pago de CometAPI.

¿Cuáles son las implicaciones del lanzamiento de Llama 4?

Integración entre metaplataformas

Llama 4 está integrado en el asistente de inteligencia artificial de Meta en plataformas como WhatsApp, Messenger, Instagram y la web, mejorando las experiencias del usuario con capacidades de inteligencia artificial avanzadas.

Impacto en la industria de la IA

El lanzamiento de Llama 4 subraya la fuerte apuesta de Meta por la IA, con planes de invertir hasta 65 XNUMX millones de dólares en la expansión de su infraestructura. Esta decisión refleja la creciente competencia entre los gigantes tecnológicos por liderar la innovación en IA.

Consideraciones sobre el consumo de energía

Los considerables recursos computacionales requeridos por Llama 4 plantean inquietudes sobre el consumo energético y la sostenibilidad. Operar un clúster de más de 100,000 XNUMX GPU requiere un consumo energético considerable, lo que genera debates sobre el impacto ambiental de los modelos de IA a gran escala.

¿Qué le depara el futuro a Llama 4?

Meta planea discutir futuros desarrollos y aplicaciones de Llama 4 en la próxima conferencia LlamaCon el 29 de abril de 2025. La comunidad de IA anticipa conocimientos sobre las estrategias de Meta para abordar los desafíos actuales y aprovechar las capacidades de Llama 4 en varios sectores.

En resumen, Llama 4 representa un avance significativo en los modelos de lenguaje de IA, ofreciendo capacidades multimodales mejoradas y arquitecturas especializadas. A pesar de los desafíos de desarrollo, las importantes inversiones e iniciativas estratégicas de Meta posicionan a Llama 4 como un competidor formidable en el cambiante panorama de la IA.