La IA para la edición de imágenes ha pasado de ser un simple juguete a una herramienta de flujo de trabajo real en meses, no años. Si necesitas eliminar fondos, intercambiar caras, conservar un personaje en diferentes tomas o realizar composiciones de varios pasos con indicaciones en lenguaje natural, varios modelos nuevos prometen hacerlo más rápido y con menos correcciones manuales. En esta publicación, comparo tres de las herramientas de las que se habla mucho ahora mismo: Imagen GPT-1 de OpenAI, Qwen-Image Edit,el viral Nano plátano modelos (Gemini-2.5-Flash-Image), y Flux KontextAnalizaré en qué es bueno cada uno, dónde falla y daré una recomendación práctica dependiendo de lo que quieras lograr.

¿Cuáles son las capacidades principales que definen la excelencia en la IA de imágenes?

La "mejor" depende de tus necesidades. Mi evaluación utiliza siete criterios prácticos. Antes de analizar los modelos individuales, es crucial comprender las capacidades fundamentales que definen la excelencia en la IA para la generación y edición de imágenes. Estas se pueden clasificar, a grandes rasgos, en:

- Generación de Calidad y Fidelidad: Esto se refiere a la capacidad de la IA para producir imágenes altamente realistas, estéticamente agradables y coherentes a partir de indicaciones de texto. Los factores incluyen el detalle, la iluminación, la composición y la ausencia de artefactos o distorsiones.

- Versatilidad y precisión en la edición: Más allá de la generación inicial, una IA superior debe ofrecer funciones de edición robustas. Esto incluye la restauración (rellenar partes faltantes), la superposición (extender imágenes), la eliminación/adición de objetos, la transferencia de estilos y un control preciso sobre elementos específicos.

- Velocidad y eficiencia: En flujos de trabajo profesionales, el tiempo necesario para generar o editar imágenes es fundamental. Un procesamiento más rápido sin sacrificar la calidad es una ventaja significativa.

- Experiencia de usuario y accesibilidad: Una interfaz intuitiva, controles claros y facilidad de integración en los flujos de trabajo existentes son vitales para la adopción generalizada y la satisfacción del usuario.

- Consideraciones éticas y características de seguridad: A medida que la IA se vuelve más potente, el desarrollo y la implementación responsables son cruciales. Esto incluye medidas de protección contra la generación de contenido dañino o sesgado.

- Costo-efectividad y modelos de precios: Si bien algunas herramientas ofrecen niveles gratuitos, comprender la estructura de precios de las funciones avanzadas y el uso comercial es esencial para los usuarios conscientes del presupuesto.

- Ediciones consistentes de varios pasos — preservar la identidad/los objetos en múltiples ediciones o imágenes.

Me inclino por lo práctico: un modelo que produce imágenes ligeramente menos impactantes pero que permite obtener ediciones reproducibles, rápidas y confiables será mejor que uno llamativo que necesite mucha limpieza.

¿Cuáles son los modelos considerados y qué los hace diferentes?

Instantánea rápida del modelo

- imagen gpt-1 (OpenAI) — un modelo multimodal nativo lanzado a la API en abril de 2025 que admite directamente la generación y edición iterativa de imágenes dentro de la misma API de respuestas/imágenes multimodal.

- Imagen Flash de Gemini 2.5 (Google) — anunciado el 26 de agosto de 2025 (“nano-banana”); diseñado para una generación rápida y de baja latencia y una edición enriquecida (fusión de múltiples imágenes, consistencia de caracteres); incluye marca de agua SynthID para procedencia.

- Editor de imágenes Qwen (QwenLM / Grupo Alibaba) — una versión de edición de imágenes de Qwen-Image (fundación 20B) que enfatiza la edición de texto precisa y bilingüe y la edición combinada de semántica y apariencia.

- FLUX.1 Kontext (variantes de la plataforma Flux / Black Forest Labs / Flux) — familia de modelos (Dev/Pro/Max) centrada en la edición rápida, local y consciente del contexto con consistencia de personajes y flujos de trabajo iterativos.

¿Por qué estos cuatro?

Abordan los puntos de diseño más relevantes que los profesionales consultan en 2025: integración multimodal (OpenAI), escala + producción + conocimiento global (Google), edición de precisión e investigación abierta (Qwen) y edición iterativa centrada en la experiencia de usuario (UX-first) (Flux). Cada una ofrece diferentes ventajas y desventajas en cuanto a coste, latencia y aspectos clave (renderizado de texto, fusión de múltiples imágenes, edición iterativa y preservación de áreas sin cambios).

GPT-Image-1 (OpenAI): el gran trabajador del desarrollador

Qué es: GPT-Image-1 de OpenAI es un modelo multimodal nativo que acepta entradas de texto e imágenes y permite la generación y edición de imágenes (repintado, imagen a imagen) a través de su API de Imágenes. Está diseñado como un modelo de producción para la integración entre aplicaciones y servicios. Está diseñado como un modelo nativo de texto e imagen que acepta entradas de imágenes e indicaciones de texto, y realiza ediciones con un control preciso.

¿Cuáles son las fortalezas de GPT-image-1?

- Comprensión semántica excepcional: Una de las principales fortalezas de GPT-image-1 reside en su capacidad para interpretar indicaciones textuales detalladas y con matices. Los usuarios pueden describir escenas complejas, estados de ánimo específicos y conceptos abstractos con una precisión notable, y la IA suele producir imágenes que reflejan fielmente estas descripciones.

- Fotorrealismo de alta calidad: Cuando se le solicitan imágenes realistas, GPT-image-1 suele ofrecer resultados sorprendentemente realistas, con una atención impresionante a las texturas, la iluminación y las composiciones naturales. Esto lo convierte en una herramienta formidable para el renderizado fotorrealista y el arte conceptual.

- Interpretación creativa: Más allá de la mera traducción literal, GPT-image-1 exhibe cierto grado de interpretación creativa, añadiendo a menudo detalles sutiles o toques estilísticos que realzan el atractivo artístico general de la imagen generada. Esto puede ser especialmente beneficioso para la ideación y la exploración de diversos conceptos visuales.

- Base sólida para la iteración: Su capacidad para generar conceptos iniciales de alta calidad proporciona un excelente punto de partida para un mayor refinamiento, ya sea dentro de las capacidades de edición de la IA (si están disponibles) o a través del software de diseño gráfico tradicional.

¿Cuáles son las limitaciones de GPT-image-1?

- Control sobre los detalles finos: Si bien es excelente en conceptos generales, lograr un control absoluto a nivel de píxel o la manipulación precisa de elementos muy pequeños a veces puede ser un desafío. Este es un obstáculo común para muchas IA generativas, donde el resultado es algo determinista según la indicación.

- Disponibilidad e integración: Dependiendo de su implementación específica, las funciones de edición directa de GPT-image-1 podrían ser menos robustas o estar menos integradas que las de las plataformas dedicadas a la edición de imágenes. Los usuarios podrían necesitar exportar y usar otras herramientas para una edición intensiva posterior a la generación.

- Demandas computacionales: La generación de imágenes muy detalladas con indicaciones complejas puede requerir un uso intensivo de recursos computacionales, lo que puede llevar a tiempos de procesamiento más largos en comparación con modelos más especializados y livianos para ediciones rápidas.

Nano Banana (Imagen Flash de Google/Gemini 2.5)

Qué es: "Nano Banana" es el nombre jocoso de la reciente actualización de imágenes de Gemini de Google (Gemini 2.5 Flash Image). Se ha posicionado como un generador/editor de imágenes de última generación dentro del ecosistema Gemini de Google, promocionado por sus ediciones de varios pasos más potentes y matizadas, y por su consistencia superior en la edición de fotografías.

¿Dónde brilla Gemini-2.5-Flash-Image en el panorama de la IA visual?

Gemini-2.5-Flash-Image, una versión más reciente diseñada para la velocidad y la eficiencia, es la opción de Google que busca un equilibrio entre resultados de alta calidad y procesamiento rápido. Su denominación "Flash" se debe específicamente a su arquitectura optimizada para respuestas más rápidas, lo que la hace ideal para aplicaciones donde la generación y edición en tiempo real o casi real son cruciales.

¿Qué hace que Gemini-2.5-Flash-Image sea un fuerte competidor?

- Generación increíblemente rápida: Como su nombre indica, la velocidad es una ventaja fundamental. Gemini-2.5-Flash-Image destaca por generar imágenes rápidamente, lo cual resulta invaluable para profesionales creativos con plazos ajustados o para aplicaciones interactivas.

- Calidad de imagen sólida: A pesar de su velocidad, el modelo no compromete significativamente la calidad de la imagen. Produce imágenes coherentes y visualmente atractivas, generalmente libres de artefactos importantes, lo que lo hace competitivo frente a modelos más lentos y que consumen más recursos en muchos casos de uso.

- Comprensión multimodal: Al aprovechar el marco más amplio de Gemini, a menudo se beneficia de una comprensión multimodal avanzada, lo que significa que potencialmente puede interpretar no solo texto sino también otras formas de entrada para guiar la generación y edición de imágenes, aunque esto varía según la API específica.

- Capacidades de edición integradas: Gemini-2.5-Flash-Image generalmente viene con funciones de edición integradas, como relleno (relleno de partes faltantes de una imagen), recubrimiento (extensión de una imagen más allá de sus bordes originales) y manipulación de objetos, lo que lo convierte en una solución más completa para flujos de trabajo de imágenes de extremo a extremo.

¿Cuáles son las áreas de mejora para Gemini-2.5-Flash-Image?

- Fotorrealismo máximo: Si bien es bueno, puede que no siempre alcance el máximo fotorrealismo que se observa en algunos de los modelos más lentos y grandes para escenas muy complejas y con muchos matices. Puede haber una ligera contradicción entre la velocidad y la fidelidad máxima.

- Matices artísticos para estilos complejos: Para estilos artísticos muy específicos o solicitudes extremadamente abstractas, algunos usuarios podrían encontrarlo ligeramente menos capaz de capturar los matices artísticos más sutiles en comparación con los modelos entrenados en grandes conjuntos de datos históricos de arte.

- Control sobre el texto generado (dentro de las imágenes): Como ocurre con muchos modelos generativos, generar texto perfectamente coherente y correctamente escrito dentro de una imagen todavía puede ser un desafío.

¿Qué es Qwen-Image-Edit?

Qué es: Qwen-Image-Edit (Equipo de Alibaba/Qwen) — modelo de edición de imágenes basado en la familia Qwen-Image; garantiza una potente edición de texto bilingüe (chino e inglés), control semántico y de apariencia, y fidelidad de edición directa de imágenes.

¿Cuáles son las ventajas únicas de Qwen-Image Edit?

- Precisión de edición superior: Qwen-Image Edit suele contar con algoritmos avanzados de retoque, corrección de color y manipulación de objetos que permiten ediciones muy precisas y fluidas. Destaca por mantener la coherencia visual incluso al realizar modificaciones significativas.

- Edición sensible al contexto: Una de sus principales ventajas es su capacidad de reconocer el contexto. Al eliminar un objeto, por ejemplo, rellena inteligentemente el vacío con contenido que se integra lógicamente con el entorno, haciendo que la edición sea prácticamente indetectable.

- Transferencia de estilo y armonización: Qwen-Image Edit puede ser muy eficaz para transferir estilos de una imagen a otra o armonizar diferentes elementos dentro de una imagen para crear una apariencia cohesiva. Esto resulta invaluable para los diseñadores que trabajan con diversos recursos visuales.

- Eliminación/adición de objetos robustos: Su capacidad para agregar o quitar objetos manteniendo la iluminación, las sombras y la perspectiva es muy impresionante, lo que permite realizar reconstrucciones de escenas complejas o despejar el espacio.

- Mejora y aumento de escala de imágenes: A menudo incluye funciones avanzadas para ampliar las imágenes sin perder calidad y mejorar los detalles, los colores y el atractivo visual general.

¿Cuáles son las posibles debilidades de Qwen-Image Edit?

- Enfoque en la generación inicial: Si bien puede generar imágenes, su principal punto fuerte y optimización suele residir en la edición. Su capacidad inicial de generación de texto a imagen puede ser buena, pero posiblemente no sea tan diversa en cuanto a creatividad ni fotorrealismo como los modelos centrados exclusivamente en la generación, según la versión específica.

- Curva de aprendizaje para funciones avanzadas: La precisión y profundidad de sus herramientas de edición pueden requerir una curva de aprendizaje ligeramente más pronunciada para usuarios no familiarizados con conceptos avanzados de manipulación de imágenes.

- Intensidad de recursos para ediciones complejas: Las ediciones altamente complejas y de múltiples capas aún pueden requerir muchos recursos computacionales, lo que potencialmente puede generar tiempos de procesamiento más largos para tareas muy grandes o intrincadas.

¿Qué innovaciones aporta Flux Kontext a la IA de imágenes?

Qué es: Kontext de Flux (a veces comercializado como FLUX.1 Kontext) es una herramienta de edición y generación de imágenes diseñada para diseñadores y equipos de marca. Enfatiza edición sensible al contexto, tipografía precisa, transferencias de estilo y una UI/UX ajustada para un trabajo de diseño iterativo.

¿Cuáles son los puntos fuertes de Flux Kontext?

- Cohesión contextual: La principal fortaleza de Flux Kontext reside en su capacidad para comprender y mantener el contexto a lo largo de múltiples generaciones o ediciones de imágenes. Esto resulta fundamental para crear narrativas visuales, diseños de personajes o líneas de productos consistentes donde la armonía visual es esencial.

- Consistencia mejorada en la serie: Si necesita generar una serie de imágenes que compartan un estilo, carácter o entorno común, Flux Kontext tiene como objetivo reducir las inconsistencias que pueden afectar a otros modelos.

- Estilo adaptativo: Puede adaptar su salida basándose en imágenes generadas previamente o en una guía de estilo definida, lo que da lugar a un proceso creativo más ágil y menos iterativo.

- Especializado en Marca y Narrativa: Particularmente beneficioso para el marketing, la creación de marca y la narración de historias, donde una identidad visual unificada es crucial.

- Comprensión rápida en contexto: Su comprensión rápida no se refiere sólo a la imagen actual sino a cómo encaja en un contexto o conjunto de instrucciones más amplio.

¿Cuáles son las limitaciones de Flux Kontext?

- Potencial para centrarse en nichos específicos: Su énfasis en el contexto y la consistencia puede significar que no siempre sea el líder absoluto en fotorrealismo crudo e independiente o en diversidad artística extrema si ese es el único requisito.

- Puntos de referencia menos documentados públicamente: Como actor más nuevo o más especializado, es posible que haya menos datos de referencia públicos y extensos disponibles en comparación con modelos más establecidos.

- Depende de una entrada contextual clara: Para aprovechar sus puntos fuertes, los usuarios deben proporcionar información contextual clara o definir el marco narrativo de manera eficaz, lo que podría requerir un enfoque de estímulo diferente.

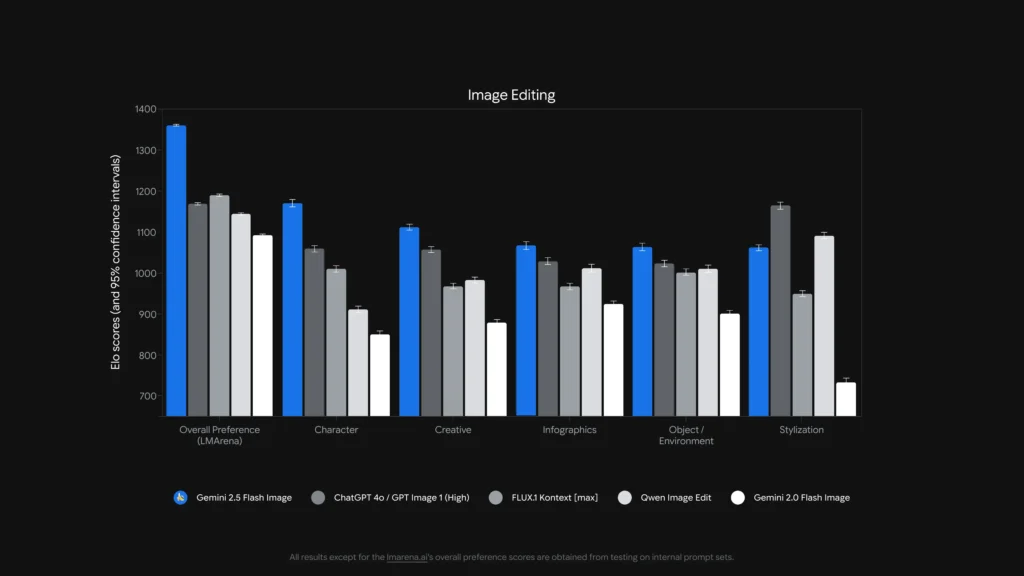

¿Qué modelo es mejor en la edición de imágenes?

Para solteros, ediciones precisas sin máscara y edición de texto dentro de imágenes, Edición de imágenes de Qwen y Imagen Flash de Gemini 2.5 (y modelos especializados como FLUX.1 Kontext) se encuentran entre los más fuertes. Para ediciones encadenadas complejas de varios pasosLa combinación de una interfaz LLM con muchas instrucciones (variantes Gemini o GPT) con un modelo de imagen a menudo produce el mejor resultado; algunos trabajos de referencia han demostrado que la indicación en estilo Cadena de Pensamiento (Gemini-CoT) mejora el éxito de la edición de varios pasos.

ediciones locales, consistencia de caracteres, manejo de texto

- Edición de imágenes de Qwen se dirige explícitamente a ambos semántico y apariencia ediciones —por ejemplo, reemplazar objeto, rotar, reemplazo preciso de texto— construidas explícitamente como una edición de imagen Modelo con vías duales (control semántico mediante Qwen2.5-VL + control de apariencia mediante el codificador VAE). Se anuncia un bilingüe robusto (chino/inglés). ediciones de texto en imágenes (por ejemplo, cambiar el texto de los carteles o las etiquetas de los productos) conservando al mismo tiempo el estilo, lo cual es poco común y valioso para el trabajo de localización y empaquetado.

- Imagen Flash de Gemini 2.5 Admite ediciones enmascaradas, modificaciones locales basadas en indicaciones (desenfocar fondo, eliminar persona, cambiar pose) y fusión de múltiples imágenes. Google promociona ediciones basadas en indicaciones que reconocen la región, además de ventajas en el conocimiento del mundo (p. ej., mejor semántica de objetos del mundo real). El modelo también añade un marca de agua invisible de SynthID para generar/editar imágenes para ayudar a la procedencia y detección.

- FLUX.1 ContextoSe posiciona como un solucionador de contexto de imagen a imagen: está optimizado para ediciones locales precisas y contextuales, así como para la experimentación iterativa. Los revisores elogian su capacidad para preservar el contexto y la semántica de la escena al realizar cambios locales. FLUX.1 Kontext y Flux Kontext UI han recibido elogios en pruebas prácticas comparativas por sus flujos de trabajo de edición iterativa y la legibilidad del texto, lo que lo convierte en una opción práctica para flujos de trabajo que requieren muchas iteraciones rápidas (recursos de marketing, miniaturas).

- Imagen GPT-1: admite operaciones de edición (solicitudes de texto e imagen para ediciones) y las herramientas de OpenAI integran patrones de encadenamiento e ingeniería de indicaciones; el rendimiento es sólido pero depende de la ingeniería de indicaciones y puede quedar por detrás de modelos especializados de edición primero en la edición granular (por ejemplo, reemplazo exacto de texto bilingüe) en algunas pruebas.

Puntos de referencia como Edición de ComplexBench y Banco de competencia Los estudios demuestran que muchos modelos aún fallan cuando las ediciones están encadenadas o son interdependientes, pero que la combinación de un LLM para el análisis de instrucciones con un modelo de imagen robusto (LLM→orquestación del modelo de imagen) o el uso de indicadores CoT puede reducir los fallos. Por ello, algunos flujos de trabajo de producción combinan modelos (p. ej., un LLM de razonamiento más un generador de imágenes) para ediciones complejas.

¿Quién es el mejor editando texto dentro de imágenes?

- Edición de imágenes de Qwen Fue diseñado específicamente para la edición precisa de textos bilingües (chino e inglés) y reporta resultados superiores en las pruebas de referencia de edición de texto (notas técnicas públicas de Qwen y puntuaciones reportadas). Los artefactos y demostraciones de Qwen de código abierto muestran una conservación precisa de la fuente, el tamaño y el estilo durante las ediciones.

- imagen gpt-1 y Imagen Flash de Gemini 2.5 Ambos avances mejoran la representación de texto, pero los puntos de referencia académicos y las notas de los proveedores indican que aún quedan desafíos para textos pequeños o detallados y pasajes de texto largos: las mejoras son incrementales y varían según el mensaje y la resolución.

Análisis comparativo: Reportaje, Edición

Para ofrecer una imagen más clara, consolidemos los aspectos clave de estos modelos líderes de IA en una tabla comparativa.

| Característica / Capacidad | Imagen GPT-1 (OpenAI) | Imagen Flash de Gemini-2.5 (Google) | Qwen-Editor de imágenes (Alibaba) | FLUX.1 Contexto |

|---|---|---|---|---|

| Generación nativa + edición | Sí. Texto+imagen multimodal en una API. | Sí: generación nativa y edición dirigida; se enfatiza la fusión de múltiples imágenes y la consistencia de los personajes. | Centrado en . (Qwen-Image-Edit) con control semántico + apariencia. | Centrado en ediciones de alta fidelidad, imagen a imagen. |

| Profundidad de edición (ajustes locales) | Alto (pero generalista) | Muy alto (indicaciones específicas + ediciones sin máscara) | Muy alto para ediciones semánticas/de texto (soporte de texto bilingüe). | Muy alto: canales de edición sensibles al contexto. |

| Manejo de texto en imágenes | Bueno, depende del aviso. | Mejorado (el proveedor muestra demostraciones de edición de plantillas y letreros) | Mejores Clínicas de Entre estos se encuentran los cambios de texto legible bilingüe. | Fuerte para preservar el estilo; la legibilidad depende del mensaje. |

| Consistencia entre caracteres y objetos | Bueno con indicaciones cuidadosas | Fuerte (característica explícita) | Medio (el enfoque está en la edición en lugar de la identidad de múltiples imágenes) | Fuerte a través de flujos de trabajo de edición iterativos. |

| Latencia/rendimiento | Moderada | Baja latencia/alto rendimiento (Modelo Flash) | Varía según el alojamiento (local/HF vs. nube) | Diseñado para ediciones iterativas rápidas en SaaS alojado. |

| Procedencia / marca de agua | Sin marca de agua obligatoria (mecanismos de política) | Marca de agua invisible de SynthID para imagenes | Depende del anfitrión | Depende del anfitrión |

Notas: La "profundidad de edición" mide la precisión y fiabilidad de las ediciones locales en la práctica; el "manejo de texto" evalúa la capacidad de colocar o cambiar texto legible dentro de las imágenes.

¿Qué pasa con la latencia, la ergonomía del desarrollador y la integración empresarial?

Opciones de latencia e implementación

- Imagen Flash de Gemini 2.5 enfatiza baja latencia Está disponible a través de la API de Gemini, Google AI Studio y Vertex AI, una excelente opción para aplicaciones empresariales que requieren un rendimiento predecible e integración en la nube. Google también informa el precio aproximado del token por imagen (y el blog para desarrolladores incluye un ejemplo de precio por imagen).

- imagen gpt-1 Está disponible a través de la API de Imágenes de OpenAI y cuenta con una amplia integración en el ecosistema (Playground, socios como Adobe/Canva). El precio está tokenizado y varía según el nivel de calidad de la imagen (OpenAI publica las conversiones de tokens a dólares).

- Flux Kontext se centra en una UX interactiva rápida y ofrece créditos + tiempos de edición bajos en demostraciones de productos: útil para diseñadores y para una iteración rápida. Qwen Proporciona artefactos abiertos y acceso a investigaciones (ideal si desea alojarlos usted mismo o inspeccionar elementos internos).

¿Cuánto cuestan estos servicios? ¿Cuál tiene mejor relación calidad-precio?

Los precios cambian con frecuencia: a continuación se muestran los números indicados por el editor (agosto de 2025) y los cálculos representativos del costo por imagen donde los proveedores los publicaron.

Precios publicados (declaraciones del proveedor)

| Modelo / Proveedor | Instantánea de precios públicos (publicada) | Estimación aproximada por imagen |

|---|---|---|

| imagen gpt-1 (OpenAI) | Precios tokenizados (entrada de texto: $5/1 millón, entrada de imagen: $10/1 millón, salida de imagen: $40/1 millón). OpenAI señala que esto se corresponde aproximadamente con... $ 0.02-$ 0.19 por imagen generada dependiendo de la calidad/tamaño. | ~$0.02 (baja calidad/miniatura) → ~$0.19 (cuadrado de alta calidad) |

| Imagen Flash de Gemini 2.5 (Google) | $30 por cada millón de tokens de salida y ejemplo: cada imagen ≈ 1290 tokens de salida (~$0.039 por imagen) según el blog del desarrollador. Precios aplicados mediante la API de Gemini/Vertex. | ~$0.039 por imagen (ejemplo de Google) |

| Flux Kontext (Flux) | Nivel gratuito con créditos; las páginas de productos de Flux muestran Créditos gratuitos 10 y ediciones típicas a precio de Créditos 5Niveles de suscripción disponibles para usuarios intensivos. (Página del producto del proveedor). | Costo muy bajo para ediciones ocasionales; suscripción para uso intensivo. |

| Edición de imágenes Qwen (QwenLM) | Lanzamiento abierto y artefactos de GitHub: acceso abierto para investigación con ejemplos gratuitos; las implementaciones comerciales varían según el integrador (autoalojado o en la nube). No hay un precio canónico único por imagen; suele ser el más bajo si se aloja en el propio servidor. |

Interpretación de valores: Si necesita una imagen de gran volumen generación de AHSS Si está en producción y busca precios por imagen predecibles, el modelo de Google es extremadamente competitivo. Si sus costos se basan principalmente en la edición manual o el tiempo iterativo del diseñador, Flux o la ejecución local de Qwen pueden ser más económicos. OpenAI ofrece un amplio ecosistema de SDK y numerosos socios, por lo que vale la pena optar por un nivel superior para facilitar la integración.

Precio en CometAPI

| Modelo | Imagen GPT-1 | Imagen Flash de Gemini-2.5 | FLUX.1 Contexto |

| Precio | Tokens de entrada $8.00; Tokens de salida $32.00 | $0.03120 | Flux Kontext Pro: $0.09600 Flux Kontext Max: $0.19200 |

Consejos prácticos y rápidos para obtener los mejores resultados

Sugerencias para indicaciones y flujo de trabajo (se aplica a todos los modelos)

- Sea explícito sobre la composiciónÁngulo de la cámara, iluminación, ambiente, distancia focal, lente y relaciones espaciales entre los objetos. Ejemplo: “Primer plano de 35 mm, poca profundidad de campo, sujeto centrado, borde de luz suave desde la esquina superior izquierda”.

- Utilice el refinamiento iterativo para las edicionesPrimero, realice ediciones estructurales básicas y luego perfeccione las texturas y la iluminación. Modelos como FLUX y Gemini están diseñados para permitir el refinamiento en varios pasos.

- Para texto en imágenes: proporcione el texto exacto que desea y agregue “representar como un letrero legible de alto contraste con relieve realista”; para ediciones bilingües, use Qwen-Image-Edit cuando necesite fidelidad chino/inglés.

- Utilice imágenes de referenciaPara lograr consistencia entre personajes o variantes de producto, proporcione imágenes de referencia de alta calidad e indicaciones de referencia como "combinar con el personaje en la referencia_01: rasgos faciales, color del vestuario e iluminación". Gemini y Flux priorizan la fusión y consistencia de múltiples imágenes.

- Ediciones con máscara y sin máscaraSiempre que sea posible, proporcione una máscara para restringir las ediciones con precisión. Al usar la opción sin máscara, se espera un desbordamiento ocasional. Los modelos varían: Flux/Gemini gestionan bien las ediciones sin máscara, pero una máscara sigue siendo útil.

- Use Imagen GPT / GPT-4o Para indicaciones de composición complejas con múltiples objetos, conteos y restricciones espaciales. Utilice una sola instrucción exacta por generación siempre que sea posible.

Consejos sobre costos y latencia

Procesamiento por lotesUtilice API por lotes o funciones en la nube para generar múltiples variantes de forma eficiente. Gemini-2.5-Flash está optimizado para un alto rendimiento si necesita un gran volumen.

Calidad de la melodía vs precioOpenAI expone niveles de imagen bajos, medios y altos; genera borradores en baja calidad y finaliza en alta.

veredicto final

- Ideal para producción e integración: Imagen GPT-1 — el más fuerte para necesidades de API, composición e integración en herramientas profesionales.

- Ideal para la consistencia fotorrealista del consumidor: Nano plátano —La actualización de imágenes Gemini de Google destaca por sus ediciones de retratos naturales y secuenciales y una experiencia de usuario accesible.

- La mejor experiencia móvil/editora: Flux Kontext — Excelentes ediciones conversacionales en el teléfono con baja fricción.

- Si se mide por ediciones de texto quirúrgicas y edición bilingüe/multilingüe → Qwen-Image-Edit** es el mejor especialista y una excelente opción cuando la precisión del texto dentro de las imágenes es importante.

Primeros Pasos

CometAPI es una plataforma API unificada que integra más de 500 modelos de IA de proveedores líderes, como la serie GPT de OpenAI, Gemini de Google, Claude de Anthropic, Midjourney, Suno y más, en una única interfaz intuitiva para desarrolladores. Al ofrecer autenticación, formato de solicitudes y gestión de respuestas consistentes, CometAPI simplifica drásticamente la integración de las capacidades de IA en sus aplicaciones. Ya sea que esté desarrollando chatbots, generadores de imágenes, compositores musicales o canales de análisis basados en datos, CometAPI le permite iterar más rápido, controlar costos y mantenerse independiente del proveedor, todo mientras aprovecha los últimos avances del ecosistema de IA.

Los desarrolladores pueden acceder Imagen GPT-1, FLUX.1 Contexto y Imagen Flash de Gemini 2.5 A través de CometAPI, las últimas versiones de los modelos listadas corresponden a la fecha de publicación del artículo. Para comenzar, explore las capacidades del modelo en Playground y consultar el Guía de API Para obtener instrucciones detalladas, consulte la sección "Antes de acceder, asegúrese de haber iniciado sesión en CometAPI y de haber obtenido la clave API". CometAPI Ofrecemos un precio muy inferior al oficial para ayudarte a integrarte.

La última integración Edición de imágenes de Qwen ¡Pronto aparecerá en CometAPI, así que estad atentos! ¿Listo para empezar a editar imágenes? → Regístrate en CometAPI hoy !

Precio en CometAPI

| Modelo | Imagen GPT-1 | Imagen Flash de Gemini-2.5 | FLUX.1 Contexto |

| Precio | Tokens de entrada $8.00; Tokens de salida $32.00 | $0.03120 | Flux Kontext Pro: $0.09600 Flux Kontext Max: $0.19200 |