L'intelligence artificielle (IA) a révolutionné de nombreux secteurs, et l'une de ses applications les plus captivantes est la génération d'images. De la création de visages humains réalistes à la production d'œuvres d'art surréalistes, la capacité de génération d'images par l'IA a ouvert de nouvelles perspectives dans l'art, le design et la technologie. Cet article explore les mécanismes à l'origine des images générées par l'IA, les modèles qui les sous-tendent et les implications plus larges de cette technologie.

Comprendre les bases : comment fonctionne la génération d’images par l’IA ?

Que sont les modèles génératifs ?

Les modèles génératifs sont une classe d'algorithmes d'IA capables de créer de nouvelles instances de données ressemblant aux données d'entraînement. Dans le contexte de la génération d'images, ces modèles apprennent des schémas à partir d'images existantes et utilisent ces connaissances pour produire de nouvelles images similaires.

Le rôle des réseaux neuronaux

Au cœur de la génération d'images par IA se trouvent les réseaux de neurones, en particulier les modèles d'apprentissage profond comme les réseaux de neurones convolutifs (CNN). Conçus pour traiter les données selon une topologie en grille, les CNN sont idéaux pour l'analyse et la génération d'images. Ils détectent des motifs tels que les contours, les textures et les formes, essentiels à la compréhension et à la recréation des images.

Modèles d'IA clés dans la génération d'images IA

Réseaux Génératifs d'Adversariat (GAN)

Introduits par Ian Goodfellow en 2014, les GAN se composent de deux réseaux neuronaux : un générateur et un discriminateur. Le générateur crée des images, tandis que le discriminateur les compare à des images réelles. Grâce à ce processus contradictoire, le générateur améliore ses résultats pour produire des images de plus en plus réalistes.

StyleGAN

Développé par NVIDIA, StyleGAN est une variante du GAN connue pour générer des visages humains de haute qualité. Il introduit une architecture de générateur basée sur les styles, permettant de contrôler différents niveaux de détail de l'image. StyleGAN2 et StyleGAN3 ont amélioré la qualité de l'image et résolu des problèmes tels que l'adhérence des textures.

Modèles de diffusion

Les modèles de diffusion génèrent des images en commençant par un bruit aléatoire et en l'affinant progressivement pour obtenir le résultat souhaité. Ils ont gagné en popularité grâce à leur capacité à produire des images de haute qualité et à leur flexibilité dans diverses applications.

Diffusion stable

Stable Diffusion est un modèle de diffusion open source permettant la conversion de texte en image. Il permet également l'inpainting et l'outpainting, permettant ainsi l'édition et l'extension d'images. Son caractère open source le rend largement accessible aux développeurs et aux artistes.

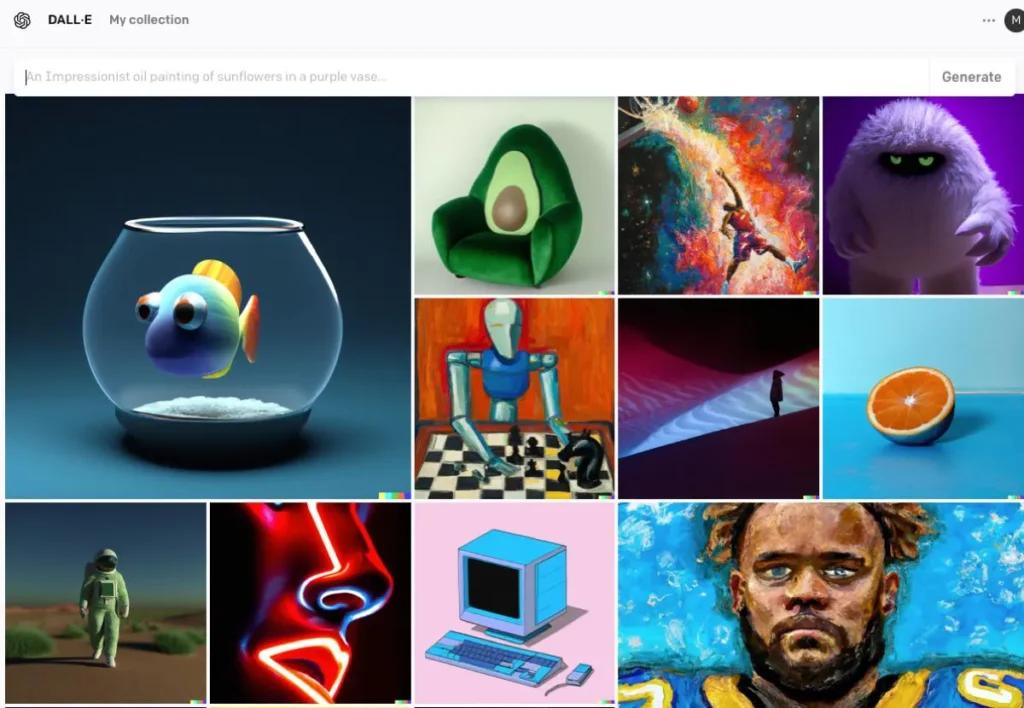

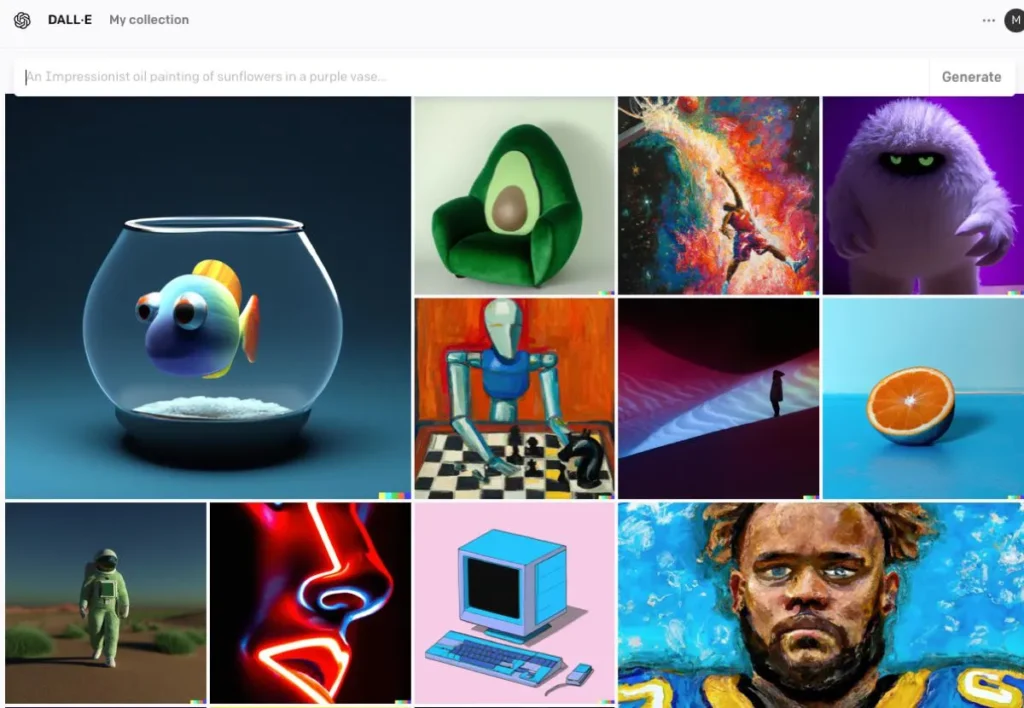

DALL · E

Développé par OpenAI, DALL·E est un modèle basé sur un transformateur capable de générer des images à partir de descriptions textuelles. DALL·E 2 et DALL·E 3 ont été améliorés par rapport à l'original, offrant une résolution plus élevée et un alignement image-texte plus précis. DALL·E 3 est intégré à ChatGPT pour une interaction utilisateur optimisée.

Le processus de génération d'images par IA

Entraîner le modèle

Les modèles d'IA nécessitent un entraînement intensif sur de grands ensembles de données d'images. Au cours de cet entraînement, le modèle apprend à reconnaître des motifs et des caractéristiques au sein des images, ce qui lui permet de générer de nouvelles images reproduisant les données d'entraînement.

Générer de nouvelles images

Une fois formé, le modèle peut générer de nouvelles images en :

- Réception d'entrée:Il peut s'agir d'un bruit aléatoire (dans les GAN), d'une invite de texte (dans DALL·E) ou d'une image existante (pour l'édition). Cette étape capture la signification sémantique du texte, permettant à l'IA de comprendre le contenu et le contexte.

- Traitement des entréesLe modèle traite les données d'entrée via ses couches de réseau neuronal, en appliquant les modèles et caractéristiques appris. À partir du texte encodé, l'IA utilise des modèles tels que les réseaux antagonistes génératifs (GAN) ou les modèles de diffusion pour créer des images. Ces modèles génèrent des images en partant d'un bruit aléatoire et en l'affinant pour correspondre à la description textuelle.

- Raffinement et évaluationL'image générée est ensuite affinée grâce à des mécanismes d'attention afin de garantir sa cohérence avec le texte. Un modèle discriminateur évalue le réalisme et la cohérence de l'image avec l'entrée, fournissant des informations pour un affinement ultérieur.

- Sortie d'image:Le résultat final est une nouvelle image qui reflète les caractéristiques des données de formation et l’entrée spécifique fournie.

Exemple de code de génération d'images IA

voici des exemples pratiques de code Python démontrant comment générer des images à l'aide de trois modèles d'IA importants : les réseaux antagonistes génératifs (GAN), la diffusion stable et DALL·E.

Réseaux antagonistes génératifs (GAN) avec PyTorch

Les réseaux antagonistes génératifs (GAN) sont constitués de deux réseaux neuronaux – le générateur et le discriminateur – qui rivalisent pour générer de nouvelles instances de données réalistes. Voici un exemple simplifié utilisant PyTorch pour générer des images :

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

Ce code définit un réseau générateur simple qui prend un vecteur de bruit à 100 dimensions en entrée et produit une sortie à 784 dimensions, qui peut être remodelée en une image 28 × 28. tanh la fonction d'activation garantit que les valeurs de sortie sont dans la plage , ce qui est courant pour les données d'image.

Diffusion stable avec diffuseurs faciaux enveloppants

Stable Diffusion est un puissant modèle de conversion de texte en image qui génère des images à partir de descriptions textuelles. Le Visage enlacé diffusers la bibliothèque fournit une interface simple pour utiliser ce modèle :

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

Ce script charge le modèle de diffusion stable et génère une image en fonction de l'invite fournie. Assurez-vous d'avoir installé les dépendances nécessaires et un GPU compatible pour des performances optimales.

DALL·E avec API OpenAI

DALL·E est un autre modèle de conversion de texte en image développé par OpenAI. Vous pouvez interagir avec lui grâce à l'API d'OpenAI :

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

remplacer "your-api-key" avec votre clé API OpenAI. Ce script envoie une invite au modèle DALL·E et récupère l'image générée. L'image est ensuite enregistrée localement.

CometAPI s'intègre également API DALL-E3, vous pouvez également utiliser la clé CometAPI pour accéder API DALL-E3, qui est plus pratique et plus rapide qu'OpenAI.

Pour plus d'informations sur le modèle dans l'API Comet, veuillez consulter API doc.

Ces exemples constituent un point de départ pour générer des images à l'aide de différents modèles d'IA. Chaque modèle possède des capacités et des exigences spécifiques ; choisissez donc celui qui correspond le mieux aux besoins de votre projet.

Conclusion

La génération d'images par l'IA se situe à l'intersection de la technologie et de la créativité, offrant des possibilités inédites en matière de création de contenu visuel. Comprendre comment l'IA génère des images, les modèles impliqués et les implications de cette technologie est essentiel pour son intégration dans divers aspects de la société.

Accéder à l'API AI Image dans CometAPI

CometAPI donne accès à plus de 500 modèles d'IA, dont des modèles multimodaux open source et spécialisés pour le chat, les images, le code, etc. Son principal atout réside dans la simplification du processus traditionnellement complexe d'intégration de l'IA. Grâce à elle, l'accès aux principaux outils d'IA tels que Claude, OpenAI, Deepseek et Gemini est disponible via un abonnement unique et unifié. Vous pouvez utiliser l'API de CometAPI pour créer de la musique et des illustrations, générer des vidéos et créer vos propres workflows.

API Comet proposer un prix bien inférieur au prix officiel pour vous aider à intégrer API GPT-4o ,API à mi-parcours API de diffusion stable (API Stable Diffusion XL 1.0) et l'API Flux(API FLUX.1 etc) et vous recevrez 1 $ sur votre compte après vous être inscrit et connecté !

CometAPI intègre les dernières API d'image GPT-4o .