grok-code-fast-1 est xAI modèle de codage agentique axé sur la vitesse et rentable conçu pour optimiser les intégrations IDE et les agents de codage automatisés. Il met l'accent faible latence, comportements agentiques (appels d'outils, traces de raisonnement par étapes) et un profil de coût compact pour les flux de travail quotidiens des développeurs.

Principales caractéristiques (en un coup d'œil)

- Débit élevé / faible latence : axé sur une sortie de jetons très rapide et des complétions rapides pour l'utilisation de l'IDE.

- Appel de fonctions et outillage agentiques : prend en charge les appels de fonctions et l'orchestration d'outils externes (exécution de tests, linters, récupération de fichiers) pour permettre des agents de codage en plusieurs étapes.

- Grande fenêtre de contexte : conçu pour gérer de grandes bases de code et des contextes multi-fichiers (les fournisseurs répertorient 256 000 fenêtres de contexte dans les adaptateurs du marché).

- Raisonnement / traces visibles : les réponses peuvent inclure des traces de raisonnement par étapes destinées à rendre les décisions de l'agent inspectables et débogables.

Détails techniques

Architecture & formation : xAI indique que grok-code-fast-1 a été développé de A à Z avec une nouvelle architecture et un corpus de pré-entraînement riche en contenu de programmation ; le modèle a ensuite été optimisé après l'entraînement sur des jeux de données de pull-request et de code réels de haute qualité. Ce pipeline d'ingénierie vise à développer le modèle. pratique à l'intérieur des flux de travail des agents (IDE + utilisation d'outils).

Service et contexte : grok-code-fast-1 Les modèles d'utilisation courants supposent des sorties en streaming, des appels de fonctions et une injection de contexte riche (téléchargements/collections de fichiers). Plusieurs marketplaces cloud et adaptateurs de plateformes proposent déjà cette fonctionnalité avec une prise en charge de contextes importants (256 000 contextes dans certains adaptateurs).

Fonctionnalités d'utilisabilité : Visible traces de raisonnement (le modèle met en évidence sa planification/utilisation des outils), des conseils d'ingénierie rapide et des exemples d'intégrations, ainsi que des intégrations de partenaires de lancement précoce (par exemple, GitHub Copilot, Cursor).

Performances de référence (sur quoi il se base)

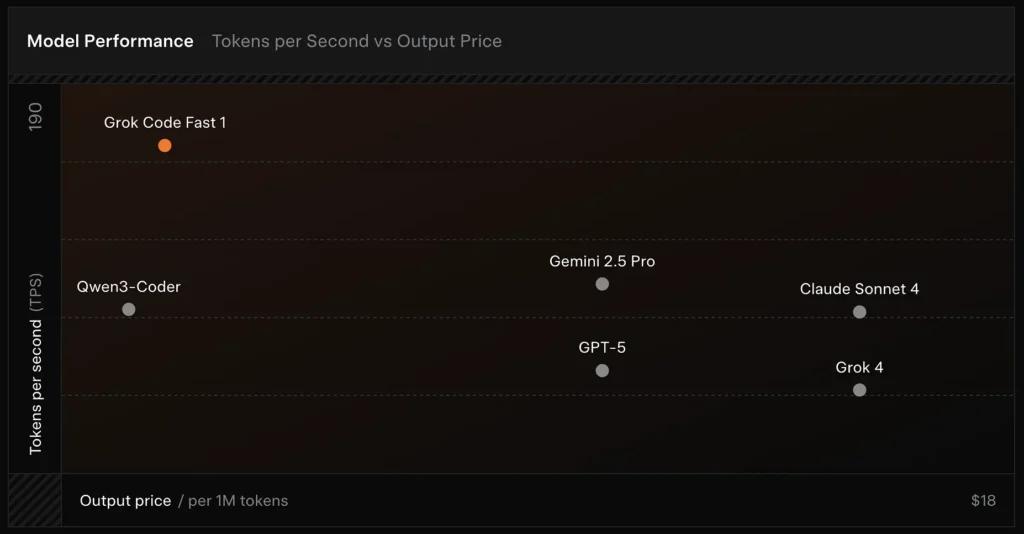

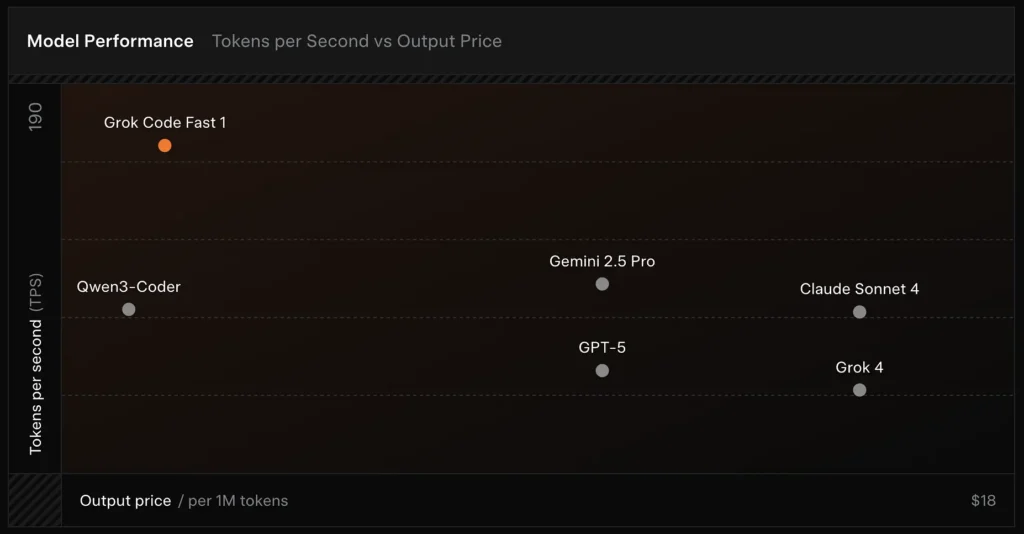

Vérifié par SWE Bench : xAI signale un 70.8% score sur leur harnais interne par rapport au sous-ensemble vérifié par SWE-Bench — un benchmark fréquemment utilisé pour comparer les modèles d'ingénierie logicielle. Une évaluation pratique récente a révélé note humaine moyenne ≈ 7.6 Sur une suite de codage mixte, il est compétitif face à certains modèles à forte valeur ajoutée (par exemple, Gemini 2.5 Pro), mais reste en retrait par rapport à des modèles multimodaux/de type « meilleur raisonneur » plus importants, tels que Claude Opus 4 et Grok 4 de xAI, pour les tâches de raisonnement de difficulté élevée. Les tests de performance montrent également des variations selon la tâche : excellent pour les corrections de bugs courants et la génération de code concis, mais moins performant pour certains problèmes de niche ou spécifiques à une bibliothèque (exemple : Tailwind CSS).

Comparaison :

- contre Grok 4 : Grok-code-fast-1 échange une certaine exactitude absolue et un raisonnement plus approfondi contre coût bien inférieur et débit plus rapide; Grok 4 reste l'option la plus performante.

- vs Claude Opus / Classe GPT : Ces modèles conduisent souvent à des tâches complexes, créatives ou de raisonnement difficile ; Grok-code-fast-1 est compétitif sur les tâches de développement de routine à volume élevé où la latence et le coût sont importants.

Limites et risques

Limitations pratiques observées jusqu’à présent :

- Lacunes du domaine : baisses de performances sur des bibliothèques de niche ou problèmes inhabituellement formulés (par exemple, les cas limites de Tailwind CSS).

- Compromis entre le coût du jeton de raisonnement : étant donné que le modèle peut émettre des jetons de raisonnement internes, un raisonnement hautement agentique/verbeux peut augmenter la longueur de sortie d'inférence (et le coût).

- Précision / cas limites : tout en étant efficace dans les tâches de routine, Grok-code-fast-1 peut halluciner ou produire un code incorrect pour de nouveaux algorithmes ou des énoncés de problèmes contradictoires ; il peut sous-performer les meilleurs modèles axés sur le raisonnement sur des tests algorithmiques exigeants.

Cas d'utilisation typiques

- Assistance IDE et prototypage rapide : complétions rapides, écritures de code incrémentielles et débogage interactif.

- Agents automatisés / workflows de code : agents qui orchestrent les tests, exécutent les commandes et modifient les fichiers (par exemple, les assistants CI, les réviseurs de robots).

- Tâches d'ingénierie quotidiennes : génération de squelettes de code, refactorisations, suggestions de tri de bogues et échafaudage de projets multi-fichiers où une faible latence améliore considérablement le flux de développement.

Comment appeler l'API grok-code-fast-1 depuis CometAPI

grok-code-fast-1 Tarification de l'API dans CometAPI, 20 % de réduction sur le prix officiel :

- Jetons d'entrée : 0.16 $/M jetons

- Jetons de sortie : 2.0 $/M jetons

Étapes requises

- Se connecter à cometapi.comSi vous n'êtes pas encore notre utilisateur, veuillez d'abord vous inscrire

- Obtenez la clé API d'accès à l'interface. Cliquez sur « Ajouter un jeton » au niveau du jeton API dans l'espace personnel, récupérez la clé : sk-xxxxx et validez.

Utiliser la méthode

- Sélectionnez l'option "

grok-code-fast-1Point de terminaison pour envoyer la requête API et définir le corps de la requête. La méthode et le corps de la requête sont disponibles dans la documentation API de notre site web. Notre site web propose également le test Apifox pour plus de commodité. - Remplacer avec votre clé CometAPI réelle de votre compte.

- Insérez votre question ou demande dans le champ de contenu : c'est à cela que le modèle répondra.

- Traitez la réponse de l'API pour obtenir la réponse générée.

CometAPI fournit une API REST entièrement compatible, pour une migration fluide. Informations clés API doc:

- URL de base : https://api.cometapi.com/v1/chat/completions

- Noms de modèle: "

grok-code-fast-1" - Authentification: Jeton porteur via

Authorization: Bearer YOUR_CometAPI_API_KEYentête - Content-Type:

application/json.

Intégration et exemples d'API

Extrait de code Python pour un ChatComplétion appel via CometAPI :

pythonimport openai

openai.api_key = "YOUR_CometAPI_API_KEY"

openai.api_base = "https://api.cometapi.com/v1/chat/completions"

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize grok-code-fast-1's main features."}

]

response = openai.ChatCompletion.create(

model="grok-code-fast-1",

messages=messages,

temperature=0.7,

max_tokens=500

)

print(response.choices.message)

Voir aussi Grok 4