Le modèle o3 d'OpenAI représente une avancée significative dans l'IA de raisonnement à grande échelle, alliant des capacités de délibération améliorées à des intégrations d'outils robustes. Depuis son lancement en décembre 2024, o3 a été au cœur de l'attention du secteur, OpenAI le décrivant comme une « intelligence de génie » et une innovation en matière de nouvelles techniques de sécurité. Cet article synthétise les dernières actualités et publications officielles pour fournir un guide complet et détaillé sur l'accès à o3, que vous soyez utilisateur final de ChatGPT ou développeur utilisant l'API. Chaque section est présentée sous forme de question pour faciliter la navigation, avec des sous-sections détaillées offrant des informations plus approfondies.

Qu'est-ce que o3 par OpenAI ?

Origines et sortie

OpenAI a présenté o3 pour la première fois le 20 décembre 2024 lors de son événement « 12 jours d'OpenAI ». Ce modèle, nommé ainsi pour éviter toute confusion avec l'opérateur télécom O2, succède au modèle de raisonnement original o1 et est conçu pour consacrer davantage de temps de calcul à la génération de réponses. Lancé le 16 avril 2025, aux côtés de son homologue plus petit o4-mini, o3 offre des capacités inégalées aux développeurs, aux chercheurs et aux équipes d'entreprise.

COMPÉTENCES FONDAMENTALES

o3 s'appuie sur une architecture de transformateurs, complétée par ce qu'OpenAI appelle une « chaîne de pensée privée », lui permettant de planifier en interne des processus de raisonnement en plusieurs étapes. Il en résulte des performances nettement améliorées sur des tâches complexes, notamment dans les domaines STEM tels que les mathématiques avancées, le codage et la résolution de problèmes scientifiques, où il atteint des niveaux de précision plusieurs fois supérieurs à ceux de son prédécesseur.

En quoi o3 diffère-t-il de ses prédécesseurs ?

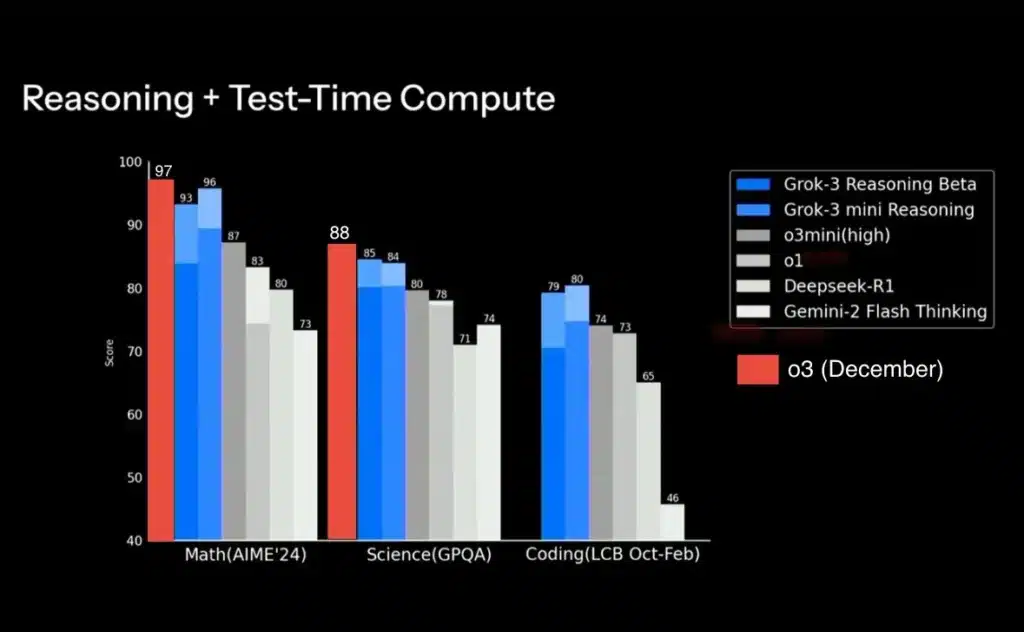

OpenAI o3 s'appuie sur le framework « o-series » de l'entreprise, qui privilégie une délibération interne approfondie (ou « chaîne de pensée privée ») avant la production de résultats. Contrairement à o1, qui offrait de solides performances sur les tâches générales, o3 a été entraîné à allouer des ressources de calcul supplémentaires aux requêtes exigeant un raisonnement intensif, ce qui a permis d'obtenir des scores nettement supérieurs sur des benchmarks tels que GPQA Diamond (87.7 % contre les performances inférieures d'o1) et aux tests de codage avancés sur Codeforces (Elo 2727 contre 1 pour o1891). Lors de tests comparatifs, o3 égale ou dépasse o1 dans les tâches STEM, logique et résolution créative de problèmes, avec toutefois une latence légèrement supérieure en raison de son processus de raisonnement plus approfondi.

Qui peut accéder à o3 ?

Quels niveaux d'abonnement ChatGPT incluent o3 ?

Depuis le 16 avril 2025, o3 est disponible pour les abonnés ChatGPT Plus, Pro et Team. Les utilisateurs Plus et Team peuvent sélectionner o3 (ou o4-mini) directement dans le sélecteur de modèles, remplaçant ainsi l'ancienne option o1-mini et bénéficiant de limites de débit plus élevées : jusqu'à 150 messages par jour pour o3-mini contre 50 auparavant. Les utilisateurs Pro ont accès à o3 et à sa variante o3-pro, plus puissante, dès son lancement, avec une utilisation illimitée dans le cadre de leur abonnement. Les utilisateurs de l'offre gratuite continuent d'accéder aux modèles GPT-4.5 et GPT-4o standard, mais doivent effectuer une mise à niveau pour accéder à la pile de raisonnement avancée d'o3.

Comment les clients API peuvent-ils utiliser o3 ?

Les développeurs utilisant l'API OpenAI peuvent appeler o3 dès qu'ils remplissent les conditions d'accès mises à jour. Selon la documentation API la plus récente d'OpenAI, les points de terminaison o3 sont activés pour tous les utilisateurs disposant d'une clé API valide, mais leur utilisation est soumise aux mêmes limites de débit et à la même structure de facturation que les autres modèles. Depuis le 11 mars 2025, les API « Réponses » et « Outils » prennent en charge les appels o3 avec les plugins de recherche web, de recherche de fichiers et d'exécution de code, permettant ainsi la création d'agents personnalisés basés sur les capacités de raisonnement d'o3.

Comment pouvez-vous accéder à o3 via ChatGPT ?

Quelles étapes permettent de déverrouiller o3 dans l'interface ChatGPT ?

- Connectez-vous et accédez aux paramètres:Ouvrez ChatGPT dans votre navigateur ou votre application de bureau, puis cliquez sur l’icône de votre profil (en bas à gauche) et sélectionnez « Paramètres ».

- Choisissez votre niveau d'abonnement: Vérifiez que vous êtes abonné à un abonnement Plus, Pro ou Team. Sinon, passez à un abonnement supérieur via le lien « Gérer l'abonnement ».

- Ouvrir le sélecteur de modèle:Dans n'importe quelle fenêtre de conversation, cliquez sur le nom du modèle en haut à gauche (la valeur par défaut peut être « GPT-4 »).

- **Sélectionnez « o3 » ou « o4-mini »**Recherchez la liste des modèles de la série O ; l'O3 apparaîtra aux côtés de l'O4-mini et du GPT-4. Cliquez sur « O3 » pour commencer à utiliser le modèle immédiatement.

- **Ajuster le niveau de raisonnement (o3-mini uniquement)**Dans les « Paramètres avancés » de ChatGPT, vous pouvez choisir entre un effort de raisonnement faible, moyen ou élevé pour les variantes o3-mini. Le niveau moyen est la valeur par défaut ; un niveau élevé consomme plus de calcul, mais peut produire des solutions étape par étape plus complètes.

Comment pouvez-vous confirmer que o3 est actif ?

Une fois o3 sélectionné, l'en-tête de la conversation affichera « Modèle : o3 ». Vous pouvez également tester en lançant une requête de raisonnement en plusieurs étapes, par exemple « Expliquer et résoudre le problème de Monty Hall étape par étape », et en observant la profondeur de l'explication de la chaîne de pensée. Si la réponse présente des étapes intermédiaires explicites, vous exploitez la chaîne de pensée privée d'o3.

Comment les développeurs peuvent-ils intégrer o3 via l'API ?

Clés API et authentification

- Obtenir une clé API en vous connectant à platform.openai.com et en accédant à « Clés API ».

- Générer une nouvelle clé si vous n'en avez pas déjà un.

- Rangez votre clé en toute sécurité : ne le codez jamais en dur dans des référentiels publics.

- Définir la variable d'environnement:

export OPENAI_API_KEY="your_api_key_here"Cette clé donne accès à tous les points de terminaison abonnés, y compris o3.

Configuration du point de terminaison

Dans votre code d'application, spécifiez le paramètre de modèle comme "o3". Par exemple, en utilisant Python avec le SDK d'OpenAI :

import openai

response = openai.ChatCompletion.create(

model="o3",

messages=,

temperature=0.7

)

print(response.choices.message.content)

Ajustez les paramètres comme temperature, max_tokenset stream adapté à votre cas d'utilisation. Si vous avez besoin d'une latence ou d'un coût plus faible, envisagez o4-mini variante en spécifiant "o4-mini".

Quelles sont les limites de prix et de taux ?

o3 est proposé à un tarif premium (environ 1.5 fois supérieur au coût des jetons GPT-4), reflétant son utilisation étendue du calcul. Les limites de débit varient selon le niveau de compte, mais autorisent généralement 40 requêtes/minute pour les utilisateurs d'API standard, avec une capacité de pointe disponible sur demande pour les entreprises. L'utilisation est mesurée par jeton (entrée + sortie), et des informations détaillées sur la facturation sont disponibles dans le tableau de bord.

Accéder à l'API o3 dans CometAPI

CometAPI fournit une interface REST unifiée qui regroupe des centaines de modèles d'IA, dont la famille Gemini de Google, sous un point de terminaison cohérent, avec gestion intégrée des clés API, des quotas d'utilisation et des tableaux de bord de facturation. Plus besoin de jongler avec plusieurs URL et identifiants de fournisseurs.

Les développeurs peuvent accéder API O3 à travers API CometPour commencer, explorez les capacités du modèle dans le Playground et consultez le Guide de l'API pour des instructions détaillées.

Quelles sont les exigences système et les meilleures pratiques applicables ?

Y a-t-il des considérations de latence ou de calcul ?

Le raisonnement plus approfondi d'o3 entraîne une latence plus élevée : les réponses peuvent prendre 0.5 à 1.5 seconde de plus que GPT-4, selon la complexité de la requête. Lorsque les performances sont critiques, les développeurs peuvent opter pour o4-mini, qui offre des gains de raisonnement similaires avec un coût et une latence réduits, ou ajuster le niveau de raisonnement d'o3-mini pour un équilibre entre vitesse et profondeur.

Comment structurer les invites pour obtenir des résultats optimaux ?

Une incitation efficace avec o3 implique :

- Demandes explicites en plusieurs étapes: Encadrez les requêtes qui guident la chaîne de pensée (par exemple, « Énumérez chaque hypothèse avant de résoudre… »).

- Directives contextuelles de l'outil:Lorsque vous utilisez des plugins, spécifiez l'outil à utiliser pour la recherche sur le Web ou l'analyse de fichiers dans la conversation.

- Gestion des jetons:Les longues fenêtres de contexte (jusqu'à 128 XNUMX jetons pris en charge) permettent des documents volumineux, mais soyez attentif aux coûts des jetons.

Comment les chercheurs en sécurité peuvent-ils accéder rapidement à o3-pro ?

Qu'est-ce que o3-pro et pourquoi est-il spécial ?

o3-pro est la prochaine version professionnelle d'o3. Elle offre une prise en charge complète des outils, des limites de débit plus élevées et des protections supplémentaires pour les applications sensibles ou à enjeux élevés. OpenAI prévoit sa sortie fin trimestre 2, avec des créneaux d'accès anticipé réservés aux équipes de recherche en sécurité et sûreté afin d'évaluer la robustesse, la confidentialité et la réduction des biais.

Comment faire une demande de services d'accès anticipé ?

Les chercheurs en sécurité peuvent postuler en remplissant le formulaire « Services d'accès anticipé » sur la page des politiques d'OpenAI. Les candidats doivent accepter des conditions supplémentaires concernant la divulgation responsable, les rapports d'utilisation et le respect des conditions commerciales de l'API. Les candidats anticipés sont généralement informés dans les deux semaines suivant leur soumission et doivent passer une vérification d'identité et d'organisation avant de recevoir les identifiants API pour les tests o3-pro.

Comment exploiter les fonctionnalités avancées d'o3 dans la pratique

Comment intégrer le raisonnement par image dans les flux de travail ?

Dans ChatGPT, il suffit d'importer une image (graphique, croquis ou photo prise sur un tableau blanc) dans la conversation. Sélectionnez o3 et demandez au modèle d'analyser ou de transformer l'image (« Faire pivoter ce diagramme de 90 degrés et nommer chaque axe »). o3 traitera l'entrée visuelle, effectuera les manipulations demandées et expliquera les étapes de son raisonnement en langage naturel.

Comment o3 peut-il améliorer la recherche en temps réel grâce à la navigation Web ?

En activant le plugin « Navigation Web » dans vos paramètres ChatGPT, o3 peut lancer des recherches, récupérer des extraits web en direct et citer des sources directement dans ses réponses. Par exemple, si vous demandez « Quelles sont les dernières découvertes sur les effets hors cible de CRISPR ? », o3 est invité à rassembler des études récentes, à résumer les principaux résultats et à inclure des références cliquables, accélérant ainsi les revues de littérature et les vérifications de faits en quelques minutes.

Conclusion

Le modèle o3 d'OpenAI ouvre une nouvelle ère du raisonnement piloté par l'IA, combinant des capacités approfondies de chaîne de pensée avec une intégration transparente des outils, allant des recherches web en direct à l'analyse d'images multimodales. L'accès à o3 est simple pour les abonnés ChatGPT Plus, Pro et Team, et les développeurs peuvent l'appeler via l'API standard avec un minimum de modifications du code existant. Les chercheurs en sécurité souhaitant un accès anticipé au prochain o3-pro peuvent postuler dans le cadre du programme spécialisé d'OpenAI. En suivant les étapes décrites ici et en adoptant les meilleures pratiques en matière de conception rapide et d'utilisation des outils, vous pouvez exploiter tout le potentiel d'o3 pour automatiser des flux de travail complexes, accélérer la recherche et créer des applications d'IA plus intelligentes.