OpenAI a récemment annoncé plusieurs mises à jour, notamment la publication du modèle GPT-5-Codex-Mini, des améliorations de la limite de débit pour les hiérarchies multi-utilisateurs et des optimisations de l'efficacité du traitement des modèles.

OpenAI's GPT-5-Codex-Mini GPT-5Codex est une nouvelle variante, spécialement conçue pour les développeurs : un modèle plus compact, optimisé en termes de coûts et de débit, offrant la plupart des fonctionnalités d'assistance au codage de GPT-5Codex, mais à un coût bien moindre et avec un volume d'utilisation supérieur. La variante « Mini » se positionne comme une solution pragmatique pour les longues sessions de codage, l'automatisation en arrière-plan et les flux de travail de développement à haute fréquence, où la capacité de pointe brute est moins importante que l'obtention d'un plus grand nombre de jetons/requêtes pour un même forfait.

Qu'est-ce que GPT-5-Codex-Mini et quelles sont ses caractéristiques ?

GPT-5-Codex-Mini est une variante compacte et économique de la famille GPT-5-Codex d'OpenAI, spécialement conçue pour les interfaces de développement Codex (intégration en ligne de commande et en environnement de développement intégré). Ce modèle, plus petit et plus économique, sacrifie légèrement les performances maximales au profit d'une consommation de ressources nettement inférieure et d'une capacité utilisable accrue pour les flux de travail interactifs des développeurs. Ce modèle Mini permet aux développeurs d'exécuter un nombre beaucoup plus important d'itérations de code (OpenAI le décrit comme suit : Utilisation 4 fois supérieure pour le même niveau d'abonnement ChatGPT) tout en maintenant la latence et les coûts à un niveau bas pour les tâches d'ingénierie courantes et bien définies.

En termes de fonctionnalités, GPT-5-Codex-Mini hérite des caractéristiques essentielles de la gamme Codex : une compréhension approfondie du code source et l’exécution de tâches en plusieurs étapes en tant qu’« agent ». Grâce à l’interface de ligne de commande (CLI) de Codex, les développeurs peuvent soumettre des commandes en langage naturel, des extraits de code, des captures d’écran ou des schémas de conception d’interface à Codex via un terminal interactif. Le modèle établit d’abord un plan, puis parcourt automatiquement les fichiers, modifie le code, exécute les commandes et effectue des tests après validation par l’utilisateur.

Du point de vue modal, les produits Codex permettent d'ajouter des images (captures d'écran d'interface utilisateur, ébauches de conception ou captures d'écran de messages d'erreur) à la session dans le terminal ou l'IDE. Le modèle comprend le contenu textuel et visuel, mais la sortie reste principalement du code et des explications. Par conséquent, GPT-5-Codex-Mini peut être considéré comme un modèle proxy de code qui prend principalement en charge « l'entrée texte + image, la sortie texte » et ne réalise pas de tâches telles que la génération d'images, d'audio ou de vidéo.

En quoi GPT-5-Codex-Mini se compare-t-il à GPT-5-Codex ?

Quoi de neuf dans Codex ?

En plus de la publication de GPT-5-Codex-Mini, OpenAI a augmenté uniformément la limite de requêtes Codex de 50 % pour les utilisateurs de ChatGPT Plus, Business et Edu, augmentant ainsi considérablement le nombre de requêtes disponibles. Parallèlement, les utilisateurs de ChatGPT Pro bénéficieront d'autorisations de traitement prioritaires pour une meilleure réactivité et une expérience d'exécution des tâches optimisée.

Par ailleurs, OpenAI a apporté une légère amélioration au modèle GPT-5-Codex, optimisant ainsi ses performances dans les scénarios collaboratifs. Le modèle mis à jour affiche des gains de plusieurs points de pourcentage sur les principaux indicateurs d'évaluation, une augmentation d'environ 3 % de l'efficacité d'utilisation des jetons et une plus grande robustesse face aux cas limites, réduisant de ce fait le besoin d'intervention de l'utilisateur.

| niveau de l'utilisateur | Codex GPT-5 | GPT-5-Codex-Mini |

|---|---|---|

| Plus/Biz/Edu | augmente le volume des messages de 1.5x respectivement. | augmente le volume des messages de 6 fois respectivement. |

Comparaison des performances de GPT-5 Codex Mini et GPT-5 Codex : différences de résultats

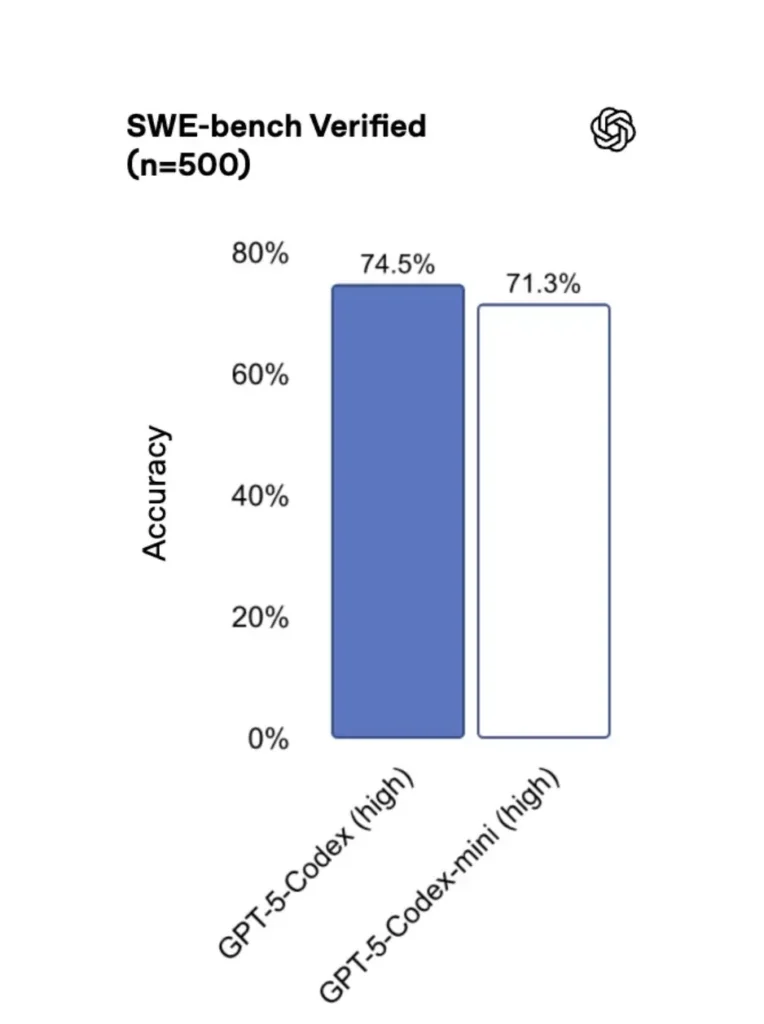

Comparé à la version originale, GPT-5-Codex-Mini offre des performances légèrement inférieures, mais les développeurs bénéficient d'un crédit d'utilisation environ quatre fois supérieur. Lors du test SWE-bench Verified, GPT-5 High a obtenu un score de 72.8 %, GPT-5-Codex de 74.5 % et GPT-5-Codex-Mini de 71.3 %.

Codex (et sa mini-variante) utilise beaucoup moins de jetons pour les interactions légères : les documents d’OpenAI annoncent des réductions de l’ordre de plusieurs dizaines de points de pourcentage pour les invites simples (par exemple, un chiffre cité de ≈93.7% de jetons en moins sur les interactions légères pour la famille Codex par rapport à GPT-5 dans certains scénarios).

GPT-5 Codex Mini vs GPT-5 Codex : différences de fonctionnalités

- Taille et coût : Mini est plus compact et plus économique ; OpenAI indique qu'il permet une utilisation environ quatre fois supérieure avec les mêmes contraintes d'abonnement. Il s'agit d'une optimisation des quotas et de l'efficacité pour les tâches courantes des développeurs.

- Enveloppe de capacité : GPT-5-Codex demeure l'option la plus performante pour les tâches complexes et de longue durée (refontes importantes, revues de code approfondies, cycles de tests prolongés). Mini est optimisé pour être plus réactif et moins gourmand en ressources pour les interactions courtes et fréquentes.

- Limites de latence et de débit : Mini offre généralement une latence plus faible et autorise des limites de débit plus élevées par forfait, ce qui le rend adapté aux flux de travail denses et interactifs.

- Surfaces par défaut : Mini est disponible en tant que modèle sélectionnable dans Codex CLI et l'extension IDE ; GPT-5-Codex est le modèle par défaut pour les tâches cloud et les flux d'analyse de code approfondis dans Codex.

Quand utiliser le Mini Codex plutôt que le Codex complet ?

- Utilisez le Mini pour : la création d'échafaudages, la génération de code répétitive, les petites refactorisations, les complétions interactives pendant l'édition et lorsque l'on travaille sous un quota ou une contrainte de coût.

- Utilisez le Codex GPT-5 pour : les revues de code complètes, les tâches autonomes de plusieurs heures, les refactorisations complexes et les tâches nécessitant le raisonnement le plus robuste du modèle et une exécution pilotée par les tests.

Comment puis-je accéder à GPT-5-Codex-Mini (CLI, IDE, API) ?

Interface de ligne de commande Codex (terminal en premier)

Introduction d'OpenAI gpt-5-codex-mini en tant qu'option de modèle dans l'interface de ligne de commande Codex. Les cas d'utilisation typiques suivent le flux de travail de l'interface de ligne de commande Codex : démarrer une session interactive, spécifier le modèle, joindre des fichiers ou des captures d'écran, exécuter des « tâches Codex Cloud », etc. L'interface de ligne de commande prend également en charge les commandes rapides. /model alternance entre le plein gpt-5-codex et gpt-5-codex-miniLors de la première exécution, vous devrez vous authentifier à l'aide de votre compte ChatGPT/Pro/Enterprise (ou fournir une clé API). L'interface de ligne de commande (CLI) propose diverses commandes permettant à Codex d'analyser les bases de code, d'exécuter des tests, d'ouvrir des REPL ou d'appliquer des recommandations de correctifs.

Exemple (session interactive Codex CLI) :

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

Ce flux reflète les nouveaux paramètres par défaut de l'interface de ligne de commande Codex, où l'outil suggérera Mini à l'approche des limites d'utilisation.

Extension VS Code / IDE

Oui, l'extension Codex pour VS Code l'inclut déjà. gpt-5-codex-mini En option, installez l'extension Codex dans Visual Studio Code pour bénéficier de la saisie semi-automatique, de suggestions de refactorisation et de corrections rapides basées sur l'IA. L'extension propose également des actions rapides (générer du code, expliquer le code sélectionné, refactoriser) et permet d'exécuter des tâches Codex Cloud directement depuis l'éditeur. Étapes VS Code :

- Installez l'extension OpenAI Codex / ChatGPT pour VS Code.

- Connectez-vous avec votre compte ChatGPT (Plus/Pro/Business).

- Ouvrez la palette de commandes :

Cmd/Ctrl+Shift+P → Codex: Set Model→ choisirgpt-5-codex-mini. - Utilisez les commandes en ligne (sélectionnez le code → clic droit → « Expliquer avec Codex » ou appuyez sur la touche de raccourci configurée).

Exemple : Commande en ligne VS Code (pseudo-étapes)

- Sélectionnez une fonction dans

user_service.py. - Presse

Cmd/Ctrl+Shift+P → Codex: Explain Selectionou utilisez le clic droit → « Expliquer avec Codex ». - L'extension ouvre un panneau latéral contenant les explications de Mini, des tests suggérés et un bouton « Créer une PR » accessible en un clic, qui utilise les tâches Codex Cloud pour envoyer une branche à la relecture.

Qu’en est-il de l’API ? Puis-je l’appeler depuis mon application ?

Les annonces d'OpenAI indiquent La prise en charge de l'API sera bientôt disponible. pour GPT-5-Codex-Mini ; au moment de la rédaction, le modèle est d’abord disponible dans la chaîne d’outils Codex (CLI/IDE). Cela signifie que les clients API en production doivent se préparer à l’utilisation du nom du modèle. gpt-5-codex-mini L'API Requêtes/Réponses sera disponible une fois publiée. En attendant, vous pouvez prototyper avec l'interface de ligne de commande Codex et les flux de l'IDE.

Lorsque l'accès à l'API est activé, un appel typique (de type Réponses) peut ressembler à ceci :

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Quelles sont les meilleures pratiques pour l'ingénierie rapide avec Codex Mini ?

Vous trouverez ci-dessous des bonnes pratiques et des modèles concrets et éprouvés sur le terrain pour tirer le meilleur parti de Codex Mini dans les flux de travail d'ingénierie de production.

1) Stratégie de sélection des modèles — combinaison et appariement

Utilisez Mini pour les tâches fréquentes et peu complexes (formatage, petites refactorisations, tests automatiques), et passez à Codex complet pour les conceptions complexes, le débogage approfondi ou les transformations importantes à l'échelle du dépôt. Automatisez la transition : l'interface de ligne de commande de Codex suggère déjà Mini à 90 % d'utilisation, et vous pouvez créer un script pour cela. /model adapter vos outils pour choisir un modèle en fonction de la complexité de la tâche.

2) Modèles d'ingénierie rapides

Créez des modèles d'invites courts et déterministes pour les tâches répétitives : génération de tests, brouillons de journal des modifications, génération de messages de commit et descriptions de demandes de tirage. Stockez-les sous forme d'extraits réutilisables dans votre dépôt ou comme préréglages d'invites Codex.

Exemple de modèle d'invite pour les tests unitaires :

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) Automatiser les mécanismes de sécurité — approbations et contrôle des éléments de configuration

N'autorisez jamais un modèle à envoyer directement du code sans validation humaine. Utilisez les modes d'approbation de Codex et les tâches Codex Cloud pour créer des différences et exiger une signature humaine dans l'intégration continue. L'interface de ligne de commande de Codex prend en charge les modes d'approbation ; les modifications doivent donc être approuvées avant d'être appliquées.

4) Mise en cache et déduplication des appels de modèle

Pour les requêtes répétitives (par exemple, l'explication d'une fonction), mettez en cache la réponse indexée par la requête et le hachage du fichier. Cela réduit les appels redondants et garantit un coût prévisible.

5) Utiliser le streaming + les différences incrémentales

Dans la mesure du possible, demandez des sorties en flux continu et des différences incrémentales plutôt que des réécritures complètes des fichiers. Cela réduit la consommation de jetons et aide les relecteurs à visualiser les modifications ciblées.

6) Test unitaire - premier flux du générateur

Générez des tests et exécutez-les localement dans un environnement éphémère. En cas d'échec, itérez sur le modèle en fournissant les correctifs correspondants. Présentez chaque itération sous forme d'invite distincte incluant les résultats des tests.

Exemple d'extrait de code d'automatisation en ligne de commande Codex (bash) :

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

Conclusion

GPT-5-Codex-Mini est une initiative pragmatique : elle reconnaît que les flux de travail des développeurs sont souvent caractérisés par de nombreuses interactions brèves où la latence, le coût et la continuité du flux sont essentiels. En proposant une version allégée, conçue pour une utilisation dans les IDE et les interfaces en ligne de commande, OpenAI permet aux équipes d'adapter l'assistance au codage au quotidien sans avoir à solliciter systématiquement le modèle le plus gourmand en ressources pour chaque interaction.

Les développeurs peuvent accéder API GPT-5-Codex ,API GPT-5 Pro Grâce à CometAPI, les derniers modèles de CometAPI répertoriés sont ceux en vigueur à la date de publication de l'article. Avant d'y accéder, assurez-vous d'être connecté à CometAPI et d'avoir obtenu la clé API.API Comet proposer un prix bien inférieur au prix officiel pour vous aider à vous intégrer.

Prêt à partir ?→ Inscrivez-vous à CometAPI dès aujourd'hui !

Si vous souhaitez connaître plus de conseils, de guides et d'actualités sur l'IA, suivez-nous sur VK, X et Discord!