Depuis août, l'actualité de Gemini 3.0 est au cœur des discussions chez les développeurs. Les articles de presse annoncent sans cesse sa date de sortie, sans que rien ne se concrétise. Les espoirs ont été maintes fois déçus, mais l'attente reste vive, car les performances de Gemini 2.5 Pro sont déjà inférieures à celles de ses concurrents, Chatgpt et Claude. Je vous apporte aujourd'hui les dernières informations de première main : Gemini 3.0 est désormais disponible sur . API Comet.

La nouvelle génération de Gemini 3 de Google a généré plus de discussions alimentées par les fuites que la plupart des lancements de produits : des points de contrôle communautaires apparaissent sur des sites de benchmarking publics, des noms de modèles apparaissent dans les propres outils de Google et un parcours de développement actif permet d’essayer les modèles via l’interface de ligne de commande Gemini et l’API Comet.

Qu’est-ce que Gemini 3.0 — et pourquoi est-il si attendu ?

En résumé, Gemini 3.0 est le prochaine itération majeure de la famille Gemini de grands modèles d'IA multimodaux développés par Google DeepMind (et sa maison mère Google LLC). La série Gemini est présentée comme la gamme phare de modèles d'IA de Google — conçue non seulement pour la compréhension et la génération de texte, mais aussi pour tâches multimodales (texte + image + code + audio/vidéo), raisonnement, utilisation d'outils et, au final, comportement plus autonome.

La raison pour laquelle les gens sont si enthousiastes à propos de Gemini 3.0 est qu'il semble représenter un grand bond en avant — et pas seulement une petite mise à jour — en termes de capacités du modèle, de longueur du contexte, de raisonnement et d'utilité concrète. Des fuites au sein de la communauté, des références de code, des résultats de tests de performance et des articles suggèrent que Gemini 3.0 explorera de nouveaux horizons : les « modèles pensants », des fenêtres de contexte plus longues, une intégration multimodale plus poussée et une orchestration d'outils multi-agents.

Ci-dessous, je vais détailler précisément. why ça compte, ce que nous savons jusqu'à présentet ce qui reste spéculatif.

Que sont « lithiumflow » et « orionmist », et pourquoi sont-ils apparus sur LMArena ?

Qu'ont découvert LM Arena et la communauté ?

Du 19 au 23 octobre, les enquêteurs de la communauté ont découvert deux nouveaux points de contrôle LM Arena nommés lithiumflow et orionmist. Ces noms semblent conformes aux conventions de dénomination internes de Google (le nom de famille « orion » a déjà été utilisé dans d'anciens noms de code Gemini), et les analystes de la communauté les interprètent comme des identifiants ou des points de contrôle préliminaires pour des variantes de Gemini 3.x, communément appelées points de contrôle Gemini 3 Pro / Flash.

En quoi est-ce important?

Si Lithiumflow et Orionmist constituent bien des points de contrôle Gemini 3, leur séparation suggère que Google pourrait préparer plusieurs sous-familles (Flash et Pro) : par exemple, une variante « Lithiumflow » optimisée pour le débit et l’efficacité, et une variante « Orionmist » adaptée à la recherche en temps réel ou aux capacités multimodales. Lithiumflow semble (d’après les spéculations de la communauté) être le modèle de génération de base, optimisé pour le raisonnement et la génération (sans ancrage de la recherche). Orionmist semble être une variante intégrant des données externes et la recherche en temps réel, potentiellement plus performante pour la génération augmentée par la recherche ou les tâches « en direct ».

Mon test

Les enregistrements de LM Arena montrent très fort Résultats de LithiumFlow sur des tâches de traitement du langage classique (raisonnement, code et certaines tâches SVG/mise en page). Plusieurs analystes de la communauté ont également publié des comparaisons directes affirmant que LithiumFlow surpasse Gemini 2.x (version publique) et d'autres logiciels similaires sur des microbenchmarks spécifiques.

L'utilisation de Lithiumflow pour l'écriture offre une créativité et une qualité littéraire supérieures à celles de Gemini 2.5, mais sa limite de mots (deux à trois mille) demeure un point faible. Combiné à OrionMist, il rivalise avec Claude 4.5 en termes de performances et de précision de codage, mais la différence reste minime.

Voici comment ces modèles se comparent dans les tests de référence effectués jusqu'à présent :

| référence | Gemini 3.0 (lithiumflow) | Gémeaux 3.0 (brume d'Orion) | Gémeaux 2.5 Pro | Claude Opus 4.1 | Claude 3.7 Sonnet |

|---|---|---|---|---|---|

| SimpleBench | 80 to 100 % | 80 to 100 % | 62.4% | 60.0% | 46.4% |

Les deux modèles présentaient encore des illusions et des instabilités dans certaines tâches de connaissance, ce qui est compréhensible pour une version préliminaire. Ce schéma (excellentes performances dans les tâches créatives et la génération d'une structure/d'un code de grande qualité, mais parfois des erreurs factuelles) est fréquent lorsque les modèles sont associés à de nouvelles fonctionnalités multimodales ou de génération de code.

Les tests de ces deux modèles ont été achevés à la LM Arena, confirmant ainsi qu'il s'agit bien de Gemini 3.0.

L'implication d'Apple et les spécifications divulguées

Différences entre les modèles

Au milieu de 2025, Apple Des extraits de code auraient fuité dans une version bêta d'iOS, montrant des identifiants tels que : com.google.gemini_3_pro et gemini_3_ultra.

Les analystes ont déduit que Google et Apple se préparaient. Intégrations « Apple Intelligence » optimisées par Gemini, probablement pour Siri et la synthèse intégrée à l'appareil :

- Gemini 3 Pro (couche de raisonnement basée sur le cloud)

- Gemini 3 Nano (variante intégrée)

- Inférence multimodale en temps réel

Cela correspond à la volonté de Google de développer un Tissu d'IA connecter les appareils mobiles, les API cloud et l'écosystème web.

Fuite de spécifications

Apple et Google négocient une intégration plus poussée de Gemini pour Apple Intelligence/Siri : selon une information exclusive, Apple envisage d’utiliser une version personnalisée de Gemini dans son architecture d’IA. Apple et Google ont mentionné le paramètre 1.2T dans leur plan de collaboration pour les modèles d’intelligence artificielle, ce qui pourrait correspondre à la spécification de Gemini 3.0.

Comment démarrer avec l'aperçu de Gemini 3 Pro

D'après les informations et les tests disponibles, trois méthodes sont proposées : Vertex, l'interface de ligne de commande Gemini et l'API. Les développeurs peuvent choisir la méthode la plus adaptée à leurs besoins et à leur environnement. Les noms des modèles Gemini 3.0 Pro sont : gemini-3-pro-preview-11-2025 et gemini-3-pro-preview-11-2025-thinking.

Accéder au sommet

Gemini 3.0 pro (gemini-3-pro-preview-11-2025) a été ajouté à la liste des modèles de Vertex, et certains utilisateurs de la communauté affirment pouvoir le tester directement, à condition de posséder un compte Vertex payant et d'y accéder avec leurs identifiants. En effet, des traces sont visibles dans les journaux réseau de Vertex :

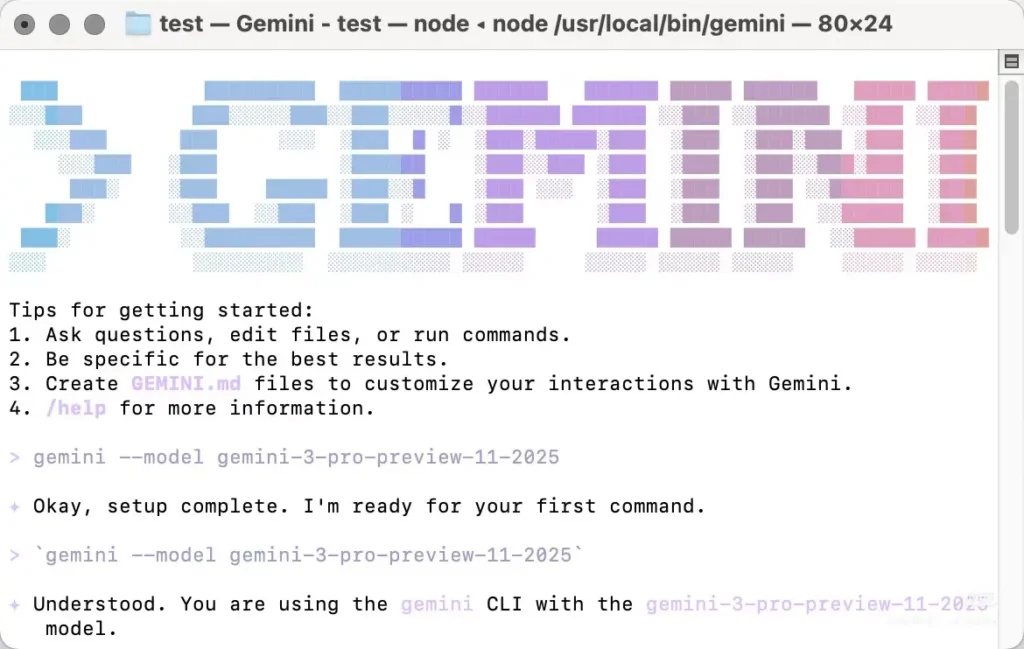

Accéder au cli Gemini

Gemini 3.0 Pro peut également être appelé via l'interface de ligne de commande Gemini (Gemini CLI), mais le modèle doit être spécifié manuellement. La plupart des tests récents de Gemini 3.0 Pro sont basés sur son utilisation via Gemini CLI. Cependant, cette méthode présente certains inconvénients : elle ne fonctionne qu'avec certains nœuds nord-américains, ce qui nécessite de modifier manuellement son adresse IP locale et parfois de réessayer. De plus, elle est instable et renvoie une erreur 404 en cas d'échec.

Vous devez installer l'interface de ligne de commande Gemini localement, puis authentifiez-vous avec un compte disposant des autorisations d'accès (compte Google / compte CometAPI) et spécifiez manuellement le nom du modèle «gemini-3-pro-preview-11-2025Pour utiliser Gemini 3.0 pro-preview, par exemple : installez et exécutez (shell)

```bash

# instant run (no install)

npx https://github.com/google-gemini/gemini-cli

or install globally:

npm install -g @google/gemini-cli

# or on macOS/Linux using Homebrew

brew install gemini-cli

L'interface de ligne de commande (CLI) accepte les identifiants de modèle de la même manière que l'API. Concrètement : définissez votre identifiant de modèle (par exemple, `model: "gemini-3-pro-preview-11-2025"`) dans une requête ou une configuration CLI et l'invoquer — si votre compte y a accès, la requête réussira.

### Accédez à l'API de CometAPI

[API Comet](https://www.cometapi.com/fr/) est une plateforme API unifiée qui regroupe plus de 500 modèles d'IA provenant de fournisseurs de premier plan — tels que la série GPT d'OpenAI, Gemini de Google, Claude d'Anthropic, Midjourney, Suno, et bien d'autres — au sein d'une interface unique et conviviale pour les développeurs. Elle offre une authentification, un formatage des requêtes et une gestion des réponses uniformes.

CometAPI a intégré [Aperçu de l'API Gemini 3 Pro](https://www.cometapi.com/fr/gemini-3-pro-api/) , et le nom de l'appel API interne est `gemini-3-pro-preview`Lors de l'appel, il vous suffit de modifier l'adresse de requête en `https://api.cometapi.com/v1/chat/completions`.

Vous pouvez appeler la préversion pro de Gemini 3.0 de la même manière que l'API OpenAI. Lors de mes tests, l'appel via CometAPI s'est avéré plus stable que l'utilisation de l'interface de ligne de commande Gemini.

## Quelles sont les caractéristiques prévues de Gemini 3.0 ?

Vous trouverez ci-dessous les fonctionnalités les plus discutées (avec une indication explicite des éléments confirmés par rapport aux attentes de la communauté/des analystes).

### Conception et architecture de base (confirmées vs. attendues)

- **Fondation multimodale :** Gemini est conçu comme une famille multimodale (texte, images, code, audio/vidéo), et Google a déjà publié des modèles et des outils multimodaux dans l'API Gemini. Ce point est confirmé et restera central.

- **Raisonnement/planification avancés :** Attendez-vous à une intégration plus poussée des techniques de planification et d'apprentissage par renforcement, fruit des recherches de DeepMind ; une différence notable dans la conception par rapport à certains concurrents. Cette attente repose sur l'historique de DeepMind plutôt que sur des spécifications publiques.

### Fenêtre de contexte et mémoire

Fenêtres de contexte plus longues : Gemini 3.0 devrait accroître la capacité de contexte effective (les discussions évoquent des millions de jetons), en s’appuyant sur des travaux antérieurs portant sur les contextes de grande envergure. Il s’agit d’une prédiction ; Google n’a pas encore publié les limites officielles de jetons pour Gemini 3.0.

### Performances, latence et variantes de modèles

- **Haute précision de raisonnement et de codage :** Les publications de la communauté LM Arena concernant « lithiumflow » (et « orionmist ») suggèrent d'excellentes performances en matière de raisonnement et de programmation. Bien qu'il s'agisse de benchmarks communautaires non vérifiés, ils constituent la principale source d'enthousiasme. Il convient de les considérer comme des signaux préliminaires et non comme une preuve définitive.

- **Plusieurs variantes :** Les rumeurs et les fuites évoquent différentes versions : une version brute/« Pro » (souvent associée au tag lithiumflow) et une version optimisée pour la recherche (orionmist). Il s’agit là encore de déductions de la communauté basées sur les identifiants des modèles et les comportements observés lors des tests.

### Multimodalité et nouvelles capacités

- **Intégration vidéo et image :** Google a récemment intégré des modèles vidéo (par exemple, Veo 3) et des fonctionnalités d'image à l'API Gemini ; Gemini 3.0 devrait exploiter et unifier ces fonctionnalités pour des flux de travail multimodaux plus riches. Cette architecture est compatible avec les versions précédentes de l'écosystème Gemini de Google.

- **Fonctionnalités intégrées et de confidentialité (objectif) :**On s'attend à des options plus efficaces, sur l'appareil ou dans un cloud privé, pour les données sensibles, car Google et ses partenaires privilégient la confidentialité et une faible latence. Cette prédiction s'appuie sur les tendances de l'écosystème ; les détails de Gemini 3.0 ne sont pas encore publics.

## En résumé

La version préliminaire de Gemini 3.0 Pro devrait constituer une avancée majeure pour les modèles multimodaux de Google, axés sur le raisonnement, en offrant potentiellement un contexte plus étendu, une planification plus robuste et des capacités multimodales plus riches. L'enthousiasme actuel s'explique par un mélange de… **Des outils de développement et des signaux produits Google ont été confirmés.** (API Gemini, CLI, modèles vidéo Veo) et **signaux communautaires non officiels mais bruyants** (Entrées de LM Arena pour lithiumflow/orionmist, fuites et chronologie des rumeurs d'analystes). Considérez les benchmarks de la communauté comme des indicateurs préliminaires et préparez-vous en apprenant à utiliser les outils de développement Gemini afin de pouvoir évaluer le modèle objectivement lorsque Google en ouvrira l'accès officiel.

Je pense que la date de sortie officielle la plus probable est le 18 novembre, ce qui coïncide avec le plan de migration des modèles de Google prévu le même jour. Attendons avec impatience plus d'informations sur l'aperçu du Gemini 3 Pro !

### Pour commencer

CometAPI est une plateforme d'API unifiée qui regroupe plus de 500 modèles d'IA provenant de fournisseurs leaders, tels que la série GPT d'OpenAI, Gemini de Google, Claude d'Anthropic, Midjourney, Suno, etc., au sein d'une interface unique et conviviale pour les développeurs. En offrant une authentification, un formatage des requêtes et une gestion des réponses cohérents, CometAPI simplifie considérablement l'intégration des fonctionnalités d'IA dans vos applications. Que vous développiez des chatbots, des générateurs d'images, des compositeurs de musique ou des pipelines d'analyse pilotés par les données, CometAPI vous permet d'itérer plus rapidement, de maîtriser les coûts et de rester indépendant des fournisseurs, tout en exploitant les dernières avancées de l'écosystème de l'IA.

Les développeurs peuvent accéder à la préversion professionnelle de Gemini 3.0 via CometAPI. [la dernière version du modèle](https://api.cometapi.com/pricing) est constamment mis à jour avec le site officiel. Pour commencer, explorez les capacités du modèle dans la section [cour de récréation](https://www.cometapi.com/console/playground) et consultez le [Guide de l'API](https://api.cometapi.com/doc) Pour des instructions détaillées, veuillez vous connecter à CometAPI et obtenir la clé API avant d'y accéder. [API Comet](https://www.cometapi.com/fr/) proposer un prix bien inférieur au prix officiel pour vous aider à vous intégrer.

Prêt à partir ?→ [Inscrivez-vous à CometAPI dès aujourd'hui](https://api.cometapi.com/login) !

Si vous souhaitez connaître plus de conseils, de guides et d'actualités sur l'IA, suivez-nous sur [VK](https://vk.com/id1078176061), [X](https://x.com/cometapi2025) et [Discord](https://discord.com/invite/HMpuV6FCrG)!