Entre 2025 et 2026, le paysage des outils d'IA a continué de se consolider : les API de passerelle (comme CometAPI) se sont étendues pour offrir un accès de type OpenAI à des centaines de modèles, tandis que les applications LLM pour utilisateurs finaux (comme AnythingLLM) ont continué d'améliorer leur fournisseur « OpenAI générique » afin de permettre aux applications de bureau et locales d'appeler n'importe quel point de terminaison compatible OpenAI. Il est donc aujourd'hui simple d'acheminer le trafic AnythingLLM via CometAPI et de bénéficier du choix des modèles, du routage des coûts et d'une facturation unifiée, tout en conservant l'interface utilisateur locale et les fonctionnalités RAG/agent d'AnythingLLM.

Qu'est-ce qu'AnythingLLM et pourquoi voudriez-vous le connecter à CometAPI ?

Qu'est-ce que AnythingLLM ?

AnythingLLM est une application d'IA open source tout-en-un, avec un client local/cloud, permettant de créer des assistants conversationnels, des workflows de génération augmentée par récupération (RAG) et des agents pilotés par LLM. Elle offre une interface utilisateur élégante, une API développeur, des fonctionnalités d'espace de travail/agent et la prise en charge des LLM locaux et cloud. Conçue pour être privée par défaut, elle est extensible via des plugins. AnythingLLM expose un OpenAI générique fournisseur qui lui permet de communiquer avec les API LLM compatibles avec OpenAI.

Qu'est-ce que CometAPI ?

CometAPI est une plateforme commerciale d'agrégation d'API qui expose Plus de 500 modèles d'IA via une interface REST unique de type OpenAI et une facturation unifiée. Concrètement, cela permet d'appeler des modèles de plusieurs fournisseurs (OpenAI, Anthropic, variantes Google/Gemini, modèles d'image/audio, etc.) via la même interface. https://api.cometapi.com/v1 des points de terminaison et une seule clé API (format sk-xxxxxCometAPI prend en charge les points de terminaison standard de type OpenAI, tels que : /v1/chat/completions, /v1/embeddings, etc., ce qui facilite l'adaptation des outils qui prennent déjà en charge les API compatibles avec OpenAI.

Pourquoi intégrer AnythingLLM à CometAPI ?

Trois raisons pratiques :

- Choix du modèle et flexibilité du fournisseur : AnythingLLM peut utiliser n'importe quel LLM compatible avec OpenAI grâce à son wrapper OpenAI générique. En connectant ce wrapper à CometAPI, on accède immédiatement à des centaines de modèles sans modifier l'interface utilisateur ni les flux d'AnythingLLM.

- Optimisation des coûts et des opérations : L'utilisation de CometAPI vous permet de changer de modèle (ou de passer à des modèles moins chers) de manière centralisée pour maîtriser les coûts, et de conserver une facturation unifiée au lieu de jongler avec plusieurs clés de fournisseur.

- Expérimentation plus rapide : Vous pouvez comparer différents modèles (par exemple,

gpt-4o,gpt-4.5, variantes de Claude ou modèles multimodaux open-source) via la même interface utilisateur AnythingLLM — utile pour les agents, les réponses RAG, la synthèse et les tâches multimodales.

Vous devez préparer l'environnement et les conditions avant l'intégration.

Configuration système et logicielle requise (niveau général)

- Poste de travail ou serveur exécutant AnythingLLM (Windows, macOS, Linux) — installation sur le poste de travail ou instance auto-hébergée. Assurez-vous d'utiliser une version récente exposant le Préférences en matière de LLM / Fournisseurs d'IA paramètres.

- un compte CometAPI et une clé API (le

sk-xxxxx(secret de style). Vous utiliserez ce secret dans le fournisseur générique OpenAI d'AnythingLLM. - connectivité réseau de votre machine à

https://api.cometapi.com(aucun pare-feu ne bloque le trafic HTTPS sortant). - Facultatif mais recommandé : un environnement Python ou Node moderne pour les tests (Python 3.10+ ou Node 18+), curl et un client HTTP (Postman / HTTPie) pour vérifier le bon fonctionnement de CometAPI avant de l’intégrer à AnythingLLM.

Conditions spécifiques à AnythingLLM

La OpenAI générique Le fournisseur LLM est la solution recommandée pour les points de terminaison qui imitent l'interface API d'OpenAI. La documentation d'AnythingLLM précise que ce fournisseur est destiné aux développeurs et qu'il est important de bien comprendre les données d'entrée fournies. Si vous utilisez le streaming ou si votre point de terminaison ne le prend pas en charge, AnythingLLM propose une option pour désactiver le streaming pour OpenAI générique.

Liste de contrôle de sécurité et opérationnelle

- Traitez la clé CometAPI comme n'importe quel autre secret : ne l'enregistrez pas dans des dépôts ; stockez-la dans les trousseaux d'accès du système d'exploitation ou dans des variables d'environnement lorsque cela est possible.

- Si vous prévoyez d'utiliser des documents sensibles dans RAG, assurez-vous que les garanties de confidentialité des points de terminaison répondent à vos besoins de conformité (consultez la documentation/les conditions de CometAPI).

- Déterminez le nombre maximal de jetons et les limites de la fenêtre de contexte afin d'éviter une explosion des factures.

Comment configurer AnythingLLM pour utiliser CometAPI (étape par étape) ?

Vous trouverez ci-dessous une séquence d'étapes concrètes, suivie d'exemples de variables d'environnement et d'extraits de code pour tester la connexion avant d'enregistrer les paramètres dans l'interface utilisateur d'AnythingLLM.

Étape 1 — Obtenez votre clé CometAPI

- Inscrivez-vous ou connectez-vous sur CometAPI.

- Accédez à « Clés API » et générez une clé ; vous obtiendrez une chaîne de caractères ressemblant à :

sk-xxxxxGardez le secret.

Étape 2 — Vérifier que CometAPI fonctionne avec une requête rapide

Utilisez curl ou Python pour appeler un point de terminaison de complétion de chat simple afin de confirmer la connectivité.

Exemple de curl

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

Si cela renvoie un code 200 et une réponse JSON avec un choices Le tableau, votre clé et votre réseau fonctionnent. (La documentation de CometAPI présente l'interface et les points de terminaison de type OpenAI).

Exemple Python (requêtes)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

Étape 3 — Configurer AnythingLLM (interface utilisateur)

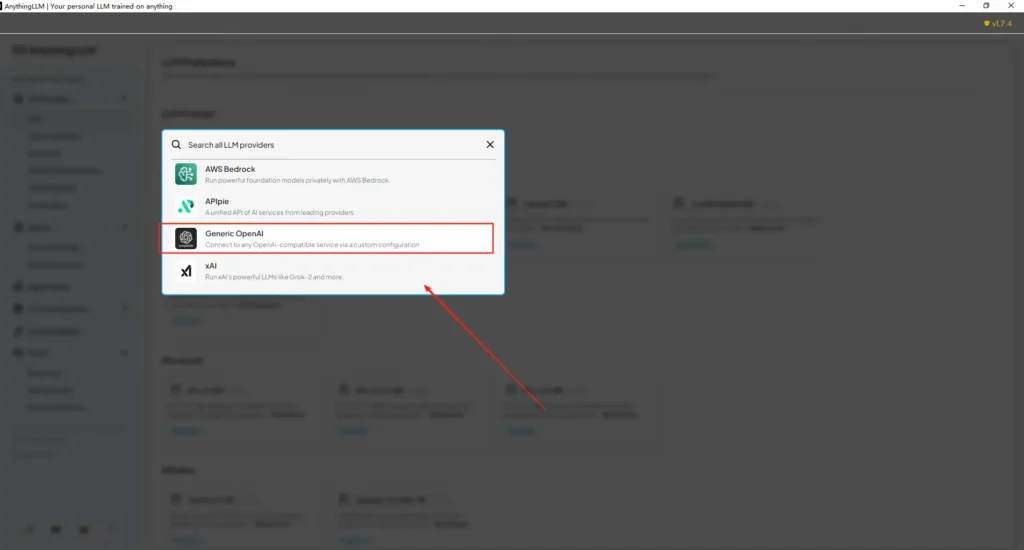

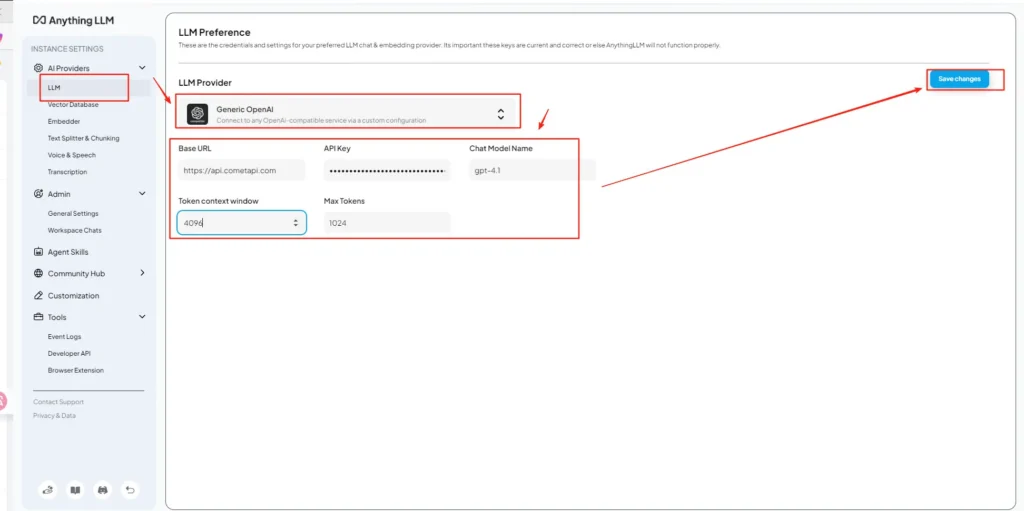

Ouvrir AnythingLLM → Paramètres → Fournisseurs d'IA → Préférences en matière de LLM (ou un chemin similaire dans votre version). Utilisez le OpenAI générique fournisseur et remplissez les champs comme suit :

Configuration de l'API (exemple)

• Accédez au menu des paramètres AnythingLLM, puis localisez les préférences LLM sous Fournisseurs d'IA.

• Sélectionnez Generic OpenAI comme fournisseur de modèle, puis saisissez les informations nécessaires.https://api.cometapi.com/v1dans le champ URL.

• Collez lesk-xxxxxSaisissez la clé API dans le champ prévu à cet effet. Renseignez les champs « Contexte du jeton » et « Nombre maximal de jetons » en fonction du modèle. Vous pouvez également personnaliser les noms de modèles sur cette page, par exemple en ajoutant…gpt-4o.

Cela correspond aux recommandations « OpenAI générique » d’AnythingLLM (interface pour développeurs) et à l’approche d’URL de base compatible OpenAI de CometAPI.

Étape 4 — Définir les noms de modèles et les limites de jetons

Sur le même écran de paramètres, ajoutez ou personnalisez les noms de modèles exactement comme CometAPI les publie (par exemple, gpt-4o, minimax-m2, kimi-k2-thinkingL'interface utilisateur d'AnythingLLM peut ainsi présenter ces modèles aux utilisateurs. CometAPI publie les chaînes de caractères des modèles pour chaque fournisseur.

Étape 5 — Testez sur AnythingLLM

Démarrez une nouvelle conversation ou utilisez un espace de travail existant, sélectionnez le fournisseur OpenAI générique (si vous en avez plusieurs), choisissez un des noms de modèles CometAPI que vous avez ajoutés et exécutez une simple invite de commande. Si les suggestions sont cohérentes, l'intégration est réussie.

Comment AnythingLLM utilise ces paramètres en interne

Le wrapper générique OpenAI d'AnythingLLM construit des requêtes de style OpenAI (/v1/chat/completions, /v1/embeddingsAinsi, une fois l'URL de base indiquée et la clé CometAPI fournie, AnythingLLM acheminera les conversations, les appels d'agents et les requêtes d'intégration via CometAPI de manière transparente. Si vous utilisez des agents AnythingLLM (les @agent (flux), ils hériteront du même fournisseur.

Quelles sont les meilleures pratiques et les pièges possibles ?

des pratiques d’excellence;

- Utilisez les paramètres de contexte appropriés au modèle : Faites correspondre la fenêtre de contexte de jetons et le nombre maximal de jetons d'AnythingLLM au modèle que vous avez sélectionné sur CometAPI. Une incompatibilité peut entraîner une troncature inattendue ou des appels infructueux.

- Sécurisez vos clés API : Stockez les clés CometAPI dans des variables d'environnement et/ou dans Kubernetes/un gestionnaire de secrets ; ne les enregistrez jamais dans Git. AnythingLLM stockera les clés dans ses paramètres locaux si vous les saisissez dans l'interface utilisateur ; considérez le stockage hôte comme sensible.

- Commencez par des modèles moins chers/plus petits pour les protocoles expérimentaux : Utilisez CometAPI pour tester des modèles à moindre coût en phase de développement et réservez les modèles premium à la production. CometAPI propose clairement la possibilité de changer de modèle économique et une facturation unifiée.

- Surveiller l'utilisation et configurer des alertes : CometAPI propose des tableaux de bord d'utilisation : définissez des budgets et des alertes pour éviter les factures surprises.

- Tester les agents et les outils de manière isolée : Les agents AnythingLLM peuvent déclencher des actions ; testez-les d’abord avec des invites sécurisées et sur des instances de test.

Pièges courants

- interface utilisateur vs

.envconflits : En cas d'auto-hébergement, les paramètres de l'interface utilisateur peuvent écraser.envmodifications (et vice versa). Vérifiez les résultats générés./app/server/.envSi le problème persiste après un redémarrage. Signaler un problème à la communautéLLM_PROVIDERréinitialise. - Incohérences dans le nom du modèle : L'utilisation d'un nom de modèle non disponible sur CometAPI entraînera une erreur 400/404 de la passerelle. Veuillez toujours vérifier la disponibilité des modèles sur la liste des modèles de CometAPI.

- Limites de jetons et streaming : Si vous avez besoin de réponses en flux continu, vérifiez que le modèle CometAPI le prend en charge (et que l'interface utilisateur d'AnythingLLM le prend également en charge). La sémantique du flux continu varie selon les fournisseurs.

Quels cas d'utilisation concrets cette intégration permet-elle de débloquer ?

Génération augmentée par récupération (RAG)

Utilisez les chargeurs de documents et la base de données vectorielle d'AnythingLLM avec les modèles de langage CometAPI pour générer des réponses contextuelles. Vous pouvez tester différentes approches : intégration économique et modèles de conversation plus sophistiqués, ou tout conserver sur CometAPI pour une facturation unifiée. Les flux RAG d'AnythingLLM sont une fonctionnalité intégrée essentielle.

Automatisation des agents

AnythingLLM prend en charge @agent Les flux de travail (navigation de pages, appels d'outils, exécution d'automatisations) sont gérés. Le routage des appels LLM des agents via CometAPI vous offre un choix de modèles pour les étapes de contrôle/interprétation sans modifier le code de l'agent.

Tests A/B multimodaux et optimisation des coûts

Changer de modèle par espace de travail ou par fonctionnalité (par exemple, gpt-4o pour les réponses de production, gpt-4o-mini (pour les développeurs). CometAPI simplifie les échanges de modèles et centralise les coûts.

pipelines multimodaux

CometAPI propose des modèles d'images, d'audio et des modèles spécialisés. La prise en charge multimodale d'AnythingLLM (via des fournisseurs) combinée aux modèles de CometAPI permet de réaliser des descriptions d'images, des résumés multimodaux ou des transcriptions audio via une interface unique.

Conclusion

CometAPI continue de se positionner comme une passerelle multimodèle (plus de 500 modèles, API de type OpenAI), ce qui en fait un partenaire naturel pour des applications telles qu'AnythingLLM, qui prennent déjà en charge un fournisseur OpenAI générique. De même, le fournisseur générique d'AnythingLLM et ses options de configuration récentes simplifient la connexion à ces passerelles. Cette convergence simplifie l'expérimentation et la migration en production fin 2025.

Comment démarrer avec l'API Comet

CometAPI est une plateforme d'API unifiée qui regroupe plus de 500 modèles d'IA provenant de fournisseurs leaders, tels que la série GPT d'OpenAI, Gemini de Google, Claude d'Anthropic, Midjourney, Suno, etc., au sein d'une interface unique et conviviale pour les développeurs. En offrant une authentification, un formatage des requêtes et une gestion des réponses cohérents, CometAPI simplifie considérablement l'intégration des fonctionnalités d'IA dans vos applications. Que vous développiez des chatbots, des générateurs d'images, des compositeurs de musique ou des pipelines d'analyse pilotés par les données, CometAPI vous permet d'itérer plus rapidement, de maîtriser les coûts et de rester indépendant des fournisseurs, tout en exploitant les dernières avancées de l'écosystème de l'IA.

Pour commencer, explorez les capacités du modèle deAPI Comet dans le cour de récréation Consultez le guide de l'API pour des instructions détaillées. Avant d'accéder à CometAPI, assurez-vous d'être connecté à CometAPI et d'avoir obtenu la clé API. AvecetAPI proposer un prix bien inférieur au prix officiel pour vous aider à vous intégrer.

Prêt à partir ?→ Inscrivez-vous à CometAPI dès aujourd'hui !

Si vous souhaitez connaître plus de conseils, de guides et d'actualités sur l'IA, suivez-nous sur VK, X et Discord!