L'IA évolue rapidement : de nouveaux modèles multimodaux et des API temps réel améliorées facilitent l'intégration d'IA performantes dans les plateformes d'automatisation, tandis que des débats parallèles sur la sécurité et l'observabilité transforment la façon dont les équipes gèrent les systèmes de production. Pour les développeurs d'automatisations locales, un modèle pratique émerge : utiliser une passerelle de modèle unifiée (comme API Comet) pour accéder à de nombreux modèles et assembler ces appels de modèle dans un exécuteur d'automatisation auto-hébergé (comme n8n) pour garder le contrôle des données, de la latence et des coûts. Ce guide vous explique, étape par étape, comment démarrer. CometAPI + n8n (local), ce à quoi il faut faire attention et comment résoudre les problèmes lorsque les choses tournent mal.

Qu'est-ce que n8n et pourquoi est-ce important pour l'automatisation de l'IA ?

n8n est un outil open source d'automatisation des workflows doté d'un éditeur visuel et d'un vaste écosystème de nœuds (connecteurs). Il est conçu pour vous permettre d'enchaîner des déclencheurs, des transformations et des appels d'API externes dans des workflows répétables (webhooks, tâches planifiées, traitement de fichiers, chatbots, etc.). L'auto-hébergement local de n8n vous offre un contrôle total sur la résidence et l'exécution des données, ce qui est particulièrement utile pour appeler des modèles d'IA tiers gérant des entrées sensibles.

Comment fonctionne n8n en pratique ?

- Canevas visuel avec déclencheurs (Webhook, Cron) et nœuds d'action (requête HTTP, nœuds de base de données, e-mail).

- Les nœuds communautaires étendent les capacités : vous pouvez installer des packages communautaires et les traiter comme des nœuds natifs.

L'auto-hébergement n8n vous offre :

- Contrôle total des données — les flux de travail et les données d’exécution restent sur l’infrastructure que vous gérez.

- Personnalisation — ajoutez des nœuds privés ou des intégrations locales sans attendre les fonctionnalités cloud.

- Prévisibilité des coûts — aucune surprise de facturation cloud par tâche pour une automatisation interne lourde.

- Sécurité et conformité — plus facile de répondre aux besoins internes en matière de politique et de réglementation.

Qu'est-ce que CometAPI et pourquoi l'utiliser comme passerelle de modèle ?

API Comet est une passerelle API unifiée qui expose des centaines de modèles d'IA tiers (texte, intégrations, génération d'images, etc.) derrière une interface et un modèle de facturation uniques, compatibles OpenAI. Ainsi, au lieu d'ajouter des intégrations sur mesure pour chaque LLM ou moteur d'images que vous souhaitez tester, vous appelez une API unique et sélectionnez le modèle souhaité dans la requête. Cela simplifie l'expérimentation, la maîtrise des coûts et l'intégration opérationnelle.

avantages:

- Choix du modèle : Essayez plusieurs fournisseurs/modèles avec le même chemin de code.

- Pooling de jetons / quotas gratuits : De nombreuses passerelles unifiées offrent des crédits/niveaux pour expérimenter.

- Infrastructure plus simple : Un système d'authentification et une URL de base à gérer.

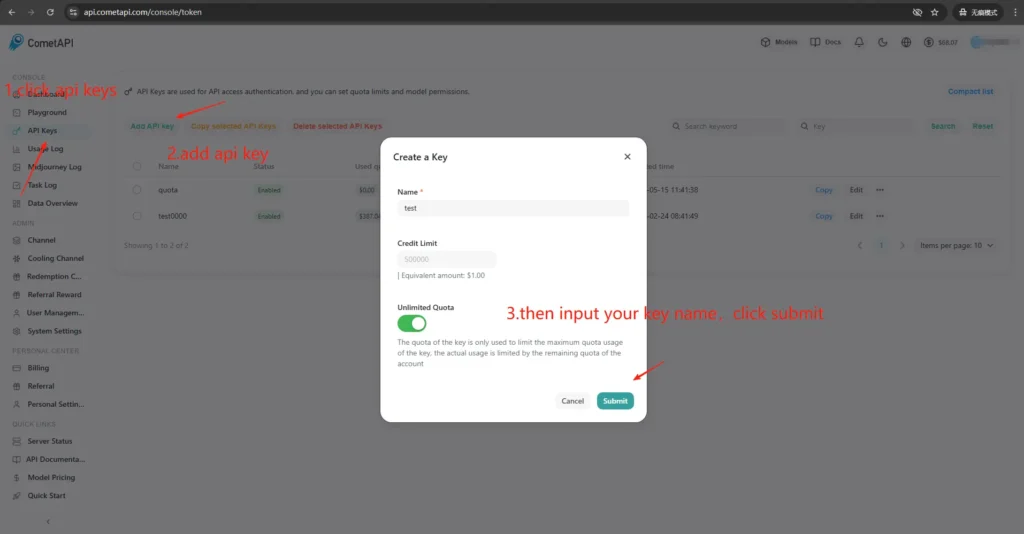

Comment obtenir l'accès et les clés CometAPI ?

- Inscrivez-vous sur le site CometAPI (ou sur le tableau de bord du fournisseur). La plupart des passerelles proposent une offre de test gratuite.

- Obtenir une clé API depuis votre tableau de bord CometAPI — une longue chaîne secrète. Notez où la documentation vous indique de la placer (CometAPI utilise l'autorisation Bearer contre

https://api.cometapi.com/v1). - Lire la documentation de l'API pour le point de terminaison que vous prévoyez d'utiliser (complétions de chat, images, intégrations). CometAPI documente les points de terminaison comme

/v1/chat/completionset/v1/images/generations.

Pourquoi la liaison (intégration) entre n8n et CometAPI est-elle importante ?

Le terme « liaison » désigne ici un chemin d'intégration fiable et sécurisé entre votre exécuteur d'automatisation (n8n) et votre passerelle de modèle. Une liaison adéquate est importante pour les raisons suivantes :

- Il préserve aux contextes à travers les appels (historique des conversations, intégrations).

- Il centralise Lettres de créance et des secrets réunis en un seul endroit pour une rotation plus sûre.

- Il réduit la latence et la surface d’erreur en utilisant des points de terminaison prévisibles et des formats de demande standard.

- Il permet observabilité et le dépannage : savoir quel modèle, quelle invite et quelle réponse ont conduit à un résultat.

En bref : une bonne liaison réduit le risque opérationnel et accélère l’itération.

Comment déployer n8n localement (guide pratique rapide) ?

Vous pouvez exécuter n8n localement soit avec npm ou avec Docker ; Docker Compose est l'approche recommandée pour la plupart des scénarios auto-hébergés (reproductible et isolant les dépendances). Vous trouverez ci-dessous un exemple minimal de Docker Compose et des notes essentielles.

Comment auto-héberger n8n avec Docker ?

Docker (et Docker Compose) est la méthode la plus robuste et la plus reproductible pour exécuter n8n en production. Il isole l'application, simplifie les mises à niveau et s'associe parfaitement aux proxys inverses et aux orchestrateurs (Docker Swarm, Kubernetes). La documentation officielle de n8n inclut une référence à Docker Compose que je suivrai et adapterai ici.

Pour la production, vous exécuterez généralement une pile composée de :

- Service n8n (image officielle :

docker.n8n.io/n8nio/n8norn8nio/n8n(selon l'étiquette). - PostgreSQL (ou une autre base de données prise en charge).

- Redis (si vous prévoyez d'utiliser le mode file d'attente).

- Un proxy inverse (Traefik, Caddy ou nginx) pour TLS, le routage de l'hôte et les règles de limite de débit.

Cette architecture sépare clairement les préoccupations (persistance de la base de données, mise en file d'attente, proxy web) et simplifie la mise à l'échelle et les sauvegardes. La documentation officielle de n8n fournit des modèles Docker Compose et des références aux variables d'environnement.

Ceci est un guide étape par étape :

- Créez un dossier et un

docker-compose.ymlavec le service canonique n8n. Vous trouverez ci-dessous un exemple pratique de Docker-Compose couvrant les besoins de production courants : Postgres externe, Redis (pour le mode file d'attente/exécutions), volumes persistants et proxy inverse Nginx gérant TLS.

```yaml

version: "3.8"

services:

n8n:

image: n8nio/n8n:latest

restart: unless-stopped

environment:

- DB_TYPE=postgresdb

- DB_POSTGRESDB_HOST=postgres

- DB_POSTGRESDB_PORT=5432

- DB_POSTGRESDB_DATABASE=n8n

- DB_POSTGRESDB_USER=n8n

- DB_POSTGRESDB_PASSWORD=supersecretpassword

- N8N_BASIC_AUTH_ACTIVE=true

- N8N_BASIC_AUTH_USER=admin

- N8N_BASIC_AUTH_PASSWORD=anothersecret

- WEBHOOK_TUNNEL_URL=https://n8n.example.com

- EXECUTIONS_MODE=queue

- QUEUE_BULL_REDIS_HOST=redis

ports:

- "5678:5678"

volumes:

- n8n_data:/home/node/.n8n

depends_on:

- postgres

- redis

postgres:

image: postgres:15

environment:

POSTGRES_DB: n8n

POSTGRES_USER: n8n

POSTGRES_PASSWORD: supersecretpassword

volumes:

- pgdata:/var/lib/postgresql/data

redis:

image: redis:7

volumes:

- redisdata:/data

volumes:

n8n_data:

pgdata:

redisdata:

2. Date de début:

docker compose up -d

3. Rendez nous visite `http://localhost:5678` et créez votre utilisateur administrateur. Pour la production, vous aurez besoin de Postgres, de SSL et de variables d'environnement appropriées ; consultez la documentation officielle de Docker Compose.

**Remarques et durcissement :**

- Do **pas** stocker les secrets en texte clair dans `docker-compose.yml`; utilisez des fichiers d'environnement, des secrets Docker ou des gestionnaires de secrets externes en production.

- remplacer `WEBHOOK_URL` avec votre véritable URL publique et configurez le proxy inverse pour acheminer `n8n.example.com` au conteneur n8n.

- Utilisez le `EXECUTIONS_MODE=queue` pour un traitement d'arrière-plan robuste ; il nécessite des travailleurs de file d'attente et Redis.

## Comment auto-héberger n8n avec npm / Node.js ?

L'installation via npm (ou pnpm) exécute n8n directement sur l'hôte. Cette solution est plus légère (sans couche conteneur) et peut s'avérer utile pour les installations mono-utilisateur peu complexes ou les postes de développement. Cependant, elle confère davantage de responsabilités à l'administrateur en matière de gestion des dépendances, d'isolation et de supervision des services. La documentation officielle de n8n inclut un guide d'installation de npm et des mises en garde.

### Les packages de système d'exploitation requis et la version du nœud :

- Utilisez un Node.js LTS stable (Node 18 ou Node 20+, conforme aux exigences de la version n8n).

- Installer `build-essential`, `git`, et un gestionnaire de processus (systemd est recommandé).

- Pour la production, utilisez toujours PostgreSQL et Redis comme services externes (même raisonnement que Docker).

### Comment installer et exécuter n8n via npm (étape par étape) ?

1.Installez Node.js (recommandé : nvm)

Install nvm

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash

Reload your shell (adjust to your shell startup file if needed)

source ~/.bashrc # or ~/.zshrc

Install and use the latest LTS (usually 18 or 20)

nvm install --lts

nvm use --lts

Verify

node -v

npm -v

Si vous voyez « n8n : commande introuvable » plus tard, redémarrez le terminal ou assurez-vous que le chemin d'accès global bin npm géré par nvm se trouve sur votre PATH.

---

2. Installer et démarrer n8n (local)

npm install -g n8n

n8n -v # verify version

3. Commencez au premier plan :

n8n start

URL par défaut : <http://localhost:5678/> Si le port est utilisé :

export N8N_PORT=5679

n8n start

Facultatif : laissez-le fonctionner en arrière-plan (toujours local) :

npm install -g pm2

pm2 start "n8n" --name n8n

pm2 save

pm2 status

4. Premier accès et connexion :

- Ouvrez http://localhost:5678/ dans votre navigateur.

- Lors de la première exécution, suivez l'assistant pour créer le compte Propriétaire (email + mot de passe) et connectez-vous.

## Comment installer ou configurer un nœud communautaire CometAPI dans n8n ?

N8n prend en charge les nœuds communautaires vérifiés (installation via l'interface graphique) et l'installation manuelle depuis npm en cas d'auto-hébergement. Il existe deux façons d'intégrer CometAPI à n8n :

### Option A — Utiliser le nœud communautaire CometAPI (si disponible dans le panneau Nœuds)

1. Dans n8n, ouvrez le panneau des nœuds (appuyez sur `+` or `Tab`).

2. CometAPI est un nœud communautaire vérifié, il apparaît sous « Plus de la communauté ». Cliquez et installez.

3. Après l'installation, redémarrez n8n si vous y êtes invité. Créez un nouveau **Credential** dans Paramètres → Informations d'identification (choisissez le type d'informations d'identification CometAPI si le nœud le fournit) et collez votre jeton CometAPI.

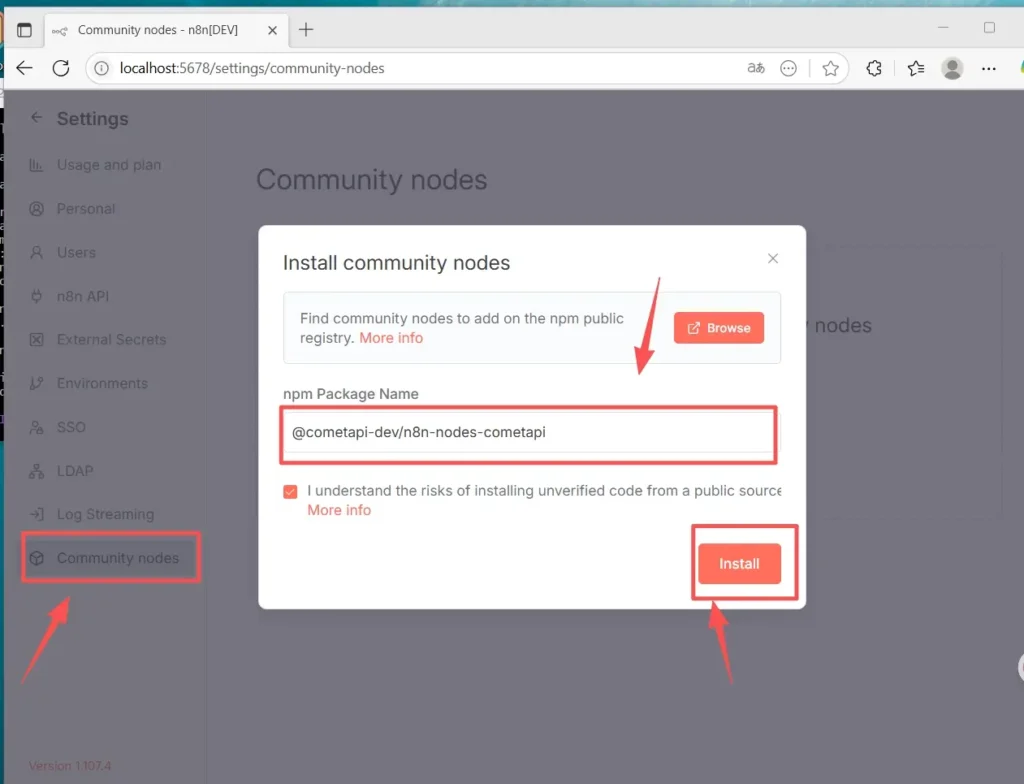

### Option B — Installation manuelle (lorsque l'installation de l'interface graphique n'est pas disponible)

1. Connectez-vous en SSH à votre hôte/conteneur n8n.

2. Installez le package dans le n8n global `node_modules` ou votre dossier personnalisé :

- Accédez à Paramètres (en bas à gauche) > Nœuds de la communautéCliquez sur «

- « Installer un nœud communautaire »

- Dans « Nom du package npm », saisissez : `@cometapi-dev/n8n-nodes-cometapi`Cochez la case de reconnaissance des risquesCliquez sur «

- Installer « Après l’installation, vous pouvez rechercher « CometAPI » dans le panneau des nœuds.

3. Redémarrez n8n. Si votre instance fonctionne en mode file d'attente, vous devez suivre la procédure d'installation manuelle décrite dans la documentation.

### Comment vérifier que le nœud est installé

- Après le redémarrage, ouvrez le panneau des nœuds et recherchez « CometAPI » ou « Comet ». Le nœud sera alors identifié comme un package communautaire.

- Si vous ne voyez pas le nœud : vérifiez que votre compte de propriétaire d’instance est utilisé (seuls les propriétaires d’instance peuvent l’installer) ou que le package de nœud a été installé sans erreur dans les journaux du conteneur/de l’image.

## Comment créer un workflow et configurer l'API

### 1. Créer un nouveau flux de travail

- Connectez-vous à votre instance n8n (auto-hébergée).

- Cliquez sur **« Ajouter un flux de travail »** pour démarrer un nouveau canevas d'automatisation.

### 2. Ajouter un nœud

- Ajoutez un nœud déclencheur : recherchez « Déclencheur manuel » ou « Lorsque vous cliquez sur « Exécuter le workflow » ».

- Cliquez sur le « + » sur le côté droit du canevas et recherchez « CometAPI » pour ajouter le nœud.

- Vous pouvez également rechercher « CometAPI » dans la liste des nœuds de gauche et le faire glisser sur le canevas.

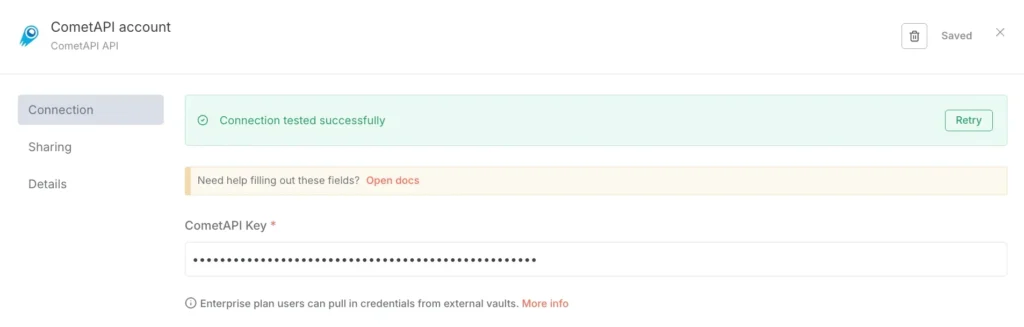

### 3. Configurer les informations d’identification (première fois uniquement) :

- Dans le nœud CometAPI, sous « Informations d’identification pour se connecter », choisissez « Créer un nouveau ».

- Collez le jeton que vous avez créé dans la console CometAPI dans « CometAPI Key ».

- Enregistrer. L'URL de base par défaut est https://www.cometapi.com/console/ et ne nécessite généralement aucune modification.

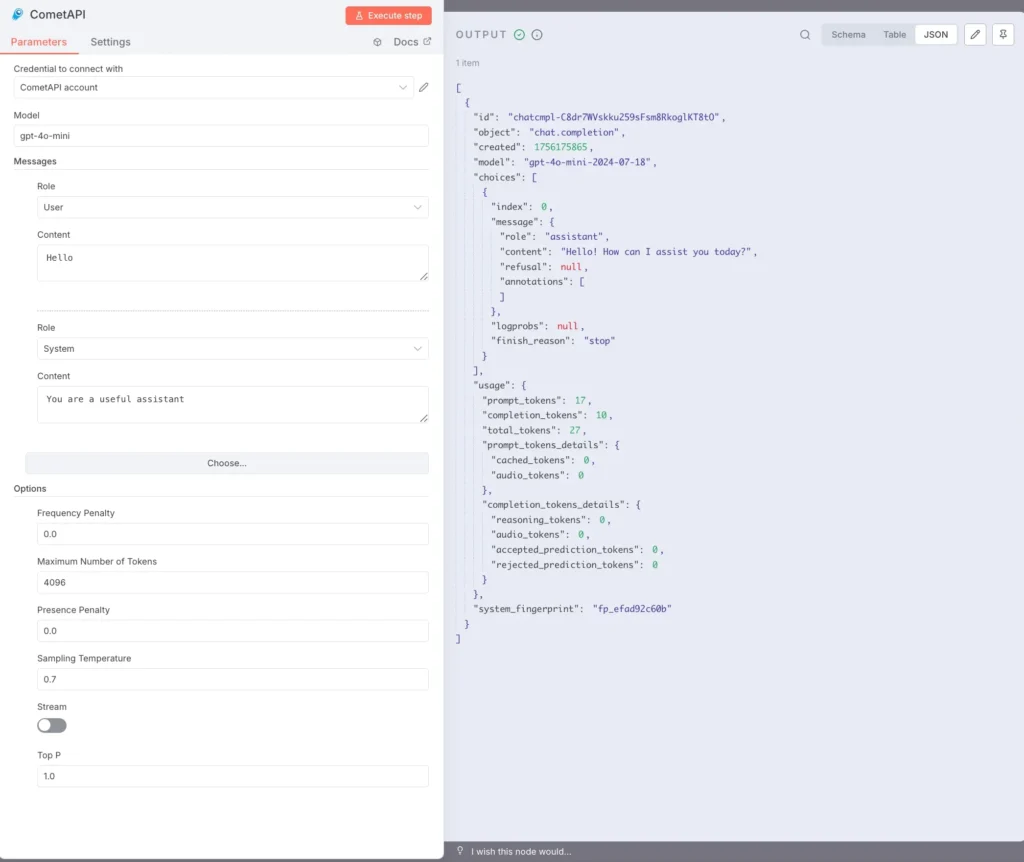

### 4. Configurer le modèle et les messages :

Modèle : saisissez un modèle pris en charge, par exemple, `gpt-4o` or `gpt-4o-mini`.

Messages : vous devez renseigner le rôle et le contexte, et vous pouvez choisir l'utilisateur ou le système pour le rôle

Les paramètres facultatifs (selon les besoins) incluent : nombre maximal de jetons (par exemple, 4096 0.7) ; température d'échantillonnage (par exemple, XNUMX) ; PenaltyStream (activation/désactivation de la diffusion). Pour obtenir une documentation et des explications spécifiques aux paramètres, veuillez consulter le [Documentation de CometAPI](https://api.cometapi.com/doc).

### 5. Exécution du texte :

Sélectionnez le nœud CometAPI et cliquez sur « Exécuter l’étape » ou cliquez sur « Exécuter le workflow » en bas.

Le panneau SORTIE sur la droite doit afficher une réponse JSON (y compris les choix, l'utilisation, etc.).

Vous avez maintenant installé n8n (Recommend) localement sur Linux via npm, installé et configuré le nœud communautaire CometAPI et pouvez exécuter des workflows qui appellent des modèles tels que gpt-4o pour recevoir des réponses.

## Quels sont les problèmes courants et comment les résoudre ?

### 1) « 401 Non autorisé » ou « Clé API non valide »

- Confirmez la chaîne de jeton exacte dans votre tableau de bord CometAPI (il peut y avoir des jetons portant des noms similaires). Copiez-la → collez-la dans les informations d'identification n8n et redémarrez le nœud si nécessaire.

- Assurez-vous que le format de l'en-tête d'autorisation est `Bearer sk-xxxxx`.

### 2) Le nœud communautaire ne s'installe pas / « mode file d'attente »

- Si votre n8n fonctionne dans **mode file d'attente**L'installation de l'interface graphique peut être désactivée ; suivez la documentation d'installation manuelle pour installer les nœuds communautaires via NPM ou créez une image personnalisée incluant le nœud. Redémarrez N8N après l'installation.

### 3) Nœud introuvable dans la palette après l'installation

- Redémarrez n8n.

- Assurez-vous d'avoir installé le package dans le bon contexte (à l'intérieur de l'image du conteneur ou dans le `.n8n/custom` chemin si vous utilisez ce modèle).

- Vérifiez les journaux du conteneur pour les erreurs de résolution de module.

### 4) Limites de taux ou problèmes de quotas

- Consultez le tableau de bord CometAPI pour connaître l'utilisation et le quota.

- Implémentez un recul exponentiel et un retour à des modèles moins chers lorsque vous détectez des avertissements de limite ou des HTTP 429.

## Existe-t-il des alternatives si le nœud communautaire n'est pas disponible ou si vous souhaitez plus de flexibilité ?

Oui, vous pouvez toujours utiliser le **Requête HTTP** nœud directement (contrôle total) ou un [Nœud OpenAI avec URL de base](https://apidoc.cometapi.com/n8n-965890m0) Redirection (raccourci pratique). L'utilisation du HTTP brut simplifie également l'adoption de nouveaux points de terminaison CometAPI dès leur publication (par exemple, points de terminaison image/vidéo). Veuillez consulter [Guide](https://apidoc.cometapi.com/n8n-965890m0).

**Voir aussi** [Comment utiliser n8n avec CometAPI](https://www.cometapi.com/fr/how-to-use-n8n-with-cometapi/?utm_source=chatgpt.com)

## Conclusion:

CometAPI vous offre le choix de vos modèles et une simplicité opérationnelle ; n8n vous offre une orchestration visuelle et une extensibilité optimales. Utilisez l'astuce des identifiants OpenAI pour une intégration rapide du chat/de la saisie semi-automatique, et des nœuds communautaires là où ils existent et sont fiables. Instrumentez chaque flux de travail pour les coûts, la latence et la sécurité ; privilégiez les solutions de secours humaines pour les décisions importantes ; et maintenez une sélection de modèles dynamique afin de vous adapter aux évolutions rapides du marché des fournisseurs d'IA. La combinaison de n8n et de CometAPI est puissante, mais comme tout outil performant, elle nécessite des garde-fous : observer, tester et itérer.