Google a annoncé Gemini 3 Flash les 17–18 décembre 2025 comme un membre à faible latence et économique de la famille Gemini 3. Il apporte un raisonnement de niveau Pro dans une empreinte de classe Flash, prend en charge des entrées multimodales étendues (texte, image, audio, vidéo), introduit des contrôles thinking_level et de résolution des médias, et est disponible via Google AI Studio, l’API Gemini (REST / SDKs), Vertex AI, Gemini CLI, et comme modèle par défaut dans Google Search / l’application Gemini.

Qu’est-ce que Gemini 3 Flash et pourquoi c’est important

Gemini 3 Flash fait partie des modèles de la série 3 de Google. Il a été conçu pour repousser la frontière de Pareto qualité vs coût vs latence : offrir une grande partie des capacités de raisonnement de Gemini 3 Pro tout en étant nettement plus rapide et moins coûteux à exécuter. Cette combinaison le rend bien adapté aux scénarios interactifs à haute fréquence (chatbots, assistants d’IDE, flux agentiques en temps réel), à la génération de contenu en masse où la latence compte, et aux applications qui nécessitent un raisonnement multimodal (images + texte + audio) avec une faible surcharge.

Points clés de haut niveau :

- Il est explicitement optimisé pour la vitesse + faible coût tout en conservant un fort raisonnement et une grande fidélité multimodale (Trois fois plus rapide que l’ancien Gemini 2.5 Pro ; conserve les capacités d’inférence de premier plan de Gemini 3.).

- Il est positionné comme le « sweet spot » pour les boucles agentiques et les flux de travail itératifs des développeurs (par ex., assistance au code, agents multi-tours).

- Flexible : il peut « ajuster son temps de réflexion » en fonction de la complexité du problème — répondre instantanément aux questions simples et envisager plus d’étapes pour les tâches complexes.

Performances techniques et résultats de benchmarks

Gemini 3 Flash réalise une triple percée en vitesse, intelligence et coût :

1) Boucles agentiques et compréhension multimodale

Gemini 3 Flash hérite d’améliorations architecturales et d’entraînement de la famille Gemini 3, produisant une forte compétence multimodale (entrées texte, image, vidéo, audio) et un raisonnement amélioré par rapport aux modèles Flash antérieurs. Google positionne Flash comme capable de traiter des tâches telles que l’analyse de documents (OCR + raisonnement), la synthèse vidéo, les questions-réponses image + texte, et des tâches de codage multimodal. Cette capacité multimodale, combinée à une faible latence, est l’un des arguments techniques déterminants du modèle.

Google a publié des revendications de benchmarks internes mettant en avant de solides performances en codage agentique (SWE-bench Verified ~78 % pour les workflows de codage agentiques) et Flash se rapproche d’un raisonnement de niveau Pro sur de nombreuses tâches tout en restant suffisamment rapide pour les boucles agentiques et les workflows quasi temps réel.

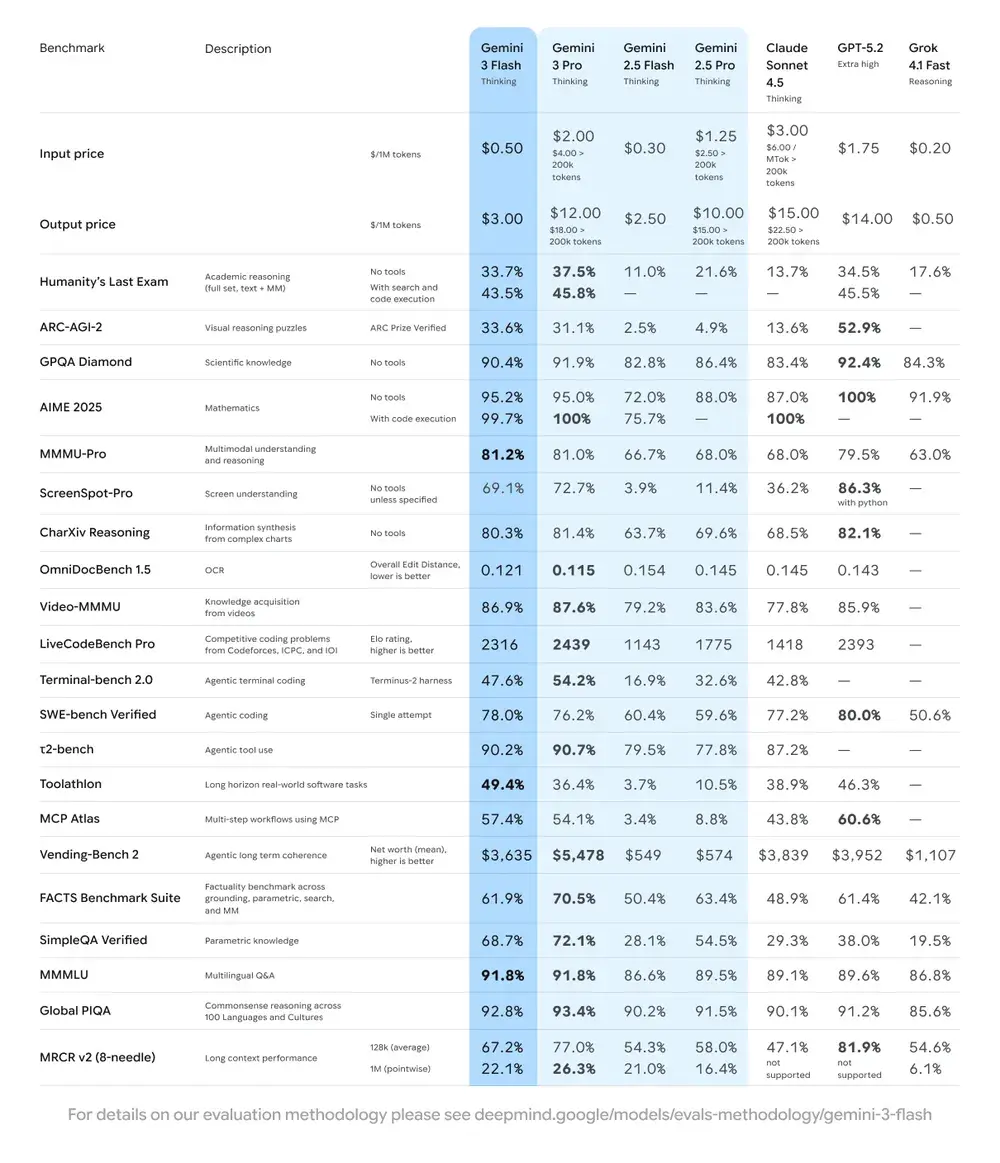

| Benchmark | Score de Gemini 3 Flash | Modèle de comparaison | Amélioration |

|---|---|---|---|

| GPQA Diamond (raisonnement de niveau doctorat) | 90,4 % | Dépasse Gemini 2.5 Pro | Significative |

| Humanity’s Last Exam (test de culture générale) | 33,7 % (sans outils) | Proche de Gemini 3 Pro | Raisonnement avancé |

| MMMU Pro (compréhension multimodale) | 81,2 % | Au même niveau que Gemini 3 Pro | — |

| SWE-bench Verified (benchmark de capacité de code) | 78 % | Supérieur à Gemini 3 Pro et à la série 2.5 | Excellente |

2) Coût et efficacité

La philosophie de développement de Gemini 3 Flash est la « frontière de Pareto » : trouver l’équilibre optimal entre vitesse, qualité et coût. Gemini 3 Flash est explicitement optimisé pour le rapport prix/performances. Google indique un tarif de Flash nettement inférieur à Pro pour des tâches comparables, et le destine à traiter de grands volumes de requêtes à moindre coût opérationnel. Pour de nombreuses charges, la variante Flash est conçue comme le choix économique par défaut — par exemple, un tarif de préversion Flash d’environ 0,50 $ par 1M jetons d’entrée et 3,00 $ par 1M jetons de sortie pour le palier de préversion Flash. En pratique, cela le rend viable pour des tâches à haute fréquence où le coût par jeton de Pro serait prohibitif.

Indicateurs d’efficacité

- Vitesse : 3× plus rapide que Gemini 2.5 Pro (d’après des tests Artificial Analysis).

- Efficacité en jetons : utilise en moyenne 30 % de jetons en moins pour accomplir la même tâche. En d’autres termes, vous obtenez des résultats plus rapides et meilleurs pour la même somme.

- Gemini 3 Flash propose un « Dynamic Thinking Mode » — adaptant la profondeur de raisonnement à la complexité de la tâche, « réfléchissant un peu plus » si nécessaire, et répondant rapidement aux tâches simples.

Implications pratiques : Un coût par jeton ou par appel plus faible signifie que vous pouvez exécuter davantage de requêtes, des contextes plus longs, ou des taux d’échantillonnage plus élevés pour le même budget. Les gains d’efficacité peuvent également réduire la complexité de l’infrastructure (moins d’instances chaudes nécessaires) et améliorer les garanties de temps de réponse.

3) Benchmark de performance

Gemini 3 Flash atteint des performances « de frontière » sur plusieurs benchmarks académiques et applicatifs tout en offrant une meilleure latence et un meilleur coût que les modèles Pro antérieurs. Google présente des chiffres tels que des scores élevés sur des benchmarks de raisonnement complexe et de connaissances (par ex., variantes GPQA) pour illustrer sa compétence.

Comment utiliser l’API Gemini 3 Flash ?

Quelle méthode d’accès choisir ?

- Recommandé (simple + robuste) : Utilisez le modèle d’intégration SDK montré par Comet — il pointe simplement un SDK GenAI existant vers l’URL de base de Comet et fournit votre clé API Comet. Cela évite d’avoir à reproduire vous‑même l’analyse des requêtes/du flux.

- Alternative (HTTP brut / curl / piles personnalisées) : Vous pouvez envoyer un POST directement vers les endpoints CometAPI (Comet accepte des formats de type OpenAI ou spécifiques aux fournisseurs). Utilisez

Authorization: Bearer <sk-...>(les exemples Comet utilisent un en‑tête Bearer) et la chaîne de modèlegemini-3-flashdans le corps. Confirmez le chemin exact et les paramètres de requête dans la documentation de l’API Comet pour le modèle souhaité.

Résumé rapide — ce que vous ferez

- Inscrivez‑vous sur CometAPI et créez un jeton API.

- Choisissez une méthode d’accès (recommandé : modèle d’enrobage SDK ci‑dessous ; repli : HTTP/cURL brut).

- Appelez le modèle

gemini-3-flashvia l’URL de base CometAPI (Comet achemine votre requête vers le backend Gemini de Google). - Gérez le streaming / les appels de fonctions / les entrées multimodales selon les exigences du modèle (détails ci‑dessous).

from google import genaiimport os# Get your CometAPI key from https://api.cometapi.com/console/token, and paste it hereCOMETAPI_KEY = os.environ.get("COMETAPI_KEY") or "<YOUR_COMETAPI_KEY>"BASE_URL = "https://api.cometapi.com"client = genai.Client( http_options={"api_version": "v1beta", "base_url": BASE_URL}, api_key=COMETAPI_KEY,)response = client.models.generate_content( model="gemini-3-flash", contents="Explain how AI works in a few words",)print(response.text)

Paramètres de requête clés à considérer

thinking_level— contrôle la profondeur de raisonnement interne :MINIMAL,LOW,MEDIUM,HIGH. UtilisezMINIMALpour la latence et le coût les plus bas quand un raisonnement multi‑étapes profond n’est pas nécessaire.media_resolution— pour les entrées vision/vidéo :low,medium,high,ultra_high. Une résolution plus basse réduit l’équivalence en jetons et la latence.streamGenerateContentvsgenerateContent— utilisez le streaming pour une meilleure latence perçue lorsque vous souhaitez des réponses partielles au fil de l’eau.- Appel de fonctions / mode JSON — utilisez des réponses structurées lorsque vous avez besoin de sorties interprétables par machine.

Envoyer des entrées multimodales (conseils pratiques)

- Images/PDF : préférez des URI Cloud Storage (gs://) pour les médias volumineux ; de nombreuses API acceptent le base64 pour les petites images. Surveillez la comptabilisation des jetons par modalité — les PDF peuvent être comptés au titre des quotas image/document selon l’endpoint.

- Vidéo/audio : pour de courts extraits vous pouvez transmettre des URI ; pour des médias longs, utilisez des workflows de traitement par lot ou transmettez des segments en flux. Vérifiez les tailles d’entrée maximales et les contraintes d’encodage dans la documentation de l’API.

- Appel de fonctions / outils : utilisez des schémas de fonctions structurés pour obtenir des sorties JSON et permettre un déclenchement d’outils sûr. Gemini 3 Flash prend en charge l’appel de fonctions en streaming pour une meilleure UX.

Où accéder à Gemini 3 Flash ?

Gemini 3 Flash est disponible sur les surfaces grand public et développeurs de Google :

- Google Search et l’application Gemini — Flash a été déployé comme modèle par défaut pour le mode IA dans Search et est intégré à l’expérience de l’application Gemini pour les utilisateurs finaux.

- Google AI Studio — un endroit immédiat pour que les développeurs expérimentent et génèrent des clés API pour les tests.

- Gemini API (Generative Language / AI Developer API) — disponible sous

gemini-3-flash-preview(ID de modèle utilisé dans la documentation/les notes de version) et via les endpoints generateContent / streamGenerateContent. - Vertex AI (Google Cloud) — accès de niveau production via les API de modèles de Vertex AI Generative AI et tarification/quotas adaptés aux charges d’entreprise.

- Gemini CLI — pour le développement en terminal et les workflows de script.

Passerelle tierce CometAPI

CometAPI a déjà ajouté gemini-3-flash à son catalogue, et sa page modèle explique comment l’appeler via l’endpoint unifié de CometAPI. L’API fournie est tarifée à 20 % du prix officiel.

Bonnes pratiques avec Gemini 3 Flash

1) Choisir thinking_level selon la tâche et affiner

- Réglez

MINIMAL/LOWpour les questions‑réponses simples et les tâches interactives à haute fréquence. - Utilisez

MEDIUM/HIGHde manière sélective pour les tâches nécessitant des chaînes de raisonnement plus profondes ou une planification multi‑étapes. - Évaluez le coût vs la qualité lorsque vous changez

thinking_level. La documentation de Google avertit quethinking_levelmodifie les signatures de pensée internes et la latence.

2) Utiliser media_resolution pour contrôler le calcul vision

Si vous transmettez des images ou des vidéos, choisissez la plus basse media_resolution acceptable pour la tâche ; par exemple, utilisez low pour les vignettes et l’extraction en masse, high pour la critique de designs visuels. Cela réduit l’équivalence en jetons pour les images et diminue la latence.

3) Préférer des sorties structurées pour l’automatisation

Utilisez le mode JSON / l’appel de fonctions lorsque votre application a besoin de sorties interprétables par machine (par ex., extraction d’entités, invocation d’outils). Cela simplifie grandement le traitement en aval. Faites respecter des schémas JSON stricts autant que possible et validez côté client.

4) Utiliser largement le streaming pour les réponses longues

streamGenerateContent réduit la latence perçue et permet un rendu progressif côté UI. Pour les tâches multimodales longues, diffusez des sorties partielles afin que les utilisateurs voient des progrès immédiats.

5) Contrôler les coûts avec la mise en cache et la gestion du contexte

- Utilisez la mise en cache du contexte pour les références répétées (tarification et jetons différents selon les modèles).

- Évitez d’envoyer un contexte inutilement long si ce n’est pas requis — préférez des invites concises et utilisez la recherche + ancrage pour les grandes bases de connaissances.

Scénarios d’usage typiques de Gemini 3 Flash

Agents conversationnels à grand volume

Flash est un choix naturel pour les chatbots et assistants de support client qui nécessitent une faible latence et un faible coût par inférence. Avec la prise en charge du streaming et un débit élevé de jetons/seconde, Flash réduit la latence perçue et les coûts opérationnels.

Assistants multimodaux et pipelines documentaires

Parce que Flash gère bien les images, les PDF et les courtes vidéos, les applications courantes incluent l’extraction de factures, la Q&R multimodale sur des manuels, le support client avec images, et l’ingestion de PDF pour des bases de connaissances.

Analyse vidéo en temps réel et modération

Une vitesse de sortie élevée rapportée (≈218 t/s dans les tests pré‑release) permet une analyse et une synthèse quasi en temps réel de courtes vidéos, la détection des moments forts, et des pipelines de modération de contenu en direct lorsqu’ils sont correctement architecturés.

Outils développeur agentiques et assistance au codage

Les scores SWE-bench et les performances de codage rapportées font de Flash une bonne option pour des assistants de codage rapides, des helpers CLI et d’autres workflows développeur qui privilégient une faible latence.

Conclusion — devez‑vous adopter Gemini 3 Flash maintenant ?

Gemini 3 Flash est une offre stratégique pour les équipes qui ont besoin d’une intelligence de raisonnement et multimodale solide sans la latence et le coût des modèles Pro haut de gamme. Le modèle est particulièrement bien adapté aux assistants de codage agentiques, aux agents multimodaux interactifs, aux pipelines de traitement de documents, et à tout système où la faible latence et l’échelle sont des préoccupations primaires. Les premiers benchmarks (ceux de Google et des analyses indépendantes) indiquent que Flash est compétitif en qualité tout en offrant des avantages substantiels de débit et de coût

Pour commencer, explorez les capacités de Gemini 3 Flash dans le Playground et consultez le guide de l’API pour des instructions détaillées. Avant d’y accéder, veuillez vous assurer que vous êtes connecté à CometAPI et que vous avez obtenu la clé API. CometAPI propose un prix bien inférieur au tarif officiel pour vous aider à vous intégrer.

Prêt à démarrer ? → Essai gratuit de Gemini 3 Flash !