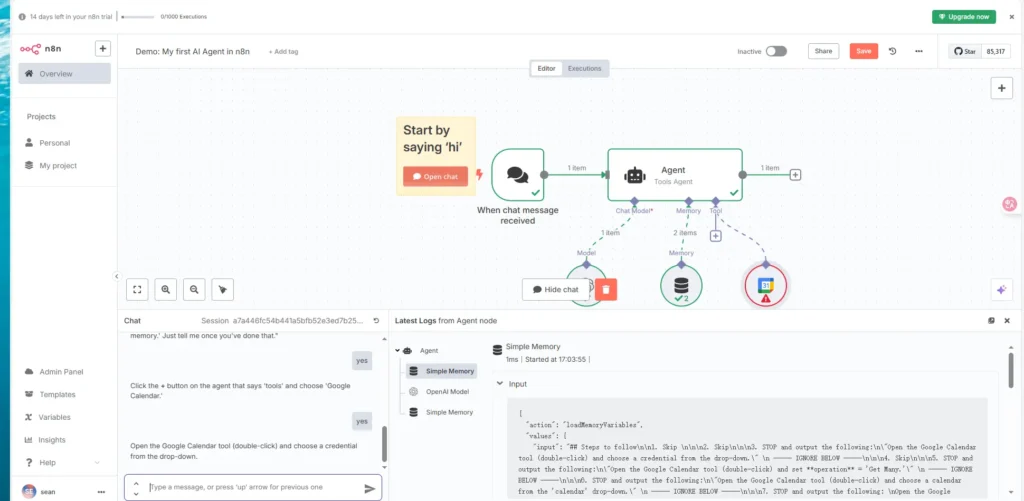

L'essor récent de l'automatisation pilotée par l'IA a fait naître le besoin de workflows plus dynamiques et contextuels. n8n, outil d'automatisation de workflows open source, s'est imposé comme une plateforme puissante pour orchestrer des processus complexes sans expertise approfondie en codage. Parallèlement, le protocole MCP (Model Context Protocol) standardise la manière dont les agents IA interagissent avec les services externes, leur permettant de découvrir des outils et d'exécuter des opérations de manière cohérente. En intégrant n8n aux serveurs MCP, les entreprises accèdent à un niveau de flexibilité inédit : les agents IA peuvent invoquer les workflows n8n comme des outils et, inversement, utiliser des services compatibles MCP directement dans leurs workflows. Cette capacité bidirectionnelle positionne n8n à la fois comme producteur et consommateur de tâches pilotées par l'IA, simplifiant l'automatisation de bout en bout et réduisant le besoin de code d'intégration personnalisé.

Qu'est-ce que n8n ?

n8n est une plateforme d'automatisation des workflows caractérisée par son modèle de licence basé sur des nœuds et un code équitable, qui permet aux utilisateurs de créer des séquences d'actions (nœuds) déclenchées par des événements ou des planifications. Elle prend en charge un large éventail d'intégrations prêtes à l'emploi, des requêtes HTTP et bases de données aux plateformes de messagerie et services cloud. Contrairement aux outils d'automatisation restrictifs de type « boîte noire », n8n offre aux développeurs un contrôle total sur leurs workflows, avec notamment la possibilité d'auto-héberger et d'étendre les fonctionnalités via des nœuds communautaires ou du code personnalisé.

Qu'est-ce que le MCP ?

Le protocole MCP (Model Context Protocol) est une norme émergente qui définit la manière dont les modèles et agents d'IA découvrent, accèdent et orchestrent les outils et sources de données externes. Il fournit une interface API et un schéma de métadonnées uniformes, permettant une interopérabilité transparente entre les agents d'IA, tels que les modèles de langage étendus (LLM), et les services qui exposent des fonctionnalités exploitables. Les serveurs MCP publient des définitions d'outils et des modèles d'invite, tandis que les clients MCP, souvent intégrés aux agents d'IA, peuvent demander et exécuter ces outils en fonction d'invites contextuelles.

Quelles mises à jour récentes rendent cette intégration essentielle ?

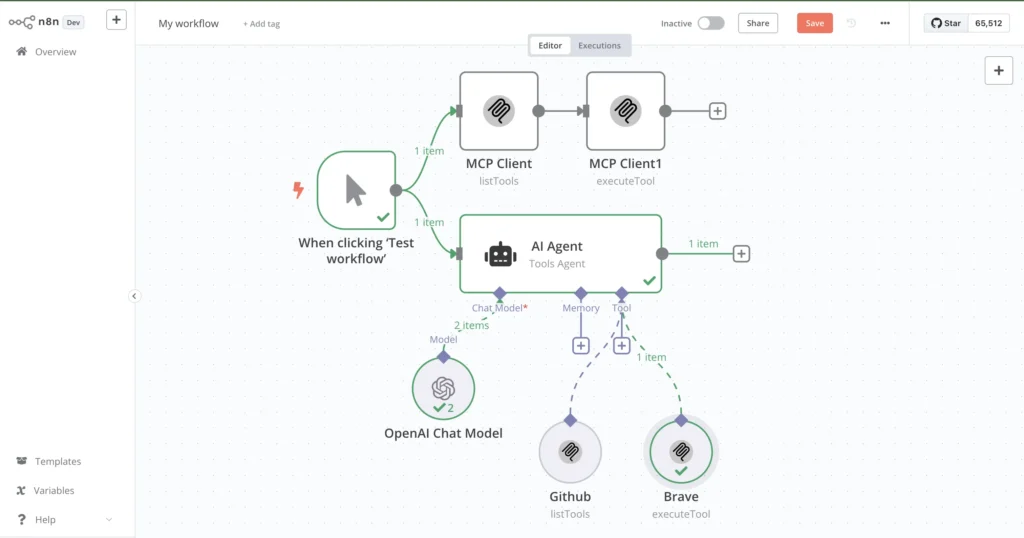

Entre février et avril 2025, l'équipe n8n a officiellement introduit deux nœuds clés : le Outil client MCP et la Déclencheur du serveur MCPLe nœud MCP Client Tool permet aux workflows n8n d'appeler des serveurs MCP externes comme s'il s'agissait de nœuds natifs, offrant ainsi des fonctionnalités basées sur l'IA via une interface unique. À l'inverse, le nœud MCP Server Trigger transforme un workflow n8n en serveur MCP, permettant ainsi aux agents IA externes d'invoquer directement des actions de workflow. Ces avancées positionnent n8n à la pointe de l'automatisation des workflows IA, réduisant la complexité et permettant le développement rapide de pipelines d'automatisation intelligents.

Comment pouvez-vous installer et configurer n8n pour les serveurs MCP ?

Avant de vous lancer dans les intégrations MCP, vous avez besoin d'une instance n8n fonctionnelle. Vous pouvez auto-héberger n8n sur une machine locale ou le déployer sur des plateformes cloud avec des installateurs en un clic, des conteneurs Docker ou des services gérés.

Pré-requis :

- Node.js: La version 18.17.0, 20.x ou 22.x est recommandée ; n8n ne prend actuellement pas en charge Node.js 23.x.

- Git et npm/fil:Pour installer n8n et les nœuds communautaires.

- Docker (facultatif) : permet des déploiements conteneurisés faciles.

- Un environnement d'hébergement: Machine locale, VPS ou service cloud comme Zeabur, où vous pouvez exposer un point de terminaison HTTP pour le trafic MCP.

Procédure d'installation

Installer le gestionnaire de versions de nœud (NVM)

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash

source ~/.nvm/nvm.sh

nvm install 18.17.0

nvm use 18.17.0

Cela garantit la compatibilité avec les versions Node.js prises en charge par n8n.

Installer n8n globalement

npm install -g n8n

Après l'installation, invoquez n8n pour lancer l'interface Web à http://localhost:5678 .

Créez votre compte

Au premier lancement, n8n vous invite à créer un compte. Saisissez une adresse e-mail et un mot de passe ; aucune carte de crédit n'est requise pour l'édition communautaire gratuite.

Installer le nœud communautaire MCP (facultatif pour le client)

Dans les paramètres de n8n sous « Nœuds de communauté », recherchez et installez n8n-nodes-mcpCe plugin fournit des fonctionnalités client MCP améliorées si votre version de n8n ne dispose pas du nœud intégré.

Comment configurer le nœud de déclenchement du serveur MCP dans n8n ?

Transformer n8n en serveur MCP permet aux agents d'IA externes de traiter les workflows comme des outils exécutables. Suivez ces étapes :

Ajout du nœud déclencheur du serveur MCP

- Créer un nouveau flux de travail

Dans l’éditeur n8n, cliquez sur « Nouveau flux de travail ». - Ajouter le nœud

Rechercher Déclencheur du serveur MCP dans le panneau de nœuds et faites-le glisser dans l'espace de travail. - Activation du jeu

Activez le flux de travail après la configuration. Le nœud déclencheur du serveur MCP générera un point de terminaison unique, généralement à/mcp/<randomId>.

Configuration du déclencheur

- Chemin URL MCP: Acceptez la valeur par défaut ou spécifiez un chemin personnalisé (par exemple,

/mcp/ai-tools). - Authentification: Pour les tests initiaux, sélectionnez « Aucun », mais pour la production, configurez les clés API, OAuth ou la vérification JWT pour sécuriser votre point de terminaison.

- Schéma d'entrée: Définir les clés de charge utile JSON attendues (par exemple,

tool,params). n8n analysera le JSON entrant et mappera automatiquement les champs aux nœuds suivants.

Une fois configuré, tout HTTP POST vers le point de terminaison (par exemple, http://your-domain.com/mcp/abc123) déclenche le flux de travail, permettant aux agents IA d'invoquer les outils que vous exposez.

Comment pouvez-vous configurer l'outil client MCP dans n8n ?

Alors que le déclencheur serveur expose n8n en tant que fournisseur d'outils, le nœud d'outil client MCP permet à n8n de consommer des services MCP externes dans les flux de travail.

Installation du nœud communautaire

Si vous n'avez pas installé n8n-nodes-mcp auparavant, suivez ces étapes maintenant :

- Ouvrez Paramètres → Nœuds de communauté

- Installer un nouveau nœud: Rechercher

n8n-nodes-mcpet cliquez sur « Installer ». - Redémarrer n8n pour charger le nouveau nœud.

Configuration de l'outil client MCP

- Ajouter le nœud d'outil client MCP

Dans votre flux de travail, recherchez Outil client MCP et ajoutez-le. - Configurer la connexion

- URL du serveur: Saisissez le point de terminaison du serveur MCP (par exemple, votre propre URL de déclenchement MCP n8n ou un service tiers).

- Nom de l'outil: Spécifiez l'identifiant de l'outil tel que publié par le serveur (par exemple,

sendEmail,fetchData). - Paramètres:Mappez les champs de saisie des nœuds précédents ou des variables de workflow.

- Gérer la réponse

Le nœud MCP Client Tool renvoie une sortie JSON structurée, que vous pouvez transmettre aux nœuds suivants comme « Set » ou « HTTP Response » pour le formatage ou le traitement ultérieur.

Comment tester et valider votre serveur MCP dans n8n ?

La validation est essentielle pour garantir que vos intégrations de points de terminaison et de clients MCP fonctionnent de manière fiable dans divers scénarios.

Envoi de demandes de test

Utilisez des outils comme boucle or Facteur pour envoyer des échantillons de charges utiles :

curl -X POST http://localhost:5678/mcp/abc123 \

-H 'Content-Type: application/json' \

-d '{"tool": "exampleTool", "params": {"message": "Hello, world!"}}'

Une réponse réussie indique que n8n a analysé la demande, exécuté le flux de travail et renvoyé le résultat attendu.

Débogage des problèmes courants

- JSON non valide: Assurez-vous que les charges utiles sont bien formées ; n8n rejettera les entrées mal formées avec une erreur 400.

- Échecs d'authentification: Si vous utilisez des clés API ou OAuth, vérifiez que les en-têtes et les jetons sont correctement configurés.

- Erreurs de flux de travail:Utilisez le journal d'exécution n8n pour inspecter les données d'exécution du nœud et les messages d'erreur.

- Connectivité réseau: Confirmez que votre instance n8n est accessible depuis l'environnement du client, en prêtant attention aux règles du pare-feu et aux paramètres DNS.

Quels sont les exemples de cas d’utilisation de n8n avec les serveurs MCP ?

L'intégration de n8n avec MCP ouvre la voie à divers scénarios d'automatisation dans différents domaines. Voici quelques exemples illustratifs.

Automatisation des flux de travail de messagerie

Supposons que vous souhaitiez que les agents IA envoient des e-mails personnalisables à la demande :

- Déclencheur du serveur MCP: Expose un outil nommé

sendEmail. - Nœud de messagerie:Connectez le déclencheur au nœud « Envoyer un e-mail » de n8n (SMTP, Gmail, etc.).

- Mappage des paramètres: Carte

to,subject,bodyde la charge utile MCP aux champs du nœud de messagerie.

L'agent IA appelle simplement le sendEmail outil via MCP, éliminant ainsi le besoin de gérer les détails SMTP dans l'agent lui-même.

Récupération et transformation des données API

Pour permettre aux agents IA d'interroger et de traiter des API tierces :

- Déclencheur du serveur MCP: Outil nommé

fetchData. - Nœud de requête HTTP:Configuré pour appeler une API externe (par exemple,https://api.cometapi.com/v1/chat/completions).

- Définir le nœud: Formate et filtre la réponse de l'API.

- Retour: Envoie du JSON structuré au client.

Les agents d’IA peuvent demander des ensembles de données spécifiques sans gérer la pagination, l’authentification ou la limitation du débit.

Création d'agents vocaux d'IA

Les assistants vocaux peuvent exploiter n8n comme backend :

- Déclencheur du serveur MCP expose des outils comme

createTaskorcheckCalendar. - Le moteur vocal traduit les commandes vocales en requêtes MCP (par exemple, « Créer une réunion demain à 3 h »).

- Les flux de travail n8n interagissent avec Google Agenda, les bases de données ou les fonctions personnalisées, puis renvoient une confirmation à l'agent.

Cette approche dissocie la logique de l’interface vocale des intégrations backend, simplifiant ainsi la maintenance et l’évolution.

Quelles sont les meilleures pratiques et les considérations de sécurité ?

Les intégrations MCP prêtes pour la production nécessitent des mesures de sécurité, de surveillance et d'évolutivité robustes.

Authentification et contrôle d'accès

- Clés de l'API: Émettre des clés par client avec des portées granulaires (par exemple, autoriser uniquement

readorwriteopérations). - OAuth 2.0 / JWT: Pour les environnements d'entreprise, intégrez-les aux fournisseurs d'identité (Okta, Auth0).

- Limitation du débit:Utilisez des proxys inverses (NGINX, Traefik) ou des passerelles API cloud pour limiter les requêtes et empêcher les abus.

Évolutivité et performances

- Mise à l'échelle horizontale: Déployez plusieurs instances n8n derrière un équilibreur de charge pour distribuer le trafic MCP.

- Redis / Files d'attente de base de données: Déchargez les tâches lourdes ou de longue durée vers les files d'attente d'arrière-plan, garantissant des réponses MCP rapides.

- Le Monitoring: Implémentez la journalisation (par exemple, Elastic Stack) et les métriques (Prometheus, Grafana) pour suivre les temps d'exécution des flux de travail et les taux d'erreur.

Quel avenir pour l’intégration de n8n et MCP ?

L’écosystème autour de MCP et n8n évolue rapidement, avec plusieurs développements prometteurs à l’horizon.

Caractéristiques à venir

- Découverte d'outils dynamiques:Les agents peuvent interroger n8n pour connaître les outils et métadonnées disponibles en temps réel, permettant des flux de travail encore plus flexibles.

- Nœuds de sécurité améliorés: Introduction du cryptage intégré, de la rotation des jetons et des nœuds de journalisation d'audit dans n8n.

- Client MCP Low-Code: D'autres abstractions pour simplifier la consommation de MCP sans nécessiter d'installations de nœuds personnalisées.

Croissance des communautés et des écosystèmes

- Marché des flux de travail MCP:Des plateformes comme n8n.io/workflows répertorient déjà des exemples de modèles de serveurs MCP, favorisant ainsi le partage et la réutilisation.

- Services tiers:Les fournisseurs de cloud et les plateformes SaaS commencent à publier des points de terminaison MCP, élargissant ainsi la portée de l'automatisation pilotée par l'IA.

- Collaboration sur les normes ouvertes:La spécification MCP est en cours de développement actif, avec des contributions des principaux fournisseurs d'IA et d'automatisation visant à améliorer l'interopérabilité.

Voir aussi Comment utiliser n8n avec CometAPI

Conclusion

L'intégration de n8n aux serveurs MCP transforme les workflows statiques en services dynamiques pilotés par l'IA et permet à n8n d'utiliser des outils externes orientés IA. L'introduction récente des nœuds MCP Client Tool et MCP Server Trigger représente une avancée significative, simplifiant le développement et la maintenance des pipelines d'automatisation intelligents. En appliquant les meilleures pratiques d'installation, de configuration, de sécurité et de test, les entreprises peuvent exploiter tout le potentiel de cette intégration pour innover plus rapidement, réduire les coûts d'ingénierie et proposer une automatisation contextuelle pour divers cas d'utilisation.