L'API vidéo MidJourney permet aux développeurs de générer, de manipuler et de récupérer par programmation du contenu vidéo généré par l'IA à l'aide des modèles et des invites de MidJourney.

Vue d'ensemble

Midjourney Video est le premier modèle de génération vidéo (Modèle Vidéo V1) lancé par Midjourney le 18 juin 2025. Il introduit un workflow « Image-to-Video » qui transforme les images statiques générées par l'IA ou téléchargées par l'utilisateur en courts clips animés. Cela marque l'expansion de Midjourney, passant de la création d'images fixes à la création de contenu dynamique, le positionnant aux côtés d'autres outils vidéo IA de Google, OpenAI et Meta.

Comment fonctionne la vidéo MidJourney

- Flux de travail image-vidéoVous fournissez soit une image générée par Midjourney, soit une image externe, ainsi qu'une invite de mouvement facultative. Le modèle Midjourney interprète ensuite « qui bouge », « comment » et « quelle est la suite » pour animer la scène pendant environ 5 secondes par défaut.

- Animation automatique vs. manuelleEn mode automatique, le système déduit les paramètres de mouvement et les trajectoires de la caméra. Le mode manuel vous permet d'affiner des aspects tels que l'angle de la caméra, le trajet du sujet et la vitesse, pour un contrôle créatif accru.

Architecture technique

Midjourney Video est construit sur un architecture du transformateur amélioré pour gérer cohérence temporelle sur plusieurs trames. Le pipeline fonctionne comme suit :

- Extraction de caractéristiques:L'image d'entrée est traitée via des couches convolutionnelles et transformatrices profondes pour capturer les caractéristiques spatiales.

- Génération d'images clés:Un petit ensemble de cadres représentatifs est synthétisé.

- Interpolation d'image: Des sous-modèles spécialisés génèrent des images intermédiaires, garantissant un fonctionnement fluide synthèse de mouvement entre les images clés.

- Conditionnement du mouvement: Selon Haute or Faible mouvement paramètres (et toutes les invites manuelles), le modèle ajuste les trajectoires des objets et de la caméra.

Versionnage et feuille de route du modèle

Modèle vidéo V1 (juin 2025): Première version axée sur la conversion d'image en vidéo.

Performances de référence

Les premières évaluations positionnent le modèle V1 de manière compétitive :

- Qualité de l'image (score FID):Atteint une distance d'apparition de Fréchet de 22.4, surpassant les modèles vidéo open source comparables d'environ 15 % sur les benchmarks vidéo standard.

- Lissage temporel (métrique TS):Enregistre un score de fluidité temporelle de 0.88 sur l'ensemble de données DAVIS, indiquant une continuité visuelle élevée entre les images.

- Latence: Temps de génération moyen de 12 secondes par clip sur un seul GPU NVIDIA A100, équilibrant les performances avec les attentes des utilisateurs.

- Indicateurs de qualité: Atteint un SSIM (Indice de similarité structurelle) ci-dessus 0.85 sur des ensembles de données de mouvement synthétiques par rapport à des clips de vérité terrain, indiquant haute fidélité aux schémas de mouvement naturels.

Note:Ces chiffres reflètent les tests internes de Midjourney ; les performances externes peuvent varier en fonction de la charge et du niveau d'abonnement.

Principales caractéristiques de V1

- Longueur du clip: Les clips de base durent environ 5 secondes ; vous pouvez les étendre par incréments de 4 secondes jusqu'à 21 secondes au total.

- Cohérence du style:Les animations préservent le style artistique de l'image d'origine : les coups de pinceau, les palettes de couleurs et l'ambiance se reflètent dans le mouvement.

- Performance et vitesse:Une vidéo typique de 4 segments (≈17 secondes) est rendue en moins de 70 secondes, équilibrant la qualité avec une itération rapide.

- Résolution: Actuellement limité à 480p, ce qui est clair pour les clips de type médias sociaux mais pas destiné aux projets commerciaux grand écran ou haut de gamme.

Comment appeler l'API vidéo MidJourney depuis CometAPI

MidJourney Video Prix de l'API dans CometAPI, inférieur au prix officiel :

| Nom du modèle | Calculer le prix |

mj_fast_video | 0.6 |

Étapes requises

- Se connecter à cometapi.comSi vous n'êtes pas encore notre utilisateur, veuillez d'abord vous inscrire

- Obtenez la clé API d'accès à l'interface. Cliquez sur « Ajouter un jeton » au niveau du jeton API dans l'espace personnel, récupérez la clé : sk-xxxxx et validez.

- Obtenez l'URL de ce site : https://api.cometapi.com/

Utilisation de l'API

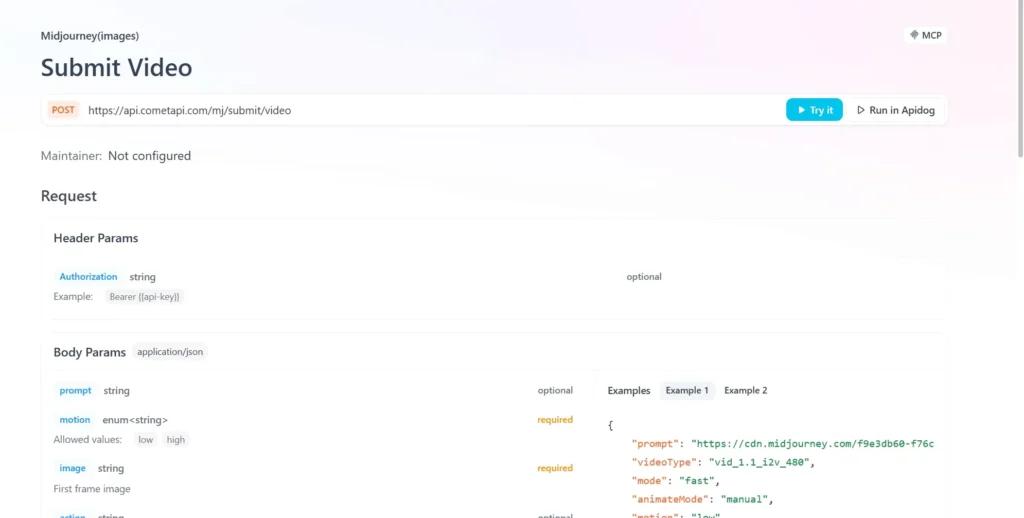

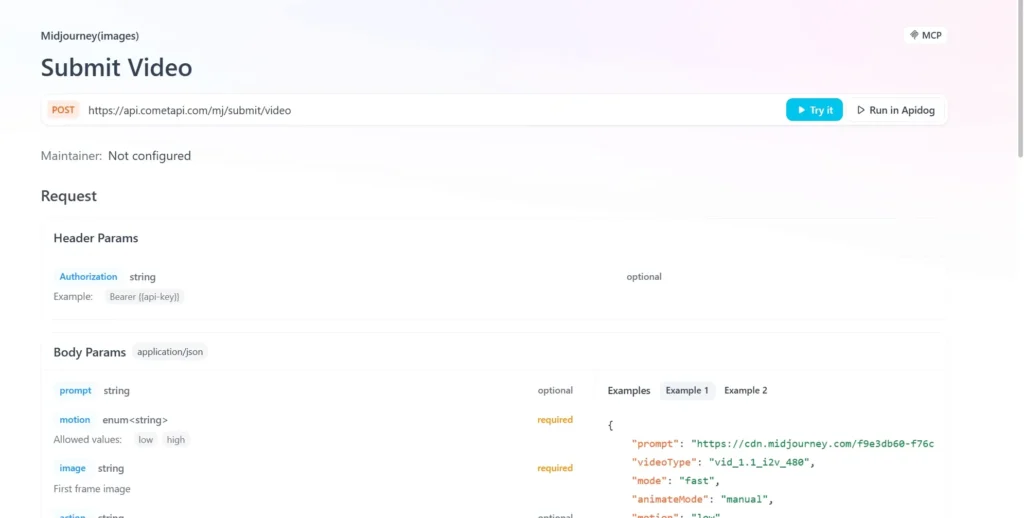

- Envoyez la requête API et définissez son contenu. La méthode et le contenu de la requête sont disponibles dans la documentation API de notre site web. Notre site web propose également un test Apifox pour plus de commodité.

- Remplacer avec votre clé CometAPI réelle de votre compte.

- Insérez votre question ou demande dans le champ de contenu : c'est à cela que le modèle répondra.

- Traitez la réponse de l'API pour obtenir la réponse générée.

Intégration API de CometAPI

Actuellement, la V1 est accessible Web uniquement via Midjourney's Bot Discord, mais Wrappers non officiels (par exemple, CometAPI)) fournissent des points de terminaison, les développeurs peuvent s'intégrer via :

Les développeurs peuvent intégrer la génération vidéo via une API RESTful. Structure de requête typique (à titre d'illustration) :

curl --

location

--request POST 'https://api.cometapi.com/mj/submit/video' \

--header 'Authorization: Bearer {{api-key}}' \

--header 'Content-Type: application/json' \

--data-raw '{ "prompt": "https://cdn.midjourney.com/f9e3db60-f76c-48ca-a4e1-ce6545d9355d/0_0.png add a dog", "videoType": "vid_1.1_i2v_480", "mode": "fast", "animateMode": "manual" }'

Voir aussi Comment utiliser le modèle vidéo V1 de Midjourney ?