Qu’est-ce que l’API GPT-5.2

L’API GPT-5.2 est identique à GPT-5.2 Thinking dans ChatGPT. GPT-5.2 Thinking est la variante intermédiaire de la famille GPT-5.2 d’OpenAI, conçue pour le travail approfondi : raisonnement multi-étapes, résumé de longs documents, génération de code de qualité, et travail intellectuel professionnel où la précision et une structure exploitable priment sur le débit brut. Dans l’API, elle est exposée comme le modèle gpt-5.2 (Responses API / Chat Completions), et se situe entre la variante Instant à faible latence et la variante Pro de meilleure qualité mais plus coûteuse.

Fonctionnalités principales

- Contexte très long et compactage : fenêtre effective de 400K et outils de compactage pour gérer la pertinence à travers de longues conversations et des documents.

- Effort de raisonnement configurable :

none | medium | high | xhigh(xhigh active le calcul interne maximal pour les raisonnements difficiles).xhighest disponible pour les variantes Thinking/Pro. - Prise en charge renforcée des outils et des fonctions : appel d’outils de première classe, grammaires (CFG/Lark) pour contraindre les résultats structurés, et comportements agentiques améliorés qui simplifient des automatisations complexes en plusieurs étapes.

- Compréhension multimodale : compréhension plus riche des images + du texte et intégration dans des tâches en plusieurs étapes.

- Sécurité améliorée / gestion des contenus sensibles : interventions ciblées pour réduire les réponses indésirables dans des domaines comme l’automutilation et d’autres contextes sensibles.

Capacités techniques & spécifications (vue développeur)

- Points de terminaison d’API & ID de modèles :

gpt-5.2pour Thinking (Responses API),gpt-5.2-chat-latestpour les workflows chat/instant, etgpt-5.2-propour le niveau Pro ; disponibles via Responses API et Chat Completions là où indiqué. - Jetons de raisonnement & gestion de l’effort : l’API prend en charge des paramètres explicites pour allouer le calcul (effort de raisonnement) par requête ; un effort plus élevé augmente la latence et le coût mais améliore la qualité de sortie pour les tâches complexes.

- Outils de sortie structurée : prise en charge de grammaires (Lark / CFG) pour contraindre la sortie du modèle à un DSL ou une syntaxe exacte (utile pour SQL, JSON, génération de DSL).

- Appel d’outils parallèle & coordination agentique : parallélisme amélioré et orchestration des outils plus propre réduisent le besoin de prompts système élaborés et de structures multi-agents.

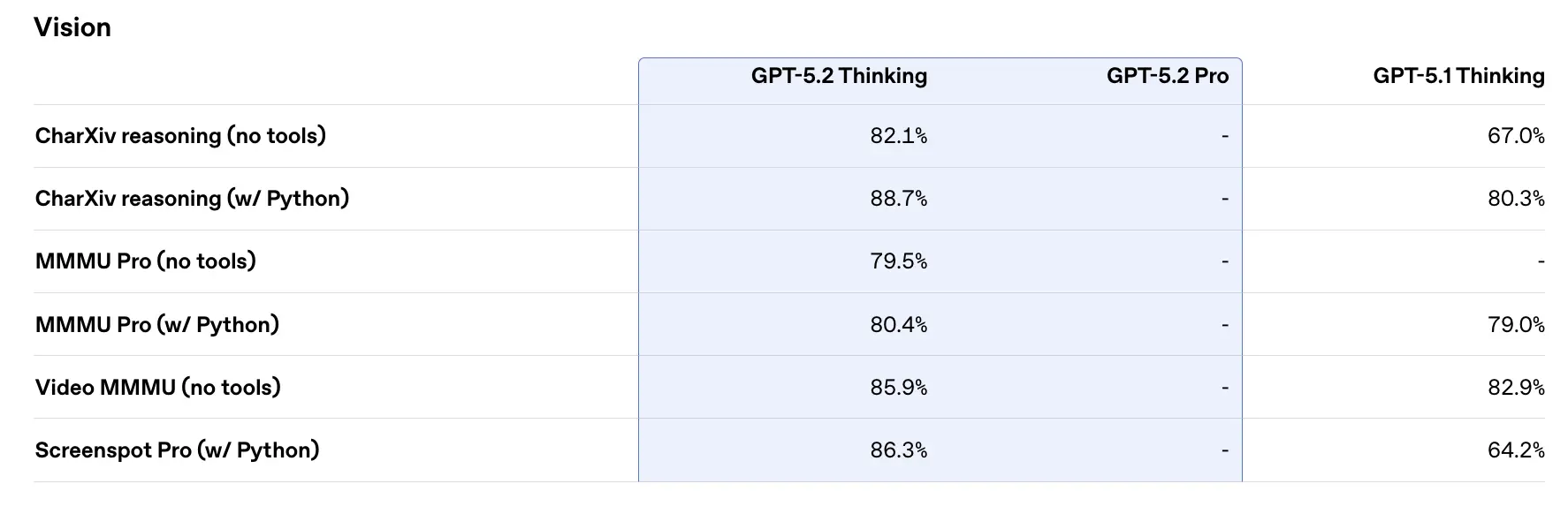

Performances de référence & données à l’appui

OpenAI a publié une variété de résultats de benchmarks internes et externes pour GPT-5.2. Faits saillants sélectionnés (chiffres rapportés par OpenAI) :

- GDPval (44 professions, knowledge work) — GPT-5.2 Thinking “surpasse ou égale les meilleurs professionnels du secteur dans 70.9% des comparaisons” ; OpenAI indique que les résultats ont été produits à >11× la vitesse et à <1% du coût des professionnels experts sur leurs tâches GDPval (estimations de vitesse et de coût basées sur l’historique). Ces tâches incluent des modèles de feuilles de calcul, des présentations et de courtes vidéos.

- SWE-Bench Pro (coding) — GPT-5.2 Thinking atteint ≈55.6% sur SWE-Bench Pro et ~80% sur SWE-Bench Verified (Python uniquement) selon OpenAI, établissant un nouvel état de l’art pour l’évaluation génération de code / ingénierie dans leurs tests. En pratique, cela se traduit par un débogage plus fiable et des correctifs de bout en bout, d’après les exemples d’OpenAI.

- GPQA Diamond (graduate-level science Q&A) — GPT-5.2 Pro : 93.2%, GPT-5.2 Thinking : 92.4% sur GPQA Diamond (sans outils, raisonnement maximal).

- ARC-AGI series — Sur ARC-AGI-2 (benchmark de raisonnement fluide plus difficile), GPT-5.2 Thinking a obtenu 52.9% et GPT-5.2 Pro 54.2% (OpenAI affirme qu’il s’agit de nouvelles marques à l’état de l’art pour des modèles de style chaîne de pensée).

- Long-context (OpenAI MRCRv2) — GPT-5.2 Thinking montre une précision proche de 100% sur la variante MRCR à 4 aiguilles jusqu’à 256k jetons et des scores substantiellement améliorés vs GPT-5.1 dans des contextes longs. (OpenAI a publié des graphiques et des tableaux MRCRv2.)

Comparaison avec les contemporains

- vs Google Gemini 3 (Gemini 3 Pro / Deep Think): Gemini 3 Pro a été publicisé avec une fenêtre de contexte de ~1,048,576 (≈1M) token et des entrées multimodales étendues (texte, image, audio, vidéo, PDF) ainsi que de fortes intégrations agentiques via Vertex AI / AI Studio. Sur le papier, la fenêtre de contexte plus grande de Gemini 3 est un différenciateur pour des charges de travail à session unique extrêmement volumineuses ; les compromis incluent la surface d’outillage et l’adéquation à l’écosystème.

- vs Anthropic Claude Opus 4.5: Opus 4.5 d’Anthropic met l’accent sur les workflows d’agent et de développement en entreprise et rapporte de solides résultats SWE-bench ainsi qu’une robustesse pour de longues sessions agentiques ; Anthropic positionne Opus pour l’automatisation et la génération de code avec une fenêtre de contexte de 200k et des intégrations agent/Excel spécialisées. Opus 4.5 est un concurrent solide pour l’automatisation en entreprise et les tâches de code.

À retenir en pratique : GPT-5.2 vise un ensemble équilibré d’améliorations (contexte 400k, sorties en nombre de jetons élevé, raisonnement/codage améliorés). Gemini 3 vise les contextes à session unique absolument les plus grands (≈1M), tandis que Claude Opus se concentre sur l’ingénierie en entreprise et la robustesse agentique. Choisissez en fonction de la taille du contexte, des besoins de modalité, de l’adéquation des fonctionnalités/outillage, et des compromis coût/latence.

Comment accéder et utiliser l’API GPT-5.2

Étape 1 : Inscrivez-vous pour obtenir une clé API

Connectez-vous à cometapi.com. Si vous n’êtes pas encore utilisateur, veuillez vous enregistrer d’abord. Connectez-vous à votre CometAPI console. Récupérez la clé API d’accès à l’interface. Cliquez sur “Add Token” dans la section API token du centre personnel, obtenez la clé de jeton : sk-xxxxx et validez.

Étape 2 : Envoyez des requêtes à l’API GPT-5.2

Sélectionnez le point de terminaison “gpt-5.2” pour envoyer la requête API et définissez le corps de requête. La méthode et le corps de requête sont obtenus depuis la documentation API de notre site. Notre site fournit également des tests Apifox pour votre commodité. Remplacez <YOUR_API_KEY> par votre clé CometAPI réelle depuis votre compte. Les développeurs appellent ceci via les points de terminaison Responses API / Chat.

Insérez votre question ou requête dans le champ content — c’est à cela que le modèle répondra. Traitez la réponse de l’API pour obtenir la réponse générée.

Étape 3 : Récupérez et vérifiez les résultats

Traitez la réponse de l’API pour obtenir la réponse générée. Après traitement, l’API renvoie le statut de la tâche et les données de sortie.

Voir aussi API d’aperçu Gemini 3 Pro