Fonctionnalités clés

- Deux variantes :

grok-4-1-fast-reasoning(pensée / agentique) etgrok-4-1-fast-non-reasoning(réponses « Fast » instantanées). - Fenêtre de contexte massive : 2,000,000 jetons — conçue pour des transcriptions de plusieurs heures, de grandes collections de documents et une planification longue sur plusieurs tours.

- API d’outils d’agent de première partie : navigation web/X intégrée, exécution de code côté serveur, recherche de fichiers et connecteurs « MCP » afin que le modèle puisse agir comme un agent autonome sans couche d’intégration externe.

- Modalités : Multimodal (texte + images et capacités visuelles améliorées incluant l’analyse de graphiques et une extraction au niveau OCR).

Comment fonctionne Grok 4.1 Fast ?

- Architecture et modes : Grok 4.1 Fast est présenté comme une seule famille de modèles pouvant être configurée pour le mode « raisonnement » (chaînes de pensée internes et délibération accrue) ou pour un fonctionnement « rapide » sans raisonnement, pour une latence plus faible. Le mode raisonnement peut être activé/désactivé via des paramètres API (par exemple,

reasoning.enabled) sur des couches fournisseur telles que CometAPI. - Signal d’entraînement : xAI rapporte un apprentissage par renforcement dans des environnements agentiques simulés (formation fortement axée sur les outils) afin d’améliorer les performances sur des tâches d’appels d’outils à long horizon et multi-tours (ils mentionnent un entraînement sur τ²-bench Telecom et du RL en long contexte).

- Orchestration des outils : Les outils s’exécutent sur l’infrastructure xAI ; Grok peut invoquer plusieurs outils en parallèle et décider de plans agentiques sur plusieurs tours (recherche web, recherche sur X, exécution de code, récupération de fichiers, serveurs MCP).

- Débit et limites de taux : des limites publiées à titre d’exemple incluent 480 requêtes/minute et 4,000,000 jetons/minute pour le cluster

grok-4-1-fast-reasoning.

Versions et nomenclature du modèle Grok 4.1 fast

grok-4-1-fast-reasoning— mode agentique « pensant » : jetons de raisonnement internes, orchestration d’outils, idéal pour des workflows complexes en plusieurs étapes.grok-4-1-fast-non-reasoning— mode « Fast » instantané : nombre minimal de jetons de pensée internes, latence réduite pour la conversation, le brainstorming et la rédaction courte.

Performances aux benchmarks de Grok 4.1 fast

xAI met en avant plusieurs victoires et des améliorations mesurées par rapport aux versions Grok précédentes et à certains modèles concurrents. Chiffres publiés clés :

- τ²-bench (benchmark télécom agentique d’outils) : score déclaré de 100 % avec un coût total de $105。

- Berkeley Function Calling v4 : précision globale déclarée de 72 % (chiffre publié par xAI) avec un coût total d’environ ~$400 dans ce contexte de benchmark.

- Recherche et recherche agentique (Research-Eval / Reka / X Browse) : xAI rapporte des scores supérieurs et un coût plus bas par rapport à plusieurs concurrents sur des benchmarks internes/de l’industrie de recherche agentique (exemples : Grok 4.1 Fast : scores Research-Eval et X Browse sensiblement plus élevés que GPT-5 et Claude Sonnet 4.5 dans les tableaux publiés par xAI).

- Factualité / hallucinations : Grok 4.1 Fast divise par deux le taux d’hallucination par rapport à Grok 4 Fast sur FActScore et des métriques internes associées.

Limites et risques de Grok 4.1 fast

- Les hallucinations sont réduites, pas éliminées. Les diminutions publiées sont significatives (xAI signale une réduction substantielle des taux d’hallucination par rapport au précédent Grok 4 Fast), mais des erreurs factuelles se produisent encore dans des cas limites et des workflows à réponse rapide — validez indépendamment les sorties critiques.

- Surface de confiance des outils : les outils côté serveur augmentent la commodité mais élargissent aussi la surface d’attaque (mauvais usage des outils, résultats externes incorrects ou sources obsolètes). Utilisez des vérifications de provenance et des garde-fous ; considérez les sorties d’outils automatisés comme des éléments à vérifier.

- Pas universellement SOTA : des avis indiquent que la série Grok excelle en STEM, en raisonnement et dans les tâches agentiques à long contexte, mais peut être en retrait sur certaines tâches de compréhension visuelle multimodale et de génération créative par rapport aux toutes dernières offres multimodales d’autres fournisseurs.

Comment Grok 4.1 fast se compare à d’autres modèles leaders

- Par rapport à Grok 4 / Grok 4.1 (non-Fast) : Fast échange une partie du calcul interne/de la « pensée » contre une latence et une économie de jetons, tout en visant à maintenir une qualité de raisonnement proche des niveaux de Grok 4 ; il est optimisé pour un usage agentique en production plutôt que pour un raisonnement de pointe sur des benchmarks hors ligne lourds. ([xAI][5])

- Par rapport aux familles Google Gemini / OpenAI GPT / Anthropic Claude : des avis indépendants et la presse tech notent les points forts de Grok en raisonnement logique, appels d’outils et gestion de long contexte, tandis que d’autres fournisseurs dominent parfois en vision multimodale, génération créative ou différents compromis prix/performance.

- Comment accéder à l’API Grok 4.1 fast

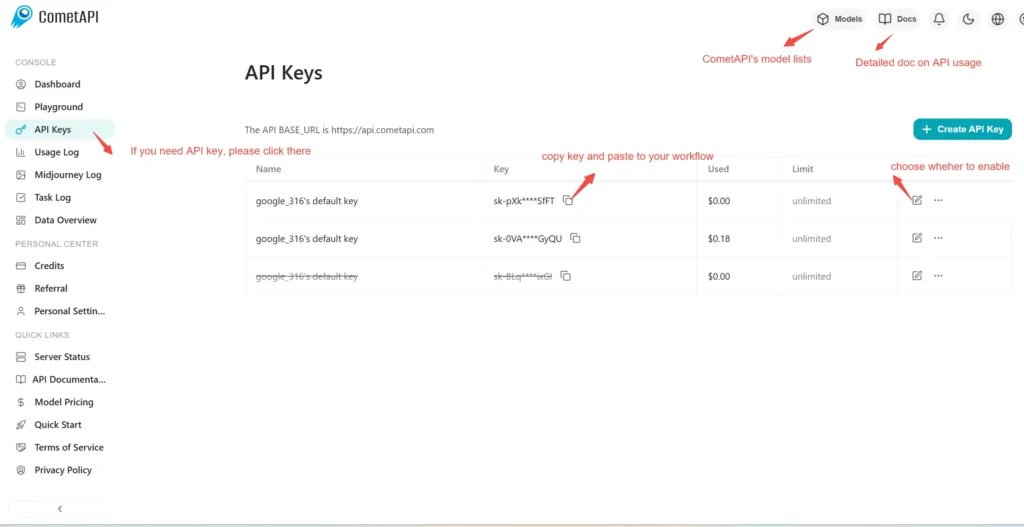

Étape 1 : S’inscrire pour obtenir une clé API

Se connecter à cometapi.com. Si vous n’êtes pas encore utilisateur, veuillez d’abord vous inscrire. Connectez-vous à votre console CometAPI. Obtenez les informations d’identification d’accès de la clé API de l’interface. Cliquez sur « Add Token » au niveau du jeton API dans le centre personnel, obtenez la clé de jeton : sk-xxxxx et soumettez.

Étape 2 : Envoyer des requêtes à l’API Grok 4.1 fast

Sélectionnez le « \grok-4-1-fast-reasoning/ grok-4-1-fast-non-reasoning\ » endpoint pour envoyer la requête API et définissez le corps de la requête. La méthode de requête et le corps de la requête sont obtenus depuis la documentation API de notre site web. Notre site propose également Apifox en test pour votre commodité. Remplacez <YOUR_API_KEY> par votre clé CometAPI réelle provenant de votre compte. base url is Chat format(https://api.cometapi.com/v1/chat/completions).

Insérez votre question ou votre demande dans le champ content — c’est ce à quoi le modèle répondra. Traitez la réponse de l’API pour obtenir la réponse générée.

Étape 3 : Récupérer et vérifier les résultats

Traitez la réponse de l’API pour obtenir la réponse générée. Après traitement, l’API répond avec le statut de la tâche et les données de sortie.