OpenAI, Anthropic et Google continuent de repousser les limites des grands modèles linguistiques avec leurs dernières offres phares : o3 d'OpenAI (et sa variante améliorée o3-pro), Claude Opus 4 d'Anthropic et Gemini 2.5 Pro de Google. Chacun de ces modèles apporte des innovations architecturales uniques, des performances exceptionnelles et des intégrations écosystémiques adaptées à différents cas d'usage, de l'assistance au codage pour les entreprises aux améliorations de la recherche grand public. Cette comparaison approfondie examine leur historique de versions, leurs capacités techniques, leurs performances de référence et les applications recommandées pour aider les entreprises à choisir le modèle le plus adapté à leurs besoins.

Qu'est-ce que l'o3 d'OpenAI et comment a-t-il évolué ?

OpenAI a présenté o3 pour la première fois le 16 avril 2025, le positionnant comme « notre modèle le plus intelligent », conçu pour un contexte étendu et des réponses extrêmement fiables. Peu après, le 10 juin 2025, OpenAI a publié o3-pro, une variante optimisée pour les performances, disponible pour les utilisateurs Pro dans ChatGPT et via l'API, qui offre une inférence plus rapide et un débit plus élevé sous fortes charges.

Fenêtre de contexte et débit

OpenAI o3 propose un 200 XNUMX jetons Fenêtre contextuelle pour les entrées et les sorties, permettant la gestion de documents volumineux, de bases de code ou de conversations à plusieurs tours sans troncatures fréquentes. Son débit est d'environ 37.6 jetons/sec, qui, sans être en tête du peloton, offre une réactivité constante pour les charges de travail soutenues.

Raisonnement délibératif avancé

- « Chaîne de pensée privée »:o3 a été formé avec l'apprentissage par renforcement pour planifier et raisonner à travers des étapes intermédiaires avant de produire son résultat final, améliorant considérablement sa capacité de déduction logique et de décomposition de problèmes.

- Alignement délibératif:Il intègre des techniques de sécurité qui guident le modèle pour adhérer de manière plus fiable aux directives grâce à un raisonnement étape par étape, réduisant ainsi les erreurs majeures dans les tâches complexes du monde réel.

Tarification et intégration d'entreprise

Le prix d'OpenAI pour o3 s'élève à environ $2 par million de jetons d'entrée et 8 $ par million de jetons de sortie. Cela le positionne en milieu de gamme : plus abordable que les modèles haut de gamme comme Claude Opus 4 pour les charges de travail lourdes, mais plus coûteux que des alternatives plus économiques comme Gemini 2.5 Pro. Point crucial, les entreprises bénéficient d'une intégration transparente avec l'écosystème plus large des API OpenAI, couvrant les intégrations, les réglages fins et les points de terminaison spécialisés, minimisant ainsi les frais d'intégration.

Comment Claude Opus 4 se différencie-t-il sur le marché ?

Anthropic a annoncé Claude Opus 4 le 22 mai 2025, le présentant comme « le meilleur modèle de codage au monde », offrant des performances soutenues sur les tâches complexes et longues, ainsi que sur les workflows d'agents. Lancé simultanément via l'API d'Anthropic et Amazon Bedrock, il est désormais accessible aux clients AWS via les fonctions LLM et l'API REST de Bedrock...

Capacités de « réflexion » étendues

Une caractéristique distinctive de l'Opus 4 est son « pensée étendue » Mode bêta, qui répartit dynamiquement les ressources de calcul entre le raisonnement sur le modèle et les appels d'outils (par exemple, recherche, récupération, API externes). Grâce aux « résumés de réflexion », les utilisateurs bénéficient d'une visibilité sur la chaîne de raisonnement interne du modèle, essentielle pour les applications sensibles à la conformité dans les secteurs de la finance et de la santé.

Compromis entre prix et contexte

At $15 par million de jetons d'entrée et 75 $ par million de jetons de sortie, Claude Opus 4 se situe au sommet de la gamme de prix. Son 200 XNUMX jetons fenêtre de saisie (avec un 32 XNUMX jetons Le plafond de sortie (output cap) est inférieur à la fenêtre de 2.5 million de jetons de Gemini 1 Pro, mais suffisant pour la plupart des tâches de révision de code et de raisonnement détaillé. Anthropic justifie ce supplément en mettant l'accent sur l'intensité de calcul interne et la fidélité soutenue de la chaîne de pensée, avec jusqu'à 90 % d'économies grâce à la mise en cache rapide et 50 % grâce au traitement par lots. Des budgets de réflexion étendus sont inclus pour les niveaux payants ; les utilisateurs gratuits n'ont accès qu'à la variante Sonnet.

Quelles fonctionnalités et performances uniques Gemini 2.5 Pro apporte-t-il ?

Lancé en tant que niveau « Pro » de nouvelle génération de Google, Gémeaux 2.5 Pro cible les organisations nécessitant un contexte massif, des données multimodales et une évolutivité rentable. Il prend notamment en charge jusqu'à Jetons 1,048,576 dans une seule invite (entrante) et Jetons 65,535 sortant, permettant des flux de travail de documents de bout en bout qui s'étendent sur des centaines de milliers de pages.

Contexte supérieur et multimodalité

Gemini 2.5 Pro brille par son Jeton 1M Fenêtre contextuelle, facilitant des cas d'usage tels que l'analyse de contrats juridiques, l'exploration de brevets et la refactorisation complète de bases de code. Le modèle accepte nativement texte, code, images, audio, PDF et cadres vidéo, rationalisant les pipelines multimodaux sans étapes de prétraitement séparées.

Comment Gemini améliore-t-il la recherche multimodale et conversationnelle ?

Gemini 2.5 Pro se distingue par sa méthodologie de « requête en éventail » : il décompose les requêtes complexes en sous-questions, effectue des recherches parallèles et synthétise instantanément des réponses complètes et conversationnelles. Grâce à la prise en charge des saisies textuelles, vocales et visuelles, le mode IA exploite les capacités multimodales de Gemini pour répondre aux diverses interactions utilisateur, même s'il en est encore à ses débuts et peut parfois mal interpréter les requêtes.

Des prix compétitifs

Avec un taux d'entrée de 1.25 $ à 2.50 $ par million de jetons et 10 $ à 15 $ par million de jetons de sortie, Gemini 2.5 Pro offre le meilleur prix par jeton Le ratio entre les trois solutions est particulièrement attractif pour les applications volumineuses et gourmandes en documents, où les longs contextes stimulent davantage la consommation de jetons que les indicateurs de performance bruts. Les forfaits premium permettent d'accéder à des budgets « Deep Think » et à un débit plus élevé. Les abonnements Google AI Pro et Ultra regroupent l'accès à Gemini 2.5 Pro ainsi qu'à d'autres outils comme la génération vidéo Veo et NotebookLM.

Architectures et capacités sous-jacentes

OpenAI o3 : Raisonnement réflexif à grande échelle

o3 d'OpenAI est un transformateur génératif réflexif pré-entraîné conçu pour allouer un temps de délibération supplémentaire aux tâches de raisonnement logique étape par étape. Son architecture s'appuie sur l'architecture de transformateur de GPT-4, mais intègre un mécanisme de « budget de réflexion » : le modèle alloue dynamiquement davantage de cycles de calcul aux problèmes complexes, créant ainsi des chaînes de pensée internes avant de générer des résultats. Il en résulte une nette amélioration des performances dans les domaines nécessitant un raisonnement en plusieurs étapes, tels que les mathématiques avancées, la recherche scientifique et la synthèse de code.

Claude Opus 4 : Raisonnement hybride pour flux de travail étendus

Claude Opus 4 d'Anthropic est son modèle le plus puissant à ce jour, optimisé pour le codage et les workflows agentiques soutenus. Comme o3, il s'appuie sur un noyau de transformateur, mais introduit des modes de raisonnement hybrides – réponses quasi instantanées (« réflexion rapide ») et délibération prolongée (« réflexion approfondie ») – lui permettant de maintenir le contexte sur des milliers d'étapes et des heures de calcul. Cette approche hybride rend Opus 4 particulièrement adapté aux pipelines d'ingénierie logicielle de longue durée, aux tâches de recherche en plusieurs étapes et à l'orchestration d'agents autonomes.

Gemini 2.5 Pro : une réflexion multimodale avec des budgets adaptatifs

Gemini 2.5 Pro de Google DeepMind étend les capacités natives de multimodalité et de raisonnement de Gemini. Il introduit « Deep Think », un mécanisme adaptatif de réflexion parallèle qui répartit les sous-tâches entre les modules internes et synthétise les résultats en réponses cohérentes. Gemini 2.5 Pro bénéficie également d'une fenêtre contextuelle exceptionnellement longue, lui permettant d'ingérer des bases de code entières, de grands ensembles de données (texte, audio, vidéo) et des documents de conception en une seule passe, tout en offrant un contrôle précis des budgets de réflexion pour un compromis performance-coût.

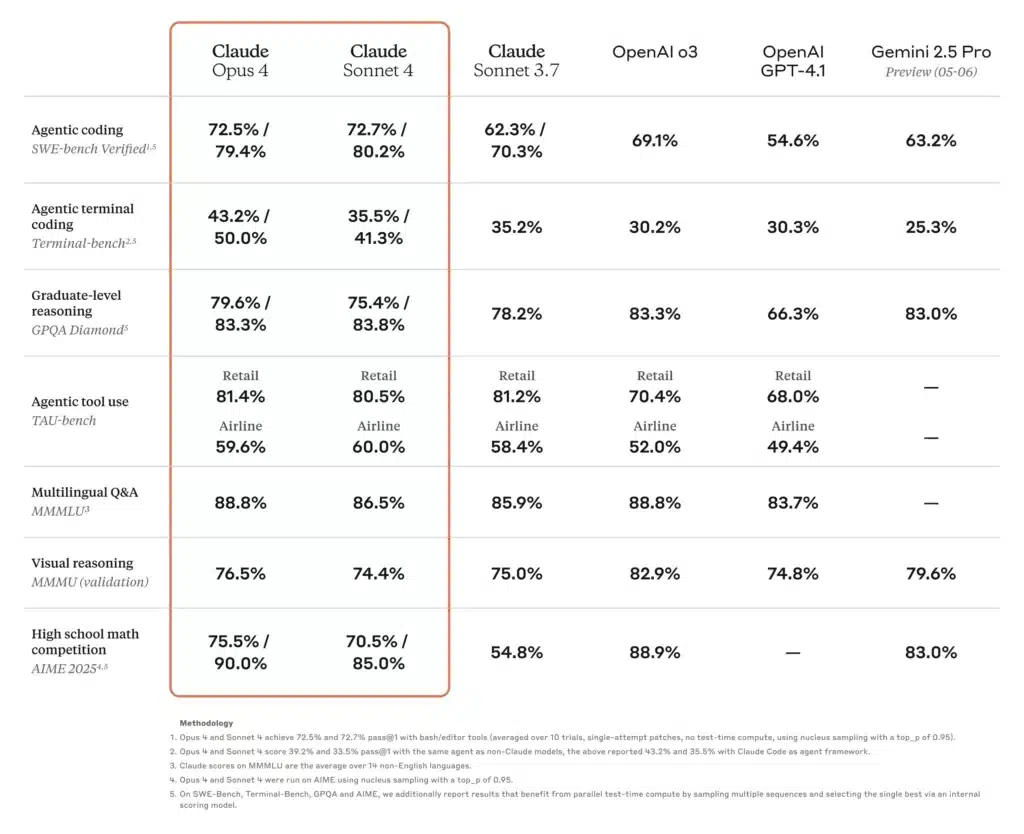

Comment les benchmarks de performance se comparent-ils entre ces modèles ?

Raisonnement académique et scientifique

Dans un récent classement SciArena, o3 a dominé ses pairs sur des questions de raisonnement technique évaluées par des chercheurs, ce qui témoigne de la forte confiance de la communauté dans sa précision scientifique. Parallèlement, Claude Opus 4 a démontré des performances supérieures dans des tests basés sur des agents nécessitant une résolution de problèmes soutenue de plusieurs heures, surpassant les modèles Sonnet jusqu'à 30 % sur des tâches TAU-bench et de raisonnement prédictif. Gemini 2.5 Pro est également en tête de nombreux tests académiques, se classant n° 1 sur LMArena pour les mesures de préférence humaine et affichant des marges significatives aux tests de mathématiques et de sciences.

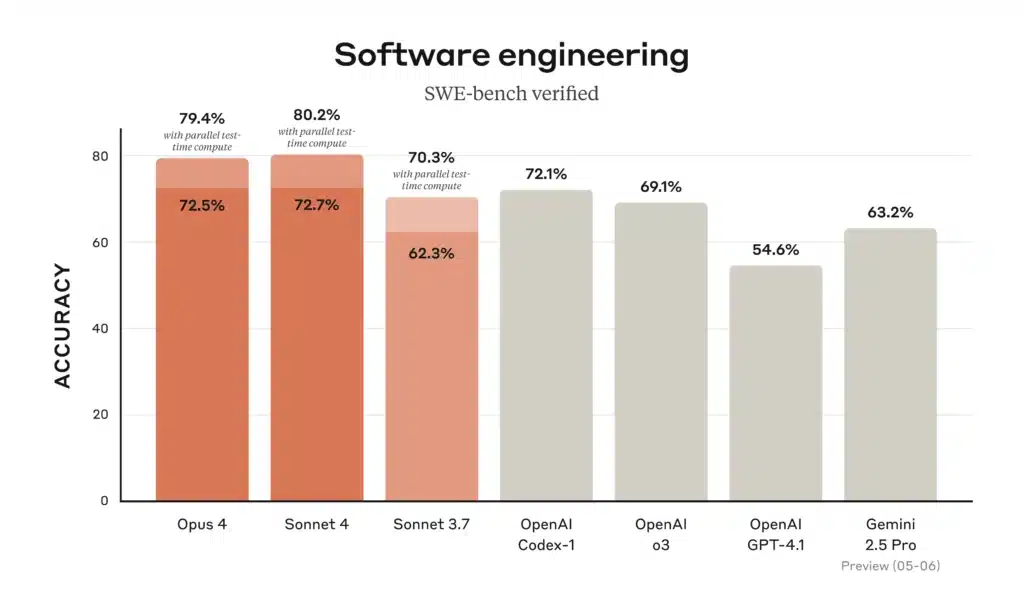

Codage et ingénierie logicielle

Dans les classements de codage, Gemini 2.5 Pro « domine la populaire WebDev Arena » et domine les benchmarks de codage courants, grâce à sa capacité à charger et à raisonner sur des référentiels entiers. Claude Opus 4 détient le titre de « meilleur modèle de codage au monde », avec 72.5 % sur SWE-bench et 43.2 % sur Terminal-bench, des benchmarks axés sur les tâches logicielles complexes et de longue durée. o3 excelle également dans la synthèse de code et le débogage, mais se situe légèrement derrière Opus 4 et Gemini dans les scénarios d'ingénierie à plusieurs étapes et à grande échelle ; néanmoins, sa chaîne de pensée intuitive le rend très fiable pour les tâches de codage individuelles.

Utilisation des outils et intégration multimodale

La conception multimodale de Gemini 2.5 Pro (traitement de texte, d'images, d'audio et de vidéo) lui confère un avantage certain dans les workflows créatifs tels que les simulations interactives, l'analyse visuelle de données et le storyboard vidéo. L'utilisation des outils agentiques de Claude Opus 4, notamment l'interface de ligne de commande Claude Code et les opérations intégrées sur le système de fichiers, excelle dans la création de pipelines autonomes entre API et bases de données. o3 prend en charge la navigation Web, l'analyse de fichiers, l'exécution Python et le raisonnement d'images, ce qui en fait un « couteau suisse » polyvalent pour les tâches multiformats, avec toutefois des limites de contexte plus courtes que Gemini 2.5 Pro.

Comment ces modèles se comparent-ils dans des scénarios de codage réels ?

En matière d'assistance au codage, les benchmarks ne sont qu'une partie de l'équation. Les développeurs recherchent une génération de code précise, des compétences en refactoring et la capacité à comprendre le contexte du projet réparti sur plusieurs fichiers.

Taux de précision et d'hallucinations

- Claude Opus 4 est leader dans la prévention des hallucinations, avec moins de cas de références d'API inexistantes ou de signatures de bibliothèque incorrectes, ce qui est essentiel pour les bases de code critiques. Son taux d'hallucinations est estimé à ~% 12 sur les audits de code approfondis par rapport à ~% 18 pour les Gémeaux et ~% 20 pour o3.

- Gémeaux 2.5 Pro excelle dans les transformations en masse (par exemple, la migration de modèles de code sur des dizaines de milliers de lignes), grâce à sa vaste fenêtre de contexte, mais se débat parfois avec des erreurs logiques subtiles dans de grands blocs de code.

- OpenAI o3 reste la référence pour les extraits rapides, la génération de modèles standard et le débogage interactif en raison de sa latence stable et de sa haute disponibilité, mais les développeurs effectuent souvent une validation croisée avec un autre modèle pour détecter les erreurs de cas limites.

Écosystème d'outils et d'API

- Le o3 et GEMINI Exploitez des outils complets (l'API d'appel de fonctions d'OpenAI et le framework Actions intégré de Google respectivement), permettant une orchestration transparente de la récupération de données, des requêtes de base de données et des appels d'API externes.

- Claude Opus 4 est en cours d'intégration dans des frameworks agentiques comme Claude Code (l'outil CLI d'Anthropic) et Amazon Bedrock, offrant des abstractions de haut niveau pour créer des flux de travail autonomes sans orchestration manuelle.

Quel modèle offre le meilleur rapport qualité-prix ?

L’équilibrage des capacités brutes, de la longueur du contexte et du coût donne lieu à des conclusions différentes sur la « meilleure valeur » en fonction des caractéristiques de la charge de travail.

Cas d'utilisation à volume élevé et centrés sur les documents

Si vous traitez de vastes corpus, tels que des référentiels juridiques, de la littérature scientifique ou des archives d’entreprise,Gémeaux 2.5 Pro émerge souvent comme le gagnant. Son Jeton 1M fenêtre et prix de $ 1.25- $ 2.50 (entrée) et $ 10- $ 15 Les jetons (de sortie) offrent une structure de coûts imbattable pour les tâches à contexte long.

Raisonnement approfondi et flux de travail en plusieurs étapes

Lorsque la précision, la fidélité de la chaîne de pensée et les capacités à long terme des agents sont importantes, comme dans la modélisation financière, les contrôles de conformité juridique ou les pipelines de R&D,Claude Opus 4, malgré son prix plus élevé, peut réduire les frais de gestion des erreurs et améliorer le débit de bout en bout en minimisant les réexécutions et les cycles de révision humaine.

Adoption équilibrée des entreprises

Pour les équipes recherchant des performances polyvalentes fiables sans échelle extrême, OpenAI o3 Offre un compromis. Avec une prise en charge étendue des API, des tarifs modérés et de solides résultats de benchmark, il demeure un choix incontournable pour les plateformes de science des données, l'automatisation du support client et les intégrations de produits en phase de démarrage.

Quel modèle d’IA choisir pour vos besoins spécifiques ?

En fin de compte, votre modèle idéal dépend de trois facteurs principaux :

- Échelle du contexte:Pour les charges de travail nécessitant des fenêtres d'entrée massives, Gemini 2.5 Pro domine.

- Profondeur du raisonnement:Si vos tâches impliquent une logique en plusieurs étapes et une faible tolérance aux erreurs, Claude Opus 4 offre une cohérence supérieure.

- Sensibilité aux coûts et adéquation à l'écosystème:Pour les tâches à usage général au sein de la pile OpenAI, en particulier lorsque l'intégration avec les pipelines de données existants est importante, o3 présente une option équilibrée et rentable.

En évaluant le profil de jeton de votre application (entrée par rapport à sortie), la tolérance aux hallucinations et les exigences en matière d'outillage, vous pouvez sélectionner le modèle qui correspond de manière optimale aux besoins techniques et aux contraintes budgétaires.

Voici un tableau comparatif côte à côte résumant les spécifications clés, les mesures de performance, les prix et les cas d'utilisation idéaux pour OpenAI o3, Anthropic Claude Opus 4 et Google Gemini 2.5 Pro :

| Fonctionnalité / Métrique | OpenAI o3 | Claude Opus 4 | Gémeaux 2.5 Pro |

|---|---|---|---|

| Fenêtre de contexte (entrante / sortante) | 200 200 jetons / XNUMX XNUMX jetons | 200 32 jetons / XNUMX XNUMX jetons | 1 048 576 jetons / 65 535 jetons |

| Débit (jetons/s) | ~ 37.6 | ~ 42.1 | ~ 83.7 |

| Latence moyenne | ~2.8 s | ~3.5 s | ~2.52 s |

| Benchmark de codage (SWE-bench) | 69.1% | 72.5% | 63.2% |

| Évaluation de référence en mathématiques (AIME-2025) | 78.4 %¹ | 81.7 %¹ | 83.0% |

| Taux d'hallucinations (audits de code) | ~ 20% | ~ 12% | ~ 18% |

| Entrées multimodales | Texte et code | Texte et code | Texte, code, images, audio, PDF, vidéo |

| Soutien à la « chaîne de pensée » | Standard | Réflexion approfondie avec résumés | Standard |

| API d'appel de fonctions/outils | Oui (fonctions OpenAI) | Oui (via les agents anthropiques et le substrat rocheux) | Oui (Actions Google) |

| Tarification (jetons d'entrée) | 2.00 $ / jetons M | 15.00 $ / jetons M | 1.25 $–2.50 $/M jetons |

| Tarification (jetons de sortie) | 8.00 $ / jetons M | 75.00 $ / jetons M | 10 $–15 $/M jetons |

| Cas d'utilisation idéaux | Chatbots à usage général, support client, extraits de code rapides | Raisonnement profond, bases de code complexes, agents autonomes | Analyse de documents à grande échelle, flux de travail multimodaux |

Les scores mathématiques AIME-2025 pour o3 et Opus 4 sont des valeurs moyennes approximatives basées sur les repères rapportés.

Pour commencer

CometAPI est une plateforme d'API unifiée qui regroupe plus de 500 modèles d'IA provenant de fournisseurs leaders, tels que la série GPT d'OpenAI, Gemini de Google, Claude d'Anthropic, Midjourney, Suno, etc., au sein d'une interface unique et conviviale pour les développeurs. En offrant une authentification, un formatage des requêtes et une gestion des réponses cohérents, CometAPI simplifie considérablement l'intégration des fonctionnalités d'IA dans vos applications. Que vous développiez des chatbots, des générateurs d'images, des compositeurs de musique ou des pipelines d'analyse pilotés par les données, CometAPI vous permet d'itérer plus rapidement, de maîtriser les coûts et de rester indépendant des fournisseurs, tout en exploitant les dernières avancées de l'écosystème de l'IA.

Les développeurs peuvent accéder Gémeaux 2.5 Pro,Claude Opus 4 et API O3 à travers API CometLes dernières versions des modèles répertoriés sont celles en vigueur à la date de publication de l'article. Pour commencer, explorez les fonctionnalités du modèle dans la section cour de récréation et consultez le Guide de l'API Pour des instructions détaillées, veuillez vous connecter à CometAPI et obtenir la clé API avant d'y accéder. API Comet proposer un prix bien inférieur au prix officiel pour vous aider à vous intégrer.

En fin de compte, le choix entre la série o3 d'OpenAI, Claude Opus 4 d'Anthropic et Gemini 2.5 Pro de Google dépend de priorités organisationnelles spécifiques, qu'il s'agisse de performances techniques de pointe, d'une intégration sécurisée en entreprise ou d'expériences client multimodales fluides. En alignant vos cas d'usage sur les atouts et l'écosystème de chaque modèle, vous pouvez exploiter les avancées de l'IA pour stimuler l'innovation dans la recherche, le développement, l'éducation et au-delà.

Note de l'auteur: Au 31 juillet 2025, chacun de ces modèles continue d'évoluer, avec de fréquentes mises à jour mineures et des améliorations de l'écosystème. Consultez toujours la dernière documentation de l'API CometAPI et les tests de performances avant de prendre une décision finale.