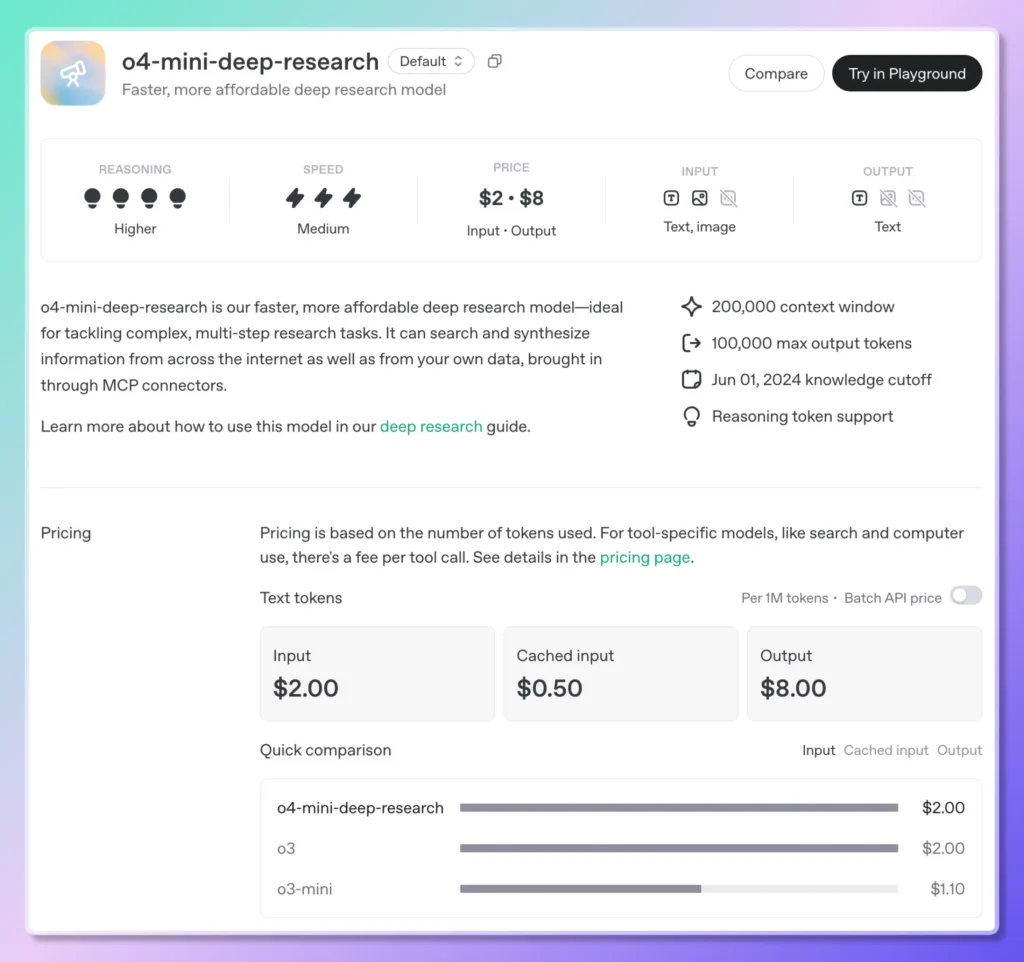

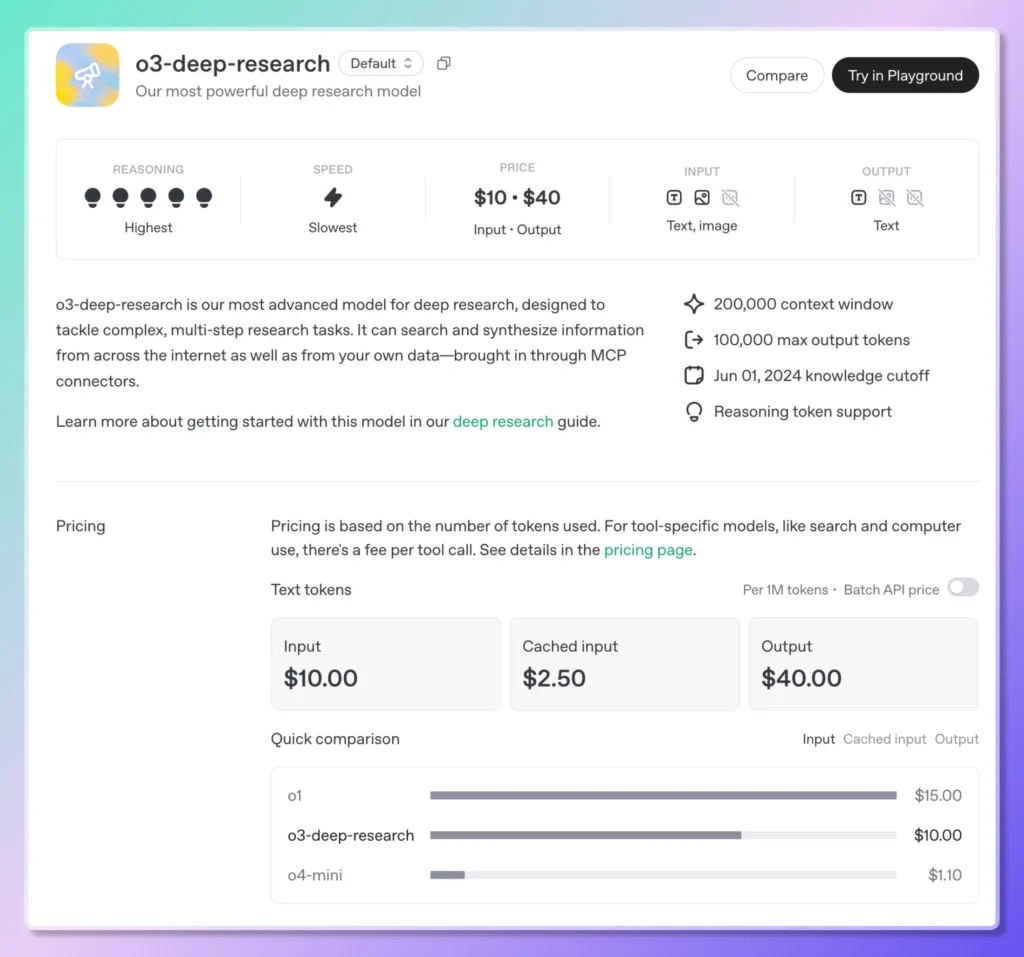

Le 27 juin 2025, OpenAI a officiellement ouvert l'accès API à ses fonctionnalités de recherche approfondie, permettant aux développeurs d'automatiser par programmation des flux de recherche complexes en plusieurs étapes. Baptisé API de recherche approfondie, ce nouveau service expose deux modèles spécialement conçus :o3-deep-research-2025-06-26 pour une synthèse approfondie et une sortie de « meilleure qualité », ainsi que pour une latence plus légère et plus faible o4-mini-deep-research-2025-06-26— via le point de terminaison standard de complétion de chat. Ces modèles s'appuient sur les moteurs de raisonnement introduits dans l'agent Deep Research de ChatGPT plus tôt cette année, mais offrent désormais aux développeurs un contrôle total sur la conception des invites, la configuration des outils et l'exécution asynchrone en arrière-plan.

Au-delà de l'ouverture de ces versions spécialisées de recherche approfondie d'o3 et d'o4-mini, OpenAI a également amélioré ses modèles de raisonnement traditionnels.o3, o3-proet o4-mini— avec des fonctionnalités de recherche web intégrées. Cette intégration permet aux modèles d'effectuer des recherches en temps réel, de récupérer des informations actualisées et de synthétiser les résultats directement en un seul appel. Le nouveau service de « recherche web raisonnée » est disponible à partir de 10 $ pour 1,000 XNUMX appels, reflétant le calcul premium et l'orchestration des API requis ; simultanément, OpenAI a réduit le coût de la recherche Web sur ses modèles multimodaux phares (GPT-4o et GPT-4.1) à 25 $ pour 1,000 XNUMX appels .

Pour rationaliser les tâches de recherche de longue durée, l'API prend désormais en charge webhooksLes développeurs peuvent enregistrer des points de terminaison de rappel pour recevoir des notifications automatiques à la fin d'une tâche de recherche approfondie, éliminant ainsi le besoin d'interrogation ou de vérification manuelle de l'état. Ce mécanisme de webhook est particulièrement recommandé pour les workflows exécutés de manière asynchrone, comme les analyses de marché ou les revues de politiques sur plusieurs heures, garantissant ainsi la fiabilité et l'efficacité de l'utilisation des ressources dans les systèmes de production.

L'accès à l'API Deep Research est simple. Après avoir installé le dernier SDK OpenAI et s'être authentifié avec votre clé API, les développeurs n'ont qu'à spécifier l'un des deux nouveaux noms de modèle Deep Research dans leur requête de complétion de chat. En activant les outils comme web_search_preview et code_interpreter et régler le background Si vous définissez l'option sur true, le modèle décompose de manière autonome les requêtes de haut niveau en sous-questions, émet des recherches, exécute des analyses et renvoie un rapport structuré et riche en citations, complet avec des métadonnées en ligne et des URL sources.

Ce lancement représente une évolution significative de la feuille de route produit d'OpenAI. Plus tôt cette année, en février 2025, l'agent Deep Research a fait ses débuts dans ChatGPT en tant que fonctionnalité « nouvelle génération » – optimisée par une variante optimisée d'o3 – pour des tâches qui, auparavant, auraient demandé des dizaines d'heures aux analystes humains. Il combinait navigation, utilisation d'outils Python et raisonnement itératif pour produire des résultats complets et vérifiables en moins d'une demi-heure. Grâce à la sortie de l'API, les entreprises comme les startups peuvent intégrer cette puissance d'analyse à leurs propres applications, pour des cas d'utilisation allant de la veille concurrentielle et des analyses documentaires à la due diligence technique, et au-delà.

De plus, le déploiement à plus grande échelle de la recherche web dans les modèles o3, o3-pro et o4-mini brouille la frontière entre connaissances statiques et recherche d'informations en temps réel. Les développeurs peuvent désormais créer des invites demandant au modèle de « trouver les derniers résultats trimestriels » ou de « résumer les évolutions réglementaires actuelles en matière de confidentialité des données dans l'UE ». Le modèle récupère, interprète et cite de manière autonome les sources pertinentes, le tout au sein d'une seule transaction API. Cette approche unifiée contraste avec les modèles précédents, qui nécessitaient des pipelines distincts de recherche puis de synthèse, réduisant ainsi la complexité et la latence de l'intégration.

D'un point de vue commercial, les ajustements tarifaires accompagnant ces fonctionnalités reflètent la volonté d'OpenAI de démocratiser le raisonnement avancé tout en maîtrisant les coûts d'infrastructure. Le tarif de 10 $/1 25 appel pour la recherche web basée sur le raisonnement positionne le service de manière compétitive par rapport aux fournisseurs de pipelines de données spécialisés, tandis que le tarif réduit de 1 $/4 4.1 appel pour la recherche web GPT-XNUMXo/XNUMX souligne l'engagement d'OpenAI à rendre l'IA dynamique, optimisée par des outils, accessible à grande échelle.

À l'avenir, OpenAI a annoncé un investissement continu dans l'écosystème de recherche approfondie : mises à jour des modèles, prise en charge étendue des outils (notamment des connecteurs directs aux bases de données et des intégrations de documents privés via MCP) et fonctionnalités d'analyse multimodale plus approfondies sont au programme. À mesure que ces capacités mûriront, la frontière entre l'IA comme partenaire conversationnel et l'IA comme assistant de recherche autonome continuera de s'estomper, annonçant une nouvelle ère d'applications agentiques capables d'enquêter, de raisonner et de fournir des informations exploitables avec une intervention humaine minimale.

Pour commencer

CometAPI fournit une interface REST unifiée qui regroupe des centaines de modèles d'IA sous un point de terminaison cohérent, avec gestion intégrée des clés API, des quotas d'utilisation et des tableaux de bord de facturation. Plus besoin de jongler avec plusieurs URL et identifiants de fournisseurs.

Les développeurs peuvent accéder API o3-Pro(modèle: o3-pro; o3-pro-2025-06-10), API O3 (modèle:o3;o3-2025-04-16 )et API O4-Mini(modèle: o4-mini;o4-mini-2025-04-16) À travers API CometLes derniers modèles listés sont ceux en vigueur à la date de publication de l'article. Pour commencer, explorez les fonctionnalités du modèle dans la section cour de récréation et consultez le Guide de l'API Pour des instructions détaillées, veuillez vous connecter à CometAPI et obtenir la clé API avant d'y accéder. API Comet proposer un prix bien inférieur au prix officiel pour vous aider à vous intégrer.

La dernière intégration o3-deep-research(modèle :

o3-deep-research-2025-06-26) et o4-mini-deep-research (modèle : o4-mini-deep-research-2025-06-26) apparaîtra bientôt sur CometAPI, alors restez à l'écoute ! Pendant que nous finalisons le téléchargement du modèle Gemini 2.5 Flash‑Lite, explorez nos autres modèles sur la page Modèles ou essayez-les dans l'IA Playground.