La dernière avancée d'Alibaba en matière d'intelligence artificielle, Qwen3-Coder, marque une étape importante dans le paysage en constante évolution du développement logiciel piloté par l'IA. Dévoilé le 23 juillet 2025, Qwen3-Coder est un modèle de codage agentique open source conçu pour gérer de manière autonome des tâches de programmation complexes, de la génération de code standard au débogage de bases de code complètes. Construit sur une architecture de pointe de type « mélange d'experts » (MoE) et doté de 480 milliards de paramètres, dont 35 milliards activés par jeton, le modèle atteint un équilibre optimal entre performances et efficacité de calcul. Dans cet article, nous explorons ce qui distingue Qwen3-Coder, examinons ses performances de référence, décortiquons ses innovations techniques, guidons les développeurs vers une utilisation optimale et examinons l'accueil du modèle et ses perspectives d'avenir.

Qu'est-ce que Qwen3-Coder ?

Qwen3-Coder est le dernier modèle de codage agentique de la famille Qwen, officiellement annoncé le 22 juillet 2025. Conçu comme le « modèle de code agentique le plus performant à ce jour », sa variante phare, Qwen3-Coder-480B-A35B-Instruct, dispose de 480 milliards de paramètres au total, avec une conception Mixture-of-Experts (MoE) activant 35 milliards de paramètres par jeton. Il prend en charge nativement des fenêtres contextuelles jusqu'à 256 XNUMX jetons et s'adapte à un million de jetons grâce à des techniques d'extrapolation, répondant ainsi à la demande de compréhension et de génération de code à l'échelle du référentiel.

Open source sous Apache 2.0

Fidèle à l'engagement d'Alibaba en faveur d'un développement communautaire, Qwen3-Coder est publié sous licence Apache 2.0. Cette disponibilité open source garantit la transparence, encourage les contributions de tiers et accélère l'adoption dans le monde universitaire et industriel. Les chercheurs et les ingénieurs peuvent accéder à des pondérations pré-entraînées et affiner le modèle pour des domaines spécialisés, de la fintech au calcul scientifique.

Évolution de Qwen2.5

S'appuyant sur le succès de Qwen2.5-Coder, qui proposait des modèles allant de 0.5 milliard à 32 milliards de paramètres et obtenait des résultats SOTA lors des tests de génération de code, Qwen3-Coder étend les capacités de son prédécesseur grâce à une plus grande échelle, des pipelines de données améliorés et de nouveaux régimes d'entraînement. Qwen2.5-Coder a été entraîné sur plus de 5.5 3 milliards de jetons grâce à un nettoyage méticuleux des données et à la génération de données synthétiques ; Qwen7.5-Coder améliore ce résultat en ingérant 70 XNUMX milliards de jetons avec un ratio de code de XNUMX %, en exploitant les modèles antérieurs pour filtrer et réécrire les entrées bruyantes afin d'obtenir une qualité de données supérieure.

Quelles sont les principales innovations qui différencient Qwen3-Coder ?

Plusieurs innovations clés distinguent Qwen3-Coder :

- Orchestration des tâches agentiques: Plutôt que de simplement générer des extraits, Qwen3-Coder peut enchaîner de manière autonome plusieurs opérations (lecture de la documentation, appel d'utilitaires et validation des sorties) sans intervention humaine.

- Budget de réflexion amélioré:Les développeurs peuvent configurer la quantité de calcul consacrée à chaque étape du raisonnement, permettant un compromis personnalisable entre vitesse et minutie, ce qui est crucial pour la synthèse de code à grande échelle.

- Intégration transparente des outils: L'interface de ligne de commande de Qwen3-Coder, « Qwen Code », adapte les protocoles d'appel de fonctions et les invites personnalisées pour s'intégrer aux outils de développement populaires, ce qui facilite son intégration dans les pipelines CI/CD et les IDE existants.

Comment Qwen3-Coder se compare-t-il à ses concurrents ?

Confrontations de référence

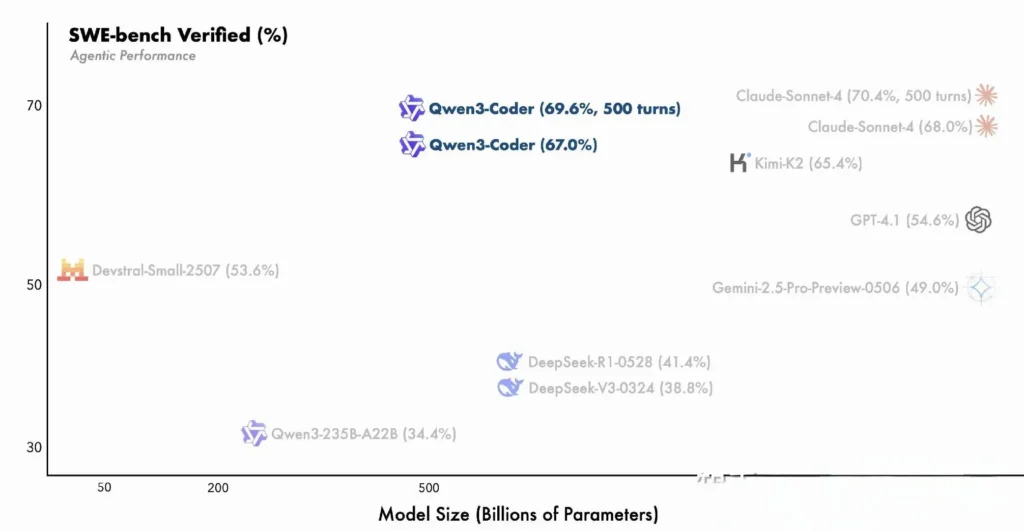

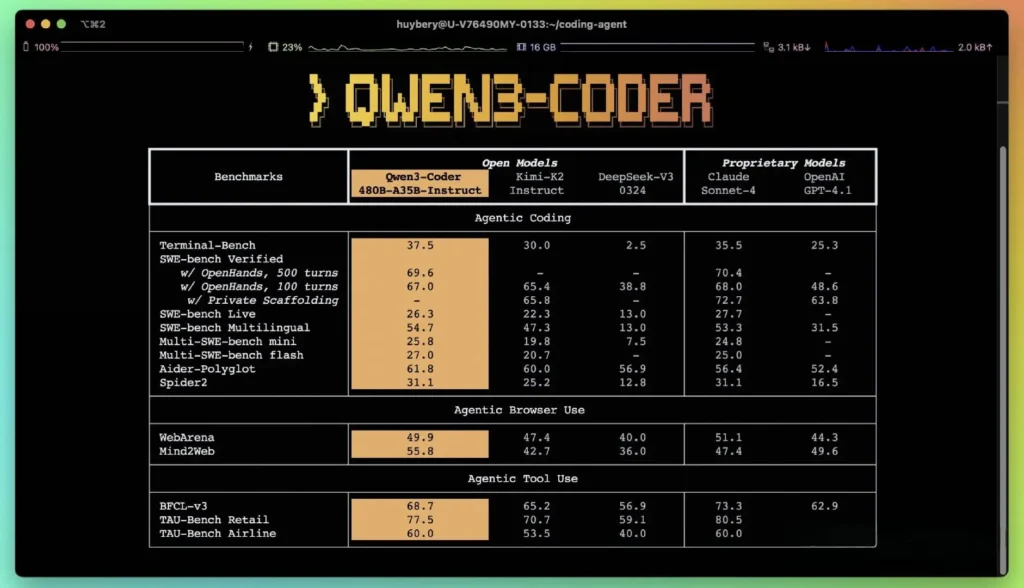

Selon les indicateurs de performance publiés par Alibaba, Qwen3-Coder surpasse les principales alternatives nationales, telles que les modèles de type codex de DeepSeek et K2 de Moonshot AI, et égale ou dépasse les capacités de codage des principales offres américaines, sur plusieurs benchmarks. Selon les évaluations tierces :

- Aider Polyglotte:Qwen3-Coder-480B a obtenu un score de 61.8%, illustrant une génération de code multilingue et un raisonnement puissants.

- MBPP et HumanEval:Des tests indépendants indiquent que Qwen3-Coder-480B-A35B surpasse GPT-4.1 en termes d'exactitude fonctionnelle et de gestion des invites complexes, en particulier dans les défis de codage en plusieurs étapes.

- La variante du paramètre 480B a obtenu plus de 85 % de réussite d'exécution sur le Banc SWE Suite vérifiée, surpassant à la fois le modèle haut de gamme de DeepSeek (78 %) et le K2 de Moonshot (82 %), et correspondant étroitement à Claude Sonnet 4 à 86 %.

Comparaison avec les modèles propriétaires

Alibaba affirme que les capacités agentiques de Qwen3-Coder s'alignent sur celles de Claude d'Anthropic et de GPT-4 d'OpenAI pour les workflows de codage de bout en bout, une performance remarquable pour un modèle open source. Les premiers testeurs signalent que sa planification multi-tours, son appel dynamique d'outils et sa correction automatique des erreurs permettent de gérer des tâches complexes, telles que la création d'applications web full-stack ou l'intégration de pipelines CI/CD, avec un minimum d'intervention humaine. Ces capacités sont renforcées par la capacité du modèle à s'auto-valider par l'exécution de code, une fonctionnalité moins prononcée dans les LLM purement génératifs.

Quelles sont les innovations techniques derrière Qwen3-Coder ?

Architecture de mélange d'experts (MoE)

Au cœur de Qwen3-Coder se trouve une conception MoE de pointe. Contrairement aux modèles denses qui activent tous les paramètres pour chaque jeton, les architectures MoE mobilisent sélectivement des sous-réseaux spécialisés (experts) adaptés à des types de jetons ou à des tâches spécifiques. Dans Qwen3-Coder, 480 milliards de paramètres sont répartis entre plusieurs experts, avec seulement 35 milliards de paramètres actifs par jeton. Cette approche réduit les coûts d'inférence de plus de 60 % par rapport aux modèles denses équivalents, tout en préservant une haute fidélité dans la synthèse et le débogage du code.

Mode de pensée et mode de non-pensée

S'inspirant des innovations de la famille Qwen3, Qwen3-Coder intègre un inférence bimode cadre:

- Mode de réflexion alloue un « budget de réflexion » plus important aux tâches de raisonnement complexes en plusieurs étapes, telles que la conception d’algorithmes ou la refactorisation inter-fichiers.

- Mode non-pensée fournit des réponses rapides et contextuelles adaptées aux complétions de code simples et aux extraits d'utilisation d'API.

Ce changement de mode unifié élimine le besoin de jongler avec des modèles distincts pour les tâches optimisées pour le chat et pour le raisonnement, simplifiant ainsi les flux de travail des développeurs.

Apprentissage par renforcement avec synthèse automatisée de cas de test

L'innovation majeure de Qwen3-Coder réside dans sa fenêtre contextuelle native de 256 XNUMX jetons (soit deux fois la capacité habituelle des principaux modèles ouverts) et dans sa prise en charge d'un million de jetons via des méthodes d'extrapolation (par exemple, YaRN). Cela permet au modèle de traiter des référentiels entiers, des ensembles de documentation ou des projets multifichiers en une seule passe, préservant ainsi les dépendances entre fichiers et réduisant les invites répétitives. Des tests empiriques montrent que l'extension de la fenêtre contextuelle produit des gains décroissants, mais néanmoins significatifs, en termes de performances des tâches à long terme, notamment dans les scénarios d'apprentissage par renforcement piloté par l'environnement.

Comment les développeurs peuvent-ils accéder à Qwen3-Coder et l’utiliser ?

La stratégie de publication de Qwen3-Coder met l'accent sur l'ouverture et la facilité d'adoption :

- Pondérations des modèles open source:Tous les points de contrôle du modèle sont disponibles sur GitHub sous Apache 2.0, permettant une transparence totale et des améliorations pilotées par la communauté.

- Interface de ligne de commande (code Qwen):Issu de Google Gemini Code, l'interface de ligne de commande prend en charge les invites personnalisées, les appels de fonctions et les architectures de plug-ins pour s'intégrer de manière transparente aux systèmes de construction et aux IDE existants.

- Déploiements dans le cloud et sur site:Les images Docker préconfigurées et les graphiques Kubernetes Helm facilitent les déploiements évolutifs dans les environnements cloud, tandis que les recettes de quantification locales (quantification dynamique 2 à 8 bits) permettent une inférence sur site efficace, même sur les GPU standard.

- Accès API via CometAPI:Les développeurs peuvent également interagir avec Qwen3-Coder via des points de terminaison hébergés sur des plateformes telles que API Comet, qui proposent l'Open source(

qwen3-coder-480b-a35b-instruct) et versions commerciales(qwen3-coder-plus; qwen3-coder-plus-2025-07-22)au même prix.La version commerciale mesure 1M de long. - Étreindre le visage:Alibaba a rendu les poids Qwen3-Coder et les bibliothèques qui les accompagnent disponibles gratuitement sur Hugging Face et GitHub, conditionnés sous une licence Apache 2.0 qui autorise une utilisation académique et commerciale sans redevances.

Intégration API et SDK via CometAPI

CometAPI est une plateforme d'API unifiée qui regroupe plus de 500 modèles d'IA provenant de fournisseurs leaders, tels que la série GPT d'OpenAI, Gemini de Google, Claude d'Anthropic, Midjourney, Suno, etc., au sein d'une interface unique et conviviale pour les développeurs. En offrant une authentification, un formatage des requêtes et une gestion des réponses cohérents, CometAPI simplifie considérablement l'intégration des fonctionnalités d'IA dans vos applications. Que vous développiez des chatbots, des générateurs d'images, des compositeurs de musique ou des pipelines d'analyse pilotés par les données, CometAPI vous permet d'itérer plus rapidement, de maîtriser les coûts et de rester indépendant des fournisseurs, tout en exploitant les dernières avancées de l'écosystème de l'IA.

Les développeurs peuvent interagir avec Qwen3-Coder via une API de style OpenAI compatible, disponible via CometAPI. API Comet, qui proposent l'Open source(qwen3-coder-480b-a35b-instruct) et versions commerciales(qwen3-coder-plus; qwen3-coder-plus-2025-07-22) au même prix. La version commerciale fait 1 Mo. Exemple de code pour Python (utilisant le client compatible OpenAI) avec les meilleures pratiques recommandant des paramètres d'échantillonnage de température = 0.7, top_p = 0.8, top_k = 20 et une pénalité de répétition = 1.05. La longueur de sortie peut atteindre 65,536 XNUMX jetons, ce qui la rend adaptée aux tâches de génération de code volumineuses.

Pour commencer, explorez les capacités des modèles dans le cour de récréation et consultez le Guide de l'API Pour des instructions détaillées, veuillez vous connecter à CometAPI et obtenir la clé API avant d'y accéder.

Démarrage rapide sur Hugging Face et Alibaba Cloud

Les développeurs désireux d'expérimenter avec Qwen3-Coder peuvent trouver le modèle sur Hugging Face sous le référentiel Qwen/Qwen3-Coder-480B-A35B-InstructL'intégration est simplifiée via le transformers bibliothèque (version ≥ 4.51.0 à éviter KeyError: 'qwen3_moe') et clients Python compatibles OpenAI. Un exemple minimal :

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-480B-A35B-Instruct")

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-480B-A35B-Instruct")

input_ids = tokenizer("def fibonacci(n):", return_tensors="pt").input_ids

output = model.generate(input_ids, max_length=200, temperature=0.7, top_p=0.8, top_k=20, repetition_penalty=1.05)

print(tokenizer.decode(output))

Définition d'outils personnalisés et de flux de travail agentiques

L'une des fonctionnalités remarquables de Qwen3-Coder est invocation d'outil dynamiqueLes développeurs peuvent enregistrer des utilitaires externes (linters, formateurs, exécuteurs de tests) et permettre au modèle de les appeler de manière autonome pendant une session de codage. Cette fonctionnalité transforme Qwen3-Coder d'un assistant de code passif en un agent de codage actif, capable d'exécuter des tests, d'ajuster le style de code et même de déployer des microservices en fonction des intentions conversationnelles.

Quelles applications potentielles et orientations futures sont permises par Qwen3-Coder ?

En alliant la liberté de l'open source à des performances de niveau entreprise, Qwen3-Coder ouvre la voie à une nouvelle génération d'outils de développement pilotés par l'IA. Des audits de code automatisés et des contrôles de conformité de sécurité aux services de refactoring continu et aux assistants Dev-Ops optimisés par l'IA, la polyvalence du modèle inspire déjà les startups et les équipes d'innovation internes.

Flux de travail de développement logiciel

Les premiers utilisateurs constatent une réduction de 30 à 50 % du temps consacré au codage standard, à la gestion des dépendances et à l'échafaudage initial, permettant ainsi aux ingénieurs de se concentrer sur les tâches de conception et d'architecture à forte valeur ajoutée. Les suites d'intégration continue peuvent exploiter Qwen3-Coder pour générer automatiquement des tests, détecter les régressions et même suggérer des optimisations de performances basées sur l'analyse du code en temps réel.

Les entreprises jouent

À mesure que les entreprises des secteurs de la finance, de la santé et du e-commerce intègrent Qwen3-Coder à leurs systèmes critiques, les boucles de rétroaction entre les équipes d'utilisateurs et la R&D d'Alibaba accéléreront les améliorations, telles que le réglage spécifique au domaine, l'amélioration des protocoles de sécurité et le renforcement des plugins IDE. De plus, la stratégie open source d'Alibaba encourage les contributions de la communauté mondiale, favorisant ainsi un écosystème dynamique d'extensions, de benchmarks et de bibliothèques de bonnes pratiques.

Conclusion

En résumé, Qwen3-Coder représente une avancée majeure dans l'IA open source pour l'ingénierie logicielle : un modèle puissant et agentique qui non seulement écrit du code, mais orchestre également des pipelines de développement complets avec une surveillance humaine minimale. En rendant cette technologie librement disponible et facile à intégrer, Alibaba démocratise l'accès aux outils d'IA avancés et ouvre la voie à une ère où la création logicielle deviendra de plus en plus collaborative, efficace et intelligente.

FAQ

Qu'est-ce qui rend Qwen3-Coder « agentique » ?

L'IA agentique désigne des modèles capables de planifier et d'exécuter des tâches en plusieurs étapes de manière autonome. La capacité de Qwen3-Coder à invoquer des outils externes, à exécuter des tests et à gérer des bases de code sans intervention humaine illustre ce paradigme.

Qwen3-Coder est-il adapté à une utilisation en production ?

Bien que Qwen3-Coder affiche de solides performances lors des tests de référence et des tests en conditions réelles, les entreprises doivent effectuer des évaluations spécifiques au domaine et mettre en œuvre des garde-fous (par exemple, des pipelines de vérification de sortie) avant de l'intégrer dans les flux de production critiques.

Comment l’architecture Mixture-of-Experts profite-t-elle aux développeurs ?

MoE réduit les coûts d'inférence en activant uniquement les sous-réseaux pertinents par jeton, ce qui permet une génération plus rapide et des coûts de calcul réduits. Cette efficacité est essentielle pour la mise à l'échelle des assistants de codage IA dans les environnements cloud.