Qu'est-ce que Llama 4 ?

Meta Platforms a dévoilé sa nouvelle suite de grands modèles de langage (LLM) : la série Llama 4, marquant une avancée significative dans le domaine de l'intelligence artificielle. La collection Llama 4 introduit deux modèles principaux en avril 2025 : Llama 4 Scout et Llama 4 Maverick. Ces modèles sont conçus pour traiter et traduire divers formats de données, notamment du texte, de la vidéo, des images et de l'audio, mettant en avant leurs capacités multimodales. Meta a également présenté en avant-première Llama 4 Behemoth, un modèle à venir présenté comme l'un des LLM les plus puissants à ce jour, destiné à faciliter l'entraînement des futurs modèles.

En quoi Llama 4 diffère-t-il des modèles précédents ?

Capacités multimodales améliorées

Contrairement à ses prédécesseurs, Llama 4 est conçu pour gérer de multiples modalités de données de manière fluide. Il peut ainsi analyser et générer des réponses à partir de textes, d'images, de vidéos et d'entrées audio, ce qui le rend hautement adaptable à diverses applications.

Introduction de modèles spécialisés

Meta a introduit deux versions spécialisées au sein de la série Llama 4 :

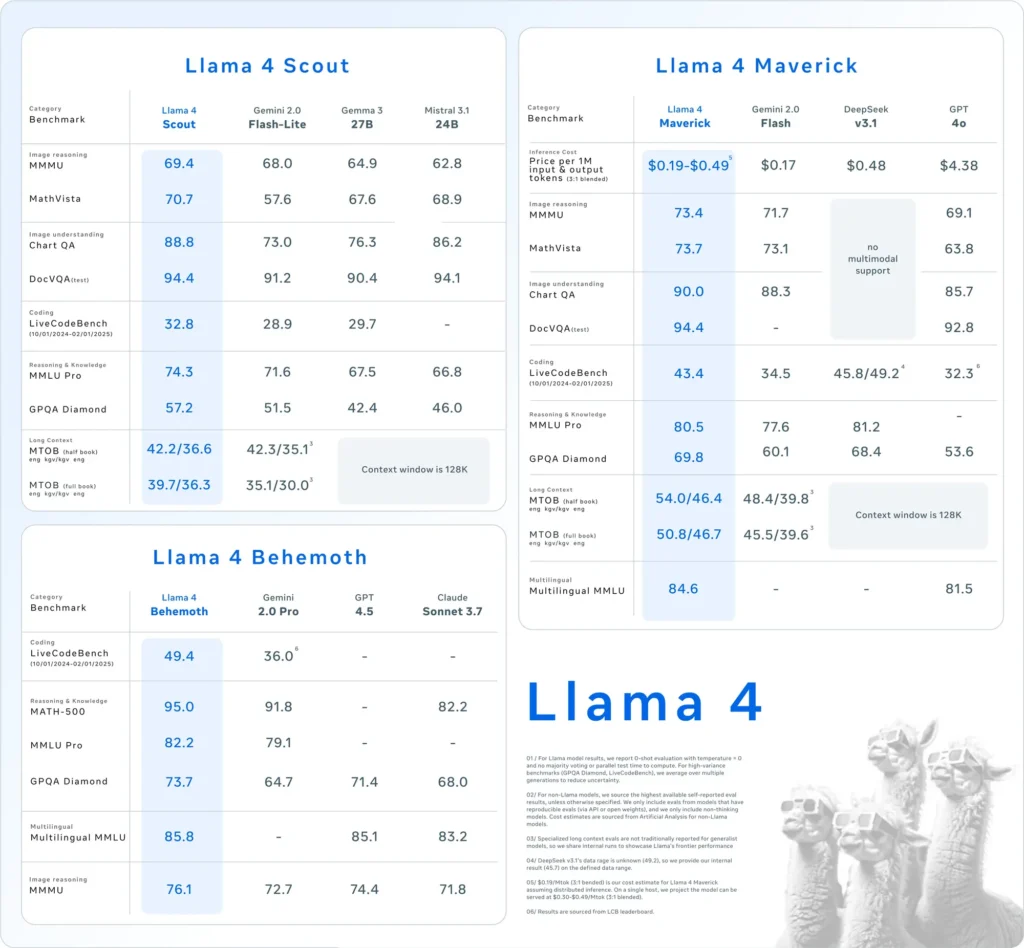

- Llama 4 Scout:Un modèle compact optimisé pour fonctionner efficacement sur un seul GPU Nvidia H100. Il dispose d'une fenêtre contextuelle de 10 millions de jetons et a démontré des performances supérieures à celles de concurrents comme Gemma 3 et Mistral 3.1 de Google lors de divers benchmarks.

- Llama 4 Maverick:Un modèle plus grand comparable en performances à GPT-4o et DeepSeek-V3 d'OpenAI, excellant particulièrement dans les tâches de codage et de raisonnement tout en utilisant moins de paramètres actifs.

De plus, Meta développe Llama 4 Behemoth, un modèle avec 288 milliards de paramètres actifs et un total de 2 4.5 milliards, visant à surpasser des modèles comme GPT-3.7 et Claude Sonnet XNUMX sur les benchmarks STEM.

Adoption de l'architecture de mélange d'experts (MoE)

Llama 4 utilise une architecture de « mélange d'experts » (MoE), divisant le modèle en unités spécialisées afin d'optimiser l'utilisation des ressources et d'améliorer les performances. Cette approche permet un traitement plus efficace en activant uniquement les sous-ensembles pertinents du modèle pour des tâches spécifiques.

Comment Llama 4 se compare-t-il aux autres modèles d’IA ?

Llama 4 se positionne de manière compétitive parmi les principaux modèles d'IA :

- Benchmarks de Performance:Les performances de Llama 4 Maverick sont comparables à celles de GPT-4o et DeepSeek-V3 d'OpenAI dans les tâches de codage et de raisonnement, tandis que Llama 4 Scout surpasse des modèles comme Gemma 3 et Mistral 3.1 de Google dans divers benchmarks.

- Approche open sourceMeta continue de proposer les modèles Llama en open source, favorisant ainsi une collaboration et une intégration plus larges entre les plateformes. Cependant, la licence Llama 4 impose des restrictions aux entités commerciales comptant plus de 700 millions d'utilisateurs, suscitant des discussions sur la véritable ouverture du modèle.

| Catégorie | référence | Llama 4 Maverick | GPT-4o | Gémeaux 2.0 Flash | DeepSeek v3.1 |

|---|---|---|---|---|---|

| Raisonnement par l'image | MMMU | 73.4 | 69.1 | 71.7 | Pas de support multimodal |

| MathVista | 73.7 | 63.8 | 73.1 | Pas de support multimodal | |

| Compréhension des images | GraphiqueQA | 90.0 | 85.7 | 88.3 | Pas de support multimodal |

| DocVQA (test) | 94.4 | 92.8 | - | Pas de support multimodal | |

| Codage | LiveCodeBench | 43.4 | 32.3 | 34.5 | 45.8/49.2 |

| Raisonnement et connaissance | MMLU Pro | 80.5 | - | 77.6 | 81.2 |

| GPQA Diamant | 69.8 | 53.6 | 60.1 | 68.4 | |

| Multilingues | MMLU multilingue | 84.6 | 81.5 | - | - |

| Contexte long | MTOB (demi-livre) eng→kgv/kgv→eng | 54.0/46.4 | Contexte limité à 128 K | 48.4/39.8 | Contexte limité à 128 K |

| MTOB (livre complet) eng→kgv/kgv→eng | 50.8/46.7 | Contexte limité à 128 K | 45.5/39.6 | Contexte limité à 128 K |

Comment Llama 4 se comporte-t-il dans les tests de référence ?

Les évaluations comparatives fournissent des informations sur les performances des modèles Llama 4 :

- Llama 4 ScoutCe modèle surpasse plusieurs concurrents, dont les Gemma 3 et Mistral 3.1 de Google, sur divers benchmarks. Sa capacité à fonctionner avec une fenêtre contextuelle de 10 millions de jetons sur un seul GPU souligne son efficacité et son efficience dans la gestion de tâches complexes.

- Llama 4 MaverickComparable en performances à celles de GPT-4o et DeepSeek-V3 d'OpenAI, Llama 4 Maverick excelle dans les tâches de codage et de raisonnement tout en utilisant moins de paramètres actifs. Cette efficacité ne se fait pas au détriment des capacités, ce qui en fait un concurrent sérieux dans le paysage des LLM.

- Llama 4 BehemothAvec 288 milliards de paramètres actifs et un total de 2 4 milliards, Llama 4.5 Behemoth surpasse des modèles comme GPT-3.7 et Claude Sonnet XNUMX dans les benchmarks STEM. Son nombre important de paramètres et ses performances témoignent de son potentiel comme modèle fondamental pour les futurs développements de l'IA.

Ces résultats de référence soulignent l'engagement de Meta à faire progresser les capacités de l'IA et à positionner la série Llama 4 comme un acteur formidable dans le domaine.

Comment les utilisateurs peuvent-ils accéder à Llama 4 ?

Meta a intégré les modèles Llama 4 à son assistant IA, les rendant ainsi accessibles sur des plateformes telles que WhatsApp, Messenger, Instagram et le web. Cette intégration permet aux utilisateurs de profiter des fonctionnalités améliorées de Llama 4 dans des applications familières.

Pour les développeurs et chercheurs souhaitant exploiter Llama 4 pour des applications personnalisées, Meta donne accès aux pondérations des modèles via des plateformes comme Hugging Face et ses propres canaux de distribution. Cette approche open source permet à la communauté de l'IA d'innover et de développer les capacités de Llama 4.

Il est important de noter que, bien que Llama 4 soit commercialisé comme open source, la licence impose des restrictions aux entités commerciales comptant plus de 700 millions d'utilisateurs. Les organisations doivent consulter les conditions de licence pour s'assurer de leur conformité avec les directives de Meta.

Créez rapidement avec Llama 4 sur CometAPI

CometAPI donne accès à plus de 500 modèles d'IA, dont des modèles open source et multimodaux spécialisés pour le chat, les images, le code, etc. Son principal atout réside dans la simplification du processus traditionnellement complexe d'intégration de l'IA. En centralisant l'agrégation des API sur une seule plateforme, les utilisateurs gagnent un temps précieux et des ressources qui seraient autrement consacrées à la gestion de plateformes et de fournisseurs distincts. Grâce à elle, l'accès aux principaux outils d'IA tels que Claude, OpenAI, Deepseek et Gemini est disponible via un abonnement unique et unifié. Vous pouvez utiliser l'API de CometAPI pour créer de la musique et des illustrations, générer des vidéos et créer vos propres workflows.

API Comet proposer un prix bien inférieur au prix officiel pour vous aider à intégrer API de Lama 4, et recevez 1 $ sur votre compte après votre inscription et votre connexion ! Bienvenue pour découvrir CometAPI. CometAPI vous propose un paiement à l'utilisation.API de Lama 4 Dans CometAPI, la tarification est structurée comme suit :

| Catégorie | lama-4-maverick | lama-4-scout |

| Tarification des API | Jetons d'entrée : 0.48 $/M jetons | Jetons d'entrée : 0.216 $/M jetons |

| Jetons de sortie : 1.44 $/M jetons | Jetons de sortie : 1.152 $/M jetons |

- S'il vous plaît se référer à API de Lama 4 pour les détails d'intégration.

- Pour les informations sur le modèle lancé dans l'API Comet, veuillez consulter https://api.cometapi.com/new-model.

- Pour obtenir des informations sur le prix des modèles dans l'API Comet, veuillez consulter https://api.cometapi.com/pricing

Commencez à construire sur CometAPI aujourd'hui – inscrivez-vous ici pour un accès gratuit ou une mise à l'échelle sans limite de débit en passant à un Forfait payant CometAPI.

Quelles sont les implications de la sortie de Llama 4 ?

Intégration entre les méta-plateformes

Llama 4 est intégré à l'assistant IA de Meta sur des plateformes telles que WhatsApp, Messenger, Instagram et le Web, améliorant ainsi l'expérience utilisateur grâce à des capacités d'IA avancées.

Impact sur l'industrie de l'IA

La sortie de Llama 4 souligne la volonté de Meta de se lancer dans l'IA, avec un projet d'investissement pouvant atteindre 65 milliards de dollars pour développer son infrastructure. Cette initiative reflète la concurrence croissante entre les géants de la technologie pour dominer l'innovation en IA.

Considérations sur la consommation d'énergie

Les importantes ressources de calcul requises par Llama 4 suscitent des inquiétudes quant à la consommation d'énergie et à la durabilité. L'exploitation d'un cluster de plus de 100,000 XNUMX GPU requiert une énergie considérable, suscitant des discussions sur l'impact environnemental des modèles d'IA à grande échelle.

Quel avenir pour Llama 4 ?

Meta prévoit de discuter des développements et des applications futurs de Llama 4 lors de la prochaine conférence LlamaCon le 29 avril 2025. La communauté de l'IA anticipe des informations sur les stratégies de Meta pour relever les défis actuels et exploiter les capacités de Llama 4 dans divers secteurs.

En résumé, Llama 4 représente une avancée significative dans les modèles de langage de l'IA, offrant des capacités multimodales améliorées et des architectures spécialisées. Malgré des défis de développement, les investissements substantiels et les initiatives stratégiques de Meta positionnent Llama 4 comme un concurrent redoutable dans un paysage de l'IA en constante évolution.