L'IA de retouche d'image est passée du statut de jouet ludique à celui d'outil de workflow en quelques mois, et non en quelques années. Si vous devez supprimer des arrière-plans, permuter des visages, conserver un personnage sur plusieurs plans ou réaliser une composition en plusieurs étapes avec des instructions en langage naturel, plusieurs nouveaux modèles promettent une exécution plus rapide et avec moins de corrections manuelles. Dans cet article, je compare trois des outils dont tout le monde parle actuellement : Image GPT-1 d'OpenAI, Qwen-Image Edit, le viral Nano Banane modèles (Gemini-2.5-Flash-Image), et Flux KontextJe vais passer en revue les points forts de chacun, leurs points faibles et donner une recommandation pratique en fonction de ce que vous souhaitez accomplir.

Quelles sont les principales capacités qui définissent l’excellence en matière d’IA d’image ?

Le « meilleur » dépend de vos besoins. Mon évaluation repose sur sept critères pratiques. Avant d'analyser chaque modèle, il est essentiel de comprendre les capacités fondamentales qui définissent l'excellence en matière d'IA de génération et de retouche d'images. Celles-ci peuvent être classées en trois grandes catégories :

- Qualité et fidélité des générations : Il s'agit de la capacité de l'IA à produire des images très réalistes, esthétiques et cohérentes à partir d'invites textuelles. Les facteurs pris en compte incluent les détails, l'éclairage, la composition et l'absence d'artefacts ou de distorsions.

- Polyvalence et précision de l'édition : Au-delà de la génération initiale, une IA performante doit offrir des fonctionnalités d'édition performantes. Celles-ci incluent l'inpainting (remplissage des parties manquantes), l'outpainting (extension des images), la suppression/ajout d'objets, le transfert de style et le contrôle précis d'éléments spécifiques.

- Rapidité et efficacité : Pour les flux de travail professionnels, le temps nécessaire à la génération ou à la retouche des images est primordial. Un traitement plus rapide sans compromis sur la qualité constitue un avantage considérable.

- Expérience utilisateur et accessibilité : Une interface intuitive, des contrôles clairs et une facilité d’intégration dans les flux de travail existants sont essentiels pour une adoption généralisée et la satisfaction des utilisateurs.

- Considérations éthiques et caractéristiques de sécurité : À mesure que l'IA gagne en puissance, un développement et un déploiement responsables sont essentiels. Cela inclut des mesures de protection contre la création de contenus préjudiciables ou biaisés.

- Modèles de rentabilité et de tarification : Bien que certains outils proposent des niveaux gratuits, il est essentiel pour les utilisateurs soucieux de leur budget de comprendre la structure tarifaire des fonctionnalités avancées et de l'utilisation commerciale.

- Modifications cohérentes en plusieurs étapes — préserver l’identité/les objets à travers plusieurs modifications ou images.

Je penche pour le côté pratique : un modèle qui produit des images légèrement moins impressionnantes mais qui vous permet d’obtenir des modifications reproductibles, rapides et fiables battra un modèle tape-à-l’œil qui nécessite beaucoup de nettoyage.

Quels sont les modèles envisagés et qu’est-ce qui les différencie ?

Aperçu rapide du modèle

- gpt-image-1 (OpenAI) — un modèle nativement multimodal publié sur l'API en avril 2025 qui prend directement en charge la génération et l'édition d'images itératives au sein de la même API Réponses/Images multimodales.

- Image Flash Gemini 2.5 (Google) — annoncé le 26 août 2025 (« nano-banane ») ; conçu pour une génération rapide et à faible latence et une édition riche (fusion multi-images, cohérence des caractères) ; inclut le filigrane SynthID pour la provenance.

- Qwen-Image-Edit (QwenLM / groupe Alibaba) — une version d'édition d'image de Qwen-Image (fondation 20B) mettant l'accent sur les modifications de texte bilingues et précises et l'édition combinée sémantique + apparence.

- FLUX.1 Kontext (variantes de la plateforme Flux / Black Forest Labs / Flux) — famille de modèles (Dev / Pro / Max) axée sur l'édition rapide, locale et contextuelle avec cohérence des caractères et flux de travail itératifs.

Pourquoi ces quatre-là ?

Ils couvrent les points de conception les plus pertinents pour les praticiens en 2025 : intégration multimodale (OpenAI), mise à l'échelle + production + connaissance du monde (Google), édition de précision et recherche ouverte (Qwen) et édition itérative axée sur l'expérience utilisateur (Flux). Chacun présente des compromis différents en termes de coût, de latence et de points forts (rendu de texte, fusion multi-images, édition itérative, préservation des zones inchangées).

GPT-Image-1 (OpenAI) — le poids lourd du développeur

Qu'est-ce que c'est: GPT-Image-1 d'OpenAI est un modèle multimodal natif qui accepte les entrées texte et image et prend en charge la génération et la modification d'images (inpainting, image à image) via l'API Images. Il se positionne comme un modèle de production pour l'intégration entre applications et services. Conçu comme un modèle texte et image natif, il accepte les entrées image et les invites textuelles, et permet des modifications avec un contrôle précis.

Quels sont les points forts de GPT-image-1 ?

- Compréhension sémantique exceptionnelle : L'un des principaux atouts de GPT-image-1 réside dans sa capacité à interpréter des textes nuancés et élaborés. Les utilisateurs peuvent décrire des scènes complexes, des ambiances spécifiques et des concepts abstraits avec une précision remarquable, et l'IA produit souvent des images qui reflètent fidèlement ces descriptions.

- Photoréalisme de haute qualité : Lorsqu'on lui demande des images réalistes, GPT-image-1 produit souvent des résultats d'un réalisme saisissant, avec une attention remarquable portée aux textures, à l'éclairage et aux compositions naturelles. Cela en fait un outil formidable pour le rendu photoréaliste et l'art conceptuel.

- Interprétation créative : Au-delà de la simple traduction littérale, GPT-image-1 fait preuve d'une certaine créativité, ajoutant souvent des détails subtils ou des touches de style qui rehaussent l'attrait artistique global de l'image générée. Cela peut être particulièrement utile pour l'idéation et l'exploration de concepts visuels variés.

- Base solide pour l'itération : Sa capacité à générer des concepts initiaux de haute qualité constitue un excellent point de départ pour un perfectionnement ultérieur, soit dans le cadre des capacités d'édition de l'IA (si disponibles), soit via un logiciel de conception graphique traditionnel.

Quelles sont les limites de GPT-image-1 ?

- Contrôle des détails fins : Bien qu'excellente pour les concepts généraux, obtenir un contrôle absolu au pixel près ou manipuler avec précision de très petits éléments peut parfois s'avérer difficile. C'est un obstacle courant pour de nombreuses IA génératives, où le résultat est quelque peu déterministe et basé sur l'invite.

- Disponibilité et intégration : Selon son implémentation spécifique, les fonctionnalités d'édition directe de GPT-image-1 peuvent être moins robustes ou intégrées que celles des plateformes d'édition d'images dédiées. Les utilisateurs peuvent avoir besoin d'exporter et d'utiliser d'autres outils pour une édition post-génération intensive.

- Exigences informatiques : La génération d'images très détaillées avec des invites complexes peut nécessiter beaucoup de calculs, ce qui peut entraîner des temps de traitement plus longs par rapport à des modèles plus spécialisés et plus légers pour des modifications rapides.

Nano Banana (image Flash Google / Gemini 2.5)

Qu'est-ce que c'est: « Nano Banana » est le nom ludique donné à la récente mise à jour d'images Gemini de Google (Gemini 2.5 Flash Image). Ce logiciel se positionne comme un générateur/éditeur d'images nouvelle génération au sein de l'écosystème Gemini de Google, commercialisé pour des retouches multi-étapes plus précises et plus nuancées, ainsi qu'une cohérence supérieure des retouches photographiques.

Où Gemini-2.5-Flash-Image brille-t-il dans le paysage de l'IA visuelle ?

Gemini-2.5-Flash-Image, une version plus récente conçue pour la vitesse et l'efficacité, est le concurrent de Google qui vise un équilibre entre haute qualité de sortie et rapidité de traitement. Son appellation « Flash » fait spécifiquement référence à son architecture optimisée pour des temps de réponse plus rapides, ce qui le rend particulièrement adapté aux applications où la génération et l'édition en temps réel ou quasi réel sont cruciales.

Qu'est-ce qui fait de Gemini-2.5-Flash-Image un concurrent sérieux ?

- Génération ultra-rapide : Comme son nom l'indique, la rapidité est un atout majeur. Gemini-2.5-Flash-Image excelle dans la génération rapide d'images, un atout précieux pour les professionnels créatifs aux délais serrés ou pour les applications interactives.

- Qualité d'image solide : Malgré sa rapidité, le modèle ne compromet pas significativement la qualité de l'image. Il produit des images cohérentes et visuellement attrayantes, généralement exemptes d'artefacts majeurs, ce qui le rend compétitif face à des modèles plus lents et plus gourmands en ressources dans de nombreux cas d'utilisation.

- Compréhension multimodale : S'appuyant sur le cadre plus large de Gemini, il bénéficie souvent d'une compréhension multimodale avancée, ce qui signifie qu'il peut potentiellement interpréter non seulement du texte, mais également d'autres formes d'entrée pour guider la génération et l'édition d'images, bien que cela varie selon l'API spécifique.

- Capacités d'édition intégrées : Gemini-2.5-Flash-Image est généralement livré avec des fonctionnalités d'édition intégrées telles que l'inpainting (remplissage des parties manquantes d'une image), l'outpainting (extension d'une image au-delà de ses bordures d'origine) et la manipulation d'objets, ce qui en fait une solution plus complète pour les flux de travail d'image de bout en bout.

Quels sont les domaines d’amélioration pour Gemini-2.5-Flash-Image ?

- Photoréalisme de pointe : Bien que performant, il n'atteint pas toujours le summum du photoréalisme observé sur certains modèles plus lents et plus grands, pour des scènes très complexes et nuancées. Un léger compromis peut être nécessaire entre vitesse et fidélité ultime.

- Nuance artistique pour styles complexes : Pour des styles artistiques très spécifiques ou des demandes extrêmement abstraites, certains utilisateurs pourraient trouver qu'il est légèrement moins capable de capturer les nuances artistiques les plus subtiles par rapport aux modèles formés sur de vastes ensembles de données historiques sur l'art.

- Contrôle du texte généré (dans les images) : Comme de nombreux modèles génératifs, générer un texte parfaitement cohérent et correctement orthographié dans une image peut encore être un défi.

Qu'est-ce que Qwen-Image-Edit ?

Qu'est-ce que c'est: Qwen-Image-Edit (Alibaba / équipe Qwen) — modèle d'édition d'image construit sur la famille Qwen-Image ; revendique une édition de texte bilingue puissante (chinois et anglais), un contrôle sémantique et d'apparence et une fidélité d'édition d'image directe.

Quelles sont les forces uniques de Qwen-Image Edit ?

- Précision d'édition supérieure : Qwen-Image Edit intègre souvent des algorithmes avancés d'inpainting, de surpainting et de manipulation d'objets, permettant des modifications ultra-précises et fluides. Il excelle à maintenir la cohérence visuelle, même en cas de modifications importantes.

- Édition contextuelle : L'un de ses principaux atouts réside dans sa prise en compte du contexte. Par exemple, lors de la suppression d'un objet, le contenu vide est comblé intelligemment avec un contenu qui s'intègre harmonieusement à l'environnement, rendant la modification quasiment indétectable.

- Transfert de style et harmonisation : Qwen-Image Edit est très efficace pour transférer des styles d'une image à une autre ou harmoniser différents éléments d'une image afin de créer un rendu cohérent. C'est un atout précieux pour les designers travaillant avec des ressources visuelles variées.

- Suppression/ajout d'objet robuste : Sa capacité à ajouter ou supprimer des objets tout en conservant l'éclairage, les ombres et la perspective est très impressionnante, permettant des reconstructions de scènes complexes ou un désencombrement.

- Mise à l'échelle et amélioration de l'image : Inclut souvent des fonctionnalités avancées pour mettre à l'échelle les images sans perte de qualité et améliorer les détails, les couleurs et l'attrait visuel général.

Quelles sont les faiblesses potentielles de Qwen-Image Edit ?

- Objectif de la génération initiale : Bien qu'il puisse générer des images, son principal atout et son optimisation résident souvent dans l'édition. Sa génération initiale de texte en image peut être satisfaisante, mais potentiellement moins créative et photoréaliste que les modèles purement axés sur la génération, selon la version.

- Courbe d'apprentissage pour les fonctionnalités avancées : La précision et la profondeur de ses outils d’édition peuvent nécessiter une courbe d’apprentissage légèrement plus raide pour les utilisateurs peu familiarisés avec les concepts avancés de manipulation d’images.

- Intensité des ressources pour les modifications complexes : Les modifications très complexes et multicouches peuvent néanmoins être exigeantes en termes de calcul, ce qui peut entraîner des temps de traitement plus longs pour les tâches très volumineuses ou complexes.

Quelles innovations Flux Kontext apporte-t-il à l'IA d'image ?

Qu'est-ce que c'est: Kontext de Flux (parfois commercialisé sous le nom de FLUX.1 Kontext) est un outil de retouche et de génération d'images destiné aux designers et aux équipes de marque. Il met l'accent sur édition contextuelle, typographie précise, transferts de style et interface utilisateur/expérience utilisateur précise pour un travail de conception itératif.

Quels sont les points forts de Flux Kontext ?

- Cohésion contextuelle : La principale force de Flux Kontext réside dans sa capacité à comprendre et à maintenir le contexte entre plusieurs générations ou modifications d'images. C'est un atout précieux pour créer des récits visuels cohérents, des designs de personnages ou des gammes de produits où l'harmonie visuelle est essentielle.

- Amélioration de la cohérence des séries : Si vous devez générer une série d'images partageant un style, un caractère ou un environnement commun, Flux Kontext vise à réduire les incohérences qui peuvent affecter d'autres modèles.

- Style adaptatif : Il peut adapter sa production en fonction d'images générées précédemment ou d'un guide de style défini, ce qui conduit à un processus créatif plus rationalisé et moins itératif.

- Spécialisé pour la marque et le récit : Particulièrement bénéfique pour le marketing, l’image de marque et la narration, où une identité visuelle unifiée est cruciale.

- Compréhension rapide dans le contexte : Sa compréhension rapide ne concerne pas seulement l’image actuelle, mais également la manière dont elle s’intègre dans un contexte plus large ou un ensemble d’instructions.

Quelles sont les limites de Flux Kontext ?

- Potentiel de concentration sur une niche : L'accent mis sur le contexte et la cohérence pourrait signifier qu'il n'est pas toujours le leader absolu du photoréalisme brut et autonome ou de la diversité artistique extrême si c'est la seule exigence.

- Points de repère moins documentés publiquement : En tant qu'acteur plus récent ou plus spécialisé, les données de référence publiques complètes peuvent être moins disponibles que pour les modèles plus établis.

- Dépend d'une entrée contextuelle claire : Pour exploiter ses atouts, les utilisateurs doivent fournir des informations contextuelles claires ou définir efficacement le cadre narratif, ce qui peut nécessiter une approche d’incitation différente.

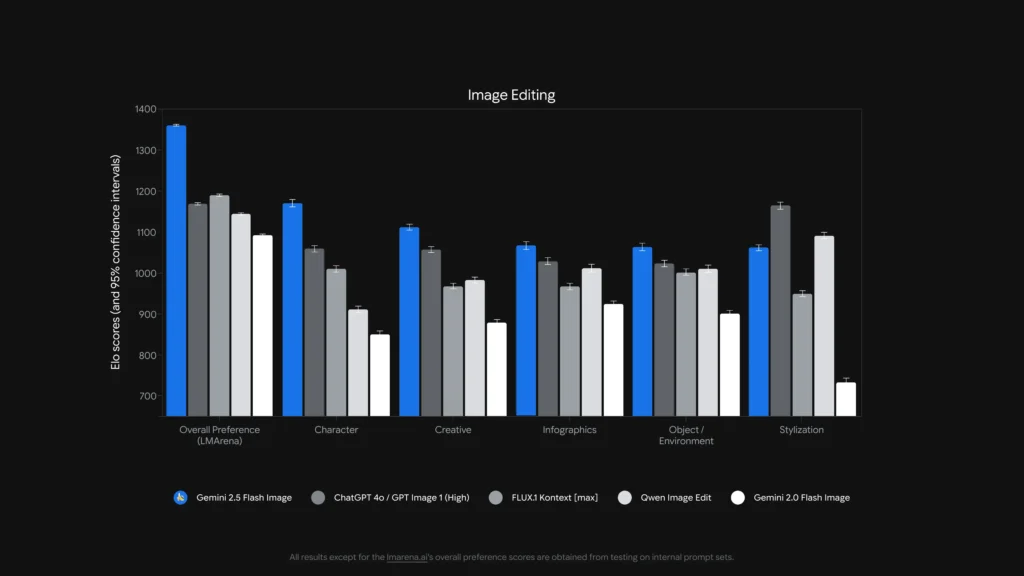

Quel modèle est le meilleur pour l'édition d'images ?

Pour les célibataires, modifications précises sans masque et édition de texte à l'intérieur des images, Qwen-Image-Edit et Image Flash Gemini 2.5 (et des modèles spécialisés comme FLUX.1 Kontext) sont parmi les plus puissants. montages complexes en plusieurs étapes enchaînées, la combinaison d'un front-end LLM riche en instructions (variantes Gemini ou GPT) avec un modèle d'image donne souvent le meilleur résultat — certains travaux de référence ont montré que l'invite de style Chain-of-Thought (Gemini-CoT) améliore le succès de l'édition en plusieurs étapes.

modifications locales, cohérence des caractères, gestion du texte

- Qwen-Image-Edit cible explicitement les deux sémantique et apparence modifications — par exemple, remplacer un objet, faire pivoter, remplacer un texte précis — explicitement construites comme un l'édition d'image Modèle à double voie (contrôle sémantique via Qwen2.5-VL + contrôle d'apparence via l'encodeur VAE). Il présente un bilinguisme robuste (chinois/anglais). modifications de texte dans les images (par exemple, modifier le texte des panneaux, les étiquettes des produits) tout en préservant le style, ce qui est rare et précieux pour les travaux de localisation et d'emballage.

- Image Flash Gemini 2.5 prend en charge les modifications masquées, les modifications locales basées sur des invites (flouter l'arrière-plan, supprimer une personne, changer de pose) et la fusion multi-images. Google propose des modifications sensibles aux régions basées sur des invites, ainsi que des avantages liés à la connaissance du monde (par exemple, une meilleure sémantique des objets du monde réel). Le modèle ajoute également une filigrane SynthID invisible aux images générées/éditées pour aider à la provenance et à la détection.

- FLUX.1 Contexte: se positionne comme un outil de résolution de contexte image à image, optimisé pour des modifications locales précises et contextuelles, ainsi que pour une expérimentation itérative. Les critiques saluent sa capacité à préserver le contexte et la sémantique de la scène lors des modifications locales. FLUX.1 Kontext et Flux Kontext UI sont plébiscités lors de tests pratiques comparatifs pour leurs workflows d'édition itérative et la lisibilité du texte, ce qui en fait un choix judicieux pour les workflows nécessitant de nombreuses itérations rapides (ressources marketing, vignettes).

- GPT-image-1: prend en charge les opérations d'édition (invites texte + image pour les modifications) et les outils d'OpenAI intègrent des modèles d'ingénierie de chaînage et d'invite ; les performances sont solides mais dépendent de l'ingénierie d'invite et peuvent suivre les modèles spécialisés d'édition en premier dans l'édition à granularité fine (par exemple, le remplacement exact du texte bilingue) dans certains tests.

Des repères tels que ComplexBench-Edit et CompBench Il est démontré que de nombreux modèles échouent encore lorsque les modifications sont enchaînées ou interdépendantes, mais que la combinaison d'un LLM pour l'analyse des instructions avec un modèle d'image robuste (orchestration LLM→modèle d'image) ou l'utilisation d'invites CoT peut réduire les échecs. C'est pourquoi certains workflows de production combinent les modèles (par exemple, un LLM de raisonnement et un générateur d'images) pour les modifications complexes.

Qui est le meilleur pour éditer du texte dans des images ?

- Qwen-Image-Edit Conçu spécifiquement pour l'édition de texte bilingue (chinois et anglais), il affiche des résultats supérieurs aux tests d'édition de texte (notes techniques publiques et scores rapportés de Qwen). Les artefacts et démos Qwen open source garantissent une préservation précise des polices, tailles et styles lors des modifications.

- gpt-image-1 et Image Flash Gemini 2.5 les deux font des progrès dans le rendu du texte, mais les repères académiques et les notes des fournisseurs indiquent qu'il reste des défis à relever pour les textes de petite taille/détaillés et les longs passages textuels - les améliorations sont progressives et varient selon l'invite et la résolution.

Analyse comparative : fonctionnalité, édition

Pour donner une image plus claire, consolidons les aspects clés de ces principaux modèles d’IA dans un tableau comparatif.

| Fonctionnalité / Capacité | GPT-image-1 (OpenAI) | Image Flash Gemini 2.5 (Google) | Qwen-Image-Edit (Alibaba) | FLUX.1 Contexte |

|---|---|---|---|---|

| Génération native + édition | Oui. Texte + image multimodal dans une seule API. | Oui — génération native et édition ciblée ; fusion multi-images et cohérence des caractères soulignées. | Concentré sur édition (Qwen-Image-Edit) avec contrôle sémantique + apparence. | Axé sur les modifications image par image et haute fidélité. |

| Profondeur d'édition (ajustements locaux) | Élevé (mais généraliste) | Très élevé (invites ciblées + modifications sans masque) | Très élevé pour les modifications sémantiques/textuelles (prise en charge du texte bilingue). | Très élevé — pipelines d'édition sensibles au contexte. |

| Gestion du texte dans l'image | Bien, cela dépend de la rapidité | Amélioré (le fournisseur montre des démonstrations de modèles et d'édition de panneaux) | Mieux parmi ceux-ci, des modifications de texte lisibles bilingues. | Fort pour préserver le style ; la lisibilité dépend de la rapidité. |

| Cohérence caractère/objet | Bon avec des conseils judicieux | Forte (fonctionnalité explicite) | Moyen (l'accent est mis sur l'édition plutôt que sur l'identité multi-images) | Fort grâce à des flux de travail d'édition itératifs. |

| Latence / débit | Modérée | Faible latence / débit élevé (Modèle Flash) | Varie selon l'hébergement (local/HF vs cloud) | Conçu pour des modifications itératives rapides dans un SaaS hébergé. |

| Provenance / filigrane | Pas de filigrane obligatoire (mécanismes politiques) | Filigrane invisible SynthID pour les images. | Cela dépend de l'hôte | Cela dépend de l'hôte |

Remarques : La « profondeur d'édition » mesure la précision et la fiabilité des modifications locales dans la pratique ; la « gestion du texte » évalue la capacité à placer/modifier du texte lisible à l'intérieur des images.

Qu'en est-il de la latence, de l'ergonomie des développeurs et de l'intégration en entreprise ?

Options de latence et de déploiement

- Image Flash Gemini 2.5 souligne faible latence et est disponible via l'API Gemini, Google AI Studio et Vertex AI, un choix judicieux pour les applications d'entreprise nécessitant un débit prévisible et une intégration cloud. Google publie également des prix approximatifs par image (et le blog des développeurs inclut un exemple de prix par image).

- gpt-image-1 est disponible via l'API OpenAI Images et bénéficie d'une large intégration avec l'écosystème (Playground, partenaires comme Adobe/Canva). La tarification est tokenisée et varie selon le niveau de qualité de l'image (OpenAI publie les conversions de jetons en dollars).

- Flux Kontext se concentre sur une UX interactive rapide et offre des crédits + des temps d'édition faibles dans les démonstrations de produits - pratique pour les concepteurs et une itération rapide. Qwen fournit des artefacts ouverts et un accès à la recherche (idéal si vous souhaitez auto-héberger ou inspecter les éléments internes).

Combien coûtent ces services ? Lequel offre le meilleur rapport qualité-prix ?

Les prix changent fréquemment — vous trouverez ci-dessous les chiffres indiqués par l'éditeur (août 2025) et les calculs de coûts par image représentatifs lorsque les fournisseurs les ont publiés.

Prix publiés (déclarations du fournisseur)

| Modèle / Fournisseur | Aperçu des prix publics (publié) | Estimation approximative par image |

|---|---|---|

| gpt-image-1 (OpenAI) | Tarification tokenisée (saisie de texte : 5 $/1 M$, saisie d’image : 10 $/1 M$, sortie d’image : 40 $/1 M$). OpenAI indique que cela correspond à environ $ 0.02- $ 0.19 par image générée en fonction de la qualité/taille. | ~0.02 $ (basse qualité/vignette) → ~0.19 $ (carré de haute qualité) |

| Image Flash Gemini 2.5 (Google) | 30 $ par million de jetons de sortie et exemple : chaque image ≈ 1290 jetons de sortie (~$0.039 (par image) selon le blog du développeur. Tarification appliquée via l'API Gemini / Vertex. | ~$0.039 par image (exemple Google) |

| Contexte Flux (Flux) | Niveau gratuit avec crédits ; les pages produits Flux montrent vous recevrez 10 crédits gratuits et des modifications typiques au prix de 5 crédits ; niveaux d'abonnement disponibles pour les utilisateurs intensifs. (Page produit du fournisseur). | Coût très faible pour les modifications occasionnelles ; abonnement pour une utilisation intensive. |

| Qwen-Image-Edit (QwenLM) | Publication ouverte et artefacts GitHub : accès libre pour la recherche avec exemples gratuits ; les déploiements commerciaux varient selon l'intégrateur (auto-hébergement ou cloud). Pas de prix canonique unique par image ; le prix le plus bas est généralement fixé en auto-hébergement. |

Interprétation de la valeur : Si vous avez besoin d'images à grand volume génération En production et souhaitant une tarification par image prévisible, l'exemple de Google est extrêmement compétitif. Si vos coûts sont dominés par l'édition humaine ou le temps de conception itératif, Flux ou l'exécution locale de Qwen peuvent être plus économiques. OpenAI offre un vaste écosystème de SDK et de nombreux partenaires, ce qui justifie le niveau supérieur pour la facilité d'intégration.

Prix en CometAPI

| Modèle | GPT-image-1 | Image Flash Gemini 2.5 | FLUX.1 Contexte |

| Prix | Jetons d'entrée : 8.00 $ ; jetons de sortie : 32.00 $ | $0.03120 | flux kontext pro : 0.09600 $ flux-kontext-max : 0.19200 $ |

Conseils pratiques et rapides pour obtenir les meilleurs résultats

Conseils d'invite et de flux de travail (s'applique à tous les modèles)

- Soyez explicite sur la composition: angle de prise de vue, éclairage, ambiance, distance focale, objectif et relations spatiales entre les objets. Exemple : « Gros plan 35 mm, faible profondeur de champ, sujet centré, lumière douce sur le bord supérieur gauche. »

- Utiliser le raffinement itératif pour les modificationsEffectuez d'abord des modifications structurelles grossières, puis peaufinez les textures et l'éclairage. Des modèles comme FLUX et Gemini sont conçus pour prendre en charge un raffinement en plusieurs étapes.

- Pour le texte dans les images: fournissez le texte exact que vous souhaitez et ajoutez « rendre comme un signe lisible à contraste élevé avec un gaufrage réaliste » — pour les modifications bilingues, utilisez Qwen-Image-Edit lorsque vous avez besoin d'une fidélité chinois/anglais.

- Utiliser des images de référence: pour la cohérence des personnages ou des variantes de produits, fournissez des images de référence de haute qualité et des invites d'ancrage telles que « correspondez au personnage de la référence_01 : traits du visage, couleur du costume et éclairage ». Gemini et Flux mettent l'accent sur la fusion/cohérence multi-images.

- Modifications avec ou sans masque: Dans la mesure du possible, utilisez un masque pour limiter les modifications. En cas d'utilisation d'un masque, attendez-vous à des débordements occasionnels. Les modèles varient : Flux/Gemini gèrent bien les modifications sans masque, mais un masque reste utile.

- Utilisez le Image GPT / GPT-4o Pour les invites de composition complexes comportant plusieurs objets, nombres et contraintes spatiales. Utilisez une seule instruction précise par génération, lorsque cela est possible.

Conseils sur les coûts et la latence

Traitement par lots: utilisez des API batch ou des fonctions cloud pour générer efficacement de nombreuses variantes. Gemini-2.5-Flash est optimisé pour un débit élevé si vous avez besoin de volumes importants.

Qualité de l'accord vs prix:OpenAI expose des niveaux d'images faibles/moyens/élevés ; génère des brouillons de faible qualité, finalise à haute qualité.

Résultat final

- Idéal pour la production et l'intégration : GPT-Image-1 — le plus puissant pour les besoins d'API, de composition et d'intégration dans des outils professionnels.

- Idéal pour la cohérence photoréaliste du consommateur : Nano Banane — La mise à niveau d'image Gemini de Google brille par des modifications de portrait naturelles et séquentielles et une expérience utilisateur accessible.

- Meilleure expérience mobile/éditeur : Flux Kontext — d'excellentes modifications conversationnelles au téléphone avec peu de friction.

- Si vous mesurez par des modifications de texte chirurgicales et une édition bilingue/multilingue → Qwen-Image-Edit** est le meilleur spécialiste et un excellent choix lorsque la précision du texte à l'intérieur des images est importante.

Pour commencer

CometAPI est une plateforme d'API unifiée qui regroupe plus de 500 modèles d'IA provenant de fournisseurs leaders, tels que la série GPT d'OpenAI, Gemini de Google, Claude d'Anthropic, Midjourney, Suno, etc., au sein d'une interface unique et conviviale pour les développeurs. En offrant une authentification, un formatage des requêtes et une gestion des réponses cohérents, CometAPI simplifie considérablement l'intégration des fonctionnalités d'IA dans vos applications. Que vous développiez des chatbots, des générateurs d'images, des compositeurs de musique ou des pipelines d'analyse pilotés par les données, CometAPI vous permet d'itérer plus rapidement, de maîtriser les coûts et de rester indépendant des fournisseurs, tout en exploitant les dernières avancées de l'écosystème de l'IA.

Les développeurs peuvent accéder GPT-image-1, FLUX.1 Contexte et Image Flash Gemini 2.5 Grâce à CometAPI, les dernières versions des modèles répertoriées correspondent à la date de publication de l'article. Pour commencer, explorez les fonctionnalités du modèle dans la section cour de récréation et consultez le Guide de l'API Pour des instructions détaillées, veuillez vous connecter à CometAPI et obtenir la clé API avant d'y accéder. API Comet proposer un prix bien inférieur au prix officiel pour vous aider à vous intégrer.

La dernière intégration Qwen-Image-Edit apparaîtra bientôt sur CometAPI, alors restez à l'écoute ! Prêt à commencer à éditer des images ? → Inscrivez-vous à CometAPI dès aujourd'hui !

Prix en CometAPI

| Modèle | GPT-image-1 | Image Flash Gemini 2.5 | FLUX.1 Contexte |

| Prix | Jetons d'entrée : 8.00 $ ; jetons de sortie : 32.00 $ | $0.03120 | flux kontext pro : 0.09600 $ flux-kontext-max : 0.19200 $ |