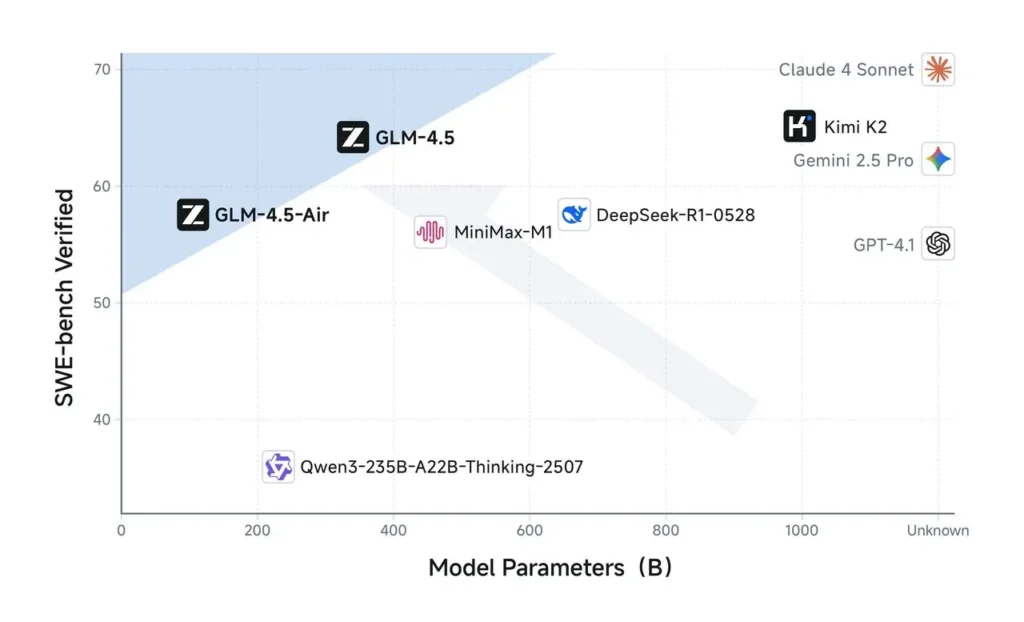

Le 28 juillet 2025, la startup pékinoise Zhipu AI a officiellement dévoilé sa série GLM-4.5 de grands modèles de langage open source. Il s'agit de sa version la plus puissante à ce jour et cible les applications avancées d'agents intelligents. L'annonce, effectuée lors d'un événement en ligne en direct à la suite de la Conférence mondiale sur l'intelligence artificielle (WAIC), a présenté deux variantes : le GLM-4.5 complet, avec 355 milliards de paramètres au total (dont 32 milliards actifs), et le GLM-4.5-Air, plus compact, avec 106 milliards de paramètres au total (dont 12 milliards actifs). Les deux modèles utilisent une architecture de raisonnement hybride, « pensante » et « non-pensante », conçue pour équilibrer inférence profonde et réactivité, et offrent une fenêtre contextuelle de 128,000 XNUMX jetons pour des cas d'utilisation conversationnels et orientés tâches étendus.

Le lancement de GLM-4.5 intervient dans un contexte de course à l'IA qui s'intensifie en Chine. Selon l'agence de presse officielle chinoise Xinhua, les développeurs chinois ont publié 1,509 2025 modèles en langage étendu en juillet 3,755, soit un record mondial de XNUMX XNUMX modèles, ce qui témoigne clairement de l'ampleur et de la rapidité de l'expansion de l'écosystème chinois de l'IA.

Licence Open Source de GLM-4.5

S'écartant clairement des paradigmes propriétaires fermés, Z.ai publie GLM-4.5 sous un Licence open source de type MIT, entièrement vérifiable, offrant aux entreprises une transparence totale sur la pondération des modèles et le code d'entraînement. Les organisations peuvent déployer GLM-4.5. sur site, l'affiner sur des ensembles de données propriétaires ou l'intégrer via des services d'inférence auto-hébergés, évitant ainsi le verrouillage des fournisseurs et les structures de tarification des API opaques.

La disponibilité des deux GLM-4.5 pour les tâches générales d'agent et GLM-4.5-Air, une variante légère optimisée pour les environnements à faibles ressources, garantit un large éventail de cas d'utilisation, des déploiements de centres de données à grande échelle aux scénarios d'inférence de périphériques périphériques.

D'un point de vue stratégique, l'approche open source de Zhipu positionne l'entreprise face aux acteurs occidentaux traditionnels à code source fermé comme OpenAI. En démocratisant l'accès à un modèle comparable à GPT-4 sous licence MIT, Zhipu vise à développer une solide communauté de développeurs en aval et à établir des références techniques pour les capacités d'IA agentique. Les observateurs du secteur soulignent que cette démarche s'inscrit dans une tendance plus large chez les « tigres de l'IA » chinois, notamment Moonshot AI et Step AI, qui ont également ouvert des modèles de grande envergure pour accélérer les cycles d'innovation.

Analyse comparative et indicateurs de performance

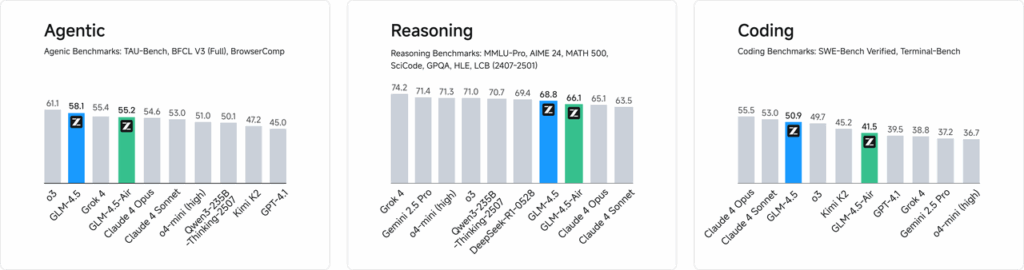

Les tests préliminaires fournis par Zhipu AI indiquent que GLM-4.5 obtient un score global de 63.2 sur 12 suites d'évaluation standard du secteur, ce qui le place troisième parmi les modèles open source et propriétaires, tandis que la version simplifiée GLM-4.5-Air obtient un score de 59.8, alliant efficacité et précision. Les évaluations de codage internes démontrent également que GLM-4.5 surpasse ses principaux concurrents, obtenant un taux de réussite de 53.9 % contre Kimi K2 et de 80.8 % contre Qwen3-Coder sur 52 tâches de programmation différentes.

Les démonstrations en direct ont mis en évidence les capacités d'agentivité de GLM-4.5 : le modèle effectuait des recherches web de manière autonome (récupérant et synthétisant des informations provenant de sources multiples) et interagissait avec des environnements de développement et de réseaux sociaux simulés pour générer des publications, exécuter des extraits de code et manipuler des éléments d'interface utilisateur en temps réel. Les utilisateurs intéressés peuvent tester gratuitement et immédiatement le modèle grandeur nature via le portail Qingyan de Zhipu et la plateforme CometAPI. Les développeurs peuvent quant à eux accéder aux points de terminaison de l'API sur le service BigModel de CometAPI ou télécharger les pondérations complètes du modèle depuis Hugging Face et ModelScope sous licence MIT.

La rentabilité est un élément clé de la stratégie de Z.ai. Formé sur un corpus de 15 4.5 milliards de jetons, GLM-100 exploite des chemins d'inférence optimisés pour offrir un débit de 200 à 0.11 jetons par seconde, soit jusqu'à huit fois plus rapide que ses concurrents nationaux comparables, à un prix annoncé de seulement 1 $ par million de jetons, ce qui le place au-dessus des modèles comme DeepSeek-RXNUMX et les dernières versions d'Alibaba. Sous la licence permissive du MIT, l'ensemble des pondérations, du code et de la documentation des modèles sont disponibles gratuitement via Hugging Face, afin de favoriser une communauté dynamique de développeurs et de chercheurs à travers le monde.

« GLM-4.5 incarne notre engagement à démocratiser l'accès aux technologies d'IA de pointe », a déclaré Zhang Peng, PDG de Z.ai, lors d'une interview accordée à CNBC. « En rendant open source un modèle qui excelle dans le raisonnement, le codage et les fonctions agentiques, nous permettons aux organisations de toute taille d'innover sans les contraintes des API propriétaires ni les coûts prohibitifs. »

Pour commencer

CometAPI est une plateforme d'API unifiée qui regroupe plus de 500 modèles d'IA provenant de fournisseurs leaders, tels que la série GPT d'OpenAI, Gemini de Google, Claude d'Anthropic, Midjourney, Suno, etc., au sein d'une interface unique et conviviale pour les développeurs. En offrant une authentification, un formatage des requêtes et une gestion des réponses cohérents, CometAPI simplifie considérablement l'intégration des fonctionnalités d'IA dans vos applications. Que vous développiez des chatbots, des générateurs d'images, des compositeurs de musique ou des pipelines d'analyse pilotés par les données, CometAPI vous permet d'itérer plus rapidement, de maîtriser les coûts et de rester indépendant des fournisseurs, tout en exploitant les dernières avancées de l'écosystème de l'IA.

Les développeurs peuvent accéder API GLM-4.5 Air et API GLM-4.5 à travers API CometLes dernières versions des modèles Claude répertoriées sont celles à la date de publication de l'article. Pour commencer, explorez les fonctionnalités du modèle dans le cour de récréation et consultez le Guide de l'API Pour des instructions détaillées, veuillez vous connecter à CometAPI et obtenir la clé API avant d'y accéder. API Comet proposer un prix bien inférieur au prix officiel pour vous aider à vous intégrer.