Rilis GLM-5, yang diperkenalkan minggu ini oleh Zhipu AI dari Tiongkok (dipasarkan secara publik sebagai Z.AI / zai-org di banyak kanal pengembang), menandai langkah lain dalam percepatan rilis model besar. Model baru ini diposisikan sebagai andalan Zhipu: skala lebih besar, disetel untuk tugas-tugas agentic berjangka panjang, dan dibangun dengan pilihan rekayasa yang dimaksudkan untuk menurunkan biaya inferensi sambil mempertahankan konteks panjang. Laporan awal industri dan catatan langsung dari pengembang menunjukkan peningkatan bermakna dalam pengkodean, penalaran multi-langkah, dan orkestrasi agen dibanding iterasi GLM sebelumnya — dan dalam beberapa pengujian bahkan menantang Claude 4.5.

Apa itu GLM-5 dan siapa yang membangunnya?

GLM-5 adalah rilis besar terbaru dalam keluarga GLM: sebuah foundation model besar open-source yang dikembangkan dan dipublikasikan oleh Z.ai (tim di balik seri GLM). Diumumkan pada awal Februari 2026, GLM-5 dipresentasikan sebagai model generasi berikutnya yang secara khusus disetel untuk tugas-tugas “agentic” — yaitu alur kerja multi-langkah berjangka panjang di mana model harus merencanakan, memanggil alat, mengeksekusi, dan mempertahankan konteks untuk percakapan berkepanjangan atau agen otomatis. Rilis ini menonjol bukan hanya karena desain modelnya tetapi juga karena bagaimana dan di mana model tersebut dilatih: Z.ai menggunakan campuran perangkat keras dan toolchain domestik Tiongkok sebagai bagian dari dorongan kemandirian.

Angka arsitektur dan pelatihan yang dilaporkan mencakup:

- Skalabilitas parameter: GLM-5 ditingkatkan hingga sekitar 744B parameter (dengan jumlah expert “aktif” yang lebih kecil sebagaimana disebutkan di beberapa catatan teknis, mis. 40B aktif), dibanding ukuran keluarga GLM-4 sebelumnya sekitar 355B/32B aktif.

- Data prapelatihan: Ukuran korpus pelatihan dilaporkan meningkat dari ~23 triliun token (generasi GLM-4) menjadi ~28.5 triliun token untuk GLM-5.

- Sparse attention / DeepSeek Sparse Attention (DSA): Skema attention jarang untuk mempertahankan konteks panjang sekaligus menurunkan biaya komputasi saat inferensi.

- Penekanan desain: pilihan rekayasa berfokus pada orkestrasi agen, penalaran konteks panjang, dan inferensi hemat biaya.

Asal-usul dan pemposisian

GLM-5 dibangun di atas lini yang mencakup GLM-4.5 (dirilis pertengahan 2025) dan beberapa pembaruan iteratif seperti 4.7. Z.ai memposisikan GLM-5 sebagai lompatan dari “vibe coding” (keluaran kode cepat satu langkah) menuju “agentic engineering”: penalaran berkelanjutan, orkestrasi multi-alat, dan sintesis sistem pada jendela konteks yang panjang. Materi publik menekankan bahwa GLM-5 dirancang untuk menangani tugas rekayasa sistem yang kompleks — membangun, mengoordinasikan, dan mempertahankan perilaku agen multi-langkah alih-alih hanya menjawab kueri terisolasi.

Fitur baru apa yang ada di GLM-5?

Perubahan arsitektur utama

- Skala sparse masif (MoE): GLM-5 beralih ke arsitektur Mixture-of-Experts sparse yang jauh lebih besar. Angka publik dari laman pengembang dan tulisan independen mencantumkan model ini sekitar 744B total parameter dengan ~40B aktif per token — langkah signifikan dari konfigurasi GLM-4.5 ~355B / 32B aktif. Skala sparse ini memungkinkan model menampilkan kapasitas total yang sangat besar sambil menjaga komputasi per token tetap terkelola.

- DeepSeek Sparse Attention (DSA): Untuk mempertahankan kemampuan konteks panjang tanpa meningkatkan biaya inferensi secara linier, GLM-5 mengintegrasikan mekanisme attention sparse (bermerek DeepSeek) untuk menjaga dependensi jarak jauh penting pada skala sambil memangkas biaya attention pada konteks berukuran sangat panjang.

Agentic engineering sebagai tujuan desain fundamental

Salah satu fitur utama GLM-5 adalah bahwa ia secara eksplisit dirancang untuk agentic engineering — artinya model ini dimaksudkan untuk digunakan bukan hanya untuk obrolan satu putaran atau tugas ringkasan, tetapi sebagai “otak” bagi agen multi-langkah yang dapat merencanakan, melakukan pemanggilan alat, mengelola status, dan bernalar di sepanjang konteks panjang. Z.ai memposisikan GLM-5 untuk berperan dalam loop orkestrasi: menguraikan masalah kompleks, memanggil alat/API eksternal, dan melacak tugas panjang selama banyak putaran.

Mengapa desain agentic itu penting

Alur kerja agentic adalah pusat otomatisasi dunia nyata: asisten riset otomatis, insinyur perangkat lunak otonom, orkestrasi operasi, dan kontrol simulasi. Model yang dibangun untuk dunia ini membutuhkan perencanaan yang kuat, perilaku pemanggilan alat yang stabil, dan ketangguhan pada ribuan token konteks.

Peningkatan pengkodean, penalaran, dan perilaku “long-horizon”

GLM-5 menekankan peningkatan dalam generasi kode dan penalaran. Z.ai mengklaim peningkatan terarah pada kemampuan model untuk menulis, merombak, dan men-debug kode, serta penalaran multi-langkah yang lebih konsisten di sepanjang interaksi panjang. Laporan akses awal independen dan evaluasi mitra menemukan bahwa model ini secara signifikan lebih kuat pada tugas-tugas berorientasi pengembang dibanding generasi GLM sebelumnya.

Fitur praktis untuk pengembang

- Jendela konteks yang lebih besar untuk menampung dokumentasi, basis kode, dan status percakapan.

- Primitif tooling untuk pemanggilan alat yang aman dan penanganan hasil.

- Performa few-shot dan chain-of-thought yang lebih baik untuk mengurai dan mengeksekusi tugas kompleks.

- Fitur agentic dan pemanggilan alat: GLM-5 menekankan dukungan native untuk agen: pemanggilan fungsi/alat, sesi stateful, dan pengelolaan yang lebih baik atas dialog panjang dan rangkaian penggunaan alat. Ini memudahkan pembuatan agen yang mengintegrasikan penelusuran web, basis data, atau otomatisasi tugas.

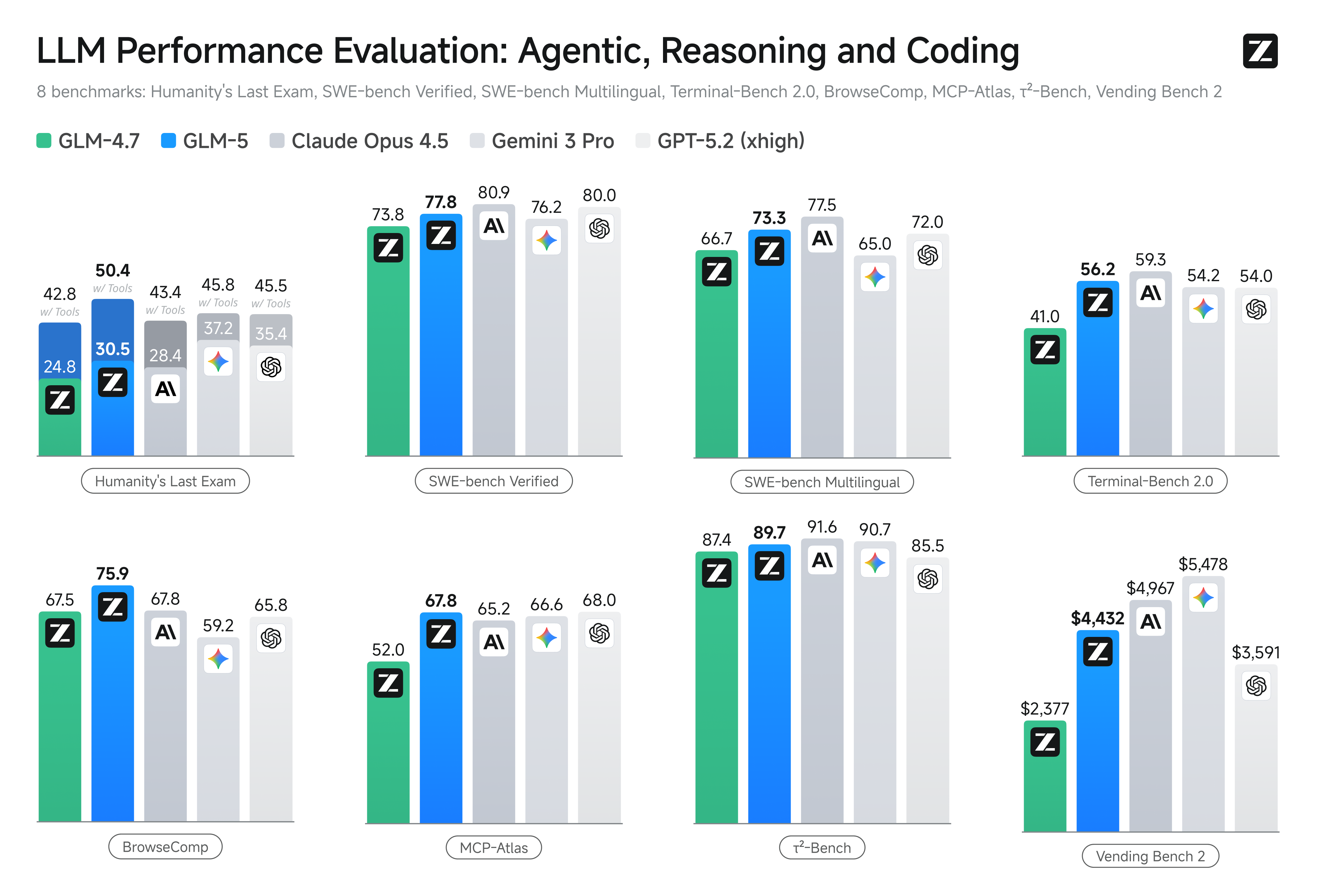

Bagaimana performa GLM-5 pada tolok ukur?

Sorotan tolok ukur spesifik

- Tolok ukur pengkodean: GLM-5 mendekati (dan dalam beberapa kasus, menyamai) performa pengkodean model proprietary yang sangat dioptimalkan seperti Claude Opus 4.5 dari Anthropic pada tugas pengkodean tertentu. Hasil ini bergantung pada tugas (uji unit, pengkodean algoritmik, penggunaan API), tetapi menandai peningkatan yang jelas dibanding GLM-4.5.

- Uji penalaran dan agentic: Pada penalaran multi-langkah dan rangkaian evaluasi agentic (mis. perencanaan multi-putaran, tolok ukur dekomposisi tugas), GLM-5 meraih hasil terbaik di kelasnya untuk model open-source dan pada beberapa metrik melampaui model tertutup pesaing pada tugas-tugas terarah.

Bagaimana cara mengakses dan mencoba GLM-5?

GLM-5 adalah model bahasa besar generasi kelima dari Zhipu AI (Z.ai), dibangun dengan arsitektur Mixture-of-Experts (~745 B total, ~44 B aktif) dan ditujukan untuk penalaran kuat, pengkodean, serta alur kerja agentic. Model ini resmi diluncurkan sekitar 12 Feb 2026.

Saat ini ada dua cara utama orang mengaksesnya:

A) Akses API Resmi (Z.ai atau Agregator)

Zhipu AI sendiri menyediakan API untuk model-modelnya, dan Anda dapat memanggil GLM-5 melalui API tersebut.

Langkah-langkah umum:

- Daftar akun Z.ai/Open BigModel API.

- Dapatkan kunci API dari dasbor.

- Gunakan endpoint bergaya OpenAPI atau REST API dengan nama model (mis.,

glm-5).

(Mirip dengan cara Anda memanggil model GPT dari OpenAI). - Atur prompt dan kirim permintaan HTTP.

👉 Halaman harga Z.ai menampilkan harga token GLM-5 resmi seperti:

- ~$1.0 per 1M token input

- ~$3.2 per 1M token output

B) Pembungkus API Pihak Ketiga —— CometAPI

API seperti CometAPI atau WaveSpeed membungkus banyak model AI (OpenAI, Claude, Z.ai, dll.) di balik antarmuka terpadu.

- Dengan layanan seperti CometAPI, Anda dapat memanggil model GLM dengan mengganti ID model.

(CometAPI saat ini mendukung GLM-5/GLM-4.7.) - glm-5 di CometAPI dihargai 20% dari harga resmi.

| Jenis Penggunaan | Harga |

|---|---|

| Token input | ~$0.8 per 1M tokens |

| Token output | ~$2.56 per 1M tokens |

Mengapa ini penting: Anda mempertahankan kode klien yang kompatibel dengan OpenAI yang sudah ada dan hanya mengganti base URL/ID model.

C) Self-hosting melalui Hugging Face / Weights

Ada repositori bobot tidak resmi GLM-5 (mis., versi bernama glm-5/glm-5-fp8) yang terlihat di daftar model Hugging Face.

Dengan itu Anda dapat:

- Mengunduh bobot model.

- Menggunakan alat seperti vLLM, SGLang, xLLM, atau Transformers untuk menyajikan secara lokal atau pada armada GPU cloud Anda.

Kelebihan: kontrol maksimal, tanpa biaya API berkelanjutan.

Kekurangan: kebutuhan komputasi yang sangat besar — kemungkinan memerlukan banyak GPU kelas atas dan memori (ratusan GB), membuatnya tidak praktis pada sistem kecil.

Jadi — apakah GLM-5 sepadan, dan haruskah Anda tetap menggunakan GLM-4.7?

Jawaban singkat (ringkasan eksekutif)

- Jika pekerjaan Anda membutuhkan perilaku agentic multi-langkah yang tangguh, generasi kode tingkat produksi, atau otomatisasi tingkat sistem: GLM-5 layak dievaluasi segera. Arsitektur, skala, dan penyetelannya memprioritaskan capaian-capaian ini.

- Jika Anda membutuhkan mikroservis hemat biaya dan throughput tinggi (obrolan singkat, klasifikasi, prompt ringan): GLM-4.7 kemungkinan tetap menjadi pilihan paling ekonomis. GLM-4.7 mempertahankan seperangkat kapabilitas kuat dengan biaya per token yang jauh lebih rendah di banyak daftar penyedia dan sudah teruji di lapangan.

Jawaban lebih panjang (rekomendasi praktis)

Adopsi strategi model bertingkat: gunakan GLM-4.7 untuk interaksi sehari-hari berkapasitas tinggi dan cadangkan GLM-5 untuk masalah rekayasa bernilai tinggi dan orkestrasi agentic. Uji coba GLM-5 pada irisan produk kecil yang menguji konteks panjang, integrasi tooling, dan ketepatan kode; ukur waktu rekayasa yang dihemat serta biaya model tambahan. Seiring waktu, Anda akan tahu apakah peningkatan kapabilitas GLM-5 membenarkan migrasi yang lebih luas.

Dengan CometAPI, Anda dapat beralih antara GLM-4.7 dan GLM-5 kapan saja.

Kasus penggunaan dunia nyata di mana GLM-5 unggul

1. Orkestrasi agen yang kompleks

Fokus desain GLM-5 pada perencanaan multi-langkah dan pemanggilan alat membuatnya sangat cocok untuk sistem yang harus mengoordinasikan penelusuran, pemanggilan API, dan eksekusi program (misalnya: asisten riset otomatis, generator kode iteratif, atau agen layanan pelanggan multi-langkah yang harus berkonsultasi dengan basis data dan API eksternal).

2. Rekayasa longform & penalaran basis kode

Saat Anda membutuhkan model untuk menganalisis, merombak, atau menyintesis lintas banyak berkas atau basis kode besar, konteks yang diperluas dan attention sparse GLM-5 menjadi keunggulan langsung — lebih sedikit mode kegagalan akibat konteks terpotong dan konsistensi rentang panjang yang lebih baik.

3. Sintesis yang intensif pengetahuan

Analis dan tim produk yang menghasilkan laporan kompleks — ringkasan riset multi-bagian, ringkasan hukum, atau pengajuan regulasi — dapat memperoleh manfaat dari peningkatan model dalam penalaran multi-langkah yang stabil dan pengurangan halusinasi pada pengujian yang dilaporkan vendor.

4. Otomatisasi agentic untuk alur kerja

Tim yang membangun otomatisasi yang harus mengorkestrasi banyak sistem (mis., perencanaan + ticketing + pipeline deployment) dapat menggunakan GLM-5 sebagai perencana dan eksekutor pusat, didukung oleh kerangka pemanggilan alat dan pembungkus keamanan.

Kesimpulan

GLM-5 adalah rilis penting dalam lanskap model frontier yang berkembang pesat. Penekanannya pada agentic engineering, pengkodean dan penalaran yang lebih baik, serta ketersediaan bobot terbuka menjadikannya menarik bagi tim yang membangun sistem AI berjangka panjang dengan alat terintegrasi. Ada peningkatan nyata pada tugas-tugas tertentu dan kompromi biaya/kinerja yang menjanjikan — namun pembeli harus mengevaluasi GLM-5 terhadap tugas spesifik mereka dan menjalankan tolok ukur terkontrol sendiri sebelum berkomitmen ke produksi.

Pengembang dapat mengakses GLM-5 melalui CometAPI sekarang. Untuk memulai, jelajahi kapabilitas model di Playground dan lihat panduan API untuk instruksi terperinci. Sebelum mengakses, pastikan Anda telah masuk ke CometAPI dan memperoleh kunci API. CometAPI menawarkan harga yang jauh lebih rendah daripada harga resmi untuk membantu Anda melakukan integrasi.

Siap berangkat?→ Daftar untuk GLM-5 hari ini !

Jika Anda ingin mengetahui lebih banyak tips, panduan, dan berita tentang AI, ikuti kami di VK, X dan Discord!