OpenAI baru-baru ini mengumumkan beberapa pembaruan, termasuk rilis model GPT-5-Codex-Mini, peningkatan batas kecepatan untuk hierarki multi-pengguna, dan pengoptimalan efisiensi pemrosesan model.

OpenAI GPT-5-Codex-Mini Varian GPT-5-Codex yang baru diumumkan dan berfokus pada pengembang: model yang lebih kecil, dioptimalkan untuk biaya dan throughput, dirancang untuk memberikan sebagian besar bantuan pengkodean GPT-5-Codex, tetapi dengan biaya yang jauh lebih rendah dan volume penggunaan yang lebih tinggi. Varian "Mini" diposisikan sebagai pilihan pragmatis untuk sesi pengkodean yang panjang, otomatisasi latar belakang, dan alur kerja pengembang frekuensi tinggi di mana kapabilitas puncak mentah kurang penting daripada mendapatkan lebih banyak token/permintaan untuk paket yang sama.

Apa itu GPT-5-Codex-Mini dan fiturnya?

GPT-5-Codex-Mini adalah varian ringkas dan hemat biaya dari keluarga GPT-5-Codex OpenAI yang dikemas khusus untuk permukaan produk Codex (integrasi CLI dan IDE). Model ini diposisikan sebagai model "lebih kecil dan lebih hemat biaya" yang mengorbankan sedikit kapasitas puncak demi konsumsi sumber daya yang jauh lebih rendah dan kuota yang dapat digunakan lebih tinggi untuk alur kerja pengembang interaktif. Model mini ini dirancang untuk memungkinkan pengembang menjalankan lebih banyak putaran pengkodean (OpenAI menjelaskan secara kasar Penggunaan 4x lebih banyak untuk tingkatan langganan ChatGPT yang sama) sambil menjaga latensi dan biaya tetap rendah untuk tugas-tugas rekayasa umum yang terdefinisi dengan baik.

Dari segi kapabilitas, GPT-5-Codex-Mini mewarisi fitur-fitur inti lini produk Codex: pemahaman mendalam tentang basis kode dan eksekusi tugas-tugas multi-langkah secara "agen". Berdasarkan fitur-fitur Codex CLI, pengembang dapat mengirimkan perintah bahasa alami, cuplikan kode, tangkapan layar, atau diagram desain antarmuka ke Codex melalui terminal interaktif. Model ini akan menyediakan rencana terlebih dahulu, kemudian secara otomatis menelusuri berkas, mengedit kode, menjalankan perintah, dan menguji setelah mendapatkan persetujuan pengguna.

Dari perspektif modal, produk Codex memungkinkan penambahan gambar (seperti tangkapan layar UI, draf desain, atau tangkapan layar pesan kesalahan) ke sesi di terminal atau IDE. Model ini dapat memahami konten teks dan gambar, tetapi keluarannya tetap berupa kode teks dan penjelasan. Oleh karena itu, GPT-5-Codex-Mini dapat dianggap sebagai model proksi kode yang utamanya berupa "input teks + gambar, output teks", dan tidak melakukan tugas-tugas seperti pembuatan gambar, pembuatan audio, atau pembuatan video.

Bagaimana GPT-5-Codex-Mini dibandingkan dengan GPT-5-Codex?

Apa yang baru di Codex?

Selain peluncuran GPT-5-Codex-Mini, OpenAI juga telah meningkatkan batas kecepatan Codex sebesar 50% untuk pengguna ChatGPT Plus, Business, dan Edu, sehingga meningkatkan batas permintaan yang tersedia secara signifikan. Sementara itu, pengguna ChatGPT Pro akan mendapatkan izin pemrosesan prioritas untuk meningkatkan kecepatan respons dan pengalaman eksekusi tugas.

Lebih lanjut, OpenAI telah melakukan sedikit peningkatan pada model GPT-5-Codex, yang mengoptimalkan kinerjanya dalam skenario kolaboratif. Model yang diperbarui menunjukkan peningkatan beberapa poin persentase pada metrik evaluasi utama, peningkatan efisiensi penggunaan token sekitar 3%, dan ketahanan yang lebih baik dalam menangani kasus-kasus khusus, sehingga mengurangi kebutuhan akan panduan pengguna.

| tingkat pengguna | Kodeks GPT-5 | GPT-5-Codex-Mini |

|---|---|---|

| Plus/Bisnis/Pendidikan | meningkatkan volume pesan masing-masing sebesar 1.5x. | meningkatkan volume pesan masing-masing sebesar 6x. |

GPT-5-Codex-Mini vs GPT-5-Codex: perbedaan tolok ukur

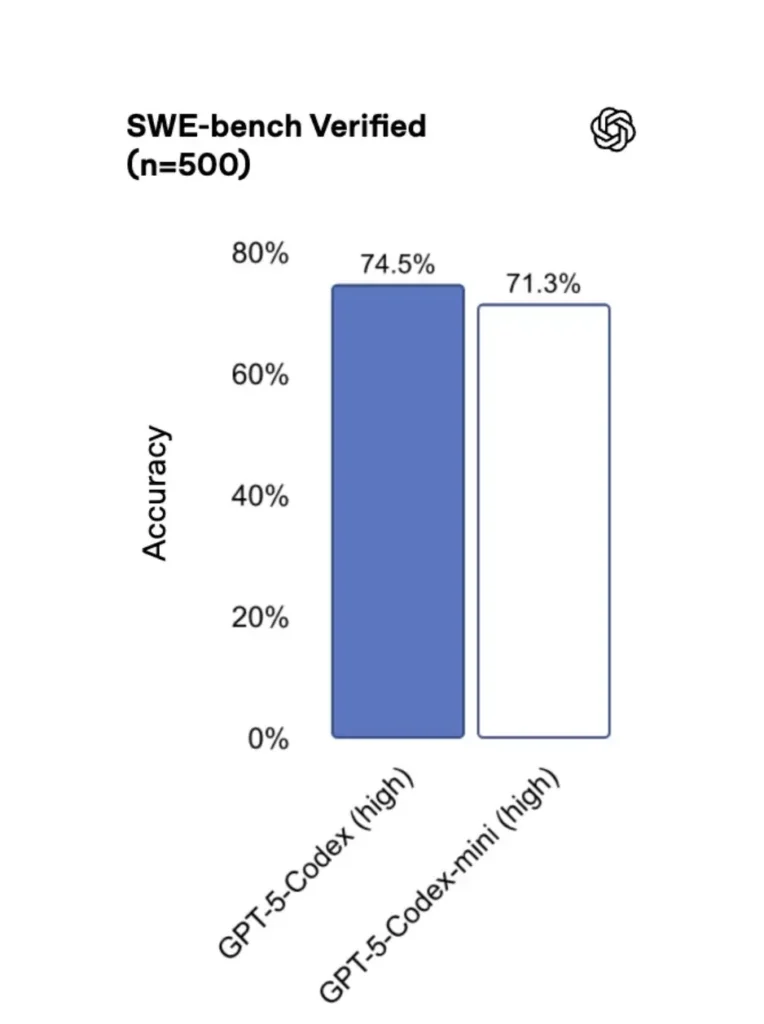

Dibandingkan dengan versi aslinya, GPT-5-Codex-Mini memang sedikit berkurang kinerjanya, tetapi pengembang menerima kredit penggunaan sekitar empat kali lipat. Dalam uji SWE-bench Verified, GPT-5 High memperoleh skor 72.8%, GPT-5-Codex memperoleh skor 74.5%, dan GPT-5-Codex-Mini memperoleh skor 71.3%.

Codex (dan varian mininya) menggunakan token yang jauh lebih sedikit untuk interaksi yang ringan—materi OpenAI mengklaim pengurangan pada urutan puluhan poin persentase untuk perintah sederhana (misalnya, angka yang dikutip ≈93.7% lebih sedikit token pada interaksi ringan untuk keluarga Codex vs. GPT-5 dalam beberapa skenario).

GPT-5-Codex-Mini vs GPT-5-Codex: perbedaan fitur

- Ukuran & biaya: Mini secara eksplisit lebih kecil dan lebih hemat biaya; OpenAI membingkainya sebagai platform yang memungkinkan penggunaan sekitar 4 kali lebih banyak dengan batasan langganan yang sama. Ini merupakan optimasi kuota/efisiensi untuk tugas-tugas rutin pengembang.

- Amplop kemampuan: GPT-5-Codex tetap menjadi opsi dengan kemampuan lebih tinggi untuk tugas-tugas agen yang panjang dan kompleks (refaktor besar, tinjauan kode mendalam, siklus pengujian yang diperpanjang). Mini disetel agar lebih cepat dan hemat sumber daya untuk interaksi singkat yang sering.

- Latensi dan batas kecepatan: Mini biasanya memberikan latensi yang lebih rendah dan memungkinkan batas kecepatan yang lebih tinggi per paket — membuatnya cocok untuk alur kerja yang padat dan interaktif.

- Permukaan default: Mini tersedia sebagai model yang dapat dipilih di Codex CLI dan Ekstensi IDE; GPT-5-Codex adalah default untuk tugas cloud dan alur peninjauan kode mendalam di Codex.

Kapan menggunakan Mini vs. Full Codex

- penggunaan Mini untuk: perancah, pembuatan kode berulang, pemfaktoran ulang kecil, pelengkapan interaktif selama pengeditan, dan saat bekerja dengan kuota atau kendala biaya.

- penggunaan Kodeks GPT-5 untuk: tinjauan kode yang komprehensif, tugas otonom multi-jam, pemfaktoran ulang yang kompleks, dan tugas yang memerlukan penalaran model yang paling kuat dan eksekusi yang digerakkan oleh pengujian.

Bagaimana cara mengakses GPT-5-Codex-Mini (CLI, IDE, API)?

Codex CLI (terminal-pertama)

OpenAI diperkenalkan gpt-5-codex-mini sebagai opsi model di dalam Codex CLI. Pola penggunaan umum mengikuti alur kerja Codex CLI: memulai sesi interaktif, menentukan model, melampirkan file atau tangkapan layar, menjalankan “tugas Codex Cloud”, dan banyak lagi. CLI juga mendukung quick /model beralih antara penuh gpt-5-codex dan gpt-5-codex-miniSaat pertama kali dijalankan, Anda perlu melakukan autentikasi menggunakan akun ChatGPT/Pro/Enterprise Anda (atau memberikan kunci API). CLI menyediakan berbagai perintah yang memungkinkan Codex memindai basis kode, menjalankan pengujian, membuka REPL, atau menerapkan rekomendasi patch.

Contoh (sesi interaktif Codex CLI):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

Alur tersebut mencerminkan default Codex CLI baru di mana alat akan menyarankan Mini mendekati batas penggunaan.

Ekstensi VS Code / IDE

Ya — ekstensi Codex IDE (VS Code) sudah menyertakan gpt-5-codex-mini Sebagai opsi. Instal ekstensi Codex di Visual Studio Code untuk mendapatkan penyelesaian kode sebaris, saran refaktor, dan perbaikan cepat berbasis AI. Ekstensi ini juga menampilkan tindakan cepat (menghasilkan kode, menjelaskan kode yang dipilih, melakukan refaktor) dan dapat menjalankan tugas Codex Cloud dari editor, langkah-langkah VS Code:

- Instal ekstensi OpenAI Codex / ChatGPT untuk VS Code.

- Masuk dengan akun ChatGPT Anda (Plus/Pro/Bisnis).

- Buka palet perintah:

Cmd/Ctrl+Shift+P → Codex: Set Model→ pilihgpt-5-codex-mini. - Gunakan perintah sebaris (pilih kode → klik kanan → “Jelaskan dengan Codex” atau tekan tombol pintas yang dikonfigurasi).

Contoh: Perintah sebaris VS Code (langkah semu)

- Pilih fungsi di

user_service.py. - Media

Cmd/Ctrl+Shift+P → Codex: Explain Selectionatau gunakan klik kanan → “Jelaskan dengan Codex.” - Ekstensi ini membuka panel samping berisi penjelasan Mini, tes yang disarankan, dan tombol “Buat PR” sekali klik yang menggunakan tugas Codex Cloud untuk mendorong cabang untuk ditinjau.

Bagaimana dengan API — dapatkah saya memanggilnya dari aplikasi saya?

Pengumuman OpenAI menunjukkan Dukungan API akan segera hadir untuk GPT-5-Codex-Mini; pada saat penulisan ini, model tersebut tersedia di toolchain Codex terlebih dahulu (CLI/IDE). Ini berarti klien API produksi harus mempersiapkan nama model. gpt-5-codex-mini di API Permintaan/Respons setelah dipublikasikan. Sementara itu, Anda dapat membuat prototipe dengan Codex CLI dan alur IDE.

Saat akses API diaktifkan, panggilan umum (gaya Respons) mungkin terlihat seperti:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Apa praktik terbaik untuk rekayasa cepat dengan Codex Mini?

Berikut ini adalah praktik dan pola terbaik yang nyata dan teruji di lapangan untuk mendapatkan nilai maksimal dari Codex Mini dalam alur kerja rekayasa produksi.

1) Strategi pemilihan model — gabungkan dan sesuaikan

Gunakan Mini untuk tugas-tugas berfrekuensi tinggi dan dengan kompleksitas rendah (pemformatan, refaktor kecil, pengujian otomatis), dan kembali ke Codex lengkap untuk desain kompleks, penelusuran kesalahan mendalam, atau transformasi besar di seluruh repositori. Otomatiskan peralihan: Codex CLI sudah menyarankan Mini pada penggunaan 90%, dan Anda dapat membuat skrip. /model beralih dalam perkakas Anda untuk memilih model berdasarkan kompleksitas tugas.

2) Template rekayasa cepat

Buat templat prompt deterministik kecil untuk tugas-tugas yang berulang: pembuatan pengujian, draf changelog, pembuatan pesan komit, dan deskripsi PR. Simpan ini sebagai cuplikan kode yang dapat digunakan kembali di repositori Anda atau sebagai preset prompt Codex.

Contoh templat perintah untuk pengujian unit:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) Otomatisasi jaring pengaman — persetujuan & gerbang CI

Jangan pernah mengizinkan model untuk langsung mengirim kode tanpa persetujuan manusia. Gunakan mode persetujuan Codex dan tugas Codex Cloud untuk membuat diff dan mewajibkan persetujuan manusia di CI. Codex CLI mendukung "mode persetujuan" sehingga pengeditan harus disetujui sebelum diterapkan.

4) Cache dan deduplikasi panggilan model

Untuk perintah berulang (misalnya, menjelaskan suatu fungsi), simpan respons yang dikunci dengan hash perintah + berkas dalam cache. Hal ini mengurangi panggilan yang berulang dan menjaga profil biaya tetap terprediksi.

5) Gunakan streaming + perbedaan tambahan

Jika memungkinkan, mintalah keluaran streaming dan diff inkremental, alih-alih penulisan ulang seluruh berkas. Hal ini mengurangi penggunaan token dan membantu peninjau melihat perubahan yang ditargetkan.

6) Pengujian unit-aliran generator pertama

Hasilkan pengujian dan jalankan secara lokal di lingkungan sementara. Jika pengujian gagal, ulangi dengan model yang menyediakan perbaikan pengujian yang gagal. Bingkai setiap iterasi sebagai prompt terpisah dengan keluaran pengujian yang disertakan.

Contoh cuplikan otomatisasi Codex CLI (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

Kesimpulan

GPT-5-Codex-Mini merupakan langkah produk yang pragmatis: langkah ini mengakui bahwa alur kerja pengembang seringkali didominasi oleh banyak interaksi singkat yang mana latensi, biaya, dan alur kerja tanpa gangguan menjadi pertimbangan. Dengan menyediakan tingkatan mini yang ditujukan untuk penggunaan IDE dan CLI, OpenAI memberi tim kemampuan untuk meningkatkan skala bantuan pengkodean sehari-hari tanpa harus langsung menerapkan model berbiaya tertinggi untuk setiap interaksi.

Pengembang dapat mengakses API Kodeks GPT-5 ,API GPT-5 Pro Melalui CometAPI, model terbaru CometAPI yang tercantum adalah per tanggal publikasi artikel. Sebelum mengakses, pastikan Anda telah masuk ke CometAPI dan mendapatkan kunci API.API Komet menawarkan harga yang jauh lebih rendah dari harga resmi untuk membantu Anda berintegrasi.

Siap untuk berangkat?→ Daftar ke CometAPI hari ini !

Jika Anda ingin mengetahui lebih banyak tips, panduan, dan berita tentang AI, ikuti kami di VK, X dan Discord!