Pada tahun 2025–2026, lanskap perkakas AI terus terkonsolidasi: API gateway (seperti CometAPI) diperluas untuk menyediakan akses bergaya OpenAI ke ratusan model, sementara aplikasi LLM pengguna akhir (seperti AnythingLLM) terus meningkatkan penyedia "OpenAI Generik" mereka agar aplikasi desktop dan lokal pertama dapat memanggil titik akhir apa pun yang kompatibel dengan OpenAI. Hal ini memudahkan saat ini untuk merutekan lalu lintas AnythingLLM melalui CometAPI dan mendapatkan manfaat dari pilihan model, perutean biaya, dan penagihan terpadu — sambil tetap menggunakan UI lokal dan fitur RAG/agent AnythingLLM.

Apa itu AnythingLLM dan mengapa Anda ingin menghubungkannya ke CometAPI?

Apa itu AnythingLLM?

AnythingLLM adalah aplikasi AI sumber terbuka dan lengkap serta klien lokal/cloud untuk membangun asisten obrolan, alur kerja retrieval-augmented generation (RAG), dan agen berbasis LLM. Aplikasi ini menyediakan UI yang apik, API pengembang, fitur ruang kerja/agen, dan dukungan untuk LLM lokal dan cloud — dirancang untuk bersifat privat secara default dan dapat diperluas melalui plugin. AnythingLLM memaparkan OpenAI Generik penyedia yang memungkinkannya berkomunikasi dengan API LLM yang kompatibel dengan OpenAI.

Apa itu CometAPI?

CometAPI adalah platform agregasi API komersial yang mengekspos 500+ model AI melalui satu antarmuka REST bergaya OpenAI dan penagihan terpadu. Dalam praktiknya, ini memungkinkan Anda memanggil model dari berbagai vendor (OpenAI, Anthropic, varian Google/Gemini, model gambar/audio, dll.) melalui https://api.cometapi.com/v1 titik akhir dan satu kunci API (format sk-xxxxx). CometAPI mendukung titik akhir gaya OpenAI standar seperti /v1/chat/completions, /v1/embeddings, dll., yang memudahkan pengadaptasian alat yang sudah mendukung API yang kompatibel dengan OpenAI.

Mengapa mengintegrasikan AnythingLLM dengan CometAPI?

Tiga alasan praktis:

- Pilihan model & fleksibilitas vendor: AnythingLLM dapat menggunakan LLM "apa pun yang kompatibel dengan OpenAI" melalui pembungkus OpenAI Generiknya. Mengarahkan pembungkus tersebut ke CometAPI akan memberikan akses langsung ke ratusan model tanpa mengubah UI atau alur AnythingLLM.

- Optimalisasi biaya/operasi: Menggunakan CometAPI memungkinkan Anda mengganti model (atau menurunkannya ke model yang lebih murah) secara terpusat untuk pengendalian biaya, dan menjaga penagihan terpadu alih-alih menggunakan banyak kunci penyedia.

- Eksperimen lebih cepat: Anda dapat melakukan A/B pada model yang berbeda (misalnya,

gpt-4o,gpt-4.5, varian Claude, atau model multi-moda sumber terbuka) melalui UI AnythingLLM yang sama — berguna untuk agen, respons RAG, ringkasan, dan tugas multimoda.

Lingkungan dan kondisi yang harus Anda persiapkan sebelum mengintegrasikan

Persyaratan sistem & perangkat lunak (tingkat tinggi)

- Desktop atau server yang menjalankan AnythingLLM (Windows, macOS, Linux) — instalasi desktop atau instans yang dihosting sendiri. Pastikan Anda menggunakan versi terbaru yang mengekspos Preferensi LLM / Penyedia AI pengaturan.

- Akun CometAPI dan kunci API (

sk-xxxxxrahasia gaya). Anda akan menggunakan rahasia ini di penyedia OpenAI Generik AnythingLLM. - Konektivitas jaringan dari mesin Anda ke

https://api.cometapi.com(tidak ada firewall yang memblokir HTTPS keluar). - Opsional tetapi direkomendasikan: lingkungan Python atau Node modern untuk pengujian (Python 3.10+ atau Node 18+), curl, dan klien HTTP (Postman / HTTPie) untuk memeriksa kewarasan CometAPI sebelum menghubungkannya ke AnythingLLM.

Kondisi spesifik AnythingLLM

The OpenAI Generik Penyedia LLM adalah rute yang direkomendasikan untuk titik akhir yang meniru permukaan API OpenAI. Dokumen AnythingLLM memperingatkan bahwa penyedia ini berfokus pada pengembang dan Anda harus memahami masukan yang Anda berikan. Jika Anda menggunakan streaming atau titik akhir Anda tidak mendukung streaming, AnythingLLM menyertakan pengaturan untuk menonaktifkan streaming untuk OpenAI Generik.

Daftar periksa keamanan & operasional

- Perlakukan kunci CometAPI seperti rahasia lainnya — jangan komit ke repo; simpan di gantungan kunci OS atau variabel lingkungan jika memungkinkan.

- Jika Anda berencana menggunakan dokumen sensitif di RAG, pastikan jaminan privasi titik akhir memenuhi kebutuhan kepatuhan Anda (periksa dokumen/persyaratan CometAPI).

- Tentukan token maksimum dan batas jendela konteks untuk mencegah tagihan yang tak terkendali.

Bagaimana Anda mengonfigurasi AnythingLLM untuk menggunakan CometAPI (langkah demi langkah)?

Berikut adalah rangkaian langkah konkret — diikuti dengan contoh variabel lingkungan dan cuplikan kode untuk menguji koneksi sebelum Anda menyimpan pengaturan di UI AnythingLLM.

Langkah 1 — Dapatkan kunci CometAPI Anda

- Daftar atau masuk di CometAPI.

- Navigasi ke “Kunci API” dan buat kunci — Anda akan mendapatkan string yang terlihat seperti

sk-xxxxxRahasiakan itu.

Langkah 2 — Verifikasi CometAPI berfungsi dengan permintaan cepat

Gunakan curl atau Python untuk memanggil titik akhir penyelesaian obrolan sederhana untuk mengonfirmasi konektivitas.

Contoh ikal

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

Jika ini mengembalikan 200 dan respons JSON dengan choices array, kunci dan jaringan Anda berfungsi. (Dokumen CometAPI menunjukkan permukaan dan titik akhir bergaya OpenAI).

Contoh Python (permintaan)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

Langkah 3 — Konfigurasi AnythingLLM (UI)

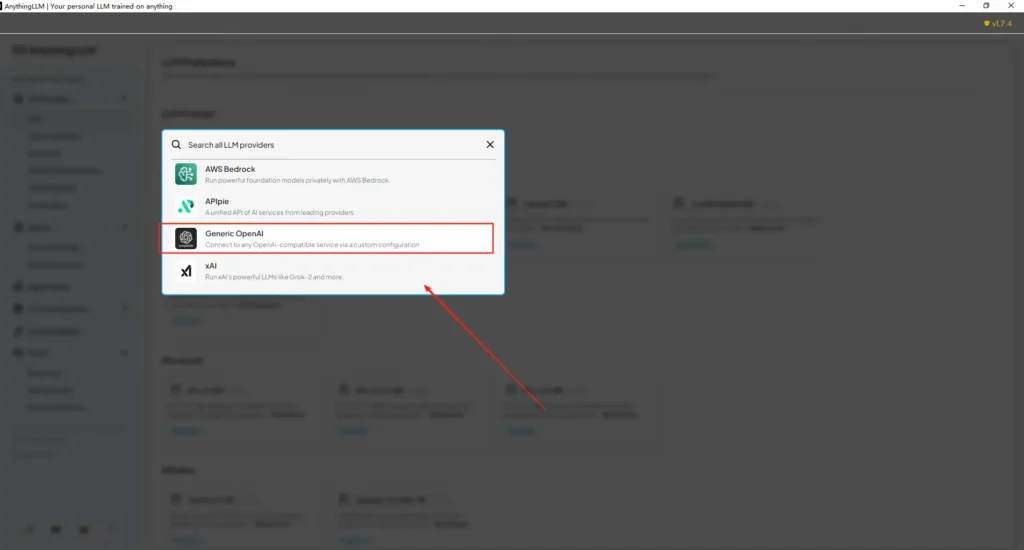

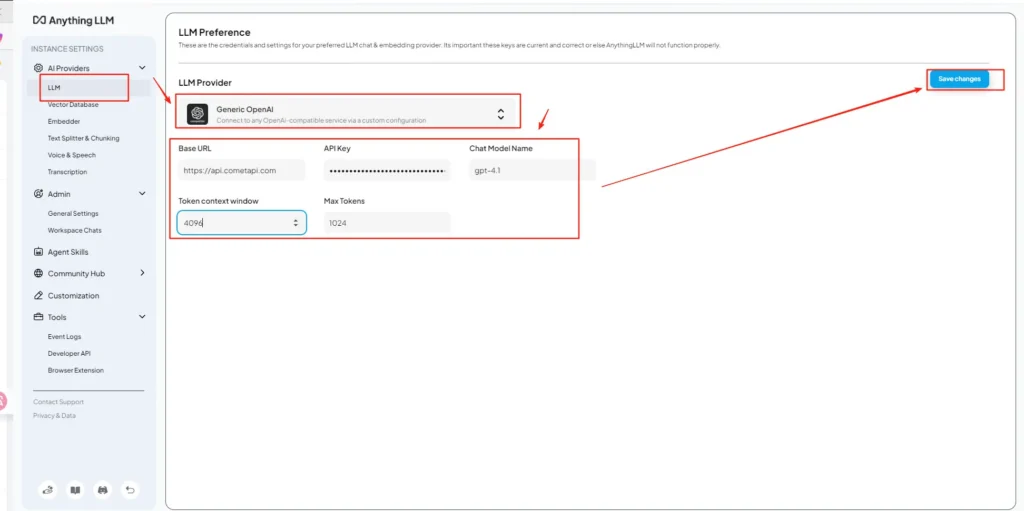

Buka AnythingLLM → Pengaturan → Penyedia AI → Preferensi LLM (atau jalur serupa di versi Anda). Gunakan OpenAI Generik penyedia dan isi kolom sebagai berikut:

Konfigurasi API (contoh)

• Masuk ke menu pengaturan AnythingLLM, cari Preferensi LLM di bawah Penyedia AI.

• Pilih Generic OpenAI sebagai penyedia model, masukkanhttps://api.cometapi.com/v1di bidang URL.

• Tempelkansk-xxxxxdari CometAPI di kotak input kunci API. Isi jendela konteks Token dan Token Maksimum sesuai dengan model yang sebenarnya. Anda juga dapat menyesuaikan nama model di halaman ini, seperti menambahkangpt-4oModel.

Hal ini sejalan dengan panduan “OpenAI Generik” AnythingLLM (pembungkus pengembang) dan pendekatan URL dasar yang kompatibel dengan OpenAI milik CometAPI.

Langkah 4 — Tetapkan nama model & batas token

Pada layar pengaturan yang sama, tambahkan atau sesuaikan nama model persis seperti yang dipublikasikan CometAPI (misalnya, gpt-4o, minimax-m2, kimi-k2-thinking) sehingga UI AnythingLLM dapat menyajikan model-model tersebut kepada pengguna. CometAPI menerbitkan string model untuk setiap vendor.

Langkah 5 — Uji di AnythingLLM

Mulai obrolan baru atau gunakan ruang kerja yang sudah ada, pilih penyedia OpenAI Generik (jika Anda memiliki beberapa penyedia), pilih salah satu nama model CometAPI yang Anda tambahkan, dan jalankan perintah sederhana. Jika Anda mendapatkan pelengkapan yang koheren, Anda telah terintegrasi.

Bagaimana AnythingLLM menggunakan pengaturan tersebut secara internal

Pembungkus OpenAI Generik AnythingLLM membangun permintaan bergaya OpenAI (/v1/chat/completions, /v1/embeddings), jadi setelah Anda mengarahkan URL dasar dan memberikan kunci CometAPI, AnythingLLM akan merutekan obrolan, panggilan agen, dan permintaan penyematan melalui CometAPI secara transparan. Jika Anda menggunakan agen AnythingLLM ( @agent mengalir), mereka akan mewarisi penyedia yang sama.

Apa saja praktik terbaik dan kemungkinan jebakannya?

Praktik terbaik

- Gunakan pengaturan konteks yang sesuai dengan model: Cocokkan Jendela Konteks Token dan Token Maksimum AnythingLLM dengan model yang Anda pilih di CometAPI. Ketidakcocokan dapat menyebabkan pemotongan tak terduga atau panggilan gagal.

- Amankan kunci API Anda: Simpan kunci CometAPI di variabel lingkungan dan/atau Kubernetes/manajer rahasia; jangan pernah memeriksanya di Git. AnythingLLM akan menyimpan kunci di pengaturan lokalnya jika Anda memasukkannya di UI — anggap penyimpanan host sebagai penyimpanan sensitif.

- Mulailah dengan model yang lebih murah/lebih kecil untuk alur eksperimen: Gunakan CometAPI untuk mencoba model berbiaya rendah untuk pengembangan, dan simpan model premium untuk produksi. CometAPI secara eksplisit mengiklankan pengalihan biaya dan penagihan terpadu.

- Pantau penggunaan & atur peringatan: CometAPI menyediakan dasbor penggunaan — tetapkan anggaran/peringatan untuk menghindari tagihan mengejutkan.

- Agen dan alat uji secara terpisah: Agen AnythingLLM dapat memicu tindakan; ujilah dengan perintah aman dan pada instans pementasan terlebih dahulu.

Jebakan umum

- Antarmuka Pengguna vs.

.envkonflik: Saat melakukan hosting sendiri, pengaturan UI dapat menimpa.envperubahan (dan sebaliknya). Periksa hasil yang dihasilkan/app/server/.envjika keadaan kembali normal setelah dimulai ulang. Laporan masalah komunitasLLM_PROVIDERreset. - Ketidakcocokan nama model: Menggunakan nama model yang tidak tersedia di CometAPI akan menyebabkan kesalahan 400/404 dari gateway. Selalu konfirmasi model yang tersedia pada daftar model CometAPI.

- Batasan token & streaming: Jika Anda memerlukan respons streaming, pastikan model CometAPI mendukung streaming (dan versi UI AnythingLLM mendukungnya). Beberapa penyedia berbeda dalam semantik streaming.

Kasus penggunaan dunia nyata apa yang dapat dibuka oleh integrasi ini?

Generasi Augmented Pengambilan (RAG)

Gunakan pemuat dokumen AnythingLLM + basis data vektor dengan CometAPI LLM untuk menghasilkan jawaban yang peka konteks. Anda dapat bereksperimen dengan penyematan murah + model obrolan mahal, atau tetap menggunakan CometAPI untuk penagihan terpadu. Alur RAG AnythingLLM adalah fitur bawaan utama.

Otomatisasi agen

AnythingLLM mendukung @agent alur kerja (menelusuri halaman, memanggil alat, menjalankan otomatisasi). Perutean panggilan LLM agen melalui CometAPI memberi Anda pilihan model untuk langkah kontrol/interpretasi tanpa mengubah kode agen.

Pengujian A/B multi-model dan pengoptimalan biaya

Beralih model per ruang kerja atau fitur (misalnya, gpt-4o untuk jawaban produksi, gpt-4o-mini untuk dev). CometAPI membuat pertukaran model menjadi mudah dan memusatkan biaya.

Pipa multimoda

CometAPI menyediakan gambar, audio, dan model khusus. Dukungan multi-moda AnythingLLM (melalui penyedia) plus model CometAPI memungkinkan pembuatan teks gambar, peringkasan multimoda, atau alur transkripsi audio melalui antarmuka yang sama.

Kesimpulan

CometAPI terus memposisikan dirinya sebagai gateway multi-model (lebih dari 500 model, API bergaya OpenAI) — yang menjadikannya mitra alami bagi aplikasi seperti AnythingLLM yang sudah mendukung penyedia OpenAI Generik. Penyedia Generik AnythingLLM dan opsi konfigurasi terbarunya juga memudahkan koneksi ke gateway tersebut. Konvergensi ini menyederhanakan eksperimen dan migrasi produksi di akhir tahun 2025.

Cara memulai dengan Comet API

CometAPI adalah platform API terpadu yang menggabungkan lebih dari 500 model AI dari penyedia terkemuka—seperti seri GPT OpenAI, Gemini Google, Claude Anthropic, Midjourney, Suno, dan lainnya—menjadi satu antarmuka yang ramah bagi pengembang. Dengan menawarkan autentikasi yang konsisten, pemformatan permintaan, dan penanganan respons, CometAPI secara drastis menyederhanakan integrasi kapabilitas AI ke dalam aplikasi Anda. Baik Anda sedang membangun chatbot, generator gambar, komposer musik, atau alur kerja analitik berbasis data, CometAPI memungkinkan Anda melakukan iterasi lebih cepat, mengendalikan biaya, dan tetap tidak bergantung pada vendor—semuanya sambil memanfaatkan terobosan terbaru di seluruh ekosistem AI.

Untuk memulai, jelajahi kemampuan modelAPI Komet dalam tempat bermain dan lihat panduan API untuk instruksi detail. Sebelum mengakses, pastikan Anda telah masuk ke CometAPI dan mendapatkan kunci API. cometAPI menawarkan harga yang jauh lebih rendah dari harga resmi untuk membantu Anda berintegrasi.

Siap untuk berangkat?→ Daftar ke CometAPI hari ini !

Jika Anda ingin mengetahui lebih banyak tips, panduan, dan berita tentang AI, ikuti kami di VK, X dan Discord!