DeepSeek dirilis Pencarian Dalam V3.2 dan varian komputasi tinggi DeepSeek-V3.2-Spesial, dengan mesin sparse-attention (DSA) baru, perilaku agen/alat yang ditingkatkan, dan mode "berpikir" (rantai pemikiran) yang memunculkan penalaran internal. Kedua model tersedia melalui API DeepSeek (titik akhir yang kompatibel dengan OpenAI) dan artefak model/laporan teknis dipublikasikan secara publik.

Apa itu DeepSeek V3.2?

DeepSeek V3.2 adalah penerus produksi dalam keluarga DeepSeek V3 — keluarga model generatif konteks panjang yang besar yang secara eksplisit direkayasa untuk penalaran-pertama alur kerja dan penggunaan agen. V3.2 menggabungkan penyempurnaan eksperimental sebelumnya (V3.2-Exp) ke dalam lini model arus utama yang diekspos melalui aplikasi, UI web, dan API DeepSeek. V3.2 mendukung keluaran percakapan yang cepat dan antarmuka pengguna khusus. pikir Mode (rantai pemikiran) cocok untuk tugas penalaran multi-langkah seperti matematika, debugging, dan perencanaan.

Mengapa V3.2 penting (konteks cepat)

DeepSeek V3.2 terkenal karena tiga alasan praktis:

- Konteks panjang: Jendela konteks token hingga 128k, yang membuatnya cocok untuk dokumen panjang, kontrak hukum, atau penelitian multi-dokumen.

- Desain penalaran-pertama: Model ini mengintegrasikan rantai pemikiran (“berpikir”) ke dalam alur kerja dan penggunaan alat — sebuah pergeseran menuju aplikasi agensi yang memerlukan langkah-langkah penalaran menengah.

- Biaya & efisiensi: Pengenalan DSA (sparse attention) mengurangi komputasi untuk rangkaian panjang, sehingga memungkinkan inferensi yang jauh lebih murah untuk konteks besar.

Apa itu DeepSeek-V3.2-Speciale dan apa bedanya dengan versi dasar v3.2?

Apa yang membuat varian “Speciale” istimewa?

DeepSeek V3.2-Speciale adalah komputasi tinggi, penalaran tinggi Varian dari keluarga v3.2. Dibandingkan dengan varian v3.2 yang seimbang, Speciale disetel (dan dilatih pasca-latih) secara khusus untuk penalaran multi-langkah, matematika, dan tugas-tugas agensi; ia menggunakan pembelajaran penguatan tambahan dari umpan balik manusia (RLHF) dan rantai pemikiran internal yang diperluas selama pelatihan. Titik akhir sementara dan akses API Speciale diumumkan sebagai berbatas waktu (referensi tanggal kedaluwarsa titik akhir 15 Desember 2025 untuk jalur Speciale).

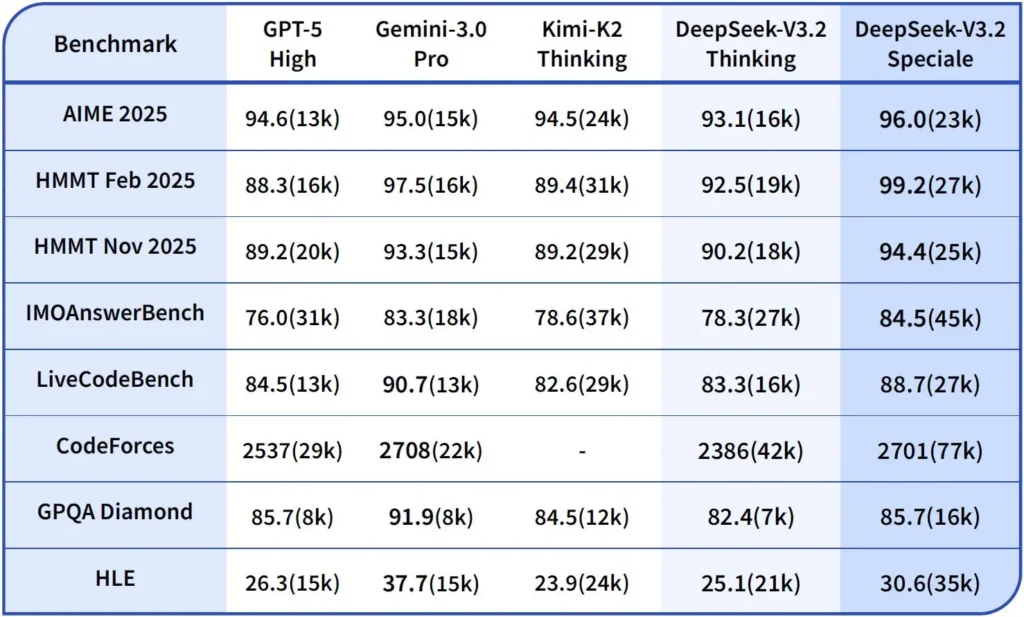

Performa dan tolok ukur

DeepSeek-V3.2-Speciale adalah varian V3.2 yang dioptimalkan untuk komputasi tinggi dan penalaran. Versi Speciale mengintegrasikan model matematika sebelumnya, DeepSeek-Math-V2. Model ini diposisikan sebagai model yang digunakan ketika beban kerja membutuhkan rantai pemikiran sedalam mungkin, pemecahan masalah multi-langkah, penalaran kompetitif (misalnya, gaya olimpiade matematika), dan orkestrasi agen yang kompleks.

Ia dapat membuktikan teorema matematika dan memverifikasi penalaran logisnya sendiri; Ia telah mencapai hasil yang luar biasa dalam berbagai kompetisi kelas dunia:

- Medali Emas IMO (Olimpiade Matematika Internasional)

- Medali Emas CMO (Olimpiade Matematika Tiongkok)

- Juara 2 ICPC (Kontes Pemrograman Komputer Internasional) (Kontes Manusia)

- Juara 10 IOI (Olimpiade Informatika Internasional) (Kontes Manusia)

Apa itu Mode Penalaran di DeepSeek v3.2?

DeepSeek mengungkap sebuah mode berpikir/bernalar yang menyebabkan model menghasilkan Rantai Pikiran (CoT) sebagai bagian terpisah dari output sebelum jawaban akhir. API menampilkan CoT ini sehingga aplikasi klien dapat memeriksa, menampilkan, atau menyaringnya.

Mekanika — apa yang disediakan API

reasoning_contentbidang:ketika mode berpikir diaktifkan, struktur respons mencakupreasoning_contentlapangan (CoT) pada tingkat yang sama dengan finalcontentHal ini memungkinkan klien mengakses langkah-langkah internal secara terprogram.- Panggilan alat saat berpikir:V3.2 mengklaim mendukung panggilan alat dalam lintasan berpikir: model dapat menyisipkan langkah-langkah penalaran dan pemanggilan alat, yang meningkatkan kinerja tugas yang kompleks.

Bagaimana DeepSeek v3.2 API mengimplementasikan penalaran

Versi 3.2 memperkenalkan mekanisme API rantai penalaran standar untuk mempertahankan logika penalaran yang konsisten di seluruh percakapan multi-giliran:

- Setiap permintaan penalaran berisi

reasoning_contentbidang dalam model; - Jika pengguna ingin model meneruskan penalaran, bidang ini harus diteruskan kembali ke putaran berikutnya;

- Ketika pertanyaan baru dimulai, pertanyaan lama

reasoning_contentharus dibersihkan untuk mencegah kontaminasi logis; - Model tersebut dapat menjalankan putaran “penalaran → pemanggilan alat → penalaran ulang” beberapa kali dalam mode penalaran.

Bagaimana cara mengakses dan menggunakan API DeepSeek v3.2

Pendek: CometAPI adalah gateway bergaya OpenAI yang mengekspos banyak model (termasuk keluarga DeepSeek) melalui https://api.cometapi.com/v1 sehingga Anda dapat menukar model dengan mengubah model string dalam permintaan. Daftar di CometAPI dan dapatkan kunci API Anda terlebih dahulu.

Mengapa menggunakan CometAPI dibandingkan DeepSeek langsung?

- CometAPI memusatkan penagihan, batasan tarif, dan pemilihan model (berguna jika Anda berencana mengganti penyedia tanpa mengubah kode).

- Titik akhir DeepSeek langsung (misalnya,

https://api.deepseek.com/v1) masih ada dan terkadang menampilkan fitur khusus penyedia; pilih CometAPI demi kenyamanan atau titik akhir vendor langsung untuk kontrol asli penyedia. Verifikasi fitur mana (misalnya, Speciale, titik akhir eksperimental) yang tersedia melalui CometAPI sebelum menggunakannya.

Langkah A — Buat akun CometAPI dan dapatkan kunci API

- Buka CometAPI (daftar / konsol) dan buat kunci API (dasbor biasanya menunjukkan

sk-...). Rahasiakan itu. API Komet

Langkah B — Konfirmasikan nama model yang tersedia

- Lakukan kueri pada daftar model untuk mengonfirmasi string model yang diekspos CometAPI (nama model dapat menyertakan sufiks varian). Gunakan titik akhir model sebelum melakukan hardcode pada nama:

curl -s -H "Authorization: Bearer $COMET_KEY" \

https://api.cometapi.com/v1/models | jq .

Cari entri DeepSeek (misalnya deepseek-v3.2 or deepseek-v3.2-exp) dan perhatikan id persisnya. CometAPI mengekspos /v1/models daftar.

Langkah C — Lakukan panggilan obrolan dasar (curl)

menggantikan <COMET_KEY> dan deepseek-v3.2 dengan id model yang Anda konfirmasi:

curl https://api.cometapi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <COMET_KEY>" \

-d '{

"model": "deepseek-v3.2",

"messages": [

{"role":"system","content":"You are a helpful assistant."},

{"role":"user","content":"Summarize DeepSeek v3.2 in two sentences."}

],

"max_tokens":300

}'

Ini adalah pola panggilan gaya OpenAI yang sama — CometAPI meneruskan ke penyedia yang dipilih.

Kompatibilitas dan Tindakan Pencegahan

- Mendukung pengaktifan Think Mode di lingkungan Claude Code;

- Pada baris perintah (CLI), cukup masukkan nama model deepseek-reasoner;

- Namun, mungkin tidak kompatibel dengan alat non-standar seperti Cline dan RooCode untuk saat ini;

- Disarankan untuk menggunakan Mode Non-Pikir untuk tugas-tugas biasa dan Mode Pikir untuk penalaran logis yang kompleks.

Pola adopsi praktis: beberapa contoh arsitektur

1 — Agen bantuan untuk alur kerja pengembang

- Mode: Speciale (mode berpikir) dipanggil untuk pembuatan kode kompleks dan pembuatan pengujian; mode obrolan cepat untuk asisten sebaris.

- Keselamatan: Gunakan pemeriksaan jalur CI dan eksekusi pengujian kotak pasir untuk kode yang dihasilkan.

- hosting yang: API atau dihosting sendiri di vLLM + kluster multi-GPU untuk konteks yang besar.

2 — Analisis dokumen untuk tim hukum/keuangan

- Mode: V3.2 dengan optimasi konteks panjang DSA untuk memproses kontrak panjang dan menghasilkan ringkasan terstruktur serta daftar tindakan.

- Keselamatan: Penandatanganan keputusan oleh pengacara manusia untuk keputusan selanjutnya; penyuntingan PII sebelum dikirim ke titik akhir yang dihosting.

3 — Orkestrasi jalur data otonom

- Mode: Mode berpikir untuk merencanakan tugas ETL multi-langkah, memanggil alat untuk menanyakan basis data dan memanggil pengujian validasi.

- Keselamatan: Terapkan konfirmasi tindakan dan pemeriksaan yang dapat diverifikasi sebelum melakukan operasi yang tidak dapat dibatalkan (misalnya, penulisan DB yang merusak).

Masing-masing pola di atas dapat diterapkan dengan model keluarga V3.2 saat ini, tetapi Anda harus memasangkan model tersebut dengan perkakas verifikasi dan tata kelola konservatif.

Bagaimana cara mengoptimalkan biaya dan kinerja dengan v3.2?

Gunakan mode ganda dengan sengaja

- Mode cepat untuk interaksi mikro: Gunakan mode alat non-berpikir untuk pengambilan cepat, konversi format, atau panggilan API langsung di mana latensi penting.

- Mode berpikir untuk perencanaan dan verifikasi: Alihkan tugas kompleks, agen multi-aksi, atau keputusan yang sensitif terhadap keselamatan ke mode berpikir. Tangkap langkah-langkah perantara dan jalankan proses verifikasi (otomatis atau manual) sebelum menjalankan tindakan kritis.

Varian model mana yang harus saya pilih?

- deepseek-v3.2 — model produksi seimbang untuk tugas agen umum.

- deepseek-v3.2-Speciale — varian penalaran berat yang terspesialisasi; mungkin hanya API pada awalnya dan digunakan saat Anda membutuhkan kinerja penalaran/tolok ukur terbaik (dan menerima kemungkinan biaya yang lebih tinggi).

Kontrol biaya praktis dan tips

- Rekayasa cepat: buat instruksi sistem tetap ringkas, hindari pengiriman konteks yang berulang. Instruksi sistem eksplisit: Gunakan perintah sistem yang menyatakan maksud mode: misalnya, "Anda berada dalam mode BERPIKIR — daftarkan rencana Anda sebelum memanggil alat." Untuk mode alat, tambahkan batasan seperti "Saat berinteraksi dengan API kalkulator, hanya keluarkan JSON dengan kolom berikut."

- Chunking + augmentasi pengambilan: gunakan pengambil eksternal untuk hanya mengirim segmen yang paling relevan untuk setiap pertanyaan pengguna.

- Suhu dan pengambilan sampel: Turunkan suhu untuk interaksi alat guna meningkatkan determinisme; naikkan suhu dalam tugas eksplorasi atau ideasi.

Tolok ukur dan ukuran

- Perlakukan keluaran sebagai tidak tepercaya hingga diverifikasi: Bahkan keluaran penalaran pun bisa salah. Tambahkan pemeriksaan deterministik (uji unit, pemeriksaan tipe) sebelum mengambil tindakan yang tidak dapat dibatalkan.

- Jalankan pengujian A/B pada beban kerja sampel (latensi, penggunaan token, kebenaran) sebelum berkomitmen pada suatu varian. v3.2 melaporkan perolehan besar pada tolok ukur penalaran, tetapi perilaku aplikasi sesungguhnya bergantung pada desain perintah dan distribusi input.

Pertanyaan Umum (FAQ)

T: Apa cara yang direkomendasikan untuk mendapatkan CoT dari model?

A: Gunakan deepseek-reasoner model atau set thinking/thinking.type = enabled dalam permintaan Anda. Responsnya mencakup reasoning_content (CoT) dan final content.

T: Bisakah model memanggil alat eksternal saat dalam mode berpikir?

A: Ya — V3.2 memperkenalkan kemampuan alat untuk digunakan dalam mode berpikir dan non-berpikir; model dapat mengeluarkan panggilan alat terstruktur selama penalaran internal. Gunakan strict mode dan skema JSON yang jelas untuk menghindari panggilan yang salah bentuk.

T: Apakah penggunaan mode berpikir meningkatkan biaya?

A: Ya — mode berpikir menghasilkan token CoT perantara, yang meningkatkan penggunaan token dan biaya. Rancang sistem Anda untuk memungkinkan berpikir hanya saat diperlukan.

T: Titik akhir dan URL dasar apa yang harus saya gunakan?

A: CometAPI menyediakan titik akhir yang kompatibel dengan OpenAI. URL dasar default-nya adalah https://api.cometapi.com dan titik akhir obrolan utama adalah /v1/chat/completions (Atau /chat/completions (tergantung pada URL dasar yang Anda pilih).

T: Apakah diperlukan perkakas khusus untuk menggunakan pemanggilan alat?

A: Tidak — API mendukung deklarasi fungsi terstruktur dalam JSON. Anda perlu memberikan tools parameter, skema alat, dan menangani siklus hidup fungsi JSON di aplikasi Anda: menerima panggilan fungsi JSON, menjalankan fungsi, lalu mengembalikan hasil ke model untuk dilanjutkan atau ditutup. Mode berpikir menambahkan persyaratan untuk meneruskan kembali reasoning_content di samping hasil alat.

Kesimpulan

DeepSeek V3.2 dan DeepSeek-V3.2-Speciale mewakili dorongan yang jelas menuju terbuka, berpusat pada penalaran LLM yang membuat rantai pemikiran menjadi eksplisit dan mendukung alur kerja alat agen. LLM ini menawarkan primitif baru yang canggih (DSA, mode berpikir, pelatihan penggunaan alat) yang dapat menyederhanakan pembuatan agen tepercaya—dengan syarat Anda memperhitungkan biaya token, manajemen status yang cermat, dan kontrol operasional.

Pengembang dapat mengakses API Deepseek v3.2 dll melalui CometAPI, versi model terbaru selalu diperbarui dengan situs web resmi. Untuk memulai, jelajahi kemampuan model di tempat bermain dan konsultasikan Panduan API untuk petunjuk terperinci. Sebelum mengakses, pastikan Anda telah masuk ke CometAPI dan memperoleh kunci API. API Komet menawarkan harga yang jauh lebih rendah dari harga resmi untuk membantu Anda berintegrasi.

Siap untuk berangkat?→ Uji coba gratis deepseek v3.2 !

Jika Anda ingin mengetahui lebih banyak tips, panduan, dan berita tentang AI, ikuti kami di VK, X dan Discord!