Ruang perkakas AI visual low-code berkembang pesat. Flowise — pembangun visual sumber terbuka untuk alur kerja LLM — terus menambahkan integrasi komunitas dan merilis pembaruan rutin; CometAPI adalah salah satu dari beberapa API AI terpadu Platform yang kini mengekspos ratusan model melalui satu titik akhir; dan pembangun backend tanpa kode seperti BuildShip juga menyediakan node untuk memanggil CometAPI sehingga Anda dapat menghubungkan model yang sama ke dalam alur kerja server. Panduan ini menunjukkan alasan dan kapan harus menggabungkan komponen-komponen ini, lalu memandu Anda melalui integrasi Flowise → CometAPI yang konkret, cara menghubungkan Prompt → LLM Chain → CometAPI, praktik terbaik yang direkomendasikan, dan contoh kasus penggunaan.

Apa itu FlowiseAI dan mengapa itu penting?

FlowiseAI adalah platform visual sumber terbuka untuk membangun alur kerja LLM, asisten obrolan, dan alur kerja agen. Platform ini menawarkan kanvas seret dan lepas yang terdiri dari node (integrasi) yang merepresentasikan prompt, rantai, konektor LLM, pengambil, memori, alat, dan keluaran — memungkinkan tim membuat prototipe dan mengirimkan sistem berbasis LLM tanpa perlu merakit semuanya secara manual. Flowise juga menyediakan API, pelacakan, alat evaluasi, dan node yang dikelola komunitas sehingga berguna untuk pembuatan prototipe cepat maupun eksperimen produksi.

Mengapa hal itu penting: dengan menggunakan Flowise Anda mendapatkan observabilitas visual dan iterasi cepat pada rantai perintah dan pilihan model — dan dengan menambahkan konektor pihak ketiga (seperti CometAPI) Anda dapat beralih atau bereksperimen dengan banyak model dasar dengan perubahan minimal.

Apa itu CometAPI dan apa saja yang disediakannya?

CometAPI adalah lapisan API terpadu yang menggabungkan akses ke ratusan model AI (OpenAI, Anthropic/Claude, Google/Gemini, model Replicate, penyedia gambar & audio, dll.) di balik satu format permintaan dan skema autentikasi yang konsisten. Artinya, Anda dapat memilih atau menukar model, membandingkan biaya/latensi, atau beralih di antara penyedia secara terprogram tanpa perlu menulis ulang kode aplikasi Anda. Platform ini diposisikan sebagai lapisan akses manajemen biaya dan agnostik vendor untuk LLM dan model multimoda.

Apa yang bisa Anda dapatkan dalam praktiknya: manajemen kredensial yang lebih sederhana untuk evaluasi multi-model, kemampuan untuk melakukan A/B model yang berbeda dengan cepat, dan (seringkali) pengoptimalan biaya dengan memilih varian model yang lebih murah jika sesuai.

Mengapa Anda mengintegrasikan FlowiseAI dengan CometAPI?

Mengintegrasikan Flowise dengan CometAPI memberi Anda kemudahan pembangun visual Flowise sekaligus akses terpusat ke berbagai backend model melalui CometAPI. Manfaatnya meliputi:

- Manajemen kredensial tunggal untuk beberapa titik akhir model (melalui CometAPI).

- Model A/Bing yang mudah dan perutean tingkat penyedia di dalam rantai visual (ganti model tanpa mengubah kabel node).

- Eksperimen yang lebih cepat: tukar model, sesuaikan perintah, dan bandingkan keluaran dalam alur Flowise.

- Mengurangi hambatan rekayasa bagi tim yang menginginkan lapisan orkestrasi visual tetapi membutuhkan beberapa penyedia model di balik layar.

- Mengapa Anda mengintegrasikan FlowiseAI dengan CometAPI?

- Mengintegrasikan Flowise dengan CometAPI memberi Anda kemudahan pembangun visual Flowise sekaligus akses terpusat ke berbagai backend model melalui CometAPI. Manfaatnya meliputi:

- Manajemen kredensial tunggal untuk beberapa titik akhir model (melalui CometAPI).

- Model A/Bing yang mudah dan perutean tingkat penyedia di dalam rantai visual (ganti model tanpa mengubah kabel node).

- Eksperimen yang lebih cepat: tukar model, sesuaikan perintah, dan bandingkan keluaran dalam alur Flowise.

- Mengurangi hambatan rekayasa bagi tim yang menginginkan lapisan orkestrasi visual tetapi membutuhkan beberapa penyedia model di balik layar.

- Kemampuan ini mempercepat pengaturan RAG, orkestrasi agen, dan alur kerja komposisi model sambil tetap menjaga asal-usul visual dan keterlacakan yang disediakan Flowise.

Kemampuan ini mempercepat pengaturan RAG, orkestrasi agen, dan alur kerja komposisi model sambil menjaga asal-usul visual dan ketertelusuran Flowise menyediakan.

Lingkungan dan prasyarat apa yang Anda perlukan sebelum integrasi?

Daftar Periksa (minimal):

- Masuk ke Aliran AI

- A API Komet akun + kunci API (Anda akan mengambilnya dari Konsol CometAPI). Catatan: CometAPI menggunakan jalur dasar (misalnya

https://api.cometapi.com/v1/) untuk permintaan — Anda akan menyediakannya di pengaturan node Flowise.

Persiapan keamanan & operasional:

- Simpan kunci API di Flowise Credentials — jangan simpan kunci di templat perintah atau kode node.

- Kuota paket dan batasan kecepatan: CometAPI dan vendor model yang mendasarinya dapat memberlakukan batasan — periksa paket Anda dan terapkan pembatasan sisi klien atau coba lagi jika diperlukan.

- Amati biaya: saat beralih model, Anda dapat mengubah penggunaan token dan biaya secara signifikan — metrik instrumen dan menetapkan batasan.

Bagaimana cara mengintegrasikan CometAPI dengan FlowiseAI? (Temukan dan tambahkan node CometAPI — apa saja langkah-langkahnya?)

Ikuti langkah-langkah praktis berikut untuk menambahkan ChatCometAPI simpul dan konfigurasikan kredensial.

Langkah 1 — Konfirmasikan bahwa Anda memiliki node yang tersedia

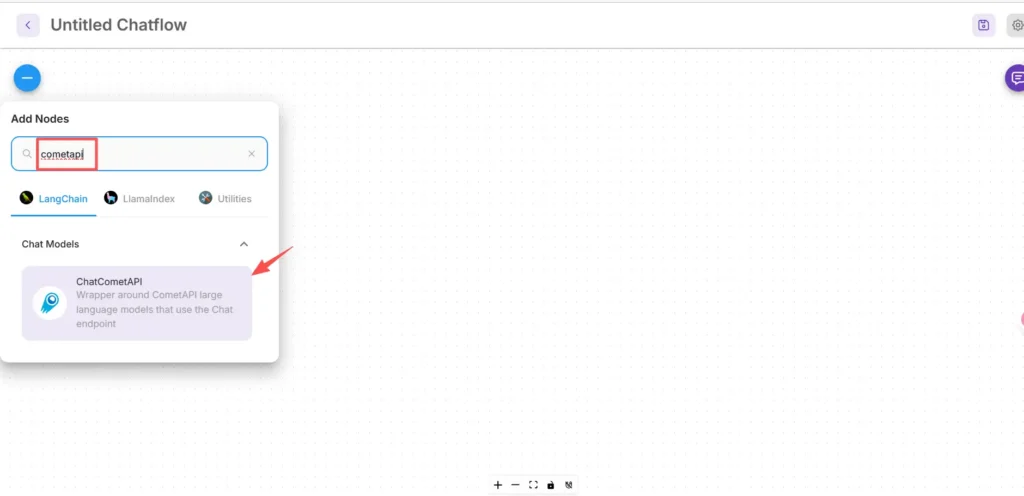

- Di kanvas FlowiseAI, klik Tambahkan baru.

- Di kotak pencarian, ketik dan cari "cometapi" untuk menemukan kotak CometAPI. Beberapa node komunitas muncul di LangChain → Model Obrolan.

Langkah 2 — Tambahkan node CometAPI ke dalam alur Anda

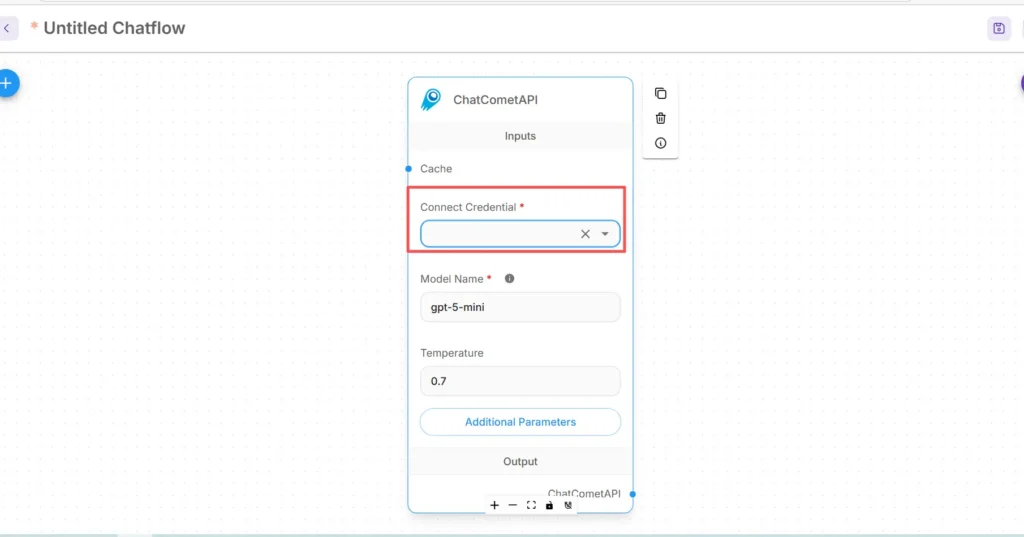

- Tarik ChatCometAPI Node ke ruang kerja Anda. Node ini menampilkan pemilihan model, suhu, token maksimum, dan parameter inferensi lainnya.

- Letakkan sebuah Mulai/Masukan node (atau node fronting chatbot Anda) di hulu node CometAPI.

Langkah 3 — Konfigurasikan kredensial untuk CometAPI

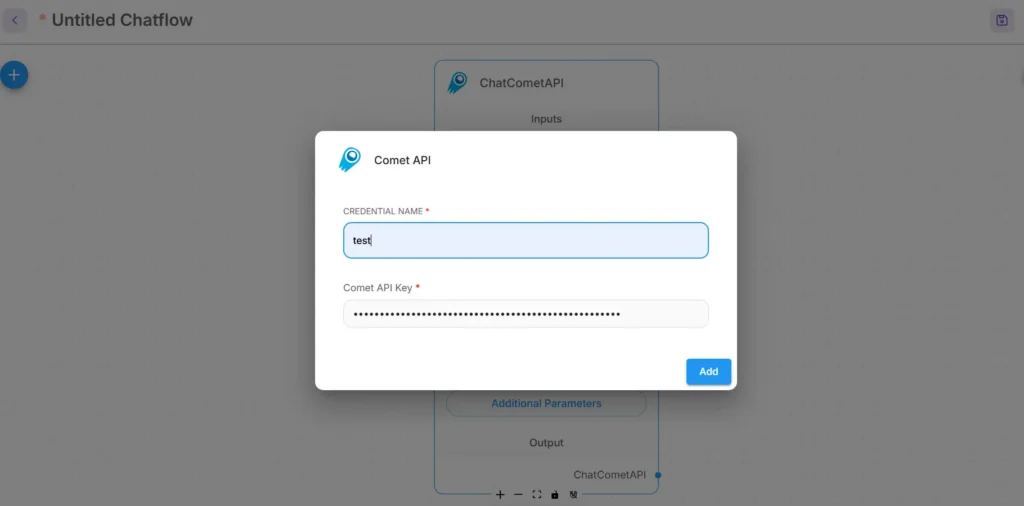

- Di menu tarik-turun Hubungkan Kredensial dari node CometAPI, pilih Buat Baru dan temukan Kunci API / Surat kepercayaan lapangan.(Dalam Flowise, atau terbuka Surat kepercayaan)

- Masukkan Kunci API CometAPI (sebaiknya melalui pengelola kredensial Flowise atau sebagai variabel lingkungan). Pada produksi, gunakan manajemen rahasia

- Pilih model dasar default (atau biarkan dapat disesuaikan dari input node jika Anda ingin peralihan model runtime). CometAPI biasanya menerima

modelparameter yang menunjukkan vendor/model mana yang akan digunakan.

Langkah 4 — Tetapkan Jalur Dasar dan parameter tambahan.

Dalam pengaturan node ChatCometAPI perluas Parameter tambahan dan mengatur Jalur Dasar untuk https://api.cometapi.com/v1/ (ini diperlukan agar node mengarah ke gateway CometAPI v1). Anda dapat menyesuaikan nama model default atau parameter penyedia yang didukung oleh CometAPI secara opsional.

Tip mengatasi masalah:

- Jika panggilan gagal, periksa keluar jaringan dan aturan firewall/NAT antara titik akhir Flowise dan CometAPI.

- Periksa batas kecepatan dan respons kesalahan yang dikembalikan oleh CometAPI; terapkan kemunduran eksponensial pada 429/5xx.

Bagaimana cara menambahkan simpul Prompt dan mengatur rantai LLM di Flowise?

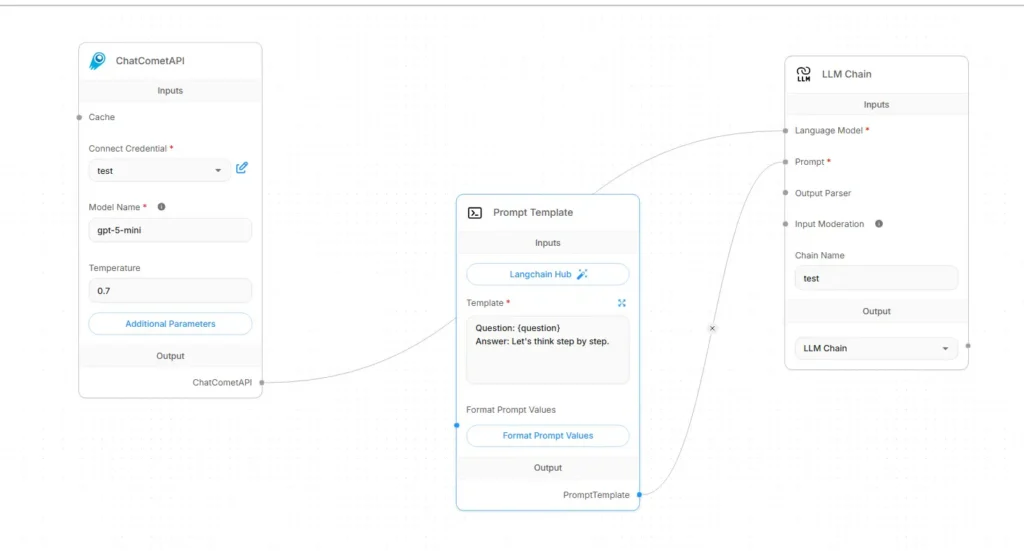

Aliran LLM Flowise biasanya dirakit sebagai Input → Template Prompt → Rantai LLM → OutputBerikut resep pengkabelan konkret menggunakan CometAPI sebagai model bahasanya:

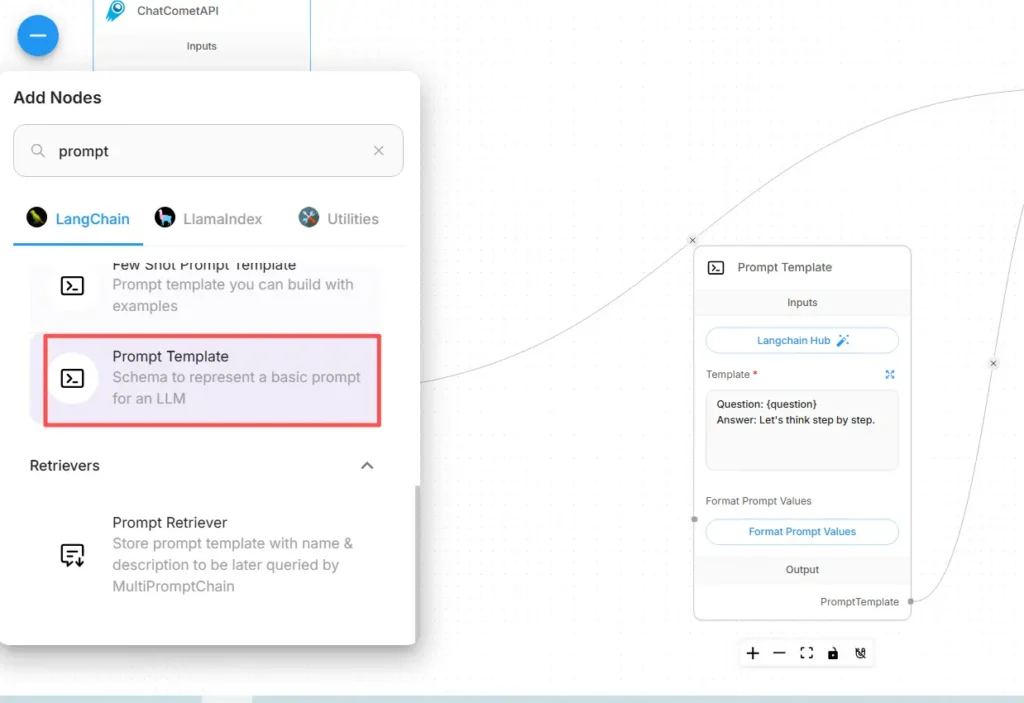

Langkah A — Buat simpul Template Prompt

- Tambahkan Templat Permintaan node (atau node “Prompt”) ke kanvas.

- Pada node Prompt, buat templat Anda menggunakan variabel untuk konten dinamis, misalnya:

You are an expert SRE. Given the following user question: {{user_input}}

Produce a step-by-step diagnostic plan and concise summary.

- Membuka

user_inputsebagai variabel yang akan diisi dari simpul Mulai/Input.

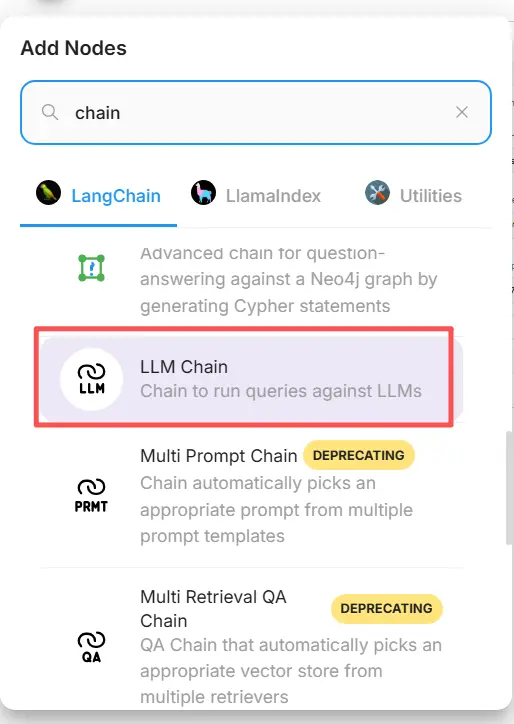

Langkah B — Tambahkan simpul Rantai LLM (pembungkus LLM)

Tambahkan sebuah Rantai LLM or LLM simpul yang merepresentasikan prompt → pemanggilan model. Di Flowise, simpul Rantai LLM biasanya memiliki dua masukan utama: Model Bahasa (simpul model/inferensi) dan Cepat (templat perintah).

Langkah C — Hubungkan node (pengkabelan eksplisit)

- Hubungkan node CometAPI ke Rantai LLM Model Bahasa memasukkan.

Ini memberi tahu rantai model mana yang harus dipanggil untuk pembangkitan. (CometAPI menjadi penyedia model.) - Hubungkan simpul Template Prompt ke Rantai LLM Cepat memasukkan.

Rantai akan menggabungkan templat perintah dengan nilai variabel dan mengirimkan perintah yang dihasilkan ke CometAPI. - Hubungkan simpul Start/Input ke Template Prompt

user_inputvariabel. - Hubungkan keluaran Rantai LLM ke simpul Keluaran (respons UI atau alat hilir).

Secara visual alurnya harus terbaca:

Start/Input → Prompt Template → LLM Chain (Language Model = CometAPI node) → Output

Langkah D — Uji coba secara kering

- Jalankan alur di konsol pengujian Flowise. Periksa prompt yang dikirim ke CometAPI, token respons, dan latensi. Sesuaikan suhu, token maks, atau top-p di pengaturan node CometAPI untuk menyesuaikan kreativitas vs. determinisme.

Apa saja kasus penggunaan praktis yang dimungkinkan oleh integrasi ini?

Berikut ini adalah beberapa kasus penggunaan yang kuat di mana Flowise + CometAPI memberikan manfaat nyata:

1) Perutean multi-model / pemilihan alat terbaik

Bangun alur yang memilih model per subtugas: peringkasan cepat dengan model berbiaya rendah, landasan faktual dengan model akurasi tinggi, dan pembuatan gambar melalui model gambar — semua melalui parameter CometAPI tanpa mengubah kabel Flowise.

2) Pengujian dan evaluasi model A/B

Jalankan dua Rantai LLM paralel di Flowise (A vs. B), rutekan prompt yang sama ke berbagai pilihan model CometAPI, dan masukkan hasilnya ke node pembanding kecil yang menilai keluaran. Gunakan metrik untuk memutuskan model mana yang akan diadopsi.

3) RAG Hibrida (Retriever + LLM)

Gunakan penyimpanan dokumen dan pengambil vektor Flowise untuk mengumpulkan konteks, lalu kirim templat perintah gabungan ke model CometAPI. API terpadu ini menyederhanakan pertukaran LLM yang digunakan untuk sintesis akhir.

4) Perkakas agen (API, DB, kode)

Alat Compose (HTTP GET/POST, panggilan DB) di dalam agen Flowise, gunakan CometAPI untuk penalaran bahasa dan pemilihan tindakan, serta rutekan output ke konektor/alat. Flowise mendukung alat permintaan dan pola agen untuk hal ini.

Mulai

CometAPI adalah platform API terpadu yang menggabungkan lebih dari 500 model AI dari penyedia terkemuka—seperti seri GPT OpenAI, Gemini Google, Claude Anthropic, Midjourney, Suno, dan lainnya—menjadi satu antarmuka yang ramah bagi pengembang. Dengan menawarkan autentikasi yang konsisten, pemformatan permintaan, dan penanganan respons, CometAPI secara drastis menyederhanakan integrasi kapabilitas AI ke dalam aplikasi Anda. Baik Anda sedang membangun chatbot, generator gambar, komposer musik, atau alur kerja analitik berbasis data, CometAPI memungkinkan Anda melakukan iterasi lebih cepat, mengendalikan biaya, dan tetap tidak bergantung pada vendor—semuanya sambil memanfaatkan terobosan terbaru di seluruh ekosistem AI.

Untuk memulai, jelajahi kemampuan model di tempat bermain dan konsultasikan dengan Flowise Panduan API untuk petunjuk terperinci. Sebelum mengakses, pastikan Anda telah masuk ke CometAPI dan memperoleh kunci API. API Komet menawarkan harga yang jauh lebih rendah dari harga resmi untuk membantu Anda berintegrasi.

Siap untuk berangkat?→ Daftar ke CometAPI hari ini !

Rekomendasi akhir dan rangkuman

Mengintegrasikan Flowise dengan CometAPI adalah cara pragmatis untuk menggabungkan orkestrasi visual yang cepat (Flowise) dengan akses fleksibel ke berbagai penyedia model (CometAPI). Pola ini—menyimpan perintah sebagai templat, memisahkan node model, dan menjalankan instrumen dengan hati-hati—memungkinkan tim melakukan iterasi dengan cepat dan beralih penyedia tanpa menulis ulang alur. Ingatlah untuk mengelola kredensial dengan aman, memperhitungkan latensi dan biaya, serta menginstrumentasikan alur Anda untuk observabilitas dan tata kelola.