Pada tanggal 19–20 November 2025, OpenAI merilis dua pembaruan yang terkait tetapi berbeda: GPT-5.1-Codex-Max, model pengkodean agen baru untuk Codex yang menekankan pengkodean cakrawala panjang, efisiensi token, dan “pemadatan” untuk mempertahankan sesi multi-jendela; dan GPT-5.1 Pro, model ChatGPT Pro-tier yang diperbarui untuk memberikan jawaban yang lebih jelas dan mumpuni dalam pekerjaan yang kompleks dan profesional.

Apa itu GPT-5.1-Codex-Max dan masalah apa yang coba dipecahkannya?

GPT-5.1-Codex-Max adalah model Codex khusus dari OpenAI yang disesuaikan untuk alur kerja pengkodean yang memerlukan penalaran dan eksekusi yang berkelanjutan dan berjangka panjang. Ketika model biasa dapat terhambat oleh konteks yang sangat panjang — misalnya, refaktor multi-file, loop agen yang kompleks, atau tugas CI/CD yang persisten — Codex-Max dirancang untuk secara otomatis memadatkan dan mengelola status sesi di beberapa jendela konteks, yang memungkinkannya untuk terus bekerja secara koheren sebagai satu proyek yang mencakup ribuan (atau lebih) token. OpenAI memposisikan Codex-Max sebagai langkah selanjutnya dalam menjadikan agen yang mampu membuat kode benar-benar bermanfaat untuk pekerjaan rekayasa yang lebih luas.

Apa itu GPT-5.1-Codex-Max dan masalah apa yang coba dipecahkannya?

GPT-5.1-Codex-Max adalah model Codex khusus dari OpenAI yang disesuaikan untuk alur kerja pengkodean yang memerlukan penalaran dan eksekusi yang berkelanjutan dan berjangka panjang. Ketika model biasa dapat terhambat oleh konteks yang sangat panjang — misalnya, refaktor multi-file, loop agen yang kompleks, atau tugas CI/CD yang persisten — Codex-Max dirancang untuk secara otomatis memadatkan dan mengelola status sesi di beberapa jendela konteks, yang memungkinkannya terus bekerja secara koheren sebagai satu proyek yang mencakup ribuan (atau lebih) token.

OpenAI menggambarkannya sebagai "lebih cepat, lebih cerdas, dan lebih hemat token di setiap tahap siklus pengembangan," dan secara eksplisit ditujukan untuk menggantikan GPT-5.1-Codex sebagai model default pada permukaan Codex.

Cuplikan fitur

- Pemadatan untuk kesinambungan multi-jendela: memangkas dan mempertahankan konteks penting agar bekerja secara koheren selama jutaan token dan jam. 0

- Peningkatan efisiensi token dibandingkan dengan GPT-5.1-Codex: hingga ~30% lebih sedikit token berpikir untuk upaya penalaran yang sama pada beberapa tolok ukur kode.

- Daya tahan agen jangka panjang: diamati secara internal untuk mempertahankan putaran agen multi-jam/multi-hari (OpenAI mendokumentasikan operasi internal >24 jam).

- Integrasi platform: tersedia hari ini di dalam Codex CLI, ekstensi IDE, cloud, dan alat peninjauan kode; akses API akan segera hadir.

- Dukungan lingkungan Windows: OpenAI secara khusus mencatat Windows didukung untuk pertama kalinya dalam alur kerja Codex, memperluas jangkauan pengembang di dunia nyata.

Bagaimana perbandingannya dengan produk pesaing (misalnya, GitHub Copilot, AI pengkodean lainnya)?

GPT-5.1-Codex-Max digadang-gadang sebagai kolaborator yang lebih otonom dan berjangka panjang dibandingkan dengan alat penyelesaian per permintaan. Meskipun Copilot dan asisten serupa unggul dalam penyelesaian jangka pendek di dalam editor, keunggulan Codex-Max terletak pada orkestrasi tugas-tugas multi-langkah, mempertahankan status yang koheren di seluruh sesi, dan menangani alur kerja yang memerlukan perencanaan, pengujian, dan iterasi. Meskipun demikian, pendekatan terbaik di sebagian besar tim adalah hibrida: gunakan Codex-Max untuk otomatisasi kompleks dan tugas agen berkelanjutan, serta gunakan asisten yang lebih ringan untuk penyelesaian tingkat baris.

Bagaimana cara kerja GPT-5.1-Codex-Max?

Apa yang dimaksud dengan “pemadatan” dan bagaimana cara kerjanya agar pekerjaan dapat berlangsung lama?

Kemajuan teknis yang penting adalah pemadatan—mekanisme internal yang memangkas riwayat sesi sambil mempertahankan bagian konteks yang menonjol sehingga model dapat melanjutkan pekerjaan yang koheren di seluruh beberapa Jendela konteks. Secara praktis, ini berarti sesi Codex yang mendekati batas konteksnya akan dipadatkan (token yang lebih lama atau bernilai lebih rendah diringkas/dipertahankan) sehingga agen memiliki jendela baru dan dapat terus melakukan iterasi berulang kali hingga tugas selesai. OpenAI melaporkan proses internal di mana model mengerjakan tugas secara terus-menerus selama lebih dari 24 jam.

Penalaran adaptif dan efisiensi token

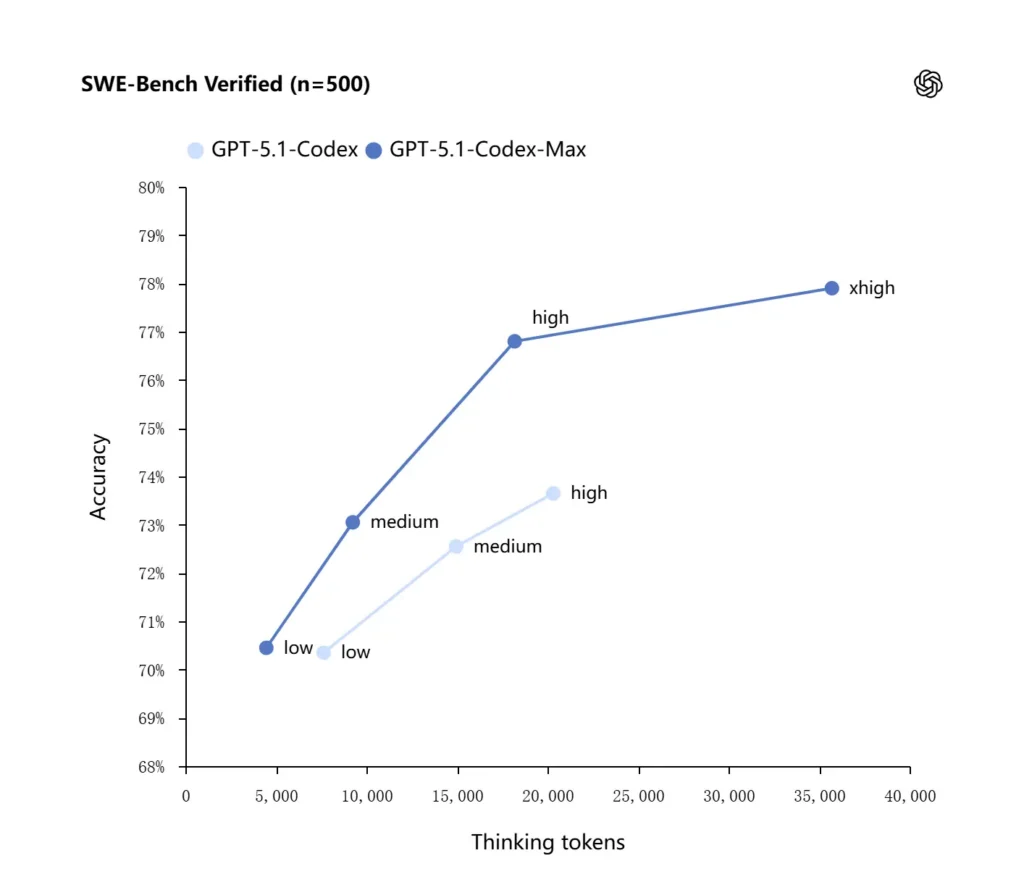

GPT-5.1-Codex-Max menerapkan strategi penalaran yang ditingkatkan yang membuatnya lebih efisien dalam token: dalam benchmark internal yang dilaporkan OpenAI, model Max mencapai kinerja yang serupa atau lebih baik daripada GPT-5.1-Codex dengan menggunakan token “berpikir” yang jauh lebih sedikit—OpenAI mengutip sekitar 30% lebih sedikit Token berpikir pada SWE-bench terverifikasi saat dijalankan dengan upaya penalaran yang sama. Model ini juga memperkenalkan mode upaya penalaran "Ekstra Tinggi (xhigh)" untuk tugas-tugas yang tidak sensitif terhadap latensi, yang memungkinkannya menggunakan lebih banyak penalaran internal untuk mendapatkan keluaran berkualitas lebih tinggi.

Integrasi sistem dan perkakas agen

Codex-Max didistribusikan dalam alur kerja Codex (CLI, ekstensi IDE, cloud, dan platform peninjauan kode) sehingga dapat berinteraksi dengan toolchain pengembang yang sebenarnya. Integrasi awal mencakup Codex CLI dan agen IDE (VS Code, JetBrains, dll.), dengan akses API yang direncanakan menyusul. Tujuan desainnya bukan hanya sintesis kode yang lebih cerdas, tetapi juga AI yang dapat menjalankan alur kerja multi-langkah: membuka berkas, menjalankan pengujian, memperbaiki kegagalan, melakukan refaktor, dan menjalankan ulang.

Bagaimana kinerja GPT-5.1-Codex-Max pada benchmark dan kerja nyata?

Penalaran berkelanjutan dan tugas jangka panjang

Evaluasi menunjukkan adanya peningkatan yang terukur dalam penalaran berkelanjutan dan tugas jangka panjang:

- Evaluasi internal OpenAICodex-Max dapat mengerjakan tugas selama "lebih dari 24 jam" dalam eksperimen internal dan integrasi Codex dengan perangkat pengembang meningkatkan metrik produktivitas rekayasa internal (misalnya, penggunaan dan throughput permintaan tarik). Ini adalah klaim internal OpenAI dan menunjukkan peningkatan produktivitas dunia nyata di tingkat tugas.

- Evaluasi independen (METR):Laporan independen METR mengukur diamati pada horizon waktu 50% (statistik yang mewakili waktu rata-rata model dapat secara koheren mempertahankan tugas yang panjang) untuk GPT-5.1-Codex-Max pada sekitar 2 40 jam menit (dengan interval kepercayaan yang lebar), meningkat dari 2 jam 17 menit GPT-5 dalam pengukuran yang sebanding — sebuah peningkatan yang signifikan sesuai tren dalam koherensi berkelanjutan. Metodologi dan CI METR menekankan variabilitas, tetapi hasilnya mendukung narasi bahwa Codex-Max meningkatkan kinerja praktis jangka panjang.

Tolok Ukur Kode

OpenAI melaporkan hasil yang lebih baik pada evaluasi pengkodean frontier, terutama pada SWE-bench Verified di mana GPT-5.1-Codex-Max mengungguli GPT-5.1-Codex dengan efisiensi token yang lebih baik. Perusahaan ini menyoroti bahwa untuk upaya penalaran "sedang" yang sama, model Max menghasilkan hasil yang lebih baik dengan menggunakan token berpikir sekitar 30% lebih sedikit; bagi pengguna yang memungkinkan penalaran internal yang lebih panjang, mode xhigh dapat lebih meningkatkan jawaban dengan mengorbankan latensi.

| GPT‑5.1-Codex (tinggi) | GPT‑5.1-Codex-Max (xhigh) | |

| SWE-bench Terverifikasi (n=500) | 73.7% | 77.9% |

| SWE-Lancer IC SWE | 66.3% | 79.9% |

| Terminal-Bangku 2.0 | 52.8% | 58.1% |

Bagaimana GPT-5.1-Codex-Max dibandingkan dengan GPT-5.1-Codex?

Perbedaan kinerja dan tujuan

- Cakupan: GPT-5.1-Codex adalah varian pengkodean berkinerja tinggi dari keluarga GPT-5.1; Kodeks-Max secara eksplisit merupakan penerus agenik berhorizon panjang yang dimaksudkan sebagai default yang direkomendasikan untuk Codex dan lingkungan serupa Codex.

- Efisiensi token: Codex-Max menunjukkan peningkatan efisiensi token material (klaim OpenAI tentang ~30% lebih sedikit token berpikir) di SWE-bench dan dalam penggunaan internal.

- Manajemen konteks: Codex-Max memperkenalkan pemadatan dan penanganan multi-jendela asli untuk mendukung tugas yang melampaui satu jendela konteks; Codex tidak menyediakan kemampuan ini secara asli pada skala yang sama.

- Kesiapan perkakas: Codex-Max dikirimkan sebagai model Codex default di seluruh CLI, IDE, dan permukaan tinjauan kode, menandakan migrasi untuk alur kerja pengembang produksi.

Kapan harus menggunakan model yang mana?

- Gunakan GPT-5.1-Codex untuk bantuan pengkodean interaktif, pengeditan cepat, perbaikan kecil, dan kasus penggunaan latensi rendah di mana seluruh konteks relevan dapat dengan mudah dimuat dalam satu jendela.

- Gunakan GPT-5.1-Codex-Max untuk refaktor multi-file, tugas agen otomatis yang memerlukan banyak siklus iterasi, alur kerja mirip CI/CD, atau saat Anda memerlukan model untuk menyimpan perspektif tingkat proyek di banyak interaksi.

Pola petunjuk praktis dan contoh untuk hasil terbaik?

Pola dorongan yang bekerja dengan baik

- Jelaskan tujuan dan batasannya secara eksplisit: “Refaktor X, pertahankan API publik, pertahankan nama fungsi, dan pastikan pengujian A, B, C lulus.”

- Berikan konteks minimal yang dapat direproduksi: tautan ke pengujian yang gagal, sertakan jejak tumpukan, dan cuplikan berkas yang relevan, alih-alih membuang seluruh repositori. Codex-Max akan memadatkan riwayat sesuai kebutuhan.

- Gunakan petunjuk bertahap untuk tugas yang rumit: memecah pekerjaan besar menjadi serangkaian subtugas, dan membiarkan Codex-Max mengulanginya (misalnya, “1) menjalankan pengujian 2) memperbaiki 3 pengujian yang gagal 3) menjalankan linter 4) meringkas perubahan”).

- Minta penjelasan dan perbedaan: meminta patch dan alasan singkat sehingga peninjau manusia dapat dengan cepat menilai keamanan dan maksudnya.

Contoh template perintah

Tugas refaktor

“Memperbaiki

payment/modul untuk mengekstrak pemrosesan pembayaran ke dalampayment/processor.pyJaga agar tanda tangan fungsi publik tetap stabil untuk pemanggil yang ada. Buat pengujian unit untukprocess_payment()yang mencakup keberhasilan, kegagalan jaringan, dan kartu tidak valid. Jalankan rangkaian pengujian dan kembalikan pengujian yang gagal beserta patch dalam format diff terpadu.

Perbaikan bug + pengujian

“Sebuah ujian

tests/test_user_auth.py::test_token_refreshgagal dengan traceback . Selidiki akar permasalahannya, usulkan perbaikan dengan perubahan minimal, dan tambahkan uji unit untuk mencegah regresi. Terapkan patch dan jalankan pengujian.

Pembuatan PR berulang

“Implementasi fitur X: tambahkan titik akhir

POST /api/exportyang mengalirkan hasil ekspor dan diautentikasi. Buat titik akhir, tambahkan dokumen, buat pengujian, dan buka PR dengan ringkasan dan daftar periksa item manual.

Untuk sebagian besarnya, mulailah dengan medium usaha; beralih ke xtinggi ketika Anda memerlukan model untuk melakukan penalaran mendalam pada banyak file dan beberapa iterasi pengujian.

Bagaimana cara mengakses GPT-5.1-Codex-Max

Dimana tersedia saat ini

OpenAI telah mengintegrasikan GPT-5.1-Codex-Max ke dalam Peralatan Codex Hari ini: Codex CLI, ekstensi IDE, cloud, dan alur peninjauan kode menggunakan Codex-Max secara default (Anda dapat memilih Codex-Mini). Ketersediaan API akan segera disiapkan; GitHub Copilot memiliki pratinjau publik yang mencakup model GPT-5.1 dan seri Codex.

Pengembang dapat mengakses GPT-5.1-Codex-Max dan API Kodeks GPT-5.1 melalui CometAPI. Untuk memulai, jelajahi kemampuan modelAPI Komet dalam tempat bermain dan lihat panduan API untuk instruksi detail. Sebelum mengakses, pastikan Anda telah masuk ke CometAPI dan mendapatkan kunci API. cometAPI menawarkan harga yang jauh lebih rendah dari harga resmi untuk membantu Anda berintegrasi.

Siap untuk berangkat?→ Daftar ke CometAPI hari ini !

Jika Anda ingin mengetahui lebih banyak tips, panduan, dan berita tentang AI, ikuti kami di VK, X dan Discord!

Mulai cepat (langkah praktis demi langkah)

- Pastikan Anda memiliki akses: konfirmasikan paket produk ChatGPT/Codex Anda (Plus, Pro, Business, Edu, Enterprise) atau paket API pengembang Anda mendukung model keluarga GPT-5.1/Codex.

- Instal Codex CLI atau ekstensi IDE: Jika Anda ingin menjalankan tugas kode secara lokal, instal Codex CLI atau ekstensi Codex IDE untuk VS Code/JetBrains/Xcode sesuai kebutuhan. Pengaturan default untuk tool ini adalah GPT-5.1-Codex-Max pada konfigurasi yang didukung.

- Pilih upaya penalaran: dimulai dari medium upaya untuk sebagian besar tugas. Untuk debugging mendalam, refaktor kompleks, atau ketika Anda ingin model berpikir lebih keras dan Anda tidak peduli dengan latensi respons, beralihlah ke tinggi or xtinggi mode. Untuk perbaikan kecil yang cepat, rendah adalah wajar.

- Berikan konteks repositori: Berikan model titik awal yang jelas — URL repo atau sekumpulan berkas dan instruksi singkat (misalnya, "refaktor modul pembayaran untuk menggunakan I/O asinkron dan menambahkan pengujian unit, mempertahankan kontrak tingkat fungsi"). Codex-Max akan memadatkan riwayat saat mendekati batas konteks dan melanjutkan pekerjaan.

- Ulangi dengan pengujian: Setelah model menghasilkan patch, jalankan rangkaian pengujian dan berikan umpan balik kegagalan sebagai bagian dari sesi yang sedang berlangsung. Pemadatan dan kontinuitas multi-jendela memungkinkan Codex-Max mempertahankan konteks pengujian penting yang gagal dan melakukan iterasi.

Kesimpulan:

GPT-5.1-Codex-Max merupakan langkah substansial menuju asisten pengkodean agen yang dapat mendukung tugas-tugas rekayasa yang kompleks dan berjangka panjang dengan efisiensi dan penalaran yang lebih baik. Kemajuan teknisnya (pemadatan, mode upaya penalaran, pelatihan lingkungan Windows) membuatnya sangat cocok untuk organisasi rekayasa modern — asalkan tim memadukan model tersebut dengan kontrol operasional yang konservatif, kebijakan yang jelas tentang keterlibatan manusia, dan pemantauan yang andal. Bagi tim yang mengadopsinya dengan cermat, Codex-Max berpotensi mengubah cara perangkat lunak dirancang, diuji, dan dipelihara — mengubah pekerjaan rekayasa yang repetitif menjadi kolaborasi yang bernilai lebih tinggi antara manusia dan model.