L'Intelligenza Artificiale (IA) ha rivoluzionato numerosi settori e una delle sue applicazioni più interessanti riguarda la generazione di immagini. Dalla creazione di volti umani realistici alla produzione di opere d'arte surreali, la capacità di generare immagini tramite l'IA ha aperto nuove strade nell'arte, nel design e nella tecnologia. Questo articolo approfondisce i meccanismi alla base delle immagini generate dall'IA, i modelli che le alimentano e le implicazioni più ampie di questa tecnologia.

Nozioni di base: come funziona la generazione di immagini tramite intelligenza artificiale?

Cosa sono i modelli generativi?

I modelli generativi sono una classe di algoritmi di intelligenza artificiale in grado di creare nuove istanze di dati simili ai dati di training. Nel contesto della generazione di immagini, questi modelli apprendono pattern da immagini esistenti e utilizzano questa conoscenza per produrre nuove immagini simili.

Il ruolo delle reti neurali

Al centro della generazione di immagini tramite intelligenza artificiale ci sono le reti neurali, in particolare modelli di deep learning come le reti neurali convoluzionali (CNN). Le CNN sono progettate per elaborare i dati con una topologia a griglia, rendendole ideali per l'analisi e la generazione di immagini. Funzionano rilevando pattern come bordi, texture e forme, essenziali per la comprensione e la ricostruzione delle immagini.

Modelli di intelligenza artificiale chiave nella generazione di immagini di intelligenza artificiale

Generative Adversarial Networks (GAN)

Introdotte da Ian Goodfellow nel 2014, le reti neurali di tipo GAN sono costituite da due reti neurali: un generatore e un discriminatore. Il generatore crea immagini, mentre il discriminatore le confronta con immagini reali. Attraverso questo processo antagonistico, il generatore migliora il suo output per produrre immagini sempre più realistiche.

StileGAN

Sviluppato da NVIDIA, StyleGAN è una variante di GAN nota per la generazione di volti umani di alta qualità. Introduce un'architettura di generazione basata su stili, che consente il controllo su diversi livelli di dettaglio nell'immagine. StyleGAN2 e StyleGAN3 hanno ulteriormente migliorato la qualità dell'immagine e risolto problemi come il "texture sticking".

Modelli di diffusione

I modelli di diffusione generano immagini partendo da rumore casuale e perfezionandolo gradualmente per ottenere il risultato desiderato. Hanno guadagnato popolarità grazie alla loro capacità di produrre immagini di alta qualità e alla loro flessibilità in diverse applicazioni.

Diffusione stabile

Stable Diffusion è un modello di diffusione open source che consente la generazione di testo in immagini. Può anche eseguire operazioni di inpainting e outpainting, consentendo l'editing e l'estensione delle immagini. La sua natura open source lo ha reso ampiamente accessibile a sviluppatori e artisti.

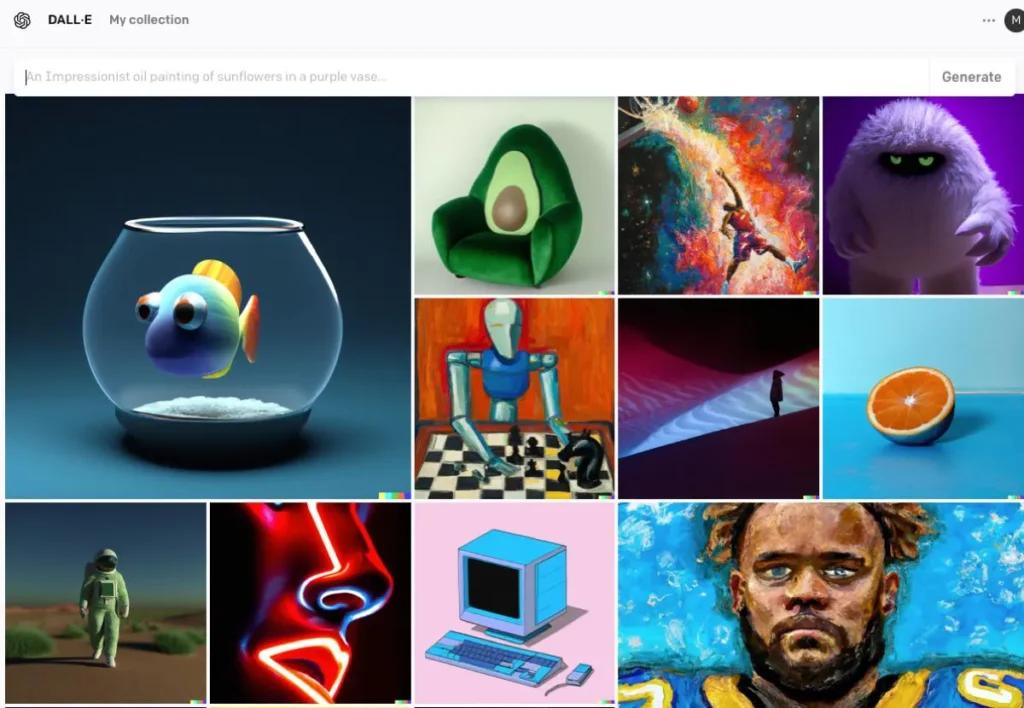

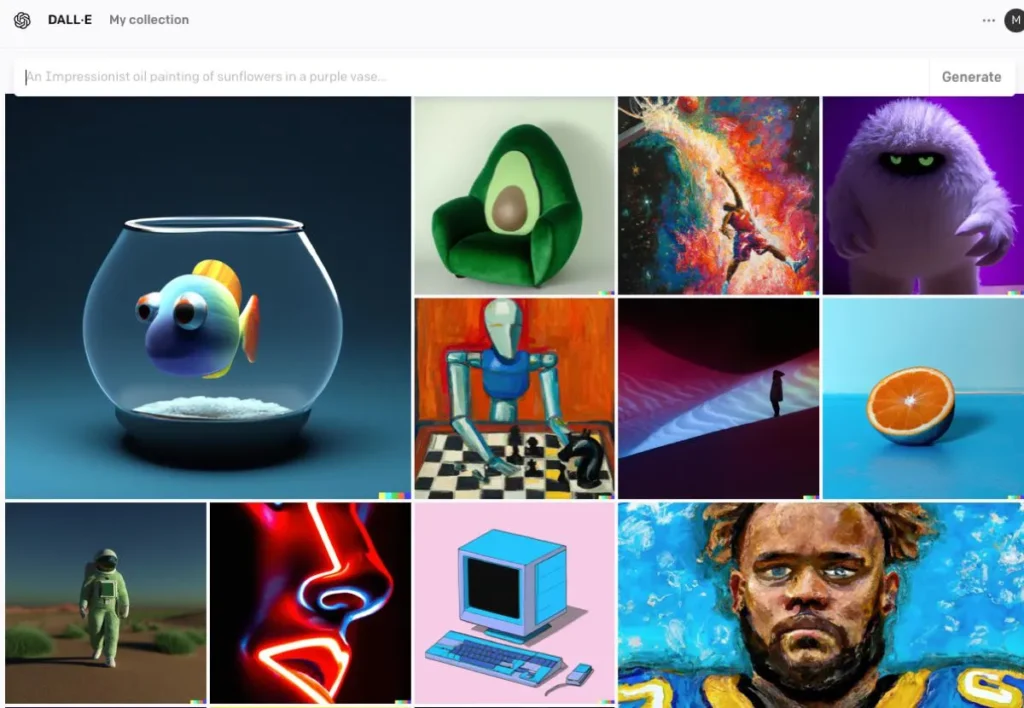

DALL · E

Sviluppato da OpenAI, DALL·E è un modello basato su trasformatori in grado di generare immagini da descrizioni testuali. DALL·E 2 e DALL·E 3 hanno migliorato l'originale, offrendo una risoluzione più elevata e un allineamento immagine-testo più accurato. DALL·E 3 è integrato in ChatGPT per una migliore interazione con l'utente.

Il processo di generazione di immagini AI

Formazione del modello

I modelli di intelligenza artificiale richiedono un addestramento approfondito su grandi set di dati di immagini. Durante l'addestramento, il modello impara a riconoscere pattern e caratteristiche all'interno delle immagini, il che gli consente di generare nuove immagini che imitano i dati di addestramento.

Generazione di nuove immagini

Una volta addestrato, il modello può generare nuove immagini tramite:

- Ricezione dell'input: Potrebbe trattarsi di rumore casuale (nelle reti GAN), di un prompt di testo (in DALL·E) o di un'immagine esistente (da modificare). Questa fase cattura il significato semantico del testo, consentendo all'IA di comprenderne il contenuto e il contesto.

- Elaborazione dell'input: Il modello elabora l'input attraverso i suoi livelli di rete neurale, applicando pattern e caratteristiche apprese. Utilizzando il testo codificato, l'IA impiega modelli come le reti generative avversarie (GAN) o i modelli di diffusione per creare immagini. Questi modelli generano immagini partendo da rumore casuale e perfezionandolo per adattarlo alla descrizione testuale.

- Perfezionamento e valutazione: L'immagine generata viene quindi perfezionata utilizzando meccanismi di attenzione per garantirne la coerenza con il testo. Un modello discriminante valuta il realismo dell'immagine e la coerenza con l'input, fornendo feedback per ulteriori perfezionamenti.

- Immagine in uscita: L'output finale è una nuova immagine che riflette le caratteristiche dei dati di addestramento e l'input specifico fornito.

Esempio di codice di generazione di immagini AI

Ecco alcuni esempi pratici di codice Python che dimostrano come generare immagini utilizzando tre importanti modelli di intelligenza artificiale: reti generative avversarie (GAN), diffusione stabile e DALL·E.

Reti generative avversarie (GAN) con PyTorch

Le reti generative avversarie (GAN) sono costituite da due reti neurali, il generatore e il discriminatore, che competono tra loro per generare nuove istanze di dati realistiche. Ecco un esempio semplificato che utilizza PyTorch per generare immagini:

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

Questo codice definisce una semplice rete di generatori che accetta un vettore di rumore a 100 dimensioni come input e produce un output a 784 dimensioni, che può essere rimodellato in un'immagine 28×28. tanh la funzione di attivazione garantisce che i valori di output siano compresi nell'intervallo , il che è comune per i dati di immagine.

Diffusione stabile con diffusori avvolgenti

Diffusione Stabile è un potente modello testo-immagine che genera immagini basate su descrizioni testuali. Il Volto Abbracciante diffusers la libreria fornisce un'interfaccia semplice per utilizzare questo modello:

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

Questo script carica il modello Stable Diffusion e genera un'immagine in base al prompt fornito. Assicurarsi di aver installato le dipendenze necessarie e di avere una GPU compatibile per prestazioni ottimali.

DALL·E con API OpenAI

DALL·E è un altro modello di conversione testo-immagine sviluppato da OpenAI. È possibile interagire con esso utilizzando l'API di OpenAI:

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

sostituire "your-api-key" Con la tua chiave API OpenAI effettiva. Questo script invia un prompt al modello DALL·E e recupera l'immagine generata. L'immagine viene quindi salvata localmente.

CometAPI integra anche API DALL-E3, puoi anche usare la chiave di CometAPI per accedere API DALL-E3, che è più comodo e veloce di OpenAI.

Per ulteriori informazioni sul modello in Comet API, vedere Documento API.

Questi esempi forniscono un punto di partenza per generare immagini utilizzando diversi modelli di intelligenza artificiale. Ogni modello ha le sue capacità e i suoi requisiti unici, quindi scegli quello più adatto alle esigenze del tuo progetto.

Conclusione

La generazione di immagini tramite intelligenza artificiale si colloca all'intersezione tra tecnologia e creatività, offrendo possibilità senza precedenti nella creazione di contenuti visivi. Comprendere come l'intelligenza artificiale genera le immagini, i modelli coinvolti e le implicazioni di questa tecnologia è essenziale per la sua integrazione in vari aspetti della società.

Accedi all'API delle immagini AI in CometAPI

CometAPI offre accesso a oltre 500 modelli di intelligenza artificiale, inclusi modelli multimodali open source e specializzati per chat, immagini, codice e altro ancora. Il suo punto di forza principale risiede nella semplificazione del processo di integrazione dell'intelligenza artificiale, tradizionalmente complesso. Grazie a CometAPI, l'accesso ai principali strumenti di intelligenza artificiale come Claude, OpenAI, Deepseek e Gemini è disponibile tramite un unico abbonamento unificato. È possibile utilizzare l'API di CometAPI per creare musica e grafica, generare video e creare flussi di lavoro personalizzati.

CometaAPI offrire un prezzo molto più basso del prezzo ufficiale per aiutarti a integrare API GPT-4o ,API di metà viaggio API di diffusione stabile (API di diffusione stabile XL 1.0) e Flux API (API FLUX.1 ecc.) e riceverai 1$ sul tuo account dopo esserti registrato e aver effettuato l'accesso!

CometAPI integra l'ultima API dell'immagine GPT-4o .