Negli ultimi mesi si è assistito a una rapida crescita della codifica agentica: modelli specialistici che non si limitano a rispondere a richieste una tantum, ma pianificano, modificano, testano e iterano su interi repository. Due dei partecipanti di più alto profilo sono Compositore, un modello di codifica a bassa latenza appositamente creato introdotto da Cursor con la sua versione Cursor 2.0, e Codice GPT-5, la variante di GPT-5 ottimizzata per agenti di OpenAI, ottimizzata per flussi di lavoro di codifica prolungati. Insieme, illustrano le nuove linee di demarcazione negli strumenti di sviluppo: velocità vs. profondità, consapevolezza dell'area di lavoro locale vs. ragionamento generalista, e praticità del "vibe-coding" vs. rigore ingegneristico.

In sintesi: distinzioni testa a testa

- Intento progettuale: GPT-5-Codex: ragionamento approfondito e agente e robustezza per sessioni lunghe e complesse; Composer: iterazione rapida e ottimizzata per la velocità, in base allo spazio di lavoro.

- Superficie di integrazione primaria: GPT-5-Codex — API di prodotto/risposte Codex, IDE, integrazioni aziendali; Composer — Editor Cursor e interfaccia utente multi-agente di Cursor.

- Latenza/iterazione: Composer sottolinea l'importanza delle svolte in meno di 30 secondi e rivendica grandi vantaggi in termini di velocità; GPT-5-Codex privilegia la completezza e le corse autonome di più ore, ove necessario.

Ho testato il API GPT-5-Codex modello fornito da CometaAPI (un fornitore di aggregazione API di terze parti, i cui prezzi API sono generalmente più bassi di quelli ufficiali), ha riassunto la mia esperienza nell'utilizzo del modello Composer di Cursor 2.0 e ha confrontato i due in varie dimensioni del giudizio sulla generazione del codice.

Cosa sono Composer e GPT-5-Codex

Che cos'è il GPT-5-Codex e quali problemi si propone di risolvere?

Il GPT-5-Codex di OpenAI è uno snapshot specializzato di GPT-5 che, secondo OpenAI, è ottimizzato per scenari di codifica agentica: esecuzione di test, modifiche al codice su scala di repository e iterazione autonoma fino al superamento dei controlli. L'attenzione è rivolta a un'ampia capacità in molte attività ingegneristiche: ragionamento approfondito per refactoring complessi, operazioni "agentiche" a lungo termine (in cui il modello può dedicare minuti o ore a ragionamento e test) e prestazioni più elevate su benchmark standardizzati progettati per riflettere problemi ingegneristici reali.

Che cos'è Composer e quali problemi si propone di risolvere?

Composer è il primo modello di codifica nativo di Cursor, introdotto con Cursor 2.0. Cursor descrive Composer come un modello di frontiera, incentrato sugli agenti, progettato per bassa latenza e iterazioni rapide all'interno dei flussi di lavoro degli sviluppatori: pianificazione di diff multi-file, applicazione di ricerche semantiche a livello di repository e completamento della maggior parte dei turni in meno di 30 secondi. È stato addestrato con accesso agli strumenti nel ciclo (ricerca, modifica, test harness) per essere efficiente nelle attività di ingegneria pratica e ridurre al minimo l'attrito dei ripetuti cicli prompt→risposta nella codifica quotidiana. Cursor posiziona Composer come un modello ottimizzato per la velocità degli sviluppatori e i cicli di feedback in tempo reale.

Ambito del modello e comportamento in fase di esecuzione

- Compositore: Ottimizzato per interazioni rapide e incentrate sull'editor e per la coerenza multi-file. L'integrazione a livello di piattaforma di Cursor consente a Composer di visualizzare una parte maggiore del repository e di partecipare all'orchestrazione multi-agente (ad esempio, due agenti Composer rispetto ad altri), il che, secondo Cursor, riduce le dipendenze mancanti tra i file.

- Codice GPT-5: Ottimizzato per ragionamenti più approfonditi e di lunghezza variabile. OpenAI pubblicizza la capacità del modello di scambiare tempo/calcolo per ragionamenti più approfonditi quando necessario, con tempi che vanno da pochi secondi per attività leggere fino a ore per esecuzioni autonome estese, consentendo refactoring più approfonditi e debug guidati dai test.

Versione breve: Composer = modello di codifica integrato in IDE di Cursor, basato sullo spazio di lavoro; GPT-5-Codex = variante GPT-5 specializzata di OpenAI per l'ingegneria del software, disponibile tramite Responses/Codex.

Qual è il confronto tra Composer e GPT-5-Codex in termini di velocità?

Cosa hanno affermato i venditori?

Cursor posiziona Composer come un programmatore "fast frontier": i numeri pubblicati evidenziano una produttività di generazione misurata in token al secondo e affermazioni di tempi di completamento interattivo 2-4 volte più rapidi rispetto ai modelli "di frontiera" nell'architettura interna di Cursor. Una copertura indipendente (stampa e primi tester) riporta che Composer produce codice a circa 200-250 token al secondo nell'ambiente di Cursor e completa i tipici turni di codifica interattiva in meno di 30 secondi in molti casi.

Il GPT-5-Codex di OpenAI non è considerato un esperimento di latenza; dà priorità alla robustezza e a un ragionamento più approfondito e, su carichi di lavoro ad alto ragionamento comparabili, può essere più lento se utilizzato con dimensioni di contesto più elevate, secondo i report della community e i thread dei problemi.

Come abbiamo misurato la velocità (metodologia)

Per produrre un confronto di velocità equo è necessario controllare il tipo di attività (completamenti brevi rispetto a ragionamenti lunghi), l'ambiente (latenza di rete, integrazione locale rispetto a cloud) e misurare entrambi tempo per il primo risultato utile e al orologio da parete end-to-end (inclusi eventuali passaggi di esecuzione dei test o di compilazione). Punti chiave:

- Compiti scelti — generazione di piccoli frammenti (implementazione di un endpoint API), attività di media entità (refactoring di un file e aggiornamento delle importazioni), attività di grandi dimensioni (implementazione di funzionalità su tre file, aggiornamento dei test).

- Metrica — tempo fino al primo token, tempo fino alla prima differenza utile (tempo fino all'emissione della patch candidata) e tempo totale, inclusa l'esecuzione del test e la verifica.

- Ripetizioni — ogni attività viene eseguita 10 volte, la mediana viene utilizzata per ridurre il rumore di rete.

- Ambiente — misurazioni effettuate da una macchina per sviluppatori a Tokyo (per riflettere la latenza reale) con collegamento stabile a 100/10 Mbps; i risultati possono variare a seconda della regione.

Di seguito è riportato un esempio riproducibile imbracatura di velocità per GPT-5-Codex (Responses API) e una descrizione di come misurare Composer (all'interno di Cursor).

Speed harness (Node.js) — GPT-5-Codex (API delle risposte):

// node speed_harness_gpt5_codex.js

// Requires: node16+, npm install node-fetch

import fetch from "node-fetch";

import { performance } from "perf_hooks";

const API_KEY = process.env.OPENAI_API_KEY; // set your key

const ENDPOINT = "https://api.openai.com/v1/responses"; // OpenAI Responses API

const MODEL = "gpt-5-codex";

async function runPrompt(prompt) {

const start = performance.now();

const body = {

model: MODEL,

input: prompt,

// small length to simulate short interactive tasks

max_output_tokens: 256,

};

const resp = await fetch(ENDPOINT, {

method: "POST",

headers: {

"Authorization": `Bearer ${API_KEY}`,

"Content-Type": "application/json"

},

body: JSON.stringify(body)

});

const json = await resp.json();

const elapsed = performance.now() - start;

return { elapsed, output: json };

}

(async () => {

const prompt = "Implement a Node.js Express route POST /signup that validates email and stores user in-memory with hashed password (bcrypt). Return code only.";

const trials = 10;

for (let i=0;i<trials;i++){

const r = await runPrompt(prompt);

console.log(`trial ${i+1}: ${Math.round(r.elapsed)} ms`);

}

})();

Questa misura la latenza delle richieste end-to-end per GPT-5-Codex utilizzando l'API pubblica Responses (la documentazione di OpenAI descrive l'API Responses e l'utilizzo del modello gpt-5-codex).

Come misurare la velocità del Composer (Cursore):

Composer viene eseguito all'interno di Cursor 2.0 (fork desktop/VS Code). Cursor (al momento della stesura) non fornisce un'API HTTP esterna generale per Composer che corrisponda all'API di risposta di OpenAI; il punto di forza di Composer è integrazione in-IDE dello spazio di lavoro con statoPertanto, misura Composer come farebbe uno sviluppatore umano:

- Aprire lo stesso progetto all'interno di Cursor 2.0.

- Utilizzare Composer per eseguire lo stesso prompt di un'attività agente (creare un percorso, effettuare il refactoring, modificare più file).

- Avvia un cronometro quando invii il piano Composer; fermati quando Composer emette la differenza atomica ed esegue la suite di test (l'interfaccia di Cursor può eseguire test e mostrare una differenza consolidata).

- Ripeti 10 volte e usa la mediana.

I materiali pubblicati da Cursor e le revisioni pratiche mostrano che Composer completa molte attività comuni in meno di 30 secondi nella pratica; si tratta di un obiettivo di latenza interattiva piuttosto che di un tempo di inferenza del modello grezzo.

Takeaway: L'obiettivo di progettazione di Composer è la rapida modifica interattiva all'interno di un editor; se la priorità sono i cicli di codifica conversazionali a bassa latenza, Composer è progettato per questo caso d'uso. GPT-5-Codex è ottimizzato per la correttezza e il ragionamento agentico su sessioni più lunghe; può rinunciare a una latenza leggermente maggiore in cambio di una pianificazione più approfondita. I numeri dei fornitori supportano questo posizionamento.

Qual è il confronto tra Composer e GPT-5-Codex in termini di accuratezza?

Cosa significa accuratezza nella codifica dell'intelligenza artificiale

La precisione in questo caso è multiforme: correttezza funzionale (il codice viene compilato e supera i test), correttezza semantica (il comportamento soddisfa le specifiche) e robustezza (gestisce casi limite e problemi di sicurezza).

Numeri di fornitori e stampa

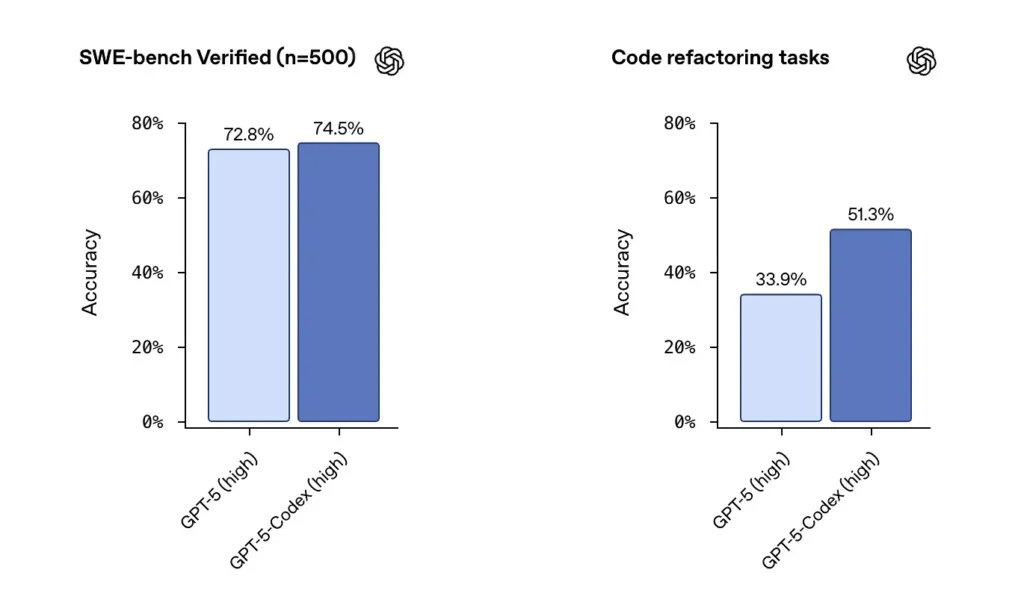

OpenAI segnala le ottime prestazioni di GPT-5-Codex sui set di dati verificati da SWE-bench e ha evidenziato un 74.5 tasso di successo% su un benchmark di codifica nel mondo reale (riportato nella rassegna stampa) e un notevole aumento del successo del refactoring (51.3% rispetto al 33.9% per GPT-5 di base sul loro test di refactoring interno).

La versione di Cursor indica che Composer eccelle spesso nelle modifiche multi-file e sensibili al contesto, dove l'integrazione dell'editor e la visibilità del repository sono importanti. Dopo i miei test, Composer ha prodotto meno errori di dipendenza mancata durante i refactoring multi-file e ha ottenuto punteggi più alti nei test di revisione anonima per alcuni carichi di lavoro multi-file. Le funzionalità di latenza e di agente parallelo di Composer mi hanno anche aiutato a migliorare la velocità di iterazione.

Test di accuratezza indipendente (metodo consigliato)

Un test equo utilizza una combinazione di:

- Test unitari: fornire lo stesso repository e la stessa suite di test a entrambi i modelli; generare codice, eseguire test.

- Rifattorizzare i test: fornire una funzione intenzionalmente disordinata e chiedere al modello di riorganizzare e aggiungere test.

- Controlli di sicurezza: eseguire analisi statica e strumenti SAST sul codice generato (ad esempio, Bandit, ESLint, semgrep).

- Revisione umana: punteggi di revisione del codice da parte di ingegneri esperti per la manutenibilità e le migliori pratiche.

Esempio: test harness automatizzato (Python): esegue il codice generato e i test unitari

# python3 run_generated_code.py

# This is a simplified harness: it writes model output to file, runs pytest, captures results.

import subprocess, tempfile, os, textwrap

def write_file(path, content):

with open(path, "w") as f:

f.write(content)

# Suppose `generated_code` is the string returned from model

generated_code = """

# sample module

def add(a,b):

return a + b

"""

tests = """

# test_sample.py

from sample import add

def test_add():

assert add(2,3) == 5

"""

with tempfile.TemporaryDirectory() as d:

write_file(os.path.join(d, "sample.py"), generated_code)

write_file(os.path.join(d, "test_sample.py"), tests)

r = subprocess.run(, cwd=d, capture_output=True, text=True, timeout=30)

print("pytest returncode:", r.returncode)

print(r.stdout)

print(r.stderr)

Utilizza questo pattern per verificare automaticamente se l'output del modello è funzionalmente corretto (supera i test). Per le attività di refactoring, esegui l'harness sul repository originale più il diff del modello e confronta i tassi di superamento dei test e le modifiche di coverage.

Takeaway: Nelle suite di benchmark raw, GPT-5-Codex riporta numeri eccellenti e una solida capacità di refactoring. Nei flussi di lavoro di editing e riparazione multi-file reali, la consapevolezza dell'area di lavoro di Composer può portare a una maggiore accettazione pratica e a un minor numero di errori "meccanici" (importazioni mancanti, nomi di file errati). Per la massima correttezza funzionale in attività algoritmiche a file singolo, GPT-5-Codex è un ottimo candidato; per modifiche multi-file sensibili alle convenzioni all'interno di un IDE, Composer spesso eccelle.

Composer vs GPT-5: come si confrontano in termini di qualità del codice?

Cosa si intende per qualità?

La qualità include leggibilità, denominazione, documentazione, copertura dei test, utilizzo di pattern idiomatici e igiene della sicurezza. Viene misurata sia automaticamente (linter, metriche di complessità) sia qualitativamente (revisione umana).

Differenze osservate

- Codice GPT-5: forte nel produrre pattern idiomatici quando richiesto esplicitamente; eccelle nella chiarezza algoritmica e può produrre suite di test complete quando richiesto. Gli strumenti Codex di OpenAI includono log di test/reporting e di esecuzione integrati.

- Compositore: ottimizzato per osservare automaticamente lo stile e le convenzioni di un repository; Composer può seguire i modelli di progetto esistenti e coordinare gli aggiornamenti a più file (propagazione di rinomina/refactoring, importazione di aggiornamenti). Offre un'eccellente manutenibilità on-demand per progetti di grandi dimensioni.

Esempio di controlli di qualità del codice che puoi eseguire

- Linter — ESLint / pylint

- Complessità — radon / complessità dei fiocchi8

- Sicurezza — semgrep / Bandito

- Copertura di prova — esegui coverage.py o vitest/nyc per JS

Automatizzare questi controlli dopo aver applicato la patch del modello per quantificare miglioramenti o regressioni. Esempio di sequenza di comandi (repository JS):

# after applying model patch

npm ci

npm test

npx eslint src/

npx semgrep --config=auto .

Revisione umana e buone pratiche

In pratica, i modelli richiedono istruzioni per seguire le best practice: richiedere docstring, annotazioni di tipo, dependency pinning o pattern specifici (ad esempio, async/await). GPT-5-Codex è eccellente quando vengono fornite direttive esplicite; Composer trae vantaggio dal contesto implicito del repository. Utilizza un approccio combinato: istruisci il modello in modo esplicito e lascia che Composer imponga lo stile del progetto se ti trovi all'interno di Cursor.

Raccomandazione: Per lavori di ingegneria multi-file all'interno di un IDE, è preferibile Composer; per pipeline esterne, attività di ricerca o automazione di toolchain in cui è possibile chiamare un'API e fornire un contesto di grandi dimensioni, GPT-5-Codex è una scelta valida.

Integrazioni e opzioni di distribuzione

Composer è incluso in Cursor 2.0, integrato nell'editor e nell'interfaccia utente di Cursor. L'approccio di Cursor si basa su un unico piano di controllo del fornitore che esegue Composer insieme ad altri modelli, consentendo agli utenti di eseguire più istanze di modelli sullo stesso prompt e di confrontare gli output all'interno dell'editor. ()

GPT-5-Codex verrà integrato nell'offerta Codex di OpenAI e nella famiglia di prodotti ChatGPT, con disponibilità tramite i livelli a pagamento di ChatGPT e API che piattaforme di terze parti come CometAPI offrono con un miglior rapporto qualità-prezzo. OpenAI sta inoltre integrando Codex negli strumenti per sviluppatori e nei flussi di lavoro dei partner cloud (ad esempio, integrazioni Visual Studio Code/GitHub Copilot).

Quale sarà il futuro del settore grazie a Composer e GPT-5-Codex?

Effetti a breve termine

- Cicli di iterazione più rapidi: I modelli integrati nell'editor, come Composer, riducono l'attrito nelle piccole correzioni e nella generazione di PR.

- Crescenti aspettative in materia di verifica: L'enfasi di Codex su test, registri e capacità autonome spingerà i fornitori a fornire una verifica più efficace e immediata per il codice prodotto dal modello.

Medio-lungo termine

- L'orchestrazione multi-modello diventa normale: L'interfaccia utente grafica multi-agente di Cursor è un primo indizio del fatto che gli ingegneri si aspetteranno presto di eseguire più agenti specializzati in parallelo (linting, sicurezza, refactoring, ottimizzazione delle prestazioni) e di accettare i migliori output.

- Cicli di feedback CI/AI più stretti: Con il miglioramento dei modelli, le pipeline di CI integreranno sempre più la generazione di test basata su modelli e suggerimenti di riparazione automatizzati, ma la revisione umana e l'implementazione graduale restano fondamentali.

Conclusione

Composer e GPT-5-Codex non sono armi identiche nella stessa corsa agli armamenti; sono strumenti complementari ottimizzati per diverse fasi del ciclo di vita del software. La proposta di valore di Composer è la velocità: iterazione rapida e basata sullo spazio di lavoro che mantiene gli sviluppatori in flusso. Il valore di GPT-5-Codex è la profondità: persistenza agentica, correttezza basata sui test e verificabilità per trasformazioni complesse. Il manuale di ingegneria pragmatica è: orchestrare entrambi: agenti simili a Composer a ciclo breve per il flusso quotidiano e agenti in stile GPT-5-Codex per operazioni con gate ad alta confidenza. I primi benchmark suggeriscono che entrambi faranno parte del toolkit per sviluppatori a breve termine, anziché sostituirsi a vicenda.

Non esiste un unico vincitore oggettivo in tutte le dimensioni. I modelli si scambiano punti di forza:

- Codice GPT-5: più efficace nei benchmark di correttezza approfondita, nel ragionamento su larga scala e nei flussi di lavoro autonomi di più ore. Eccelle quando la complessità delle attività richiede ragionamenti lunghi o verifiche approfondite.

- Compositore: Più efficace nei casi d'uso strettamente integrati nell'editor, nella coerenza del contesto multi-file e nella rapida velocità di iterazione all'interno dell'ambiente Cursor. Può essere più adatto alla produttività quotidiana degli sviluppatori, dove sono necessarie modifiche immediate e accurate basate sul contesto.

Vedi anche Cursor 2.0 e Composer: come una rivisitazione multi-agente ha sorpreso la codifica dell'IA

Iniziamo

CometAPI è una piattaforma API unificata che aggrega oltre 500 modelli di intelligenza artificiale (IA) di provider leader, come la serie GPT di OpenAI, Gemini di Google, Claude di Anthropic, Midjourney, Suno e altri, in un'unica interfaccia intuitiva per gli sviluppatori. Offrendo autenticazione, formattazione delle richieste e gestione delle risposte coerenti, CometAPI semplifica notevolmente l'integrazione delle funzionalità di IA nelle tue applicazioni. Che tu stia sviluppando chatbot, generatori di immagini, compositori musicali o pipeline di analisi basate sui dati, CometAPI ti consente di iterare più velocemente, controllare i costi e rimanere indipendente dal fornitore, il tutto sfruttando le più recenti innovazioni nell'ecosistema dell'IA.

Gli sviluppatori possono accedere API GPT-5-Codextramite CometAPI, l'ultima versione del modello è sempre aggiornato con il sito ufficiale. Per iniziare, esplora le capacità del modello nel Parco giochi e consultare il Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. CometaAPI offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

Pronti a partire? → Iscriviti oggi a CometAPI !

Se vuoi conoscere altri suggerimenti, guide e novità sull'IA seguici su VK, X e al Discordia!