Gemini 2.5 Flash API è l'ultimo modello di intelligenza artificiale multimodale di Google, progettato per attività ad alta velocità ed economiche con capacità di ragionamento controllabili, consentendo agli sviluppatori di attivare o disattivare funzionalità di "pensiero" avanzate tramite l'API Gemini. Gli ultimi modelli sono gemini-2.5-flash.

Panoramica di Gemini 2.5 Flash

Gemini 2.5 Flash è progettato per fornire risposte rapide senza compromettere la qualità dell'output. Supporta input multimodali, inclusi testo, immagini, audio e video, rendendolo adatto a diverse applicazioni. Il modello è accessibile tramite piattaforme come Google AI Studio e Vertex AI, fornendo agli sviluppatori gli strumenti necessari per una perfetta integrazione in diversi sistemi.

Informazioni di base (caratteristiche)

Gemini 2.5 Flash introduce diverse novità di spicco Caratteristiche che lo distinguono all'interno della famiglia Gemini 2.5:

- Ragionamento ibrido: Gli sviluppatori possono impostare un pensando al budget parametro per controllare con precisione quanti token il modello dedica al ragionamento interno prima dell'output.

- Frontiera di Pareto: Posizionato al punto ottimale di rapporto costo-prestazioni, Flash offre il miglior rapporto prezzo-intelligenza tra i 2.5 modelli.

- Supporto multimodale: Processi testo, immagini, videoe Audio in modo nativo, consentendo capacità conversazionali e analitiche più ricche.

- Contesto da 1 milione di token: La lunghezza del contesto senza pari consente un'analisi approfondita e la comprensione di documenti estesi in un'unica richiesta.

Versionamento del modello

Gemini 2.5 Flash è passato attraverso la seguente chiave versioni:

- gemini-2.5-flash-lite-preview-09-2025: Usabilità migliorata dello strumento: prestazioni migliorate su attività complesse e multi-step, con un aumento del 5% nei punteggi SWE-Bench Verified (dal 48.9% al 54%). Efficienza migliorata: abilitando il ragionamento, si ottiene un output di qualità superiore con meno token, riducendo latenza e costi.

- Anteprima 04-17: Rilascio con accesso anticipato con capacità di "pensiero", disponibile tramite gemini-2.5-flash-anteprima-04-17.

- Disponibilità generale stabile (GA): A partire dal 17 giugno 2025, l'endpoint stabile gemini-2.5-flash sostituisce l'anteprima, garantendo un'affidabilità di livello produttivo senza modifiche alle API rispetto all'anteprima del 20 maggio.

- Deprecazione dell'anteprima: La chiusura degli endpoint di anteprima era programmata per il 15 luglio 2025; gli utenti devono migrare all'endpoint GA prima di questa data.

A partire da luglio 2025, Gemini 2.5 Flash è ora disponibile al pubblico e stabile (nessuna modifica rispetto a gemini-2.5-flash-anteprima-05-20 ).Se stai usando gemini-2.5-flash-preview-04-17, l'attuale prezzo di anteprima continuerà fino al ritiro programmato dell'endpoint del modello il 15 luglio 2025, quando verrà disattivato. È possibile migrare al modello generalmente disponibile "gemini-2.5-flash".

Più veloce, più economico, più intelligente:

- Obiettivi di progettazione: bassa latenza + elevata produttività + bassi costi;

- Accelerazione complessiva del ragionamento, dell'elaborazione multimodale e dei compiti di testo lunghi;

- L'utilizzo dei token si riduce del 20-30%, diminuendo significativamente i costi di ragionamento.

Specifiche tecniche

Finestra di contesto di input: fino a 1 milione di token, consentendo un'ampia conservazione del contesto.

Token di output: in grado di generare fino a 8,192 token per risposta.

Modalità supportate: testo, immagini, audio e video.

Piattaforme di integrazione: disponibili tramite Google AI Studio e Vertex AI.

Prezzi: modello di prezzi competitivo basato su token, che facilita un'implementazione conveniente.

Dettagli tecnici

Sotto il cofano, Gemini 2.5 Flash è un basato su trasformatore modello linguistico di grandi dimensioni addestrato su una combinazione di dati web, codice, immagini e video. Chiave tecnico le specifiche includono:

Formazione multimodale: Addestrato ad allineare più modalità, Flash può mescolare perfettamente il testo con immagini, video, o Audio, utile per attività come la sintesi video o la sottotitolazione audio.

Processo di pensiero dinamico: Implementa un ciclo di ragionamento interno in cui il modello piani e al scompone prompt complessi prima dell'output finale.

Budget di pensiero configurabili: Il pensando al budget può essere impostato da 0 (nessun ragionamento) fino a Token 24,576, consentendo compromessi tra latenza e qualità della risposta.

Integrazione degli strumenti: Supporta Messa a terra con la ricerca Google, Esecuzione del codice, Contesto URLe Chiamata di funzione, consentendo azioni del mondo reale direttamente da prompt in linguaggio naturale.

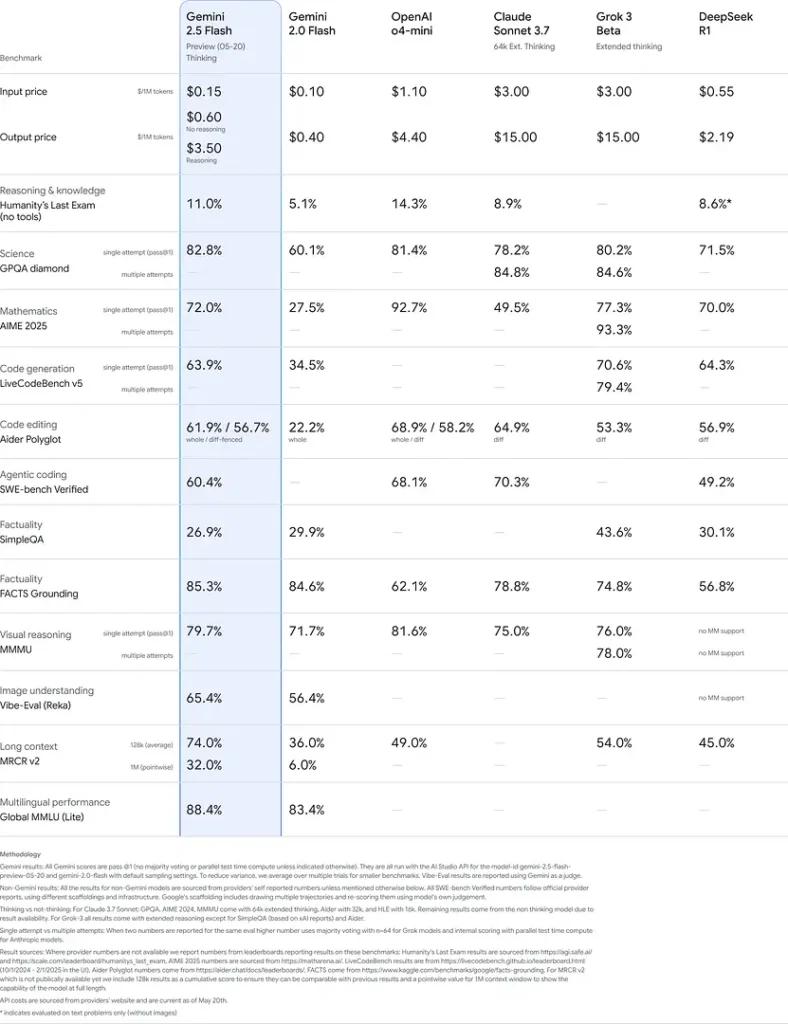

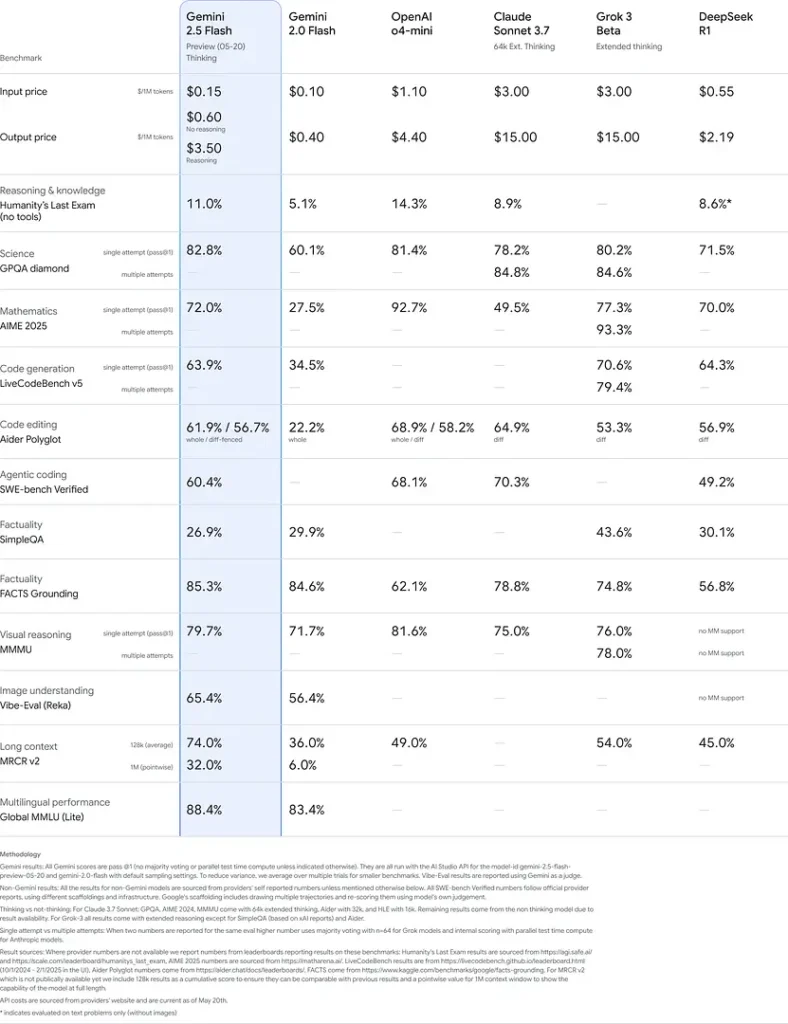

Prestazioni di riferimento

In rigorose valutazioni, Gemini 2.5 Flash dimostra leader del settore prestazione:

- LMArena Hard Prompts: Segnato secondo solo a 2.5 Pro nell'impegnativo benchmark Hard Prompts, che dimostra forti capacità di ragionamento multi-step.

- Punteggio MMLU di 0.809: Supera le prestazioni medie del modello con un 0.809 Precisione MMLU, che riflette la sua ampia conoscenza del dominio e la sua abilità di ragionamento.

- Latenza e throughput: Ottiene 271.4 token/sec velocità di decodifica con un Tempo per il primo token: 0.29 s, rendendolo ideale per carichi di lavoro sensibili alla latenza.

- Leader nel rapporto prezzo/prestazioni: A $0.26/1 M di tokenFlash surclassa molti concorrenti, eguagliandoli o superandoli nei parametri di riferimento chiave.

Questi risultati indicano il vantaggio competitivo di Gemini 2.5 Flash in termini di ragionamento, comprensione scientifica, risoluzione di problemi matematici, codifica, interpretazione visiva e capacità multilingue:

Limiti

Sebbene potente, Gemini 2.5 Flash porta con sé alcune limiti:

- Rischi per la sicurezza: Il modello può esibire un tono "predicatorio" e possono produrre risultati apparentemente plausibili ma errati o distorti (allucinazioni), in particolare nelle query di casi limite. Una rigorosa supervisione umana rimane essenziale.

- Limiti tariffari: L'utilizzo dell'API è limitato dai limiti di velocità (10 RPM, 250,000 TPM, 250 RPD sui livelli predefiniti), che possono avere un impatto sull'elaborazione batch o sulle applicazioni ad alto volume.

- Piano di intelligence: Sebbene eccezionalmente capace per un flash modello, rimane meno accurato di 2.5 Pro sui compiti agenti più impegnativi come la codifica avanzata o il coordinamento multi-agente.

- Compromessi sui costi: Sebbene offra il meglio prezzo-prestazioni, uso estensivo del pensiero la modalità aumenta il consumo complessivo di token, aumentando i costi per i prompt di ragionamento approfondito.

Vedere anche API di Gemini 2.5 Pro

Conclusione

Gemini 2.5 Flash è la dimostrazione dell'impegno di Google nel progresso delle tecnologie di intelligenza artificiale. Grazie alle sue prestazioni affidabili, alle funzionalità multimodali e alla gestione efficiente delle risorse, offre una soluzione completa per sviluppatori e organizzazioni che desiderano sfruttare la potenza dell'intelligenza artificiale nelle proprie attività.

Come chiamare Gemini 2.5 Flash API di CometAPI

Gemini 2.5 Flash Prezzi API in CometAPI: sconto del 20% sul prezzo ufficiale:

- Input token: $ 0.24 / M token

- Token di output: $0.96/M di token

Passi richiesti

- Accedere cometapi.comSe non sei ancora un nostro utente, registrati prima

- Ottieni la chiave API delle credenziali di accesso dell'interfaccia. Fai clic su "Aggiungi token" nel token API nell'area personale, ottieni la chiave token: sk-xxxxx e invia.

- Ottieni l'URL di questo sito: https://api.cometapi.com/

Metodi di utilizzo

- Selezionare l'opzione "

gemini-2.5-flash"endpoint" per inviare la richiesta API e impostarne il corpo. Il metodo e il corpo della richiesta sono reperibili nella documentazione API del nostro sito web. Il nostro sito web fornisce anche il test Apifox per vostra comodità. - Sostituire con la tua chiave CometAPI effettiva dal tuo account.

- Inserisci la tua domanda o richiesta nel campo contenuto: il modello risponderà a questa domanda.

- Elaborare la risposta API per ottenere la risposta generata.

Per informazioni sul modello lanciato in Comet API, vedere https://api.cometapi.com/new-model.

Per informazioni sul prezzo del modello in Comet API, vedere https://api.cometapi.com/pricing.

Esempio di utilizzo dell'API

Gli sviluppatori possono interagire con gemini-2.5-flash Attraverso l'API di CometAPI, che consente l'integrazione in diverse applicazioni. Di seguito un esempio in Python:

import os

from openai import OpenAI

client = OpenAI(

base_url="

https://api.cometapi.com/v1/chat/completions",

api_key="<YOUR_API_KEY>",

)

response = openai.ChatCompletion.create(

model="gemini-2.5-flash",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Explain the concept of quantum entanglement."}

]

)

print(response)

Questo script invia un prompt al Gemini 2.5 Flash modello e stampa la risposta generata, dimostrando come utilizzare Gemini 2.5 Flash per spiegazioni complesse.