API GPT-4o in tempo reale: Un endpoint di streaming multimodale a bassa latenza che consente agli sviluppatori di inviare e ricevere dati sincronizzati di testo, audio e visione tramite WebRTC o WebSocket (modello=gpt-4o-realtime-preview-<date>, stream=true) per applicazioni interattive in tempo reale.

Informazioni di base e caratteristiche

OpenAI di GPT-4o in tempo reale (ID modello: gpt-4o-anteprima-in-tempo-reale-2025-06-03) è il primo modello di fondazione pubblicamente disponibile progettato per discorso-discorso end-to-end (S2S) interazione con latenza inferiore al secondoDerivata dalla famiglia “omni” GPT-4o, la variante Realtime fonde riconoscimento vocale, ragionamento in linguaggio naturale e conversione neurale del testo in voce in un'unica rete, consentendo agli sviluppatori di creare agenti vocali che dialogano in modo fluido come gli esseri umani. Il modello è esposto attraverso l'interfaccia appositamente progettata API in tempo reale ed è strettamente integrato con il nuovo Agente in tempo reale astrazione all'interno del Agenti SDK (TypeScript e Python).

Set di funzionalità principali — S2S end-to-end • Gestione delle interruzioni • Chiamata degli strumenti

• Sintesi vocale nativa: L'input audio viene acquisito come flussi continui, tokenizzato internamente, elaborato e restituito come sintesi vocale. Non sono necessari buffer STT/TTS esterni, eliminando così ritardi di pipeline di diversi secondi.

• Latenza su scala di millisecondi: La potatura architettonica, la distillazione del modello e uno stack di servizio ottimizzato per GPU consentono Latenze del primo token di circa 300–500 ms nelle tipiche implementazioni cloud, avvicinandosi alle normali modalità di conversazione umana.

• Robusto rispetto delle istruzioni: Ottimizzato su script di conversazione e tracce di chiamata di funzione, GPT-4o Realtime dimostra un >25% di riduzione degli errori di esecuzione delle attività rispetto al valore di base GPT-2024o di maggio 4.

• Chiamata deterministica degli strumenti: Il modello produce JSON strutturati conformi a OpenAI schema di chiamata di funzione, consentendo l'invocazione deterministica delle API back-end (sistemi di prenotazione, database, IoT). Sono integrati tentativi di riconoscimento degli errori e convalida degli argomenti.

• Interruzioni aggraziate: Un rilevatore di attività vocale in tempo reale abbinato alla decodifica incrementale consente all'agente di mettere in pausa il discorso a metà frase, inglobare un'interruzione dell'utente e riprendere o ripianificare la risposta senza problemi.

• Velocità vocale configurabile: Una nuova velocità parametro (0.25–4× tempo reale) consente agli sviluppatori di personalizzare il ritmo di output per l'accessibilità o per applicazioni rapide.

Architettura tecnica — Trasformatore multimodale unificato

Codificatore-decodificatore unificato: GPT-4o Realtime condivide l'architettura omni trasformatore monostanza in cui audio, testo e token visivi (futuri) coesistono in un unico spazio latente. Il calcolo adattivo a livello di livello abbrevia i frame audio direttamente nei blocchi di attenzione successivi, risparmiando 20-40 ms per passaggio.

Tokenizzazione audio gerarchica: Il PCM grezzo a 16 kHz viene suddiviso in patch log-mel → quantizzato in token acustici a grana grossa → compresso in token semantici, ottimizzando l' token al secondo budget senza sacrificare la prosodia.

Kernel di inferenza a basso bit: I pesi distribuiti funzionano a Quantizzazione NF4 a 4 bit tramite kernel Triton / TensorRT-LLM, raddoppiando la produttività rispetto a fp16 mantenendo una perdita di qualità MOS <1 dB.

Attenzione streaming: Gli incorporamenti rotanti a finestra scorrevole e la memorizzazione nella cache chiave-valore consentono al modello di occuparsi degli ultimi 15 secondi di audio con memoria O(L), cruciali per i dialoghi della durata di una telefonata.

Dettagli tecnici

- API Version:

2025-06-03-preview - Protocolli di trasporto:

- WebRTC: Latenza ultra bassa (< 80 ms) per flussi audio/video lato client

- WebSocket: Streaming server-to-server con latenza inferiore a 100 ms

- Codifica dei dati:

- opus codec all'interno RTP pacchetti per audio

- H.264 / H.265 wrapper di frame per video

- Streaming: Supporta

stream: trueper fornire incrementale risposte parziali man mano che vengono generati i token - Nuova tavolozza vocale: Introduce otto nuove voci—lega, cenere, ballata, corallo, eco, salvia, baglioree versetto—per saperne di più espressivo, umano interazioni ..

Evoluzione del GPT-4o in tempo reale

- che si terrà nel maggio 2024: GPT-4o Omni debutta con supporto multimodale per testo, audio e visione.

- ottobre 2024: API in tempo reale entra nella beta privata (

2024-10-01-preview), ottimizzato per audio a bassa latenza. - Dicembre 2024: Disponibilità globale ampliata di

gpt-4o-realtime-preview-2024-12-17, Aggiungendo memorizzazione nella cache tempestiva e più voci. - 3 Giugno 2025: Ultimo aggiornamento (

2025-06-03-preview) lancia un raffinato tavolozza vocale e ottimizzazioni delle prestazioni.

Prestazioni di riferimento

- MMLU: 88.7, superando l'4 di GPT-86.5 Comprensione linguistica multitasking massiccia .

- Riconoscimento vocale: Ottiene leader del settore tassi di errore di parola in ambienti rumorosi, superando Sussurro linee di base.

- Test di latenza:

- Da un capo all'altro (discorso in entrata → testo in uscita): 50–80 ms tramite WebRTC

- Audio di andata e ritorno (discorso in entrata → discorso in uscita): <100 ms .

Indicatori tecnici

- Throughput: Sostiene 15 token/sec per flussi di testo; kbps 24 Opera per audio.

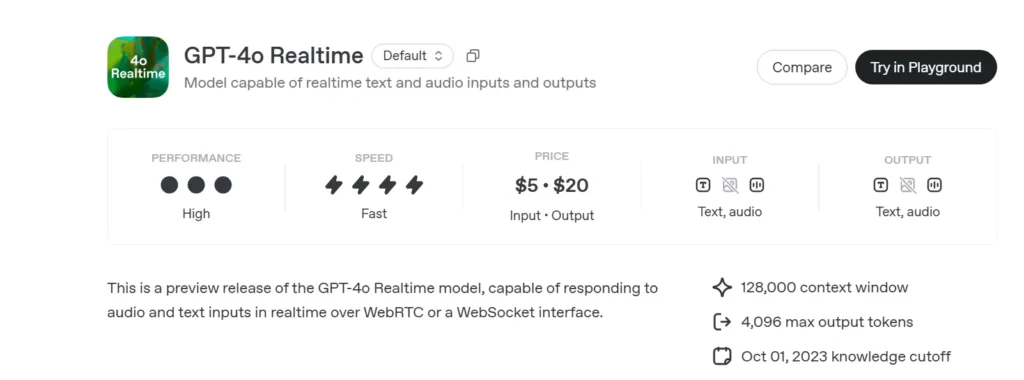

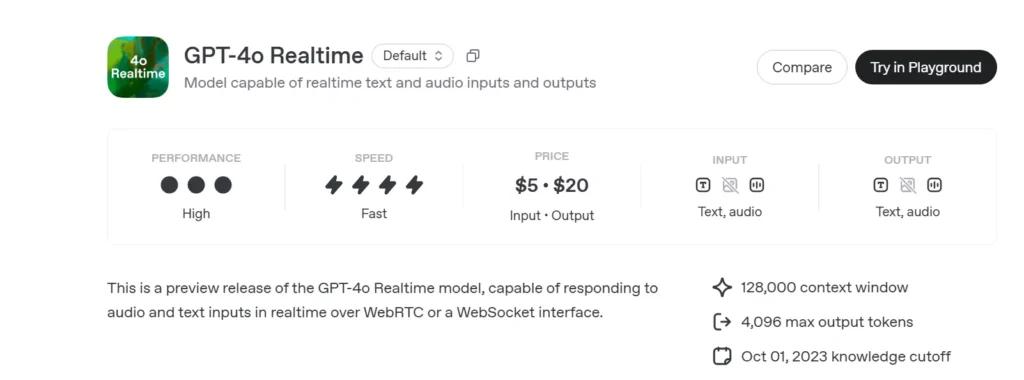

- Prezzi:

- Testo: $ 5 per 1 M di token di input; $ 20 per 1 M di token di output

- audio: $ 100 per 1 milione di token di input; $ 200 per 1 milione di token di output.

- Disponibilità: Distribuito a livello globale in tutte le regioni che supportano l'API in tempo reale.

Come chiamare l'API GPT-4o Realtime da CometAPI

GPT-4o Realtime Prezzi API in CometAPI:

- Input token: $ 2 / M token

- Token di output: $ 8 / M token

Passi richiesti

- Accedere cometapi.comSe non sei ancora un nostro utente, registrati prima

- Ottieni la chiave API delle credenziali di accesso dell'interfaccia. Fai clic su "Aggiungi token" nel token API nell'area personale, ottieni la chiave token: sk-xxxxx e invia.

- Ottieni l'URL di questo sito: https://api.cometapi.com/

Metodi di utilizzo

- Selezionare l'opzione "

gpt-4o-realtime-preview-2025-06-03"endpoint" per inviare la richiesta e impostarne il corpo. Il metodo e il corpo della richiesta sono reperibili nella documentazione API del nostro sito web. Il nostro sito web fornisce anche il test Apifox per vostra comodità. - Sostituire con la tua chiave CometAPI effettiva dal tuo account.

- Inserisci la tua domanda o richiesta nel campo contenuto: il modello risponderà a questa domanda.

- Elaborare la risposta API per ottenere la risposta generata.

Per informazioni sull'accesso al modello in Comet API, vedere Documento API.

Per informazioni sul prezzo del modello in Comet API, vedere https://api.cometapi.com/pricing.

Codice di esempio e integrazione API

import openai

openai.api_key = "YOUR_API_KEY"

# Establish a Realtime WebRTC connection

connection = openai.Realtime.connect(

model="gpt-4o-realtime-preview-2025-06-03",

version="2025-06-03-preview",

transport="webrtc"

)

# Stream audio frames and receive incremental text

with open("user_audio.raw", "rb") as audio_stream:

for chunk in iter(lambda: audio_stream.read(2048), b""):

result = connection.send_audio(chunk)

print("Assistant:", result)

- Parametri chiave:

model: “gpt-4o-anteprima-in-tempo-reale-2025-06-03”version: “2025-06-03-anteprima”transport: “webrtc” da latenza minimastream:trueda incrementale aggiornamenti

Combinando state-of-the-art ragionamento multimodale, a robusto nuova tavolozza vocale e molto basso streaming di latenza, GPT-4o in tempo reale (2025-06-03) consente agli sviluppatori di creare veramente interattivo, discorsivo Applicazioni dell'intelligenza artificiale.

Vedere anche API o3-Pro

Sicurezza e conformità

OpenAI fornisce GPT-4o Realtime con:

· XNUMX€ Guardrail a livello di sistema: Policy calibrata per rifiutare richieste non ammesse (estremismo, comportamento illecito).

· XNUMX€ Filtraggio dei contenuti in tempo reale: I classificatori inferiori a 100 ms filtrano sia l'input dell'utente sia l'output del modello prima dell'emissione.

· XNUMX€ Percorsi di approvazione umana: Attivato su invocazioni di strumenti ad alto rischio (pagamenti, consulenza legale), sfruttando i nuovi primitivi di approvazione dell'Agents SDK.