al 15 dicembre 2025 i fatti pubblici indicano che Google’s Gemini 3 Pro (preview) e OpenAI’s GPT-5.2 fissano nuove frontiere nel ragionamento, nella multimodalità e nel lavoro su contesti lunghi — ma seguono strade ingegneristiche diverse (Gemini → MoE sparsa + contesto enorme; GPT-5.2 → design densi/“routing”, compattazione e modalità di ragionamento x-high) e quindi bilanciano le vittorie ai benchmark di picco vs prevedibilità ingegneristica, tooling ed ecosistema. Quale sia “migliore” dipende dalla tua esigenza principale: le applicazioni agentiche multimodali a contesto estremo tendono verso Gemini 3 Pro; per strumenti di sviluppo enterprise stabili, costi prevedibili e disponibilità API immediata è preferibile GPT-5.2.

Che cos’è GPT-5.2 e quali sono le sue caratteristiche principali?

GPT-5.2 è la release dell’11 dicembre 2025 nella famiglia GPT-5 (varianti: Instant, Thinking, Pro). È posizionato come il modello più capace dell’azienda per il “professional knowledge work” — ottimizzato per fogli di calcolo, presentazioni, ragionamento su contesti lunghi, chiamata di strumenti, generazione di codice e attività di visione. OpenAI ha reso GPT-5.2 disponibile agli utenti ChatGPT a pagamento e tramite l’API di OpenAI (Responses API / Chat Completions) con nomi modello come gpt-5.2, gpt-5.2-chat-latest e gpt-5.2-pro.

Varianti del modello e uso previsto

- gpt-5.2 / GPT-5.2 (Thinking) — migliore per ragionamenti complessi e multi-step (la variante della famiglia Thinking predefinita usata nella Responses API).

- gpt-5.2-chat-latest / Instant — minor latenza per uso quotidiano come assistente e chat.

- gpt-5.2-pro / Pro — massima fedeltà/affidabilità per i problemi più difficili (calcolo extra, supporta

reasoning_effort: "xhigh").

Caratteristiche tecniche principali (lato utente)

- Miglioramenti in Vision & multimodalità — migliore ragionamento spaziale su immagini e comprensione video migliorata se abbinata a strumenti di codice (strumento Python), oltre al supporto per strumenti in stile code-interpreter per eseguire snippet.

- Sforzo di ragionamento configurabile (

reasoning_effort: none|minimal|low|medium|high|xhigh) per bilanciare latenza/costo vs profondità.xhighè nuovo in GPT-5.2 (e supportato su Pro). - Gestione del contesto lungo migliorata e funzionalità di compattazione per ragionare su centinaia di migliaia di token (OpenAI riporta forti metriche MRCRv2/contesto lungo).

- Chiamata di strumenti avanzata e workflow agentici — coordinamento multi-turn più forte, migliore orchestrazione degli strumenti in un’architettura “mega-agent” unica (OpenAI evidenzia le prestazioni su Tau2-bench).

Che cos’è Gemini 3 Pro Preview?

Gemini 3 Pro Preview è il modello di IA generativa più avanzato di Google, rilasciato come parte della famiglia Gemini 3 a novembre 2025. Il modello è costruito con enfasi sulla comprensione multimodale — in grado di comprendere e sintetizzare testo, immagini, video e audio — e presenta una finestra di contesto ampia (~1 milione di token) per gestire documenti o codebase estese.

Google posiziona Gemini 3 Pro come all’avanguardia in profondità e finezza del ragionamento, e funge da motore principale per diversi strumenti per sviluppatori e aziende, tra cui Google AI Studio, Vertex AI e piattaforme di sviluppo agentiche come Google Antigravity.

Al momento, Gemini 3 Pro è in preview — il che significa che funzionalità e accesso sono ancora in espansione, ma il modello già ottiene punteggi elevati su logica, comprensione multimodale e workflow agentici.

Caratteristiche tecniche e di prodotto principali

- Finestra di contesto: Gemini 3 Pro Preview supporta un input di 1.000.000 token (e fino a 64k token di output), un grande vantaggio pratico per ingerire documenti estremamente grandi, libri o trascrizioni video in un’unica richiesta.

- Funzionalità API: parametro

thinking_level(low/high) per bilanciare latenza e profondità di ragionamento; impostazionimedia_resolutionper controllare la fedeltà multimodale e l’uso di token; sono supportati search grounding, contesto file/URL, esecuzione di codice e function calling. Le thought signatures e la cache di contesto aiutano a mantenere lo stato tra più chiamate. - Modalità Deep Think / ragionamento superiore: un’opzione “Deep Think” offre un passaggio di ragionamento extra per spingere i punteggi su benchmark difficili. Google pubblica Deep Think come percorso separato ad alte prestazioni per problemi complessi.

- Supporto multimodale nativo: input di testo, immagini, audio e video con forte grounding per Search e integrazioni di prodotto (Google evidenzia i punteggi Video-MMMU e altri benchmark multimodali).

Anteprima rapida — GPT-5.2 vs Gemini 3 Pro

Tabella di confronto compatta con i fatti più importanti (fonti citate).

| Aspetto | GPT-5.2 (OpenAI) | Gemini 3 Pro (Google / DeepMind) |

|---|---|---|

| Vendor / posizionamento | OpenAI — upgrade di punta GPT-5.x focalizzato su professional knowledge work, coding e workflow agentici. | Google DeepMind / Google AI — generazione Gemini di punta focalizzata su ragionamento multimodale a contesto ultra lungo e integrazione di strumenti. |

| Principali varianti di modello | Instant, Thinking, Pro (e Auto che passa tra di esse). Pro aggiunge sforzo di ragionamento più alto. | Famiglia Gemini 3 incluse Gemini 3 Pro e modalità Deep-Think; focus multimodale/agentico. |

| Finestra di contesto (input/output) | ~400.000 token di capacità input totale; fino a 128.000 token di output/ragionamento (progettato per documenti e codebase molto lunghi). | Fino a ~1.000.000 token di input/finestra di contesto (1M) con output fino a 64K token |

| Punti di forza / focus | Ragionamento su contesti lunghi, tool-calling agentico, coding, attività strutturate d’ufficio (fogli, presentazioni); aggiornamenti di safety/system card sulla affidabilità. | Comprensione multimodale su larga scala, ragionamento + composizione di immagini, contesto molto ampio + modalità “Deep Think”, forti integrazioni di strumenti nell’ecosistema Google. |

| Capacità multimodali e immagine | Grounding visivo e multimodale migliorato; ottimizzato per uso strumenti e analisi documenti. | Generazione di immagini ad alta fedeltà + composizione potenziata dal ragionamento, editing multi-referenza e resa di testo leggibile. |

| Latenza / interattività | Il vendor enfatizza inferenza più veloce e reattività del prompt (latenza più bassa dei precedenti GPT-5.x); più livelli (Instant / Thinking / Pro). | Google enfatizza serving “Flash” ottimizzato e velocità interattive comparabili in molti flussi; la modalità Deep Think scambia latenza con ragionamento più profondo. |

| Funzioni distintive | Livelli di sforzo di ragionamento (medium/high/xhigh), tool-calling migliorato, generazione di codice di alta qualità, alta efficienza di token per workflow enterprise. | Contesto da 1M token, ingest multimodale nativo (video/audio), modalità di ragionamento “Deep Think”, integrazioni strette con prodotti Google (Docs/Drive/NotebookLM). |

| Usi tipici (breve) | Analisi di documenti lunghi, workflow agentici, progetti di coding complessi, automazione enterprise (fogli/report). | Progetti multimodali estremamente grandi, workflow agentici a lungo orizzonte che richiedono contesto da 1M token, pipeline avanzate immagine + ragionamento. |

Come si confrontano GPT-5.2 e Gemini 3 Pro dal punto di vista architetturale?

Architettura di base

- Benchmark / valutazioni su lavoro reale: GPT-5.2 Thinking ha ottenuto il 70,9% di vittorie/pareggi su GDPval (valutazione del lavoro della conoscenza su 44 professioni) e grandi guadagni su benchmark di ingegneria e matematica rispetto ai precedenti GPT-5. Importanti miglioramenti nel coding (SWE-Bench Pro) e nella QA scientifica di dominio (GPQA Diamond).

- Tooling & agenti: Solido supporto integrato per tool calling, esecuzione Python e workflow agentici (ricerca documenti, analisi file, agenti di data science). 11x più veloce / <1% del costo rispetto a esperti umani per alcuni task GDPval (misura del potenziale valore economico, 70,9% vs ~38,8% precedente) e guadagni concreti nella modellazione di fogli di calcolo (es., +9,3% su un task da junior investment banking vs GPT-5.1).

- Gemini 3 Pro: Transformer Sparse Mixture-of-Experts (MoE). Il modello attiva un piccolo set di esperti per token, consentendo una capacità di parametri totale estremamente grande con calcolo per token sublineare. Google pubblica una scheda del modello che chiarisce come il design MoE sparso sia un contributore chiave al profilo di prestazioni migliorato. Questa architettura rende possibile spingere la capacità del modello molto più in alto senza costi di inferenza lineari.

- GPT-5.2 (OpenAI): OpenAI continua a usare architetture basate su Transformer con strategie di routing/compattazione nella famiglia GPT-5 (un “router” attiva modalità diverse — Instant vs Thinking — e l’azienda documenta tecniche di compattazione e gestione dei token per contesti lunghi). GPT-5.2 enfatizza l’addestramento e la valutazione per “pensare prima di rispondere” e la compattazione per compiti a lungo orizzonte, invece di annunciare una classica MoE sparsa su larga scala.

Implicazioni delle architetture

- Trade-off di latenza e costo: Modelli MoE come Gemini 3 Pro possono offrire capacità di picco più alta per token mantenendo i costi di inferenza inferiori in molti task perché solo un sottoinsieme di esperti viene eseguito. Possono però aggiungere complessità al serving e allo scheduling (bilanciamento degli esperti al cold-start, I/O). L’approccio di GPT-5.2 (denso/instradato con compattazione) favorisce latenza prevedibile ed ergonomia per sviluppatori — soprattutto integrato nel tooling OpenAI esistente come Responses, Realtime, Assistants e API batch.

- Scalare il contesto lungo: L’input da 1M token di Gemini consente di fornire nativamente documenti estremamente lunghi e stream multimodali. Il contesto combinato di GPT-5.2 (~400k tra input+output) è comunque enorme e copre la maggior parte delle esigenze enterprise ma è più piccolo della specifica da 1M di Gemini. Per corpora molto grandi o trascrizioni video di molte ore, la specifica di Gemini offre un vantaggio tecnico netto.

Strumenti, agenti e infrastruttura multimodale

- OpenAI: integrazione profonda per tool calling, esecuzione Python, modalità di ragionamento “Pro” ed ecosistemi di agenti a pagamento (ChatGPT Agents / integrazioni di strumenti enterprise). Forte focus su workflow centrati sul codice e generazione di fogli/presentazioni come output di prima classe.

- Google / Gemini: grounding integrato con Google Search (funzionalità opzionale a pagamento), esecuzione di codice, contesto URL e file, e controlli espliciti della risoluzione dei media per scambiare token con fedeltà visiva. L’API offre

thinking_levele altre manopole per tarare costo/latenza/qualità.

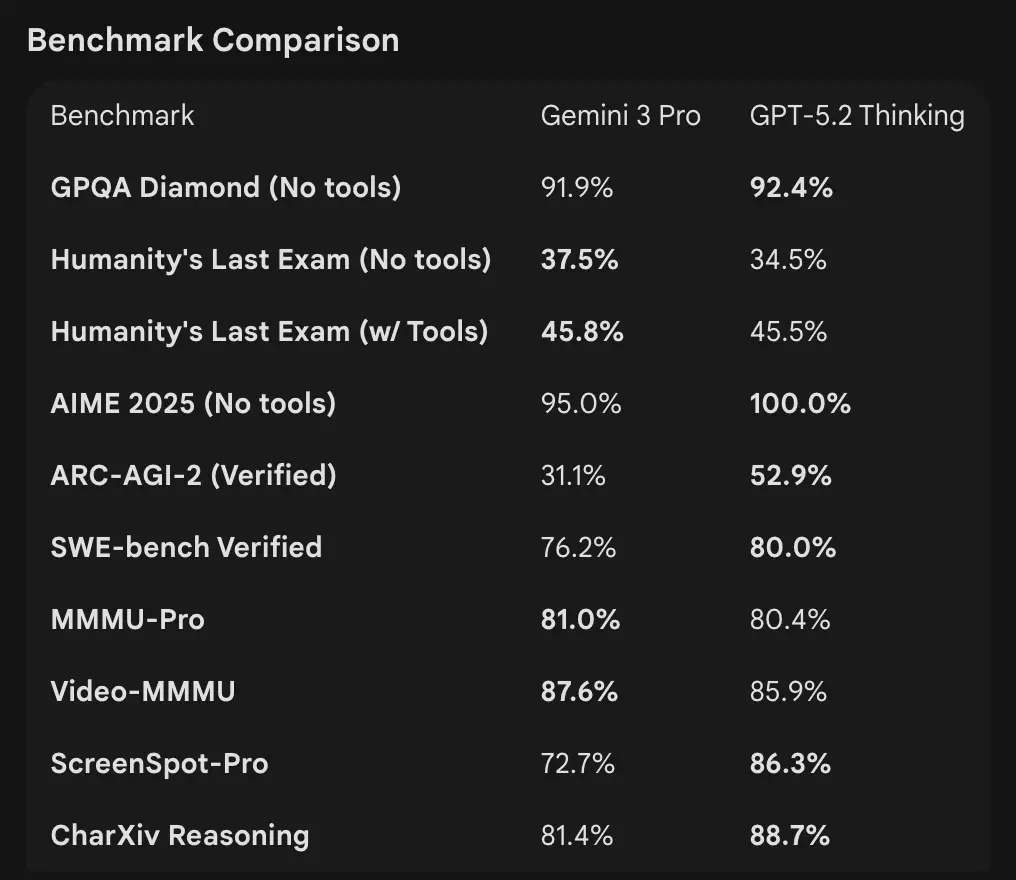

Come si confrontano i numeri dei benchmark

Finestre di contesto e gestione dei token

- Gemini 3 Pro Preview: 1.000.000 token di input / 64k token di output (model card della preview Pro). Taglio della conoscenza: gennaio 2025 (Google).

- GPT-5.2: OpenAI dimostra solide prestazioni su contesti lunghi (punteggi MRCRv2 tra 4k–256k “needle” con >85–95% in molti settaggi) e utilizza funzionalità di compattazione; gli esempi pubblici di contesto indicano prestazioni robuste anche con contesti molto grandi ma OpenAI elenca finestre specifiche per variante (ed enfatizza la compattazione più che un singolo numero 1M). Per uso API, i nomi modello sono

gpt-5.2,gpt-5.2-chat-latest,gpt-5.2-pro.

Benchmark di ragionamento e agentici

- OpenAI (selezione): Tau2-bench Telecom 98,7% (GPT-5.2 Thinking), forti guadagni in uso di strumenti multi-step e task agentici (OpenAI evidenzia il collasso di sistemi multi-agente in un “mega-agent”). GPQA Diamond e ARC-AGI mostrano incrementi netti rispetto a GPT-5.1.

- Google (selezione): Gemini 3 Pro: LMArena 1501 Elo, MMMU-Pro 81%, Video-MMMU 87,6%, alti punteggi in GPQA e Humanity’s Last Exam; Google mostra anche pianificazione a lungo orizzonte tramite esempi agentici.

Tooling & agenti:

GPT-5.2: Solido supporto integrato per tool calling, esecuzione Python e workflow agentici (ricerca documenti, analisi file, agenti di data science). 11x più veloce / <1% del costo rispetto a esperti umani per alcuni task GDPval (misura del potenziale valore economico, 70,9% vs ~38,8% precedente), e guadagni concreti nella modellazione di fogli (es., +9,3% su un task da junior investment banking vs GPT-5.1).

Interpretazione: i benchmark sono complementari — OpenAI enfatizza i benchmark di lavoro della conoscenza reale (GDPval) mostrando che GPT-5.2 eccelle in compiti produttivi come fogli di calcolo, slide e lunghe sequenze agentiche. Google enfatizza leaderboard di ragionamento puro e finestre di contesto singola richiesta estremamente grandi. Cosa conta di più dipende dal carico di lavoro: pipeline enterprise agentiche e su documenti lunghi favoriscono le prestazioni comprovate di GPT-5.2 in GDPval; ingestione di contesto massivo (es., interi corpora video / libri completi in un passaggio) favorisce la finestra di input da 1M di Gemini.

Come si confrontano le capacità multimodali?

Input e output

- Gemini 3 Pro Preview: supporta input di testo, immagini, video, audio, PDF e output testuali; Google fornisce controlli granulari

media_resolutione un parametrothinking_levelper regolare costo vs fedeltà nel lavoro multimodale. Limite output 64k token; input fino a 1M token. - GPT-5.2: supporta workflow visivi e multimodali ricchi; OpenAI evidenzia miglior ragionamento spaziale (stima di etichette di riquadri di componenti), comprensione video (punteggi Video MMMU) e visione abilitata da strumenti (lo strumento Python su task visivi migliora i punteggi). GPT-5.2 sottolinea che compiti complessi visione + codice beneficiano molto quando è abilitato il supporto agli strumenti (esecuzione di codice Python).

Differenze pratiche

Granularità vs ampiezza: Gemini espone una suite di manopole multimodali (media_resolution, thinking_level) per consentire agli sviluppatori di regolare i trade-off per tipo di media. GPT-5.2 enfatizza l’uso integrato di strumenti (esecuzione di Python nel loop) per combinare visione, codice e trasformazioni dati. Se il tuo caso d’uso è analisi pesante di video + immagini con contesti estremamente grandi, il claim del contesto 1M di Gemini è convincente; se i tuoi workflow richiedono esecuzione di codice nel loop (trasformazioni dati, generazione di fogli), il tooling di GPT-5.2 e l’attitudine agli agenti possono risultare più comodi.

Che dire di accesso API, SDK e prezzi?

OpenAI GPT-5.2 (API e prezzi)

- API:

gpt-5.2,gpt-5.2-chat-latest,gpt-5.2-protramite Responses API / Chat Completions. SDK consolidati (Python/JS), guide cookbook ed ecosistema maturo. - Prezzi (pubblici): $1,75 / 1M token di input e $14 / 1M token di output; sconti di cache (90% per input memorizzati) riducono il costo effettivo per dati ripetuti. OpenAI enfatizza l’efficienza per token (prezzo per token più alto ma meno token totali per raggiungere una soglia di qualità).

Gemini 3 Pro Preview (API e prezzi)

- API:

gemini-3-pro-previewtramite Google GenAI SDK e endpoint Vertex AI/GenerativeLanguage. Nuovi parametri (thinking_level,media_resolution) e integrazione con grounding e strumenti Google. - Prezzi (preview pubblica): Circa $2 / 1M token di input e $12 / 1M token di output per i livelli preview sotto 200k token; potrebbero applicarsi addebiti aggiuntivi per Search grounding, Maps o altri servizi Google (la fatturazione del Search grounding inizia il 5 gennaio 2026).

Usa GPT-5.2 e Gemini 3 tramite CometAPI

CometAPI è una gateway / aggregator API: un singolo endpoint REST in stile OpenAI che offre accesso unificato a centinaia di modelli di molti vendor (LLM, modelli immagine/video, embedding, ecc.). Invece di integrare molti SDK dei vendor, CometAPI consente di chiamare endpoint in formato OpenAI (chat/completions/embeddings/images) mantenendo la possibilità di cambiare modello o vendor sotto il cofano.

Gli sviluppatori possono usare i modelli di punta di due aziende diverse contemporaneamente via CometAPI without switching vendors, e i prezzi dell’API sono più convenienti, di solito con uno sconto del 20%.

Esempio: snippet API rapidi (copia-incolla per provare)

Di seguito esempi minimi eseguibili. Riflettono i quickstart pubblicati dai vendor (OpenAI Responses API + Google GenAI client). Sostituisci $OPENAI_API_KEY / $GEMINI_API_KEY con le tue chiavi.

GPT-5.2 — Python (OpenAI Responses API, reasoning impostato a xhigh per problemi difficili)

# Python (requires openai SDK that supports responses API)from openai import OpenAIclient = OpenAI(api_key="YOUR_OPENAI_API_KEY")resp = client.responses.create( model="gpt-5.2-pro", # gpt-5.2 or gpt-5.2-pro input="Summarize this 50k token company report and output a 10-slide presentation outline with speaker notes.", reasoning={"effort": "xhigh"}, # deeper reasoning max_output_tokens=4000)print(resp.output_text) # or inspect resp to get structured outputs / tokens

Note: reasoning.effort ti permette di bilanciare costo vs profondità. Usa gpt-5.2-chat-latest per stile chat Instant. La documentazione OpenAI mostra esempi per responses.create.

GPT-5.2 — curl (semplice)

curl https://api.openai.com/v1/responses \ -H "Authorization: Bearer $OPENAI_API_KEY" \ -H "Content-Type: application/json" \ -d '{ "model": "gpt-5.2", "input": "Write a Python function that converts a PDF with tables into a normalized CSV with typed columns.", "reasoning": {"effort":"high"} }'

(Esamina il JSON per output_text o output strutturati.)

Gemini 3 Pro Preview — Python (Google GenAI client)

# Python (google genai client) — example from Google docsfrom google import genaiclient = genai.Client(api_key="YOUR_GEMINI_API_KEY")response = client.models.generate_content( model="gemini-3-pro-preview", contents="Find the race condition in this multi-threaded C++ snippet: <paste code here>", config={ "thinkingConfig": {"thinking_level": "high"} })print(response.text)

Note: thinking_level controlla la deliberazione interna del modello; media_resolution può essere impostato per immagini/video. Esempi REST e JS sono nella guida sviluppatori di Gemini.

Gemini 3 Pro — curl (REST)

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-preview:generateContent" \ -H "x-goog-api-key: $GEMINI_API_KEY" \ -H "Content-Type: application/json" \ -X POST \ -d '{ "contents": [{ "parts": [{"text": "Explain the race condition in this C++ code: ..."}] }], "generationConfig": {"thinkingConfig": {"thinkingLevel": "high"}} }'

La documentazione di Google include esempi multimodali (immagini inline data, media_resolution).

Quale modello è “migliore” — guida pratica

Non esiste un “vincitore” universale; la scelta dipende da caso d’uso e vincoli. Di seguito una breve matrice decisionale.

Scegli GPT-5.2 se:

- Ti serve integrazione stretta con strumenti di esecuzione codice (ecosistema interpreter/tool di OpenAI) per pipeline dati programmatiche, generazione di fogli o workflow agentici di codice. OpenAI evidenzia miglioramenti dello strumento Python e l’uso del mega-agent.

- Dai priorità all’efficienza dei token secondo le affermazioni del vendor e vuoi prezzi OpenAI per token espliciti e prevedibili con forti sconti su input in cache (utile per workflow batch/produzione).

- Vuoi l’ecosistema OpenAI (integrazione prodotto ChatGPT, partnership Azure / Microsoft e tooling attorno a Responses API e Codex).

Scegli Gemini 3 Pro se:

- Ti serve input multimodale estremo (video + immagini + audio + pdf) e vuoi un singolo modello che accetti nativamente tutti questi input con una finestra di input da 1.000.000 token. Google lo commercializza esplicitamente per video lunghi, pipeline grandi documento + video e casi d’uso con Search/AI Mode interattivi.

- Stai costruendo su Google Cloud / Vertex AI e vuoi un’integrazione stretta con il grounding di Google Search, il provisioning Vertex e le API del client GenAI. Beneficerai delle integrazioni con i prodotti Google (Search AI Mode, AI Studio, tooling Antigravity per agenti).

Conclusione: Qual è migliore nel 2026?

Nel confronto GPT-5.2 vs. Gemini 3 Pro Preview, la risposta è dipendente dal contesto:

- GPT-5.2 guida nel lavoro professionale della conoscenza, nella profondità analitica e nei workflow strutturati.

- Gemini 3 Pro Preview eccelle nella comprensione multimodale, nelle integrazioni di ecosistema e nei task a contesto ampio.

Nessun modello è universalmente “migliore” — i loro punti di forza rispondono a esigenze reali differenti. Gli adottanti intelligenti dovrebbero allineare la scelta del modello a casi d’uso specifici, vincoli di budget e allineamento di ecosistema.

Se vuoi provare subito, esplora le capacità di GPT-5.2 e Gemini 3 Pro su CometAPI nel Playground e consulta la guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l’accesso a CometAPI e di aver ottenuto la chiave API. CometAPI offre un prezzo molto inferiore rispetto al prezzo ufficiale per aiutarti a integrare.

Pronto a iniziare?→ Prova gratuita di GPT-5.2 e Gemini 3 Pro !

If you want to