Nel frenetico mondo dell'intelligenza artificiale, Google sta per compiere un altro grande passo avanti con il suo prossimo modello Gemini 3.0. Mentre concorrenti come GPT-5 di OpenAI e Grok 4 di xAI continuano a spingersi oltre i limiti, le voci sul Gemini 3.0 circolano nei forum tecnologici, sui social media e nelle notizie di settore. Ora identifichiamo questi messaggi e attendiamo con ansia di scoprirne insieme le funzionalità.

Gemini 3.0 è stato rilasciato segretamente?

Negli ultimi giorni i post sui social e le discussioni della community hanno segnalato due elementi correlati:

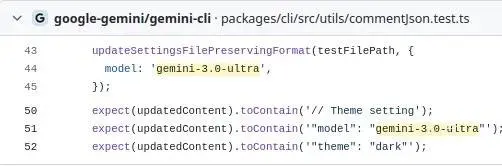

- Indipendentemente, i dati di prova di un collaboratore nel pubblico google-gemini/gemini-cli repo includeva la stringa

gemini-3.0-ultrain un file di prova. Quel frammento è stato scoperto dai membri della community e ripubblicato sulle piattaforme social; molti lo hanno interpretato come una fuga di notizie o una prova preliminare dell'esistenza di "Gemini 3.0 Ultra". - Gli utenti che hanno consultato gli elenchi dei modelli LM Arena hanno notato un nuovo nome/nome in codice del modello “pietra oceanica” apparendo in alcune arene, e alcuni partecipanti hanno ipotizzato che potrebbe trattarsi di un test stealth di "Gemini 3 Flash". Questi avvistamenti hanno alimentato l'idea che Google stesse testando silenziosamente sul campo una futura variante di Gemini 3.

Sembra un'ottima notizia. Dopotutto, è passato un bel po' di tempo da quando Google Gemini ha rilasciato il Gemini 2.5 Pro. Negli anni successivi, sono stati lanciati modelli come Claude Opus 4.1, Grok 4 e GPT-5, tutti di grande successo. Questo non ha fatto che aumentare la mia curiosità su quali sorprese Gemini porterà con Gemini 3.0.

Tuttavia, quando ho verificato l'autenticità di queste segnalazioni e ho testato le prestazioni di Oceanstone, un dispositivo sospettato di essere il flash Gemini 3.0, sono giunto a una conclusione sorprendente, al tempo stesso promettente e deludente. Condividerò i miei risultati qui di seguito.

Gemini 3.0 è davvero trapelato nel repository Gemini-CLI?

Riferimenti ai nomi dei modelli nel repository Gemini-CLI

La comunità ha evidenziato i commit nel google-gemini/gemini-cli repository a cui si fa riferimento gemini-beta-3.0-pro, gemini-beta-3.0-flash e (in alcuni rapporti) gemini-3.0-ultraIl repository è pubblico e in continuo sviluppo; le differenze tra i commit sono visibili e sono state alla base di gran parte delle speculazioni. Un commit comunemente linkato mostra le modifiche che hanno scatenato le prime discussioni sulla versione "3.0". Tuttavia: il testo del repository può contenere segnaposto, dati di test o nomi interni utilizzati per la convalida: la presenza di una stringa in un repository è non è un prova che è stato pubblicato un modello binario o un endpoint API pubblico.

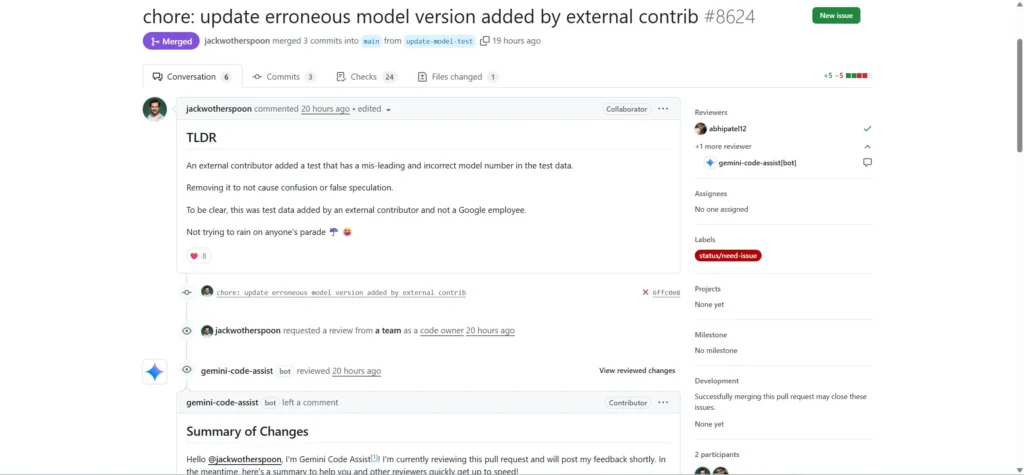

Cosa hanno fatto realmente i responsabili del repository (e i collaboratori di Google)

I manutentori del repository hanno aperto e unito una breve richiesta di pull che rimosso o corretto la voce di test fuorviante. La spiegazione del manutentore nel PR unito è esplicita: gemini-3.0-ultra la corda era dati di prova aggiunti da un collaboratore esterno, era fuorviante e il PR lo ha sostituito con il corretto identificatore del modello esistente (per i test). L'autore del PR e i collaboratori del repository hanno sottolineato che la voce non era un identificatore di prodotto ufficiale di Google. In breve: l'aspetto del repository era un valore di prova errato, non una perdita di prodotto.

Perché è importante: I repository di codice pubblici accettano contributi da autori esterni; le strutture di test a volte contengono etichette o segnaposto generati da esseri umani. La scoperta da parte della comunità di un tale segnaposto non equivale a una versione controllata del prodotto o a un manifesto ufficiale del prodotto.

In breve: Google ha risolto e commentato i problemi di sicurezza della CLI, e le modifiche/i rollback del repository suggeriscono che le stringhe 3.0 non erano intese come segnale di rilascio pubblico.

La performance dichiarata di Oceanstone: credibile o esagerata?

Oceanstone è un'etichetta modello apparsa nelle classifiche pubbliche di LM Arena e nei rapidi report sui social questa settimana. I tester della community hanno condotto confronti informali e riferiscono che Oceanstone ha prestazioni almeno pari a quelle di Gemini, e in alcuni rapidi controlli leggermente superiori. 2.5 Flash su un sottoinsieme di attività Arena. Queste impressioni si concentrano su: migliore capacità di seguire le richieste, codifica/ragionamento più efficace su campioni brevi e coerenza conversazionale leggermente migliorata — ma si tratta di voti e screenshot di campioni umani di piccole dimensioni, non di benchmark controllati.

Cosa ci dicono gli avvistamenti di LM Arena

LM Arena è una piattaforma di valutazione aperta in cui ricercatori e team eseguono confronti ciechi e talvolta presentano nomi di modelli pre-release o sperimentali (nomi in codice). Storicamente, LMArena ha mostrato nomi in codice che in seguito corrispondono alle release ufficiali dei modelli di Google (ad esempio, nomi in codice precedenti sono stati utilizzati durante i test di anteprima di Gemini 2.5 Flash Image).

Spiegazione plausibile (più probabile):

- Google o un partner/test harness hanno utilizzato temporaneamente ID di modelli di test/interni (segnaposto) durante l'esecuzione di pipeline interne o di scaffolding demo; queste stringhe sono trapelate in un commit pubblico o in un set di dati di test.

- LM Arena a volte indicizza o espone modelli nuovi/sperimentali inviati per la valutazione (talvolta con nomi in codice). Un modello di prova di Google potrebbe legittimamente apparire sotto un nome in codice come pietra oceanica senza essere una versione pubblica completa e supportata. Ciò corrisponde allo schema osservato: un nome in codice appare in LM Arena e le stringhe del nome del modello appaiono in un repository pubblico; i manutentori in seguito eliminano i riferimenti.

I risultati del mio test per Oceanstone

Oceanstone dimostra un cambiamento di paradigma nelle capacità degli agenti di intelligenza artificiale, superando i benchmark prestazionali di GPT-5 e introducendo un nuovo standard per i sistemi autonomi.

Osservazioni chiave:

- Integrazione Internet nativa: Uno degli aggiornamenti più sorprendenti di Oceanstone risiede nel suo capacità nativa di accedere a Internet tramite la sua APIDurante i test controllati, il modello è stato in grado di gestire query in tempo reale con una precisione mai osservata nelle generazioni precedenti. Ad esempio, quando gli è stata richiesta la data corrente esatta, non si è basato su dati di training statici, ma ha invece eseguito una ricerca in tempo reale, riportando correttamente 17 settembre 2025Questa caratteristica elimina una delle carenze più persistenti dei precedenti LLM: la stagnazione temporale.

- Generazione di contenuti affidabili e basati sulla fonte: Nei flussi di lavoro professionali, la generazione di contenuti è spesso limitata da questioni di credibilità e affidabilità. Gemini 3.0 affronta direttamente questa lacuna producendo output coerenti, verificabili e basati sulle fonti. Nei nostri test, il modello è riuscito a redigere articoli di lunga durata con citazioni appropriate e un flusso narrativo coerente, riflettendo sia fluidità creativa che affidabilità fattuale.

- Precisione nella replicazione delle pagine Web e fedeltà dell'interfaccia utente: Forse la capacità più inaspettata osservata è stata la capacità di Gemini 3.0 di replicare pagine web complesse con una fedeltà sorprendente. Quando gli è stato chiesto di riprodurre il layout di una pagina web ufficiale di Apple, Gemini 3.0 ha prodotto risultati che rispecchiavano il design originale in termini di struttura, tipografia ed elementi dell'interfaccia. Rispetto ai tentativi di GPT-5, il contrasto era netto.

In breve: Le prestazioni e il livello di Oceanstone sono degni di nota. Per quanto riguarda la prima release di Gemini 3.0 Flash, dobbiamo ancora attendere ulteriori notizie per confermarlo.

Quali sono le principali caratteristiche di Gemini 3.0?

Miglioramento delle prestazioni di ragionamento e codifica:

I report e le dimostrazioni pubbliche di Google su Gemini 2.5 e i successivi successi nelle competizioni di programmazione suggeriscono una continua attenzione al ragionamento e alla qualità del codice, e diversi analisti prevedono che Gemini 3.0 spingerà ulteriormente in quella direzione. I successi di Gemini/DeepMind nelle competizioni di programmazione evidenziano che Google ha continuato a lavorare sulle capacità di ragionamento, un percorso di investimento che naturalmente punta a un ragionamento più solido nei modelli di classe Gemini 3.

Funzionalità di immagini multimodali e generative più potenti.

L'app Gemini ha introdotto strumenti avanzati di editing delle immagini e funzionalità virali (ad esempio, trasformazioni in stile "Nano Banana"), suggerendo che Google sta rapidamente espandendo gli strumenti multimodali. Le voci su Gemini 3.0 che estende il rendering immagine→3D, una sintesi di immagini più rapida e di alta qualità e un inpainting più granulare hanno senso, data questa tendenza.

Finestre di contesto più lunghe e memoria/personalizzazione.

Google ha discusso pubblicamente di esperimenti di personalizzazione e funzionalità di contesto multi-tab per Gemini in Chrome. Una finestra di contesto più ampia e funzionalità di personalizzazione più persistenti sono le logiche direzioni di prodotto per Gemini 3.0.

In che modo Gemini 3 differirà da Gemini 2.5?

Per capire cosa aspettarsi, è istruttivo confrontare cosa fa 2.5 e quali lacune esistono.

| Capacità | Punti di forza dei Gemelli 2.5 | Aree di miglioramento / Cosa potrebbe aggiungere la versione 3.0 |

|---|---|---|

| Multimodalità | Testo, immagine, audio, breve video, modalità di "pensiero", ragionamento approfondito sui parametri di riferimento. | Elaborazione video in tempo reale, comprensione 3D, dati spaziali/geospaziali, modello unificato tra le modalità. |

| Finestra contestuale | ~1 milione di token. | Contesti di token potenzialmente multimilionari, migliore memoria/recupero per mantenere la coerenza durante un utilizzo prolungato. |

| Comportamento agentico/proattivo | Modalità agente annunciata; azioni programmate; una certa autonomia. | Pianificazione autonoma più affidabile, personalizzazione più approfondita, maggiore integrazione con il controllo di dispositivi e sistemi. |

| Integrazione con sistema operativo/dispositivi | Sostituzione dell'Assistente sui dispositivi Home; integrazione con Android; disponibilità di Wear OS. | Un'integrazione ancora più stretta; forse Gemini come assistente principale in più tipi di dispositivi (orologi, TV, IoT), transizioni più fluide tra le modalità. |

| Velocità, latenza, efficienza | Gemini 2.5 Flash è più veloce; ottimizzazioni di costi/efficienza. | Migliori prestazioni, in particolare per i video; minore latenza; utilizzo più efficiente dell'hardware; esecuzione sul dispositivo o edge per attività sensibili. |

Iniziamo

CometAPI è una piattaforma API unificata che aggrega oltre 500 modelli di intelligenza artificiale (IA) di provider leader, come la serie di OpenAI, Gemini di Google, Claude di Anthropic, Midjourney, Suno e altri, in un'unica interfaccia intuitiva per gli sviluppatori. Offrendo autenticazione, formattazione delle richieste e gestione delle risposte coerenti, CometAPI semplifica notevolmente l'integrazione delle funzionalità di IA nelle tue applicazioni. Che tu stia sviluppando chatbot, generatori di immagini, compositori musicali o pipeline di analisi basate sui dati, CometAPI ti consente di iterare più rapidamente, controllare i costi e rimanere indipendente dal fornitore, il tutto sfruttando le più recenti innovazioni nell'ecosistema dell'IA.

Per iniziare, esplora il modello Google Gemini (ad esempio API per immagini Flash Gemini 2.5,le capacità di gemini 2.5 pro) nel Parco giochi e consultare il Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. CometaAPI offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

Quindi, ovviamente, non appena arriverà il rilascio ufficiale, integreremo immediatamente CometAPI, il nostro gateway API per l'intelligenza artificiale. Utilizzando Gemini 3.0 e Gemini 2.5 Pro come driver principali, in combinazione con modelli leader come Claude e GPT, creeremo la produttività più potente di sempre. Pronti a partire? → Iscriviti oggi a CometAPI !

Considerazioni finali

Google Gemini 3 si preannuncia come un significativo passo avanti rispetto a Gemini 2.5. Il ritmo degli annunci, la crescente integrazione in dispositivi e sistemi operativi, l'espansione delle modalità e l'enfasi su ragionamento, memoria e capacità "agentiche" puntano tutti verso un modello che mira a essere più utile, più intelligente e più integrato nei flussi di lavoro quotidiani.

Tuttavia, come per qualsiasi modello di intelligenza artificiale ambizioso, il divario tra voci/proiezioni e effettiva implementazione può essere ampio. La fine del 2025 è una finestra temporale plausibile per molte di queste funzionalità, ma non tutte potrebbero arrivare simultaneamente o su larga scala. Gli utenti potrebbero assistere a implementazioni parziali, set di funzionalità scaglionati e vincoli iniziali (costi, elaborazione, privacy) prima che un'esperienza Gemini 3 completamente rifinita sia ampiamente disponibile.