DeepSeek ha rilasciato un sperimentale modello chiamato DeepSeek-V3.2-Exp on 29 settembre 2025, introducendo un nuovo meccanismo di attenzione sparsa (DeepSeek Sparse Attention, o DSA) che mira a ridurre notevolmente i costi di inferenza per carichi di lavoro di lungo contesto, e contemporaneamente l'azienda ha ridotto di circa la metà i prezzi delle API. Questa guida spiega cos'è il modello, i punti salienti dell'architettura e delle funzionalità, come accedere e utilizzare l'API (con esempi di codice), come si confronta con i precedenti modelli DeepSeek e come analizzare e gestire le sue risposte in produzione.

Che cos'è DeepSeek-V3.2-Exp?

DeepSeek-V3.2-Exp è un'iterazione sperimentale della versione V3 di DeepSeek. La versione, annunciata a fine settembre 2025, si posiziona come un passaggio "intermedio" che convalida le ottimizzazioni architetturali per lunghezze di contesto estese, piuttosto che come un grande passo avanti in termini di accuratezza grezza. La sua principale innovazione è Attenzione sparsa DeepSeek (DSA), un modello di attenzione che si concentra selettivamente su parti di un input lungo per ridurre i costi di elaborazione e di memoria, puntando al contempo a mantenere una qualità dell'output paragonabile a V3.1-Terminus.

Perché è importante nella pratica:

- Costo per attività di lungo contesto: La DSA mira al costo quadratico dell'attenzione, riducendo il calcolo per input molto lunghi (si pensi al recupero di più documenti, lunghe trascrizioni, mondi di gioco di grandi dimensioni). I costi di utilizzo dell'API sono sostanzialmente inferiori per i tipici casi d'uso a lungo contesto.

- Compatibilità e accessibilità: L'API DeepSeek utilizza un formato di richiesta compatibile con OpenAI, pertanto molti flussi di lavoro SDK OpenAI esistenti possono essere adattati rapidamente.

Quali sono le caratteristiche principali e l'architettura di DeepSeek V3.2-Exp?

Che cos'è DeepSeek Sparse Attention (DSA) e come funziona?

DSA è un attenzione sparsa e a grana fine schema progettato per prestare attenzione selettivamente ai token, anziché concentrare l'attenzione sull'intero contesto. In breve:

- Il modello seleziona dinamicamente sottoinsiemi di token a cui prestare attenzione in ogni livello o blocco, riducendo i FLOP per lunghezze di input elevate.

- La selezione è progettata per preservare il contesto "importante" per le attività di ragionamento, sfruttando una combinazione di criteri di selezione appresi ed euristiche di routing.

DSA è l'innovazione principale della versione V3.2-Exp, volta a mantenere la qualità dell'output vicina a quella dei modelli ad attenzione densa, riducendo al contempo i costi di inferenza, soprattutto all'aumentare della lunghezza del contesto. Le note di rilascio e la pagina del modello sottolineano che le configurazioni di training sono state allineate con la versione V3.1-Terminus, quindi le differenze nelle metriche di benchmark riflettono il meccanismo di attenzione sparsa piuttosto che una modifica radicale del training.

Quali altre architetture/funzionalità sono incluse nella versione V3.2-Exp?

- Modalità ibride (pensare vs non pensare): DeepSeek espone due ID modello:

deepseek-chat(risposte non pensanti/più veloci) edeepseek-reasoner(modalità di pensiero che può esporre contenuti di ragionamento a catena o intermedio). Queste modalità consentono agli sviluppatori di scegliere tra velocità e trasparenza del ragionamento esplicito. - Finestre di contesto molto grandi: La famiglia V3.x supporta contesti molto ampi (la linea V3 offre a DeepSeek 128K opzioni di contesto negli aggiornamenti correnti), rendendola adatta a flussi di lavoro multi-documento, registri lunghi e agenti con un elevato livello di conoscenza.

- Output JSON e chiamata di funzione rigorosa (Beta): L'API supporta un

response_formatOggetto in grado di forzare l'output JSON (e una versione beta di chiamata di funzione rigorosa). Questo è utile quando si necessitano output prevedibili e analizzabili dalla macchina per l'integrazione di strumenti. - Token di streaming e ragionamento: L'API supporta lo streaming di risposte e, per i modelli di ragionamento, distinti token di contenuto di ragionamento (spesso esposti sotto

reasoning_content), che consente di visualizzare o controllare i passaggi intermedi del modello.

Come posso accedere e utilizzare l'API DeepSeek-V3.2-Exp tramite CometAPI?

DeepSeek mantiene intenzionalmente un formato API in stile OpenAI, in modo che gli SDK OpenAI esistenti o gli strumenti compatibili possano essere reindirizzati con un URL di base diverso. Consiglio di utilizzare CometAPI per accedere a DeepSeek-V3.2-Exp perché è economico e rappresenta un gateway di aggregazione multimodale. DeepSeek espone nomi di modelli che corrispondono al comportamento di V3.2-Exp. Esempi:

DeepSeek-V3.2-Exp-thinking — modalità di ragionamento/pensiero mappata su V3.2-Exp.

DeepSeek-V3.2-Exp-thinking — modalità non ragionamento/chat mappata su V3.2-Exp.

Come posso effettuare l'autenticazione e qual è l'URL di base?

- Ottieni una chiave API dalla console per sviluppatori CometAPI (fai domanda sul loro sito).

- URL di base: (

https://api.cometapi.comorhttps://api.cometapi.com/v1per percorsi compatibili con OpenAI). La compatibilità con OpenAI significa che molti SDK OpenAI possono essere reindirizzati a DeepSeek con piccole modifiche.

Quali ID modello dovrei usare?

DeepSeek-V3.2-Exp-thinking— modalità di pensiero, espone contenuti di ragionamento/catena di pensiero. Entrambe sono state aggiornate alla versione V3.2-Exp nelle ultime note di rilascio.DeepSeek-V3.2-Exp-nothinking— risposte più rapide e senza pensieri, tipico utilizzo di chat/completamento.

Esempio: semplice richiesta curl (completamento della chat)

curl -s https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer $cometapi_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize the attached meeting transcript in 3 bullet points."}

],

"max_tokens": 512,

"stream": false

}'

Esempio: Python (modello client compatibile con OpenAI)

Questo schema funziona dopo aver indirizzato un client OpenAI all'URL di base di CometAPI (o utilizzando l'SDK di CometAPI). L'esempio seguente segue lo stile della documentazione di DeepSeek:

import os

import requests

API_KEY = os.environ

url = "https://api.deepseek.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

payload = {

"model": "deepseek-v3.2-exp",

"messages": [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Extract action items from the following notes..."}

],

"max_tokens": 800

}

r = requests.post(url, headers=headers, json=payload)

r.raise_for_status()

print(r.json())

Non è richiesto alcun SDK speciale — ma se usi già l'SDK di OpenAI puoi spesso riconfigurarlo base_url e al api_key e mantenere gli stessi schemi di chiamata.

Utilizzo avanzato: abilitazione del ragionamento o reasoning_content

Se hai bisogno della catena di pensiero interna del modello (per l'audit, la distillazione o l'estrazione di passaggi intermedi), passa a DeepSeek-V3.2-Exp-thinking. reasoning_content il campo (e il flusso o i token correlati) è disponibile nella risposta per la modalità di ragionamento; la documentazione API fornisce reasoning_content come campo di risposta per ispezionare il CoT generato prima della risposta finale. Nota: l'esposizione di questi token potrebbe influire sulla fatturazione in quanto fanno parte dell'output del modello.

Streaming e aggiornamenti parziali

- Usa il

"stream": truenelle richieste di ricezione di delta di token tramite SSE (eventi inviati dal server). stream_optionse alinclude_usageconsente di regolare come e quando i metadati di utilizzo vengono visualizzati durante uno streaming (utile per le interfacce utente incrementali).

Come si confronta DeepSeek-V3.2-Exp con i precedenti modelli DeepSeek?

V3.2-Exp vs V3.1-Terminus

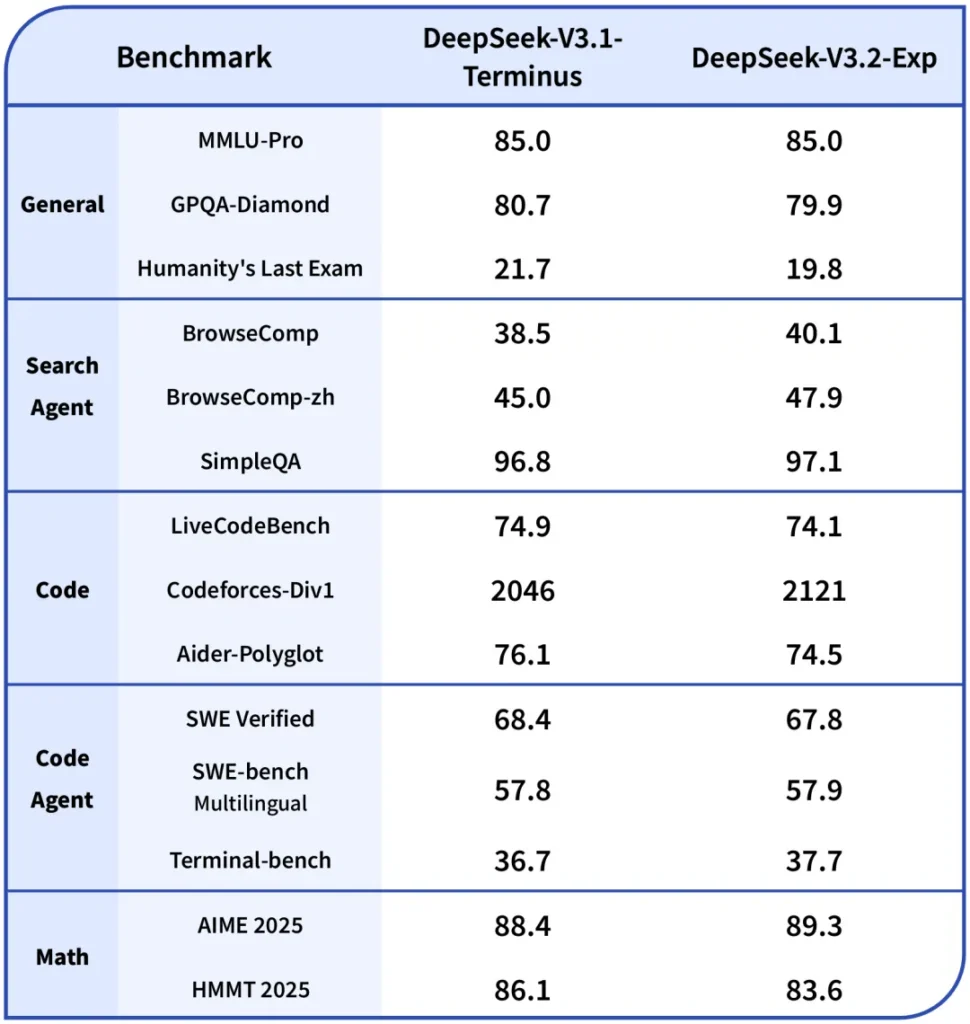

- Differenza primaria: La versione V3.2-Exp introduce il meccanismo di attenzione sparsa per ridurre il calcolo per contesti lunghi, mantenendo il resto della ricetta di addestramento allineata alla versione V3.1. Ciò ha permesso a DeepSeek di effettuare un confronto più chiaro e comparabile dei guadagni di efficienza. ()

- parametri di riferimento: Le note pubbliche indicano che V3.2-Exp offre prestazioni pressoché pari a V3.1 in molte attività di ragionamento/codifica, pur essendo notevolmente più economico in contesti lunghi; si noti che attività specifiche possono comunque presentare piccole regressioni a seconda di come la scarsità di attenzione interagisce con le interazioni dei token richieste.

V3.2-Exp vs R1 / Versioni precedenti

- Le linee R1 e V3 seguono obiettivi di progettazione diversi (R1 storicamente si è concentrata su compromessi architetturali diversi e capacità multimodali in alcuni rami). V3.2-Exp è un perfezionamento della famiglia V3 focalizzato su contesti lunghi e throughput. Se il carico di lavoro è pesante su benchmark di accuratezza grezza a singolo turno, le differenze potrebbero essere modeste; se si opera su pipeline multi-documento, il profilo di costo di V3.2-Exp è probabilmente più interessante.

Dove accedere al Sonetto 4.5 di Claude

CometAPI è una piattaforma API unificata che aggrega oltre 500 modelli di intelligenza artificiale (IA) di provider leader, come la serie GPT di OpenAI, Gemini di Google, Claude di Anthropic, Midjourney, Suno e altri, in un'unica interfaccia intuitiva per gli sviluppatori. Offrendo autenticazione, formattazione delle richieste e gestione delle risposte coerenti, CometAPI semplifica notevolmente l'integrazione delle funzionalità di IA nelle tue applicazioni. Che tu stia sviluppando chatbot, generatori di immagini, compositori musicali o pipeline di analisi basate sui dati, CometAPI ti consente di iterare più velocemente, controllare i costi e rimanere indipendente dal fornitore, il tutto sfruttando le più recenti innovazioni nell'ecosistema dell'IA.

Gli sviluppatori possono accedere DeepSeek V3.2 Exp tramite CometAPI, l'ultima versione del modello è sempre aggiornato con il sito ufficiale. Per iniziare, esplora le capacità del modello nel Parco giochi e consultare il Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. CometaAPI offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

Pronti a partire? → Iscriviti oggi a CometAPI !

Conclusione

DeepSeek-V3.2-Exp è una versione sperimentale pragmatica volta a rendere il lavoro su contesti lunghi più economico e fattibile, preservando al contempo la qualità dell'output di classe V3. Per i team che gestiscono documenti lunghi, trascrizioni o ragionamenti multi-documento, vale la pena sperimentarla: l'API segue un'interfaccia in stile OpenAI che semplifica l'integrazione, evidenziando sia il meccanismo DSA sia significative riduzioni di prezzo che modificano il calcolo economico della creazione su larga scala. Come per qualsiasi modello sperimentale, la valutazione completa, la strumentazione e l'implementazione graduale sono essenziali.