La serie GLM-4.5, sviluppata da Zhipu AI (Z.ai), rappresenta un significativo progresso nei modelli linguistici di grandi dimensioni (LLM) open source. Progettata per unificare le capacità di ragionamento, codifica e agentic, GLM-4.5 offre prestazioni affidabili in diverse applicazioni. Che siate sviluppatori, ricercatori o semplici appassionati, questa guida fornisce informazioni dettagliate su come accedere e utilizzare efficacemente la serie GLM-4.5.

Che cos'è la serie GLM-4.5 e perché è importante?

GLM-4.5 è un modello di ragionamento ibrido che combina due modalità distinte: una "modalità di pensiero" per ragionamenti complessi e utilizzo di strumenti, e una "modalità non di pensiero" per risposte immediate. Questo approccio a doppia modalità consente al modello di gestire in modo efficiente un'ampia gamma di attività. La serie include due varianti principali:

- GLM-4.5: Con 355 miliardi di parametri totali e 32 miliardi di parametri attivi, questo modello è progettato per un'implementazione su larga scala in attività di ragionamento, generazione e multi-agente.

- GLM-4.5-Aria: Una versione leggera con 106 miliardi di parametri totali e 12 miliardi di parametri attivi, ottimizzata per l'inferenza su dispositivo e cloud su piccola scala senza sacrificare le funzionalità principali.

Entrambi i modelli supportano modalità di ragionamento ibride, offrendo modalità "pensanti" e "non pensanti" per bilanciare compiti di ragionamento complessi e risposte rapide. Sono open source e rilasciati con licenza MIT, il che li rende accessibili per uso commerciale e sviluppo secondario.

Principi di architettura e design

In sostanza, GLM-4.5 sfrutta MoE per instradare dinamicamente i token attraverso sottoreti specializzate, consentendo un'efficienza dei parametri e un comportamento di scalabilità superiori (). Questo approccio implica che sia necessario attivare un numero inferiore di parametri per ogni passaggio in avanti, riducendo i costi operativi e mantenendo prestazioni all'avanguardia nelle attività di ragionamento e codifica ().

Funzionalità chiave

- Ragionamento e codifica ibridi: GLM-4.5 dimostra le prestazioni SOTA sia nei benchmark di comprensione del linguaggio naturale che nei test di generazione del codice, spesso rivaleggiando con i modelli proprietari in termini di accuratezza e fluidità.

- Integrazione agentica: Le interfacce integrate per la chiamata degli strumenti consentono a GLM-4.5 di orchestrare flussi di lavoro in più fasi, come query di database, orchestrazione di API e generazione di front-end interattivi, all'interno di un'unica sessione.

- Artefatti multimodali: Dalle mini-app HTML/CSS alle simulazioni basate su Python e agli SVG interattivi, GLM-4.5 può produrre artefatti completamente funzionali, migliorando il coinvolgimento degli utenti e la produttività degli sviluppatori.

Perché GLM-4.5 è un punto di svolta?

GLM-4.5 è stato elogiato non solo per le sue prestazioni, ma anche per aver ridefinito la proposta di valore degli LLM open source in ambito aziendale e di ricerca.

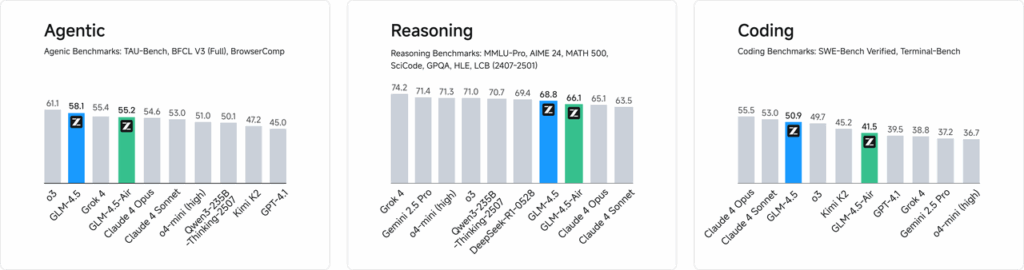

Benchmark delle prestazioni

In valutazioni indipendenti su 52 attività di programmazione, che spaziano dallo sviluppo web all'analisi dei dati e all'automazione, GLM-4.5 ha costantemente superato altri modelli open source leader in termini di affidabilità del tool-calling e completamento complessivo delle attività. Nei test comparativi con Claude Code, Kimi-K2 e Qwen3-Coder, GLM-4.5 ha ottenuto punteggi eccellenti in benchmark come la classifica "SWE-bench Verified".

Razionalizzazione dei costi

Oltre all'accuratezza, il design MoE di GLM-4.5 riduce drasticamente i costi di inferenza. Il prezzo al pubblico per le chiamate API parte da soli 0.8 RMB per milione di token in input e 2 RMB per milione di token in output, circa un terzo del costo di offerte proprietarie comparabili. Insieme a velocità di generazione di picco di 100 token/sec, il modello supporta implementazioni ad alta produttività e bassa latenza senza costi proibitivi.

Come puoi accedere a GLM-4.5?

1. Accesso diretto tramite la piattaforma Z.ai

Il metodo più semplice per interagire con GLM-4.5 è tramite la piattaforma Z.ai. Visitando chat.z.aiGli utenti possono selezionare il modello GLM-4.5 e iniziare a interagire tramite un'interfaccia intuitiva. Questa piattaforma consente test e prototipi immediati senza la necessità di integrazioni complesse. Gli utenti possono selezionare il modello GLM-4.5 o GLM-4.5-Air dall'angolo in alto a sinistra e iniziare a chattare immediatamente. Questa interfaccia è intuitiva e non richiede alcuna configurazione, il che la rende ideale per interazioni e dimostrazioni rapide.

2. Accesso API per sviluppatori

Per gli sviluppatori che desiderano integrare GLM-4.5 nelle applicazioni, la piattaforma API Z.ai offre un supporto completo. L'API offre interfacce compatibili con OpenAI per i modelli GLM-4.5 e GLM-4.5-Air, facilitando l'integrazione nei flussi di lavoro esistenti. Documentazione dettagliata e linee guida per l'integrazione sono disponibili all'indirizzo Documentazione API Z.ai .

3. Distribuzione open source

Per chi è interessato all'implementazione locale, i modelli GLM-4.5 sono disponibili su piattaforme come Hugging Face e ModelScope. Questi modelli sono rilasciati con licenza open source del MIT, consentendone l'uso commerciale e lo sviluppo secondario. Possono essere integrati con i principali framework di inferenza come vLLM e SGLang.

4. Integrazione con CometAPI

CometaAPI offre un accesso semplificato ai modelli GLM-4.5 tramite la loro piattaforma API unificata a DasbordQuesta integrazione semplifica l'autenticazione, la limitazione della velocità e la gestione degli errori, rendendola un'ottima scelta per gli sviluppatori che cercano una configurazione senza problemi. Inoltre, il formato API standardizzato di CometAPI consente un facile passaggio da un modello all'altro e test A/B tra GLM-4.5 e altri modelli disponibili.

Come possono gli sviluppatori accedere alla serie GLM-4.5?

Esistono diversi canali per ottenere e distribuire GLM-4.5, dai download diretti dei modelli alle API gestite.

Tramite Hugging Face e ModelScope

Sia Hugging Face che ModelScope ospitano l'intera serie GLM-4.5 sotto il namespace zai-org. Dopo aver accettato la licenza MIT, gli sviluppatori possono:

- Clona il repository:

git clone https://huggingface.co/zai-org/GLM-4.5

- Installa dipendenze:

pip install transformers accelerate

- Carica il modello:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

Attraverso CometAPI

CometaAPI fornisce un'API senza server per GLM‑4.5 e al API aereo GLM-4.5 a tariffe pay-per-token, accessibili tramite, configurando endpoint compatibili con OpenAI, è possibile chiamare GLM-4.5 tramite il client Python di OpenAI con modifiche minime alle basi di codice esistenti. CometAPI non fornisce solo GLM4.5 e GLM-4.5-air, ma anche tutti i modelli ufficiali:

| Nome del modello | introdurre | Prezzo |

glm-4.5 | Il nostro modello di ragionamento più potente, con 355 miliardi di parametri | Gettoni di input $0.48 Gettoni di output $1.92 |

glm-4.5-air | Conveniente Leggero Prestazioni elevate | Gettoni di input $0.16 Gettoni di output $1.07 |

glm-4.5-x | Alte prestazioni, ragionamento forte, risposta ultraveloce | Gettoni di input $1.60 Gettoni di output $6.40 |

glm-4.5-airx | Leggero, potente, con risposta ultraveloce | Gettoni di input $0.02 Gettoni di output $0.06 |

glm-4.5-flash | Prestazioni elevate, eccellenti per ragionamento, codifica e agenti | Gettoni di input $3.20 Gettoni di output $12.80 |

Integrazione di Python e API REST

Per implementazioni personalizzate, le organizzazioni possono ospitare GLM-4.5 su cluster GPU dedicati utilizzando Docker o Kubernetes. Una tipica configurazione RESTful prevede:

Avvio del server di inferenza:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

Invio di richieste:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

Quali sono le migliori pratiche per integrare GLM-4.5 nelle applicazioni?

Per massimizzare il ROI e garantire prestazioni solide, i team dovrebbero considerare quanto segue:

Ottimizzazione API e limiti di velocità

- Richieste in batch: Raggruppare prompt simili per ridurre il sovraccarico e sfruttare la produttività della GPU.

- Memorizzazione nella cache delle query comuni: Memorizzare i completamenti frequenti localmente per evitare chiamate di inferenza ridondanti.

- Campionamento adattivo: Regola dinamicamente

temperaturee altop_pbasato sulla complessità delle query per bilanciare creatività e determinismo.

Sicurezza e conformità

- Sanificazione dei dati: Preelabora gli input per eliminare le informazioni sensibili prima di inviarle al modello.

- Controllo Accessi: Implementare chiavi API, elenchi di indirizzi IP consentiti e limitazione della velocità per prevenire abusi e usi impropri.

- Registrazione di audit: Registrare richieste, completamenti e metadati per la conformità ai requisiti aziendali e normativi, in particolare in contesti finanziari o sanitari.

Iniziamo

CometAPI è una piattaforma API unificata che aggrega oltre 500 modelli di intelligenza artificiale (IA) di provider leader, come la serie GPT di OpenAI, Gemini di Google, Claude di Anthropic, Midjourney, Suno e altri, in un'unica interfaccia intuitiva per gli sviluppatori. Offrendo autenticazione, formattazione delle richieste e gestione delle risposte coerenti, CometAPI semplifica notevolmente l'integrazione delle funzionalità di IA nelle tue applicazioni. Che tu stia sviluppando chatbot, generatori di immagini, compositori musicali o pipeline di analisi basate sui dati, CometAPI ti consente di iterare più velocemente, controllare i costi e rimanere indipendente dal fornitore, il tutto sfruttando le più recenti innovazioni nell'ecosistema dell'IA.

Per gli sviluppatori che desiderano integrare GLM-4.5 nelle proprie applicazioni, la piattaforma CometAPI offre una soluzione affidabile. L'API fornisce interfacce compatibili con OpenAI, consentendo un'integrazione fluida nei flussi di lavoro esistenti. Documentazione dettagliata e linee guida per l'utilizzo sono disponibili sul sito web. Pagina API Comet.

Gli sviluppatori possono accedere GLM‑4.5 e al API aereo GLM-4.5 attraverso CometaAPI, le ultime versioni dei modelli elencate sono quelle aggiornate alla data di pubblicazione dell'articolo. Per iniziare, esplora le capacità del modello in Parco giochi e consultare il Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. CometaAPI offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

Conclusione

GLM-4.5 rappresenta un significativo progresso nel campo dei modelli linguistici di grandi dimensioni, offrendo una soluzione versatile per un'ampia gamma di applicazioni. La sua architettura di ragionamento ibrida, le capacità agentiche e la natura open source lo rendono un'opzione interessante per sviluppatori e organizzazioni che desiderano sfruttare tecnologie di intelligenza artificiale avanzate. Esplorando i diversi metodi di accesso descritti in questa guida, gli utenti possono integrare efficacemente GLM-4.5 nei loro progetti e contribuire al suo continuo sviluppo.